Anja Reinhardt: Seit Beginn des Jahres sprechen wir mit ganz unterschiedlichen Leuten über das Verhältnis von Vernunft und Gefühl im postfaktischen Zeitalter: Kopf oder Bauch – das ist die Frage. Und diese Frage geht heute an die Big Data-Expertin Yvonne Hofstetter, die in ihrem letzten Buch vom Ende der Demokratie sprach. Untertitel: Wie die künstliche Intelligenz die Politik übernimmt und uns entmündigt. Yvonne Hofstetter – wird es künstliche Intelligenz überhaupt irgendwann mit Bauch, mit Bauchgefühl geben?

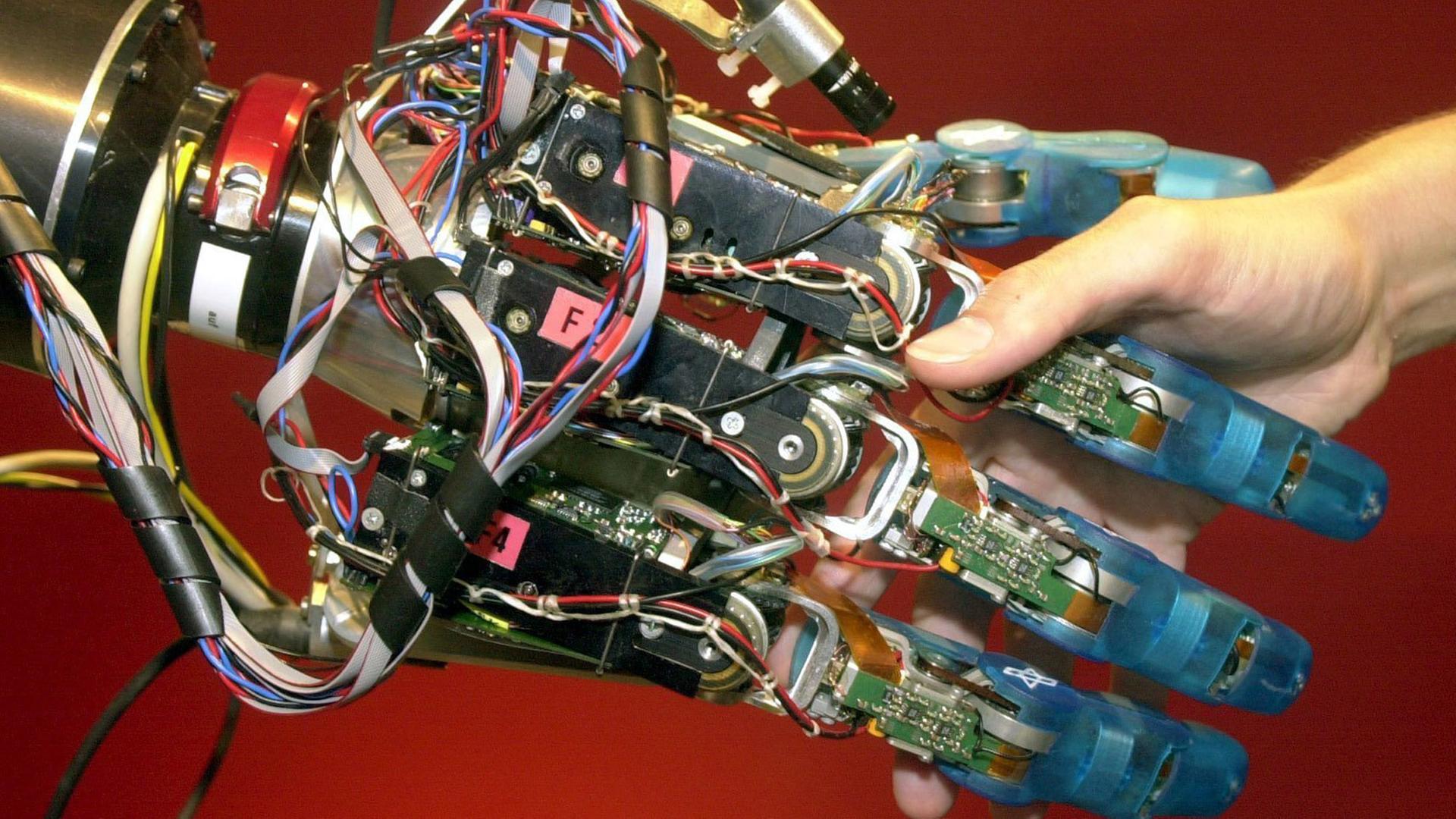

Yvonne Hofstetter: Es gibt bei der künstlichen Intelligenz keinen Bauch. Künstliche Intelligenz, so wie wir sie bauen, trifft Entscheidungen unter Unsicherheit. Das machen wir Menschen auch den ganzen Tag über. Wir entscheiden oft falsch dabei. Aber die künstliche Intelligenz schaut sich einfach Daten der Umwelt an, Rohdaten des Lebens, wenn Sie so wollen, und entscheidet ganz basierend auf diesen "Wahrheiten" oder "Wirklichkeiten", die sie da erkennt. Es geht überhaupt nicht um Emotionen, überhaupt nicht um Bauchgefühl, aber auch nicht um Kontext und ähnliche Dinge.

Reinhardt: Wenn Sie sagen Wahrheiten, dann ist das schon mal ein Kernthema, denn im humanen Denken gibt es durchaus immer mehrere Wahrheiten. Das gibt es bei der künstlichen Intelligenz nicht, oder da gibt es nur Null und Eins, um es mal so zu formulieren.

Hofstetter: Na ja. Es gibt schon im tatsächlichen Leben auch die Wahrheiten, die Sachwahrheiten beispielsweise oder die Vernunftwahrheiten. Aber natürlich ist es so, dass wir in der Politik - damit sind wir gerade stark konfrontiert, wenn wir um Social Boards reden und um Fake News reden in sozialen Netzwerken -, dass wir dort nicht mehr so genau erkennen oder sagen, na ja, wir können das so oder so sehen. In der Politik oder im Leben kann man die Dinge so oder so betrachten, und manchmal richten wir uns dann nicht so nach der tatsächlichen Wirklichkeit, wie sie stattfindet. Bei der künstlichen Intelligenz ist das ein bisschen anders. Die versucht, zu extrahieren aus den naturwissenschaftlich gegebenen Umständen, was die Wahrheit ist. Aber es ist nur eine naturwissenschaftliche Wahrheit und das Leben besteht aber nicht nur aus Naturwissenschaft.

Zwei Philosophien in der künstlichen Intelligenz

Reinhardt: Wenn wir von Naturwissenschaften, von Faktizität reden, dann kann man im Umkehrschluss ja sagen, der Mensch ist nicht nur eine Ansammlung von Daten, von Wahrheiten in seinem Handeln, was er getan hat oder was er nicht getan hat. Der Mensch ist vor allen Dingen unberechenbar durch Gefühle. Und jetzt ist es aber so, dass wir alle quasi für die künstliche Intelligenz immer berechenbarer werden, wenn ich Sie richtig verstanden habe, dadurch, dass wir uns freiwillig immer weiter ausmessen lassen, indem wir zum Beispiel Fitness-Bänder tragen, indem wir mit jedem Klick eine Information abgeben. Was heißt das denn für den Mensch auch als Gefühlswesen?

Hofstetter: Das was Sie gerade hier postuliert haben, dass der Mensch tatsächlich nicht nur aus Daten bestünde, das, würde ich sagen, das ist einfach eine Meinung, eine Philosophie, und ist auch eine Frage der Philosophie. Und tatsächlich ist hier die Welt, sage ich mal, zweigeteilt, die Welt der Philosophen. Es gibt die Menschen, die Naturalisten sind, die sagen, doch, der Mensch ist tatsächlich nur ein Datenhaufen. Wenn ich genügend Daten habe, dann kann ich den Menschen komplett reproduzieren. Ich kann wissen, was er denkt, was er fühlt, wie er sich verhalten wird. Ich kann ihn prognostizieren. Ein sehr schönes Beispiel für dieses Vorgehen - das übrigens im Silicon Valley mit unserer ganzen Digitalisierung, wie sie gerade stattfindet, postuliert wird -, ein schönes Beispiel ist, die Toten wieder auferstehen zu lassen. Und zwar in der Form, dass ein Unternehmen in Silicon Valley, ein Startup sagt, wir brauchen nur genug Daten von Verstorbenen, seine E-Mails, seine Blog Posts, seine Postings von Facebook, von Twitter, und wir lassen diesen Menschen wieder auferstehen und die Hinterbliebenen können mit dem Verstorbenen dann wieder in Kontakt treten, weil wir ihnen beispielsweise ein Hologramm zur Verfügung stellen, mit künstlicher Intelligenz beaufschlagt, die diesen Verstorbenen reproduziert. Das ist die komplett naturalistische Weltsicht. Das ist eine Philosophie. Und dem gegenüber steht die andere Philosophie, die Philosophie der Geisteswissenschaften. Das ist die, dass der Mensch doch mehr ist als nur die Summe seiner Daten, denn in den Daten kann ich kein Ich finden. Ich finde kein Selbstbewusstsein, kein Bewusstsein. Wo ist das alles? Das ist auch nicht im Gehirn. Deswegen ist die Frage, wer ist der Mensch. Hier geht es wirklich um unser Weltbild.

Reinhardt: Nun haben Sie auch schon mehrmals die Durchkreuzung von Philosophie und Naturalismus angesprochen und es gibt ein bekanntes philosophisches Problem, das Trolley-Problem. Der Lokführer wird vor die Frage gestellt, fahre ich fünf Personen um und töte sie, oder wird die Weiche so gestellt, dass ich nur eine Person töte. Damit muss sich wahrscheinlich jeder, der mit künstlicher Intelligenz zu tun hat, auseinandersetzen. Das ist auch ein Problem, das bei selbstfahrenden Autos eine Rolle spielt. Inwiefern wird denn künstliche Intelligenz auch ohne Gefühle moralisch für uns wichtig?

Hofstetter: Man kann natürlich künstliche Intelligenz schon entsprechende Regeln mitgeben. Dann muss sie keine Werte kennen, sie muss nicht emotional handeln. Aber Sie haben es gerade angesprochen: Das sind Fragen von Dilemmata, die hier auftauchen, beispielsweise auch beim autonomen Fahren. Und die Frage ist, wenn ich auf der Straße bin und ich sitze in einem autonomen Auto, und ich habe die Situation, dass ich zwei Rentner umfahre oder fünf Schulkinder. Wenn ich vor mir ein Hindernis sehe, eine Mauer, einen LKW oder wie auch immer, dann ist die Frage, wie soll sich das Auto verhalten. Nach unserer Rechtsordnung, nach der Verfassung, wo Menschenleben nicht gegen Menschenleben aufgewogen werden dürfen, ist diese Frage unentscheidbar auch für den Menschen. Aber wir können natürlich sagen, stellen wir uns mal vor, es ist keine Fifty-Fifty-Entscheidung. Dann würde nämlich der Technologe sagen, wir würfeln. Wenn es unentscheidbar ist, wird gewürfelt und der Zufall entscheidet.

Reinhardt: Wir lassen den Zufall entscheiden.

Hofstetter: Genau der Zufall entscheidet. Dann würde ich aber als Technologe auch den Passagier und Piloten mit einbeziehen in das Würfeln. Das heißt, es wäre eine Situation, in der hier das Leben quasi gedrittelt wird: Ein Drittel Wahrscheinlichkeit, die Rentner werden umgefahren und getötet, ein Drittel die Kinder, ein Drittel ich selbst. Und das gibt mir eigentlich schon eine Regel im Umgang mit der künstlichen Intelligenz. Denn dann muss ich mich als Passagier fragen, darf ich mich dann wirklich in dem Auto schlafend zurücklehnen und alles tun und das Auto einfach fahren lassen, oder muss ich nicht ganz besonders gut ausgebildet sein, mit diesem Wagen zu fahren, eine ganz besondere Verantwortung haben, mit diesem Auto umzugehen. Das sind die Fragen und die können wir durch bestimmte Regeln sehr wohl lösen. Da muss die künstliche Intelligenz überhaupt keine Werte und kein Recht und kein Gesetz implementieren.

"Eine der Begleitideologien der Digitalisierung ist der Kapitalismus"

Reinhardt: Da sind wir ja im Grunde genommen bei der Selbstverantwortung, und Sie schreiben auch vor allen Dingen in Ihrem letzten Buch, in dem es um die Abschaffung der Demokratie durch die Digitalisierung geht oder die drohende Abschaffung der Demokratie, genau über diese Selbstverantwortung. Dass wir uns alle im Klaren darüber sein müssen, dass wir mit jedem Klick Informationen abgeben, die gesammelt werden, die ein Bild von uns ergeben, und die vielleicht auch wieder zu uns zurückkommen in Form von, sagen wir mal, Sie oder ich sind bei Facebook, und wir sehen in unserer Timeline genau auf uns zugeschnittene Informationen, die ein Bild ergeben, das auch genau auf uns zugeschnitten ist und vielleicht mit der Realität nicht mehr ganz so viel zu tun hat. Inwiefern müssen wir uns da unserer Selbstverantwortung bewusst werden und nicht nur gefühlsmäßig das annehmen und sagen, ja genau das habe ich gedacht, sondern die Ratio einschalten?

Hofstetter: Wir müssen uns darüber im Klaren sein, dass eine der Begleitideologien der Digitalisierung der Kapitalismus ist. Digitalisierungsplattformen, so wie wir sie kennen, beispielsweise soziale Medien, sind zu nichts anderem da, als ihren Betreibern, Facebook, Twitter, Herrn Zuckerberg Geld zu verdienen. Sie sind Plattformen für die Werbung. Und wenn wir uns auf diesen Plattformen bewegen und 45 Prozent der Europäer und auch der Amerikaner - die Zahlen sind hier gleich - informieren sich nur noch über die News Streams in sozialen Medien auch über Politik, dann muss uns klar sein, dass wir eigentlich einem Wahn, einer Fantasterei verfallen sind, nämlich der, dass die Werbeplattformen globaler Technologiekonzerne der beste Platz seien, um sich politisch auszutauschen und zu informieren. Das ist verrückt, und wir werden extrem herausgefordert sein, uns auf andere seriöse Weise zu informieren als über das Internet. Das ist gefährlich und daran sollten wir uns halten und uns anderweitig informieren.

Äußerungen unserer Gesprächspartner geben deren eigene Auffassungen wieder. Der Deutschlandfunk macht sich Äußerungen seiner Gesprächspartner in Interviews und Diskussionen nicht zu eigen.