Entschuldigen Sie diesen etwas harschen Anfang der Sendung. Es muss sein:

(Zu hören ist ein Klavierstück von Johann Sebastian Bach, unterlegt mit weißem Rauschen.)

Das ist weißes Rauschen. Es enthält alle hörbaren Frequenzen gleich laut und erscheint uns deswegen unangenehm, ohne Struktur. In der Welt der Bilder entspricht ihm die Farbe Weiß.

Aber in diesem Rauschen versteckt sich tatsächlich eine Struktur, nämlich ein Klavier. Hören Sie es? Wie kann ich dieses allenfalls erfühlbare Klavier aus der unbrauchbaren Aufnahme herausholen? Vor einigen Jahren hätte man gesagt: Probieren wir’s mit filtern! Mit filtern geht hier aber überhaupt nichts. Ich könnte anfangen, ein Computerprogramm zu schreiben, das die Töne im Rauschen findet. Bloß: In welcher Zeile weise ich das Programm an, konkret nach der und der Frequenz zu suchen, in diesem Brei?

Selbstlernende Maschinen irritieren - vielen sind sie unheimlich

Klassische Computerprogramme müssen alles konkret wissen, die Millisekunde, die sie sich ansehen, die Tonhöhe. Sie bestehen nur aus eindeutigen Anweisungen. Die ziehen sie durch, bis sie fertig sind.

Mit dieser Art der Programmierung kam man 50 Jahre lang sehr weit. Aber bei immer mehr Problemen heute ist sie nutzlos. Dafür tritt jetzt Software auf den Plan, die lernt und damit völlig neue Perspektiven eröffnet. Sie kann auch mit dieser Musik fertig werden.

Eine solche Software gibt es noch nicht; der Markt wäre dafür auch sehr klein. Aber andere ist schon im Einsatz. Software, die gelernt hat, Sprache und Bilder intelligent zu interpretieren; die erkennt, ob ein Stuhl zu sehen ist - oder ein alter Mann. Eine andere unterscheidet anhand von Röntgenaufnahmen, ob es sich um Krebs oder um eine Kalkablagerung handelt. Und noch eine andere lotst autonom fahrende Autos ans Ziel.

Selbstlernende Maschinen irritieren. Vielen sind sie unheimlich. Sie begeben sich ja auf Augenhöhe mit uns, sie tun, als seien sie intelligent. Wenn man das konsequent weiterdenkt, stellt sich die philosophische Frage, ob die Maschine wirklich nur so tut? Denn mit unseren menschlichen neuronalen Netzwerken im Gehirn empfinden wir ja Lust und Schmerz. Wenn wir das im Rechner nachbauen, sollten wir da nicht zumindest in Betracht ziehen, dass diese lernende Maschine ähnliche Gefühle haben kann?

"Ein Roboter, der sehr darauf bedacht ist, nicht gegen eine Wand zu laufen, weil er weiß, er bekommt dann eine negative Rückmeldung, wird vielleicht nichts empfinden. Aber wir nutzen bei seiner Programmierung einen Mechanismus, der bei Tieren Schmerz auslösen würde.

Wenn wir mit dem Maschinenlernen so weiter machen, überschreiten wir möglicherweise, ohne es zu merken, eine Grenze, wo wir dann Roboter haben, denen es tatsächlich wehtut, wenn sie gegen eine geschlossene Tür laufen", sagt Anders Sandberg, Informatiker und Zukunftsforscher an der Oxford University.

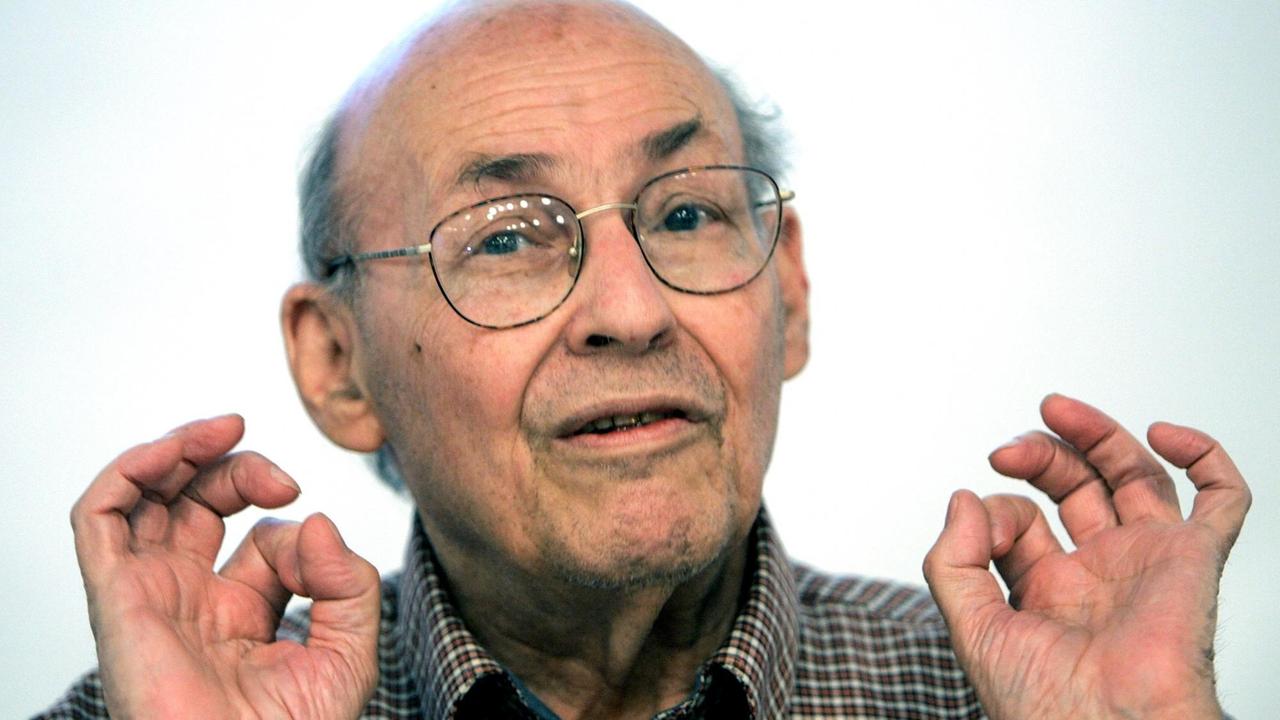

Doch sehen wir uns zunächst die Mathematik an - auch wenn das die lernenden Maschinen ein wenig entzaubert. Paul Lukowicz:

"Das hochgelobte Lernen ist nichts irgendwie Magisches, nichts Unverständliches, sondern nichts anderes als eine statistische Datenanalyse. Und eine solche statistische Datenanalyse wird immer dann notwendig, wenn ich keine deterministischen Regeln mehr finden kann."

Zum Beispiel keine Regel, wo ich in einem verrauschten Tonmaterial anfange, nach Musik zu suchen. Oder in einem aus schneller Fahrt aufgenommenen, völlig verwackelten Video nach einem Stoppschild.

"Ich kann jedes Problem auf zwei Arten angehen: Ich kann hingehen und ein physikalisches Modell erfinden, wo ich Größen messe und sagen kann: Ab dieser Trennlinie ist es meinetwegen ein Stoppschild, ab der ist es kein Stoppschild.

Nur ist das Problem, wenn man sich die Komplexität der Welt anguckt, in welch verschiedenen Lichtverhältnissen Stoppschilder sein können, was für verschiedene Graffitis Kinder da draufgeschmiert haben können, wie die Dinge vergilbt und sonst etwas sein können - dann sind wir als Menschen nicht mehr in der Lage, wirklich einen solchen deterministischen Algorithmus anzugeben.

Also ist die andere Variante, die man macht: Ich schaue mir einfach genügend Stoppschilder an und ermittle daraus statistisch etwas. Das ist das Lernen."

Paul Lukowicz leitet das Ressort "Eingebettete Intelligenz" am Deutschen Forschungszentrum für Künstliche Intelligenz in Kaiserslautern.

Ein großer Vordenker der Künstlichen Intelligenz, Marvin , starb 2015 in hohem Alter, und mit ihm eine Generation von Computerpionieren, Träumern und Schaumschlägern. Sie alle wollten Computerprogramme dem neuronalen Netzwerk des Gehirns nachempfinden, also Maschinen bauen, die es mit der menschlichen Intelligenz aufnehmen. Das versucht heute keiner mehr.

Der 1973 geborene australische Computerwissenschaftler Jeremy Howard sagt, die Versprechungen der 1980er Jahre, menschliche Intelligenz zu schaffen, seien nie eingehalten worden, und überhaupt kam nie etwas Sinnvolles dabei heraus.

Sehr viel Sinnvolleres dagegen kommt bei dem neuen Ansatz der Künstlichen Intelligenz heraus, die man heute bescheidener "Maschinenlernen" nennt.

Die Spracherkennung beim Smartphone

Frage: "Wie ist die Fahrzeit von Bautzen nach Malaga?"

Antwort: "Der Standort Malaga, Provinz Malaga, Spanien, ist bei wenig Verkehr in einem Tag, einer Stunde mit dem Auto vom Standort Bautzen entfernt. Dies ist deine Route."

Diese Antwort aus dem Smartphone kommt vielen heute normal vor. Sie ist aber bemerkenswert und erst seit wenigen Jahren möglich. Die Fahrzeit und Routenplanung gab es schon in Navigationssystemen vor zwei Jahrzehnten. Aber dass das Smartphone versteht, was ich spreche, ist alles andere als trivial - und es gelingt nur mit Maschinen, die dauernd dazulernen. Jeremy Howard:

"Die Spracherkennung funktioniert unabhängig von der Stimme. Das ist dank Maschinenlernen phantastisch gelungen und so viel besser als die Spracherkennung früher, als man Software mit einzelnen Sprechern trainieren musste."

Ich kann auch auf Englisch beim Smartphone anfragen:

Frage: "What’s the distance between London and Stockholm?"

Antwort: "Die Fahrstrecke vom Standort London, Vereinigtes Königreich, nach Stockholm, Schweden beträgt 1891,9 Kilometer."

oder auf Fränkisch:

Frage: "Sach mir amol die Fohrzeid vo Bauzn nach Nizza!"

Antwort: "Der Standort Nizza, Frankreich, ist bei wenig Verkehr in zwölf Stunden, 15 Minuten mit dem Auto von dem Standort Bautzen entfernt. Dies ist deine Route."

Solch ein System nennt man robust. Es lässt sich nicht aus dem Takt bringen. Es hat mein Fränkisch aber nie zuvor gehört.

Hinter dieser Spracherkennung steckt massive Rechenpower. Die stellt mein kleines Handy nicht bereit, nicht einen Bruchteil davon. Ich muss, wenn ich nach dem Weg frage, schon online sein, also mit dem Internet verbunden. Meine Frage geht über das Mikrofon des Smartphones direkt in ein amerikanisches Rechenzentrum.

Dieses Rechenzentrum sprechen täglich Millionen Menschen x-mal an, und dort arbeitet ein Computerprogramm, von dem niemand weiß, wie es genau funktioniert. Es hört sich seit einigen Jahren alles an und versucht, aus den Petabytes an Daten inhaltliche Schlüsse zu ziehen. Es ist eine stetig weiter lernende Maschine. In der Informatik heißt dieses Verfahren mit ganz großen Datenmengen: Deep Learning.

"Ich habe Daten analysiert, die von der medizinischen Hochschule Hannover aufgenommen wurden, wo Meerschweinchen für sie relevante Geräusche vorgespielt wurden", sagt Dominika Lyzwa vom Max-Planck-Institut für Dynamik und Selbstorganisation. Die Neurowissenschaftlerin wertet die Geräuschverarbeitung im Gehirn von Säugetieren aus, genau genommen in einem kleinen Bereich des Mittelhirns, dem Inferior Colliculus, abgekürzt IC.

"Die Gruppe in Hannover hat verschiedene Meerschweinchen gemessen, verschiedene Orte im IC, verschiedene Lautstärken. Das heißt, man kennt den Input, und man schaut sich an, was beim IC herauskommt. Dann versucht man, eine Funktion herzustellen, wie das Input-Signal zu einem Output-Signal transformiert wird."

Der Inferior Colliculus wandelt Höreindrücke in elektrische Impulse um. Wie das geht, welcher Ton welche Hirnsignale erzeugt, lässt sich nicht mit einfachen Gleichungen beschreiben. Es ist so komplex, dass Dominika Lyzwa Maschinenlernen benutzt:

"Sehr viele Daten. Ich habe über 2000 neuronale Gruppen untersucht. Letzten Endes dient diese Forschung dazu, Implantate zu entwickeln, die die Umsetzung von Geräuschen in neuronale Signale erledigen, also den IC nachbauen."

Bilderkennung bei Fahrzeugen

Ein anderes Beispiel ist die Bilderkennung: Moderne Autos erkennen mit Sensoren die Spur, auf der sie fahren. Sie warnen den Fahrer vor Hindernissen und vor überholenden Fahrzeugen im toten Winkel. Was sie als nächstes tun, ist Verkehrskennzeichen erkennen, auch in schneller Vorbeifahrt. Marc Tschentscher vom Institut für Neuroinformatik der Ruhruniversität Bochum entwickelt mit Maschinenlernverfahren Computerprogramme, die Stoppschilder erkennen:

"Wir sind einige Monate mit unseren Fahrzeugen in NRW herumgefahren und haben diese Daten aufgenommen."

- Terabytes?

"Ja, Terabytes, auf jeden Fall. Das sind im Endeffekt auch nur Rohdaten, also keine komprimierten Videodaten, damit man wirklich auch die kleinsten Verkehrszeichen erkennen kann."

- Und wie geht man dann dran?

"Dann nimmt man verschiedene Verfahren des maschinellen Lernens und teilt diesen Datensatz in einen Trainings- und einen Testdatensatz auf."

- Haben Sie’s mal getestet?

"Klar, wir machen das regelmäßig. Wir haben jedes Mal, wenn wir irgendetwas Neues trainieren, einen Testdatensatz da, um zu wissen, wie gut wir überhaupt sind.

Der Testdatensatz ist beim maschinellen Lernen unverzichtbar. Man kann die Maschine noch so gut trainieren, indem man ihr sagt, das Helle Verwackelte oben links in dem Video ist ein Stoppschild, das rötliche unten rechts ist keins. Erst wenn man dem Programm Bilder zeigt, die es noch nie gesehen hat, und es dann entscheiden muss, ob darauf Stoppschilder zu sehen sind, zeigt sich die Güte des Verfahrens."

Das Beispiel Computer-Go

"Schwer fällt es einem Menschen mit vollem Bauch, seinen Kopf sinnvoll einzusetzen. Gibt es unter ihnen keine Spieler von Liupo und Go? Nur diese Spiele zu spielen, ist besser, als nichts zu tun."

Der chinesische Philosoph Konfuzius sprach da vor rund 2300 Jahren zwei Brettspiele an, von denen das eine heute im asiatischen Raum stärker verbreitet ist als Schach und trotz fast primitiver Regeln zu den anspruchsvollsten Spielen überhaupt zählt: Go, chinesisch Weiqi, koreanisch Baduk.

Während seit 20 Jahren selbst erfahrene Schachspieler gegen Computerprogramme verlieren, spielen die Go-Programme auf dem Niveau von Anfängern. Sie machen keinen Spaß.

Schachsoftware arbeitet so: Wenn ich den Turm dahin ziehe, der Gegner dann den Bauern dorthin zieht, ich den Läufer dann dahin, stehe ich 0,88 % schlechter da als jetzt. Also prüft das Programm so lange weitere Möglichkeiten, bis es auf eine positivere Stellung stößt. Das ist ein klassisches deterministisches Programm, bei dem jeder Rechenschritt klar ist. Bei 32 Figuren am Brett ist es durchaus komplex, nur vier Züge nach vorn zu beurteilen. Kein Schachspieler kann so weit blicken. Aber heutige PCs, ja die Schach-Apps in Smartphones kommen damit locker zurecht.

Bei Go ist die Komplexität unvergleichlich größer. Wenn das Spiel beginnt, setzt Schwarz einen Stein auf eines von 361 Feldern. Wie soll der Computer entscheiden, auf welches? Dem ersten Zug von Weiß bleiben 360 Felder. Wohin soll Weiß seinen ersten Stein setzen? Die Zahl der Möglichkeiten geht ins Astronomische. Mit deterministischen Programmen ist hier nichts auszurichten, auch nicht mit Supercomputern.

In der Go-Szene schlug im März 2016 AlphaGo ein wie eine Bombe. Es wurde von Britischen Informatikern mit Maschinenlern-Techniken programmiert und trat nach einem Sieg gegen den Europameister gegen den Weltmeister an, den Koreaner Lee Sedol.

Hier beginnt am 9. März das erste Spiel. Lee Sedol hat Schwarz und fängt an. Zwei Stunden freies Spiel, dann eine Minute Nachdenkzeit pro Zug. Das Match wird in die Geschichte eingehen. Der 33-jährige Koreaner hatte bekannt gegeben, dass er mindestens vier der fünf Spiele gewinnen wird. Drei Stunden und 186 Züge später:

AlphaGo hat gewonnen. Das Programm lag schon länger vorn.

Lee Sedol scheint aufzugeben.

Das ist ja kaum zu fassen! Ein Computerprogramm hat den Weltmeister geschlagen und spielt damit mit neun Dan pro.

Das Maschinenlernprogramm gewinnt auch die Spiele zwei und drei und damit das Turnier. Der Weltmeister schwärmt von den ungewöhnlich guten Zügen, die AlphaGo macht, auf die kein Mensch gekommen wäre. Schöne Züge, Züge, über die er jahrelang nachdenken müsse. Spiel vier gewinnt Lee Sedol - und strahlt in der anschließenden Pressekonferenz.

"Danke, danke! Ich habe, obwohl ich das Tournier verloren habe, noch nie so viel Applaus geerntet. Wenn ich die drei ersten Spiele gewonnen und dieses hier verloren hätte, würde es wirklich weh tun. So aber ist es ein besonderer Sieg, den ich gegen nichts in der Welt eintauschen möchte."

Die Go-Welt ist verzaubert, und gleichzeitig scheint das uralte chinesische Spiel Go entzaubert. Nicht einmal die Programmierer, die die Software Millionen von Spielen gegen sich selbst haben spielen lassen, wissen, was sie genau tut. Paul Lukowicz:

"Es gibt Lernalgorithmen, wo das, wie das System sein Wissen codiert hat, in einer Art und Weise dargestellt ist, die man als Mensch kaum nachvollziehen kann. Und dazu gehören die neuronalen Netze."

Also Computerprogramme, die auf primitiver Ebene die Neuronen in unserem Gehirn nachempfinden.

Neuronale Netze: Für Menschen nicht mehr nachvollziehbar

Paul Lukowicz ist ein Informatiker, der gerne Mythen entzaubert. So auch den Mythos der neuronalen Netze.

"Neuronale Netze sind nichts irgendwie Besonderes. Ich sage immer meinen Studenten in Vorlesungen, neuronale Netze sind eine besondere Art, Vektor-Matrix-Multiplikationen darzustellen. Mehr tun sie nicht.

Das Problem ist, dass das neuronale Netz das Wissen in sehr komplexen Strukturen versteckt, die man als Mensch einfach nicht sehen kann."

Sebastian Houben: "Ja genau, das ist das große Problem. Es handelt sich dabei um so riesige Dimensionen an Daten - Vektoren -, dass man das auf keinen Fall schrittweise nachvollziehen kann."

Der Mathematiker Sebastian Houben von der Ruhr Universität Bochum. Sein Kollege Marc Tschentscher verweist auf ein Dilemma, das sich aus den Maschinenlernprogrammen ergibt: Einerseits locken die neuronalen Netze mit ihrer Eleganz; sie erkennen Stoppschilder selbst in unscharfen Aufnahmen, wo wir Menschen nichts mehr sehen. Andererseits kann man nicht nachvollziehen, wie sie das tun. Marc Tschentscher:

"Es ist immer wichtig, dass die Leute von der Autoindustrie genau wissen, was bei so einem Verfahren genau passiert."

- Das bedeutet, die neuronalen Netze haben da gar keine Chance?

"Also zurzeit nicht. Solange man nicht genau weiß, was die wirklich tun, oder man es nicht nachvollziehen kann, ist es im Moment nicht möglich, so etwas an die Industrie zu verkaufen."

- Das heißt, Sie haben eine Black Box, die wunderbar funktioniert. Aber man kann nicht reingucken, und deswegen ist es da, wo sehr sicherheitsrelevante Dinge passieren, eben bei einem Auto, das mit 30 oder 130 km/h fährt, unmöglich?

"Ja, das würde ich genauso sagen, ja."

Die Automobilhersteller, mit denen ich sprach, sympathisieren alle mit Deep Learning und neuronalen Netzen. Aber allein die Haftungsfragen verhindern, die Software in sicherheitskritische Elemente einzubauen. Man kann bei einem Unfall eben nicht die Zeile im Code finden, die das Kind für einen Busch hält und deswegen den Wagen nicht vollautomatisch bremst. Ein neuronales Netz lässt sich nicht in die Karten gucken, es arbeitet keine streng vorgegebenen Anweisungen ab.

Aber man wird neuronale Netze in Kürze da einsetzen, wo sie nur Empfehlungen geben. Statt den Wagen tatsächlich abzubremsen, meldet die Elektronik:

"Vorsicht! Ich vermute, da kommt uns sehr schnell ein Stoppschild entgegen."

- Und noch idealer wäre ja, wenn das System immer wieder neu dazulernt, dadurch, dass die Kamera eben dauernd herumguckt?

Marc Tschentscher: "Das wäre auf jeden Fall eine Perspektive. Da wäre nur noch viel Arbeit in der Vernetzung der Fahrzeuge zu leisten. Denn die müssten ja auch alles Gelernte miteinander kommunizieren und abspeichern können.

Ich denke, das größte Problem ist, dass da immer jemand sitzen muss, der sagt: Das ist wirklich so, wie du das gelernt hast, das ist richtig. Oder das Ganze ist halt, sage ich mal, Quatsch, das sollte nicht übernommen werden, dieses Verfahren."

Maschinenlern-Verfahren brauchen viel Rechenzeit, wenn sie lernen. AlphaGo brauchte Jahre, bis es verstand, auf Weltmeisterniveau zu spielen. Tobias Glasmachers, Juniorprofessor für Maschinelles Lernen am Institut für Neuroinformatik der Universität Bochum:

"Es ist schon richtig, dass ein großer Teil der Rechenzeit für das Training der Maschine verwendet wird. Und da müssen wir unterscheiden zwischen Offline- und Online-Training. Beim Offline-Training haben wir einen festen Datensatz vorgegeben: Wir ziehen uns zurück in unser Rechenzentrum, trainieren die Maschine und kommen irgendwann mit dem fertigen Klassifikator wieder hervor und liefern ihn dann zum Beispiel an einen Kunden aus. Beim Online-Training dagegen wollen wir, noch während der Klassifikator Vorhersagen macht, weiter lernen.

Dann müssen wir weiter zwischen Systemen unterscheiden, die echtzeitfähig sind, das heißt, die, während sie laufen, gewisse Rechenzeiteinschränkungen haben, und eben Systemen, wo die echte Laufzeit nicht so kritisch ist."

Eine elegante Methode, Rechenzeit zu sparen, ist die Parallelisierung. Man verteilt die Jobs des Lernens, des Trainings, der Datenverarbeitung einfach auf mehrere Computer oder Grafikkarten. Das ist bei vielen klassischen Computerprogrammen üblich. Auch neuronale Netze lassen sich einigermaßen parallelisieren, nicht aber die neueste Generation an Maschinenlern-Programmen. Sie heißen "Support-Vektor-Maschinen" und kommen aus der Tiefe der statistischen Mathematik. Im Grunde geht es darum, große Datenmengen zu teilen. Tobias Glasmachers:

"Das Training von Support-Vektor-Maschinen ist für diejenigen, die sich damit auskennen, ähnlich wie ein Koordinatenabstieg, ein Subspace Descent-Algorithmus. Der macht sehr viele kleine schnelle Schritte, und alle diese Schritte hängen voneinander ab. Das heißt, solche Algorithmen lassen sich nicht besonders gut parallelisieren und werden deswegen auch typischer Weise nicht auf Grafikkarten portiert."

Die Support-Vektor-Maschine ist sehr en vogue. In Zukunft werden beide Verfahren, neuronale Netze und Support-Vektoren, das Maschinenlernen bestimmen. Maschinenlernen wird häufig im Zusammenhang mit "Big Data" genannt, also sehr, sehr großen Datenmengen. Ein unscharfer Begriff, mit dem Informatiker wie Tobias Glasmachers vorsichtig umgehen:

"Im maschinellen Lernen haben wir immer zwei Blickpunkte: Das eine ist der Informatik-Standpunkt, wo wir uns die Laufzeiten von Algorithmen angucken. Und aus dieser Sicht bekommen wir tatsächlich im Big-Data-Bereich massive Probleme, zumindest mit vielen Standardalgorithmen, die es heute gibt. Aus statistischer Sicht sind, wie gesagt, große Datenmengen eher ein Segen als ein Fluch, und wir können uns viel besser auf unsere Ergebnisse verlassen."

Dauerndes Dazulernen mit sehr großen Datenmengen heißt Deep Learning. Oft wird Maschinenlernen mit Deep Learning verwechselt, so wie neuronale Netze mit Maschinenlernen gleichgesetzt werden. Richtig ist der Oberbegriff Maschinenlernen. Die mathematischen Modelle sind heute zumeist neuronale Netze oder Support-Vektor-Maschinen. Und wenn der Trainingsvorgang nie endet, sondern immer weiter geht, dann ist das Deep Learning. Tief und immer weiter lernen Google und Apple, wenn sie sich jeden Tag neue gesprochene Fragen anhören und versuchen, sie zu interpretieren. Sie werden minütlich besser.

"Es gibt einen weiteren Aspekt. Wir haben die ganze Zeit von der Interpretation datenanalytischer Modelle gesprochen, also von Daten, die wir analysieren. Wir sollten aber über etwas anderes sprechen, nämlich die Annahmen, die solchen Modellen zugrunde liegen, hinterfragen. Alle Maschinenlern-Verfahren bauen auf Annahmen über die Daten auf. Man geht zum Beispiel davon aus, dass die Testdaten in Zukunft auf den gleichen Voraussetzungen basieren wie die alten Trainingsdaten. Wir sollten also anfangen, Vorhersagemodelle im Lichte der Annahmen zu treffen, statt einfach loszurechnen", sagt der russische Mathematiker Wladimir Cherkassky, ein Urgestein des Maschinenlernens.

Software, bei der wir nicht genau wissen, wie sie zu einem Ergebnis gelangt, die aber meist überzeugende Ergebnisse liefert, verlockt. Ein Smartphone, das ich nach dem "Better" frage, und das mich sofort versteht, obwohl ich "Better" gesagt habe, statt "Wetter", hat etwas fast Menschliches.

Die Karlsruher Informatikerin Katharina Zweig weist auf Maschinenlern-Programme hin, die Vorhersagen über menschliches Verhalten machen. Und sie meint dabei nicht das Wetter oder den Börsenkurs, wo diese Technik auch immer mehr Fuß fasst, sondern die Politik:

"Stellen Sie sich vor - in Amerika ist das ja schon Gang und Gäbe - da gibt es eine Software, die heißt "Predictive Policing". Die erzählt der Polizei, wo es besonders wahrscheinlich ist, dass Einbrüche geschehen werden.

Natürlich ist das toll: Man kann die Streifendienste optimieren, man kann vielleicht auch den ein oder anderen Beamten einsparen. Aber man kann diesen Algorithmus auch noch weiter führen und könnte dann sagen: 'Hey du, du hast vier Kriminelle in deinem Bekanntenkreis, du trinkst ganz schön viel und bist ganz schön oft auffällig geworden. Mit 80 Prozent Wahrscheinlichkeit begehst du den nächsten Einbruch!'

Was ist, wenn jetzt falsche Modellierungsannahmen hinter einem solchen Algorithmus stecken? Wer kann uns davor beschützen? Wer kann diesen Algorithmus 'accountable' machen? Wer kann dafür sorgen, dass er tut, was wir denken, was er tut?"

Anders Sandberg: "Google hat diesen neuen Algorithmus veröffentlicht, der unter ein Foto schreibt, was darauf zu sehen ist. Er beruht sicherlich auf Deep Learning und wurde mit sehr, sehr vielen Beispielen trainiert. Nun passierte es, dass ein Pärchen dunkler Hautfarbe ein Selfie hoch lud, und die Software schrieb darunter: 'Gorillas'.

Die beiden haben das auf Twitter geteilt und waren ziemlich aus dem Häuschen. Google stand unter Schock. Man wollte ja auf keinen Fall, dass der Algorithmus rassistisch ist. Der Algorithmus aber kann gar nicht rassistisch sein, denn er hat gelernt, sich Bilder anzusehen und Worte darunter zu schreiben. Ihm ist es egal, ob jemand durch die Zusammenhänge, die er herstellt, beleidigt wird. Er beschreibt ja nur ein Bild, so wie er es gelernt hat. Für uns Menschen sind manche dieser Bezüge aber höchst problematisch.

Eigentlich sollte man der Maschine beibringen, dass Menschen vorsichtiger behandelt werden sollen, weil sie sich nämlich stark von Stühlen und vielleicht auch Katzen unterschieden. Das sehen wir aber erst jetzt, nachdem der Google-Algorithmus diesen dummen 'Fehler' gemacht hat. Wenn der behoben ist, werden sich natürlich andere Fehler zeigen, die wir nicht vorhersagen können. Egal, was wir tun, Maschinenlernen wird uns immer überraschen."