Seit mehr als fünf Jahren untersucht "AlgorithmWatch" die Auswirkungen und Risiken von Algorithmen auf Social-Media-Plattformen. Im vergangenen Jahr startete ein Forschungsprojekt auf Instagram. Dabei ging es darum, wie dort Videos und Fotos in der Timeline priorisiert werden. Doch das Projekt wurde eingestellt, erklärt Gründer und Gesellschafter Lorenz Matzat:

"Vor einigen Monaten hat sich Facebook bei uns gemeldet. Das schaukelte sich dann so langsam hoch, bis uns dann klar wurde, dass die ziemlich ernst wollten, dass wir das beenden, weil sie von ihrer Seite aus sagen, dass würde Datenschutzbelange betreffen, was wir anders sehen. Wir haben dann vor ungefähr einem Monat gesagt, dass wir das Projekt abbrechen, weil wir uns eigentlich nicht in der Lage sahen, gerade den rechtlichen Streit mit dem großen Konzern zu führen."

EU-Gesetzgebung soll Forschung möglich machen

Forschenden der New York University erging es zuletzt ähnlich: Sie konnten ein vergleichbares Projekt nicht fortsetzen. Auch in diesem Fall ging AlgorithmWatch damit an die Öffentlichkeit. In einem offenen Brief, der inzwischen mehr als 700 Mal unterzeichnet wurde, fordern sie die EU auf, solche Fälle in Zukunft zu verhindern. Tatsächlich gibt es mit dem Digital Services Act aktuell einen europäischen Gesetzesentwurf für digitale Dienste. Dort sind laut Lorenz Matzat bereits Abschnitte zur Forschung auf sozialen Netzwerken vorhanden.

"Aus unserer Sicht sind die bislang noch zu unkonkret und eben auch zu eng. Da stehen auch nur wissenschaftliche Forschungen drin und jetzt so Organisationen wie unsere aus dem zivilgesellschaftlichen Bereich sind dort nicht genannt und auch nicht journalistische Unternehmungen. Die Chance ist insofern größer, als sie vielleicht vor zwei Jahren war, weil es eben jetzt dieses Gesetzgebungsverfahren gibt. Das heißt, da ist wirklich noch Verhandlung möglich, und so wirklich große Freunde sind ja diese Social Networks nicht wirklich bei niemandem."

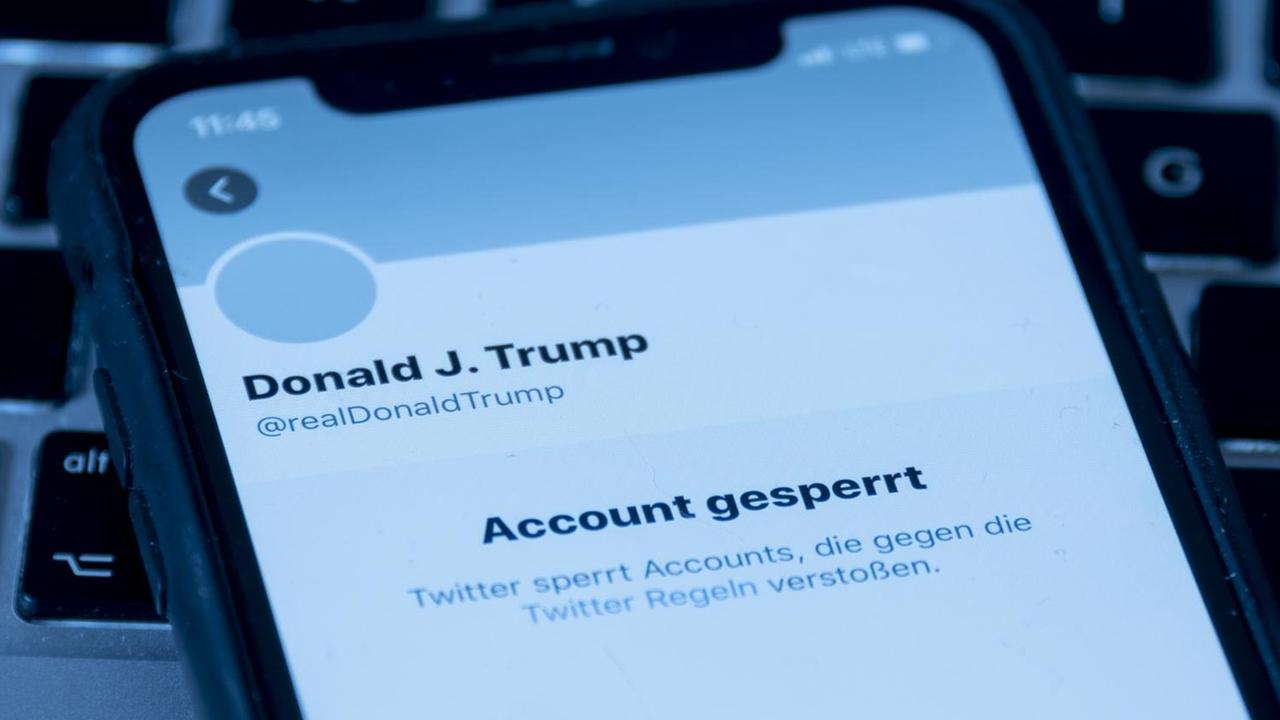

Facebook weist Vorwürfe zurück

Gegenüber mediasres hat Facebook zu den Vorwürfen schriftlich Stellung bezogen: Es habe nie die Absicht bestanden, AlgorithmWatch zu verklagen. Man begrüße unabhängige Forschungen, allerdings nicht auf Kosten der Privatsphäre seiner Nutzenden. Es gäbe Zusammenarbeiten mit hunderten von Forschungsgruppen, bei denen auch Datensätze und Schnittstellen zur Verfügung gestellt worden seien.

Algorithmus-Forscherin Katharina Zweig von der technischen Universität Kaiserslautern hat für ihre Untersuchungen noch keine Unterstützung von Facebook erhalten. Sie findet es generell sehr schwierig, soziale Netzwerke zu untersuchen: "Die verschiedenen Algorithmen in Social Media verwenden sehr viele Informationen über uns als Nutzer und Nutzerinnen. Zum Beispiel: Zu welcher Tageszeit wir auf die Plattform kommen, wo genau unser Rechner sitzt, was wir bisher schon gesucht haben. Da können Sie sich ja vorstellen, wie schwierig es ist, da wissenschaftlich genau einen Parameter zu isolieren und zu untersuchen, wie diese Information sich jetzt auf das Ergebnis auswirkt."

Informationen bedienen nur das eigene Weltbild

Für Zweig tragen soziale Netzwerke mit ihren Timelines dazu bei, dass Menschen in ihrer eigenen Blase bleiben und dann auch kaum Informationen bekommen, die nicht ihrem Weltbild entsprechen. Die Verantwortung, dass sich daran etwas ändert, sieht sie allerdings nicht nur bei der Politik.

"Wir müssen uns als Gesellschaft darüber verständigen, welche Algorithmen an welcher Stelle wir tatsächlich dauerhaft überwachen wollen. Dass man da dauerhaft eine Infrastruktur aufbaut, mit der solche Studien durchgeführt werden könnten. Wäre tatsächlich nicht besonders schwierig, noch nicht mal besonders teuer und ich glaube, dass wir uns das leisten sollten. Aber das ist natürlich eine politische und gesellschaftliche Diskussion, die wir zeitnah führen sollten."

Datenspender helfen den Forschenden

AlgorithmWatch führt aktuell auch Untersuchungen mit Freiwilligen auf YouTube durch. Dabei geht es darum, was verschiedenen Nutzenden zu Suchbegriffen rund um die Bundestagswahl angezeigt wird. YouTube wird regelmäßig vorgeworfen, mit seinen Algorithmen zur Radikalisierung beizutragen. Für Lorenz Matzat sind bei solchen Projekten Datenspenden besonders wichtig.

"Was wir eben machen können mit solchen Datenspenden entgegen anderer Untersuchungsformen ist, dass wir tatsächlich die personalisierten Daten bekommen. Die User loggen sich wirklich mit ihrem eigenen Account ein und wir können eben diese Empfehlungsalgorithmen untersuchen für den einzelnen User im Zusammenhang mit dem, was er vorher zum Beispiel geschaut hat, welche Kanäle er abonniert hat und so weiter."

Matzat wünscht sich, dass Medienaufsichten auch YouTube beobachten. Mit etwas anderen Strukturen kann er sich vorstellen, dass AlgorithmWatch auch zukünftig wieder Untersuchungen auf Facebook durchführt. Denn der Konzern hat ja nach eigenem Bekunden nichts dagegen.