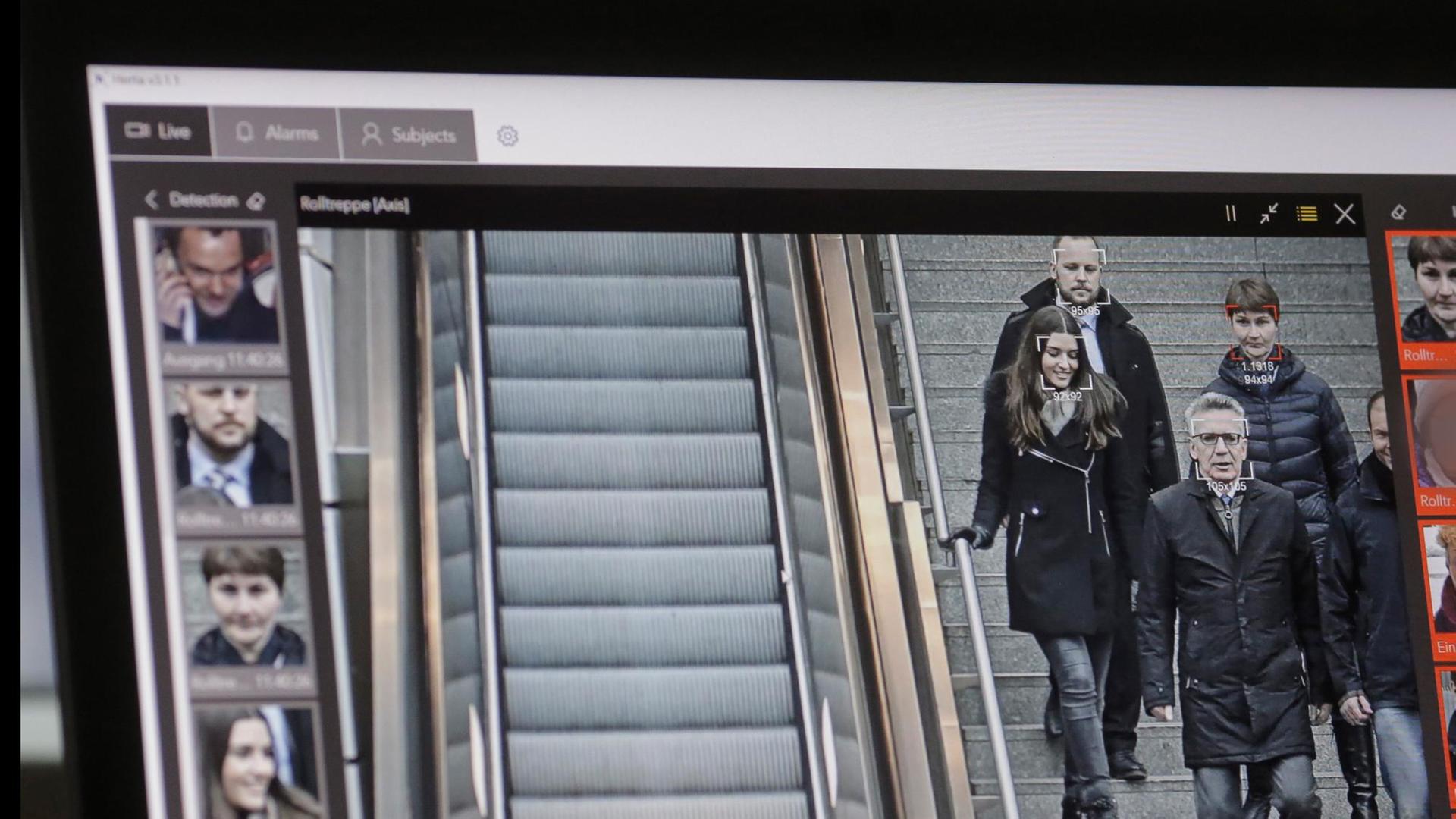

Mithilfe von intelligenter Software sollen Bilder von Überwachungskameras automatisch ausgewertet werden. Die Software soll dann von selbst die Gesichter gesuchter Personen erkennen, also zum Beispiel von mutmaßlichen Terroristen.

In den Augen mancher klingt das Versprechen der Sicherheitsindustrie vielversprechend. So wollte das Bundesinnenministerium diese Technik bundesweit an Flughäfen und Bahnhöfen einsetzen.

Gestern dann hatte Bundesinnenminister Horst Seehofer (CSU) Regelungen zur automatisierten Gesichtserkennung aus dem Entwurf für ein neues Bundespolizeigesetz nehmen lassen. Der Minister hatte aber klargestellt, dass er darunter keine grundsätzliche Abkehr von solchen Maßnahmen versteht.

CDU-Innenpolitiker Armin Schuster ist Obmann für die Unionsfraktion im Bundestagsausschuss für Inneres und Heimat und spricht im Interview über Hürden eines solchen Gesetzes.

Innere Sicherheit: Polizeigesetz zunächst ohne Gesichtserkennung

Nun doch keine automatisierte staatliche Gesichtserkennung: Das Innenministerium hat seine Pläne zur Novelle des Bundespolizeigesetzes geändert. Es seien noch zu viele Fragen offen, heißt es. SPD, Grüne und Datenschützer begrüßten dies, die Unionsfraktion hingegen zeigte sich wenig erfreut.

Nun doch keine automatisierte staatliche Gesichtserkennung: Das Innenministerium hat seine Pläne zur Novelle des Bundespolizeigesetzes geändert. Es seien noch zu viele Fragen offen, heißt es. SPD, Grüne und Datenschützer begrüßten dies, die Unionsfraktion hingegen zeigte sich wenig erfreut.

Brandes: Hat Horst Seehofer die Gesichtserkennung nur aus taktischen Gründen aus dem Gesetzentwurf herausgenommen, um jetzt das Gesetz schneller in den Bundestag bringen zu können? Sollen Sie als Parlamentarier jetzt die Buhmänner und -frauen sein, die die ungeliebte Gesichtserkennung wieder ins Gesetz reinschreiben?

Armin Schuster: Na ja, also das ist ein Verfahren, das eigentlich gar nicht so ungewöhnlich ist. Gerade wenn ein Minister merkt, dass er unter Umständen beim Koalitionspartner, wie jetzt auch im Bundesjustizministerium, Probleme hat, dann bin ich sogar ehrlich gesagt ganz dankbar, wenn das Gesetz deshalb nicht auf die lange Bank geschoben wird, sondern wenn er es im Kabinett durchbringt und wir an dieser Fassung dann parlamentarisch arbeiten können, dann gilt das alte Strucksche Gesetz sowieso. Wir verändern immer, und das war – ob ich jetzt die letzten Migrationsgesetze nehme oder das Waffenrecht oder was auch immer –, wir haben immer noch stark verändert, und deshalb bin ich jetzt gar nicht pessimistisch.

Wir müssen uns jetzt mit der SPD auseinandersetzen, weil eben dort andere Auffassungen herrschen, aber schauen wir mal. Ich freue mich darauf, weil ich sag mal, dieser Automatismus einer Abwehr des Einsatzes von neuen Methoden, von künstlicher Intelligenz, von smarten Technologien bei der Polizei, den können wir uns nicht leisten.

"Hürden waren im alten Entwurf sehr niedrig"

Brandes: Aber warum sollte das jetzt im parlamentarischen Verfahren klappen, die SPD zu überzeugen, wenn es nicht klappt, im Kabinett die SPD-Ministerinnen und -Minister zu überzeugen?

Schuster: Na ja, weil wir Parlamentarier natürlich auch gesetzgeberisch, rechtlich arbeiten. Wir führen ja nicht nur politische Diskussionen, sondern wir verhandeln jetzt hoffentlich intensiv an einem Gesetzestext. Und ich sag mal ganz offen, ich hätte mir auch an dem Gesetzentwurf, an dem alten, wo ja schon die Gesichtserkennung drin war, ich sag mal eine rechtlich qualifiziertere Regelung gewünscht.

Ich selber würde großen Wert darauf legen, dass die Rechtsgrundlage klar beschränkt den Einsatzort, dass klar in dem Gesetzestext erkennbar ist, wer ist überhaupt Gegenstand und Betroffener, also dass man klarmacht, hier geht es um Schwerverbrecher, hier geht es um Terroristen – das muss der Gesetzentwurf schon nach der Rechtsprechung des Bundesverfassungsgerichts eindeutig klarmachen.

Das hat die Regelung im alten Entwurf … also die war mir auch etwas zu … da waren die Hürden sehr niedrig. Und das wäre mein Angebot an die SPD: Wir können einen Riesensicherheitsgewinn erzielen an ganz bestimmten gefährlichen Orten, die müssen wir auch beschreiben, und für ganz bestimmte Personen, und auch die müssen wir beschreiben, also Schwerverbrecher, Terroristen et cetera. Und dann, glaube ich, kann da niemand etwas dagegen haben.

"Fehlerrate muss extrem klein sein"

Brandes: Ja, aber in den Blick der Kameras kommen ja dann alle, die dort durch den Bahnhof oder den Flughafen gehen. Insofern, kann man da wirklich sagen, betroffen sind wirklich nur die mutmaßlichen Schwerverbrecher?

Schuster: Sie haben recht, das werde ich mir auch selber als Parlamentarier sehr genau anschauen. Das System geht nur, wenn die Maßnahmen verhältnismäßig sind. Und verhältnismäßig sind sie nur, wenn die Fehlerraten extrem klein sind, extrem klein. Das muss die Technik beweisen.

Überwachung und Datenschutz: Wieviel Gesichtserkennung dürfen wir zulassen?

Was darf Künstliche Intelligenz? Die Recherchen der "New York Times" über die Nutzung einer Gesichtserkennungs-App namens "Clearview" durch US-Behörden werfen Fragen auf. Was ist rechtlich in Europa möglich? Wo zieht man die ethische Grenze bei der Nutzung solcher Daten?

Was darf Künstliche Intelligenz? Die Recherchen der "New York Times" über die Nutzung einer Gesichtserkennungs-App namens "Clearview" durch US-Behörden werfen Fragen auf. Was ist rechtlich in Europa möglich? Wo zieht man die ethische Grenze bei der Nutzung solcher Daten?

Brandes: Dann sprechen wir mal über diese Fehlerraten. Also jetzt bei dem Test am Berliner Bahnhof Südkreuz, da wurden ja in 20 Prozent der Fälle eine gesuchte Person nicht erkannt, das ist schlecht für die Ermittlungsbehörden, und in 0,1 Prozent der Fälle wurde eine falsche Person erkannt. Also bei mehreren tausend Fahrgästen, die durch so einen Bahnhof am Tag gehen, würde das bedeuten, dass jeden Tag mehrere Menschen fälschlicherweise verdächtigt werden von der Software. Wäre das für Sie verhältnismäßig?

Schuster: Nein, aber es gibt natürlich Möglichkeiten, das zu reduzieren. Die Zahl, die Sie gerade genannt haben, bedeutet, man hat ja am Südkreuz-Bahnhof mehrere Systeme mehrerer Firmen getestet, und Sie haben jetzt das Ergebnis einer Firma und eines Systems. Was ganz leicht möglich wäre, ist, um diese Falschmeldungen zu reduzieren, dass man mehrere Systeme gleichzeitig einsetzt und der Alarm nur gilt, wenn alle gleichzeitig das melden. Das hat man auch getestet, dann geht es um eine Fehlerrate von 0,000018 Prozent.

Brandes: Aber ist nicht eigentlich jeder Mensch, der fälschlicherweise da in Verdacht gerät, einer zu viel, weil die Konsequenzen können ja erheblich sein, wenn man mich jetzt plötzlich für einen Gefährder hält.

Schuster: Sie können sich sicher vorstellen, so sehr ich die Arbeit der Polizeibeamten auf der Straße, die Streife laufen, wertschätze, aber seien Sie sicher, dass das Verdachtschöpfen eines Polizeibeamten selbst als Mensch vermutlich eine höhere Fehlerrate hat als das System. Dann müssten Sie sich auch darüber beklagen, wenn ein Polizist Sie anhält, weil sie einen Verdacht hat, und dann ist der Verdacht eben ausgeräumt, weil wenn Sie Ihren Ausweis zeigen, dann weiß man, aha …

"Polizei Möglichkeiten geben, aus dem Karl-May-Zeitalter rauszukommen"

Brandes: Und da haben wir ja aber gerade in dem Beitrag auch gehört, dass offensichtlich die Fehlerrate bei Menschen mit nicht westlich weißer Hautfarbe vielleicht höher liegt, und diese Menschen beklagen ja sowieso, dass sie häufiger fälschlicherweise angehalten werden.

Schuster: Das hat man sehr intensiv getestet, gerade weil ja dieser Vorwurf sehr richtig und hart wäre, dann ginge es nicht, aber Schals im Winter, Sonnenbrillen im Sommer, Mütze auf dem Kopf oder andere Hautfarbe machen den Systemen, nach dem, was ich weiß, diese Probleme eben nicht. Aber das ist das Kernproblem.

Wir dürfen nicht pauschal neue moderne Technik immer von uns weisen, wenn es der Polizei helfen würde, nur die Technik muss – und darum kümmern wir uns jetzt –, sie muss einsatzfähig sein, weil nur dann ist die Maßnahme rechtlich verhältnismäßig. Aber ich möchte der Polizei einfach Möglichkeiten geben, aus dem Karl-May-Zeitalter rauszukommen. Wenn wir automatisiert auf einem Bahnhof herrenlose Gepäckstücke oder auf einem Flughafen erkennen können, ist das ein unglaublicher Sicherheitsgewinn, wenn wir Anis Amri im Bahnhof Zoo hätten so erkennen können, ist das ein unheimlicher Sicherheitsgewinn, und deswegen möchte ich nicht zu früh die Flinte ins Korn werfen.

Gefühlte Unsicherheit: Warum Deutschlands Polizei aufgerüstet wird

Das Unsicherheitsgefühl in der Bevölkerung hat zugenommen und bestimmt mehr und mehr die politische Agenda. Die Politik antwortet mit mehr Polizeipräsenz, erweiterten Befugnissen und Überwachungstechnik für Sicherheitsbehörden. Über die Effektivität dieser Maßnahmen wird gestritten.

Das Unsicherheitsgefühl in der Bevölkerung hat zugenommen und bestimmt mehr und mehr die politische Agenda. Die Politik antwortet mit mehr Polizeipräsenz, erweiterten Befugnissen und Überwachungstechnik für Sicherheitsbehörden. Über die Effektivität dieser Maßnahmen wird gestritten.

Brandes: Es gibt ja noch mehr Kritik an diesen Systemen. Gerade in dieser Woche, da haben wir in den USA erlebt, wie leicht Gesichtserkennungssoftware missbraucht werden kann. Da gab es die Firma Clearview, die hat Milliarden von Bildern aus dem Netz gefischt und Sicherheitsbehörden angeboten. Können Sie wirklich ausschließen, dass die Daten, die jetzt meinetwegen die Bundespolizei sammeln würde, nicht von so einer Firma gehackt würden?

Schuster: Ja, Herr Brandes, Entschuldigung, aber dass in vielen Statements von Kollegen aus der Opposition oder von Datenschutzbeauftragten eine derart groteske Geschichte aus den USA jetzt herangezogen wird … Das Einzige, was mir daran Sinnvolles einfällt, ist, ja, es wäre vielleicht schlauer, wenn unsere Datenschutzbemühungen sich mehr um Facebook, Google und was weiß ich was kümmern würden, oder Amazon, und nicht die deutsche Polizei permanent in den Misskredit gebracht wird, einen Überwachungsstaat gestalten zu wollen. Das machen wir seit über sieben Jahrzehnten eben gerade nicht.

Brandes: Na ja, aber hier war ja das Problem gar nicht bei Facebook, die haben ja jetzt selber die Anzeige erstattet, sondern es war eine Firma, die illegal Daten abgesaugt hat.

Schuster: Ja, aber wie würde es bei uns laufen? Die Daten, die in den polizeilichen Fahndungssystemen, also nehmen wir mal Terrorgefährder, gespeichert sind, die werden benutzt. Die liegen im Bundeskriminalamt und sonst nirgendwo.

"Aus meiner Sicht ein technisch mildes Mittel"

Brandes: Und das Bundeskriminalamt kann man nicht hacken?

Schuster: Das weiß ich nicht, ob es nicht wirklich eine Chance gäbe, aber ich weiß, dass es unglaublich schwer ist, das hinzukriegen. Und wenn das so leicht wäre, können Sie sicher sein, einige Hacker haben sich daran schon versucht.

Und vielleicht noch eine Information, damit da kein falscher Verdacht aufkommt: Wenn Sie als unbescholtener Bürger durch den Bahnhof Südkreuz laufen, die Kamera identifiziert Sie und gleicht jetzt ab, dann ist das ein Vorgang im Bruchteil einer Sekunde, in dem keine Speicherung Ihres Gesichts, Ihres Bildes vorkommt, sondern es ist ein Abgleich im Bruchteil einer Sekunde. Und wenn Sie negativ sind, fällt das in sich zusammen, Sie werden nicht gespeichert. Von daher ist der Eingriff aus meiner Sicht technisch sehr milde, ist ein mildes Mittel. Ich glaube, dass Sie eine höhere Chance hätten, durch eine Polizeistreife angehalten zu werden, wenn Sie ein bestimmtes Bild darstellen. Von daher, ich halte es für eine wunderbare Ergänzung, aber die Technik muss seriös sein.

Brandes: Zum Abschluss eine Frage mit der Bitte um eine kurze Antwort: Wie zuversichtlich sind Sie, dass Sie die SPD im Bundestag mit diesen Argumenten überzeugen werden?

Schuster: Ich bin zuversichtlich, dass wir mit einem ganz eng begrenzten Katalog an Straftaten, an Schwerststraftätern und einem eng begrenzten Bezug auf ganz bestimmte gefährliche Orte – da habe ich Hoffnung, dass ich die SPD-Kollegen überzeugen kann.

Äußerungen unserer Gesprächspartner geben deren eigene Auffassungen wieder. Der Deutschlandfunk macht sich Äußerungen seiner Gesprächspartner in Interviews und Diskussionen nicht zu eigen.