Die Außenwelt da draußen und die Gedanken innendrin – für Menschen, die am ganzen Körper gelähmt sind, gibt es diese zwei Welten. Die beiden zu verbinden, das war lange Zeit quasi unmöglich. Umso schlimmer, wenn das Hirn ansonsten topfit ist. Aber: die vergangenen Jahre haben Lichtblicke gebracht. Technik machts möglich, dass auch Menschen, die nicht mal mit der Wimper zucken können, mit anderen kommunizieren. Mit Elektroden im Gehirn, die dort Aktivitätsmuster übersetzen – zum Beispiel als Ja oder Nein oder als Bewegung für einen Zeiger auf einem Bildschirm, auf dem man einzelne Buchstaben auswählen kann.

Der Neurowissenschaftler Frank Willett hat mit seinem Team an der Universität Stanford eine Technik entwickelt, die auf Handschrift basiert. Er betont: "Das ist nur eine Machbarkeitsstudie, kein Produkt, das man irgendwo kaufen kann." Es müsse noch für die Anwendung verbessert werden und ein Unternehmen müsse das Konzept weiterentwickeln.

Das Interview in voller Länge:

Sophie Stigler: Also die gelähmte Person stellt sich vor, sie würde mit der Hand Buchstaben schreiben und genau diese Buchstaben erscheinen auf einem Bildschirm. Warum gerade Handschrift?

Frank Willett: Weil sich rausgestellt hat, dass sich die wunderbar für solche Gehirn-Computer-Schnittstellen eignet. Wenn jemand mit der Hand Buchstaben schreiben soll, dann macht er für jeden Buchstaben eine andere Bewegung. Das Muster der Hirnaktivität lässt sich deswegen für jeden Buchstaben klar unterscheiden. Das ist wichtig, wenn man nur eine Handvoll Nervenzellen im Gehirn über die Sensoren erfassen kann – bei uns sind es etwa hundert, im Bewegungsareal im Gehirn. Wenn die Muster da eindeutig sind, kann man sie schneller und treffsicherer übersetzen.

Stigler: Die Schnittstelle hat für Sie ein 65-jähriger gelähmter Mann getestet. Können Sie erklären, was er da machen musste und wie das abgelaufen ist?

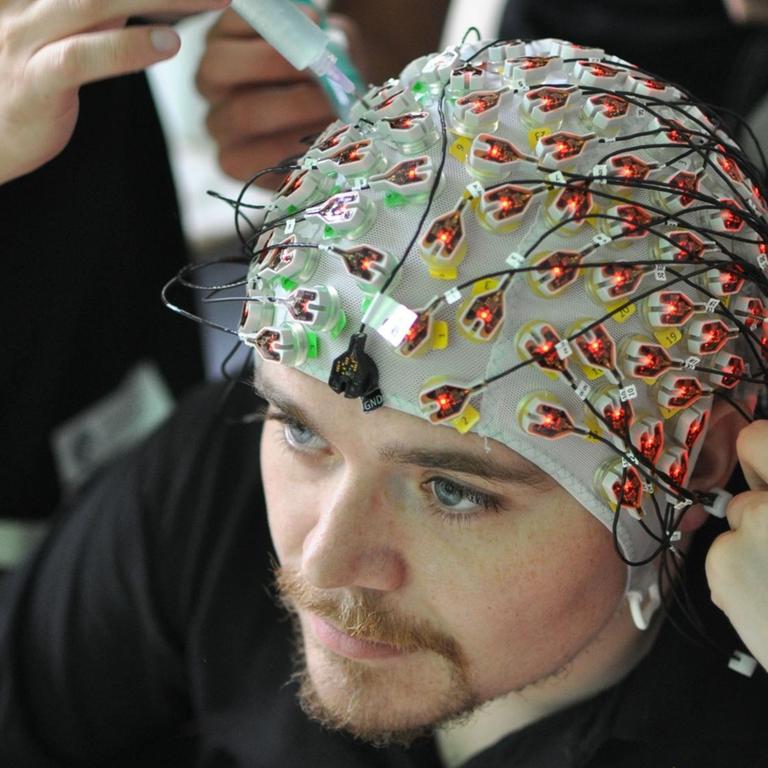

Willett: Wir können ja mal mit den Elektroden anfangen, die ins Gehirn eingepflanzt wurden. Das sind kleine Sensoren, so groß wie eine Tablette, und da hängen die haarfeinen Elektroden dran. Die Sensoren werden außen auf der Großhirnrinde angebracht und alle diese kleinen Elektroden können die elektrischen Signale von einzelnen Nervenzellen messen. Wenn jetzt die Person versucht, die Hand zu bewegen, löst das ein Aktivitätsmuster aus, das die Sensoren auffangen. Und dann muss man das eben noch in einen Buchstaben übersetzen. Dafür haben wir einen Algorithmus, der mit den Mustern trainiert wurde. Also, der sieht zum Beispiel das Muster für den Buchstaben A und dann erscheint ein A auf dem Bildschirm.

Deutlich schneller als etablierte Systeme

Stigler: Also, das System und die Person müssen sich erst verstehen lernen. Wie sieht dieses Training dafür aus?

Willett: Ja, zuerst sollte er die Buchstaben mehrere Male in Gedanken schreiben und wir haben die Daten gesammelt. Also, wir haben ihn gebeten: Bitte schreiben Sie ein A, bitte ein C und so weiter. Und damit können wir das System trainieren. Er selber muss nicht trainieren, er weiß noch wie man schreibt, auch, wenn er schon viele Jahre gelähmt ist. Also, er muss nur versuchen, zu schreiben.

Stigler: Und wie fand er das System, was war sein Urteil?

Willett: Er war positiv überrascht. Er war vorher skeptisch, ob das funktionieren würde: "Meine Sauklaue könnt ihr sowieso nicht entziffern. Ich stelle mir das nur vor und ihr zeigt es mir auf dem Bildschirm? Das ist cool." Ja, es geht zweimal so schnell wie das System, das er bisher gewöhnt war.

Bisher bloß eine Machbarkeitsstudie

Stigler: Wie treffsicher kann der Algorithmus denn erkennen, was er sagen will?

Willett: Ziemlich treffsicher. Wenn man keine Korrektur drüberlaufen lässt, die reinen Buchstaben übersetzt, dann kommt man auf 95 Prozent. Das heißt einer von zwanzig Buchstaben ist falsch. Wenn man noch eine Autokorrektur anwendet wie auf dem Handy, dann ist das System sehr treffsicher, mehr als 99 Prozent. Also, es ist fast alles richtig.

Stigler: Wo liegen die Nachteile, die Grenzen?

Willett: Naja, eine Sache ist, wie lange man das System trainieren muss, das müssen wir noch besser machen. Aber es ist wichtig, zu verstehen: Das ist nur eine Machbarkeitsstudie, kein Produkt, das man irgendwo kaufen kann. Es muss noch für die Anwendung verbessert werden und ein Unternehmen muss das Konzept weiterentwickeln, die ganzen Details ausarbeiten.

Nächstes Ziel: Sprechbewegungen entschlüsseln

Stigler: Und was ist für Sie der nächste Schritt, haben Sie schon Pläne?

Willett: Ja, einige. Einer wäre: Können wir Sprechbewegungen entschlüsseln von jemandem, der nicht sprechen kann, und damit eine Unterhaltung wieder möglich machen? Wir denken viel darüber nach, wie wir die Methoden, die wir hier benutzt haben, für sowas anwenden können. Also, es mit Sprechen zu probieren, das wäre spannend.

Stigler: Ist das nicht viel, viel schwerer?

Willett: Ja, es ist auf jeden Fall viel schwerer. Es haben viele sich schon an Sprache-Gehirn-Schnittstellen versucht und da ist man nicht man annähernd so weit wie wir jetzt mit der Handschrift. Beim Sprechen sind es viel feinere Bewegungen und dazu noch viel schneller. Deswegen braucht man besonders verlässliche Signale und noch bessere Algorithmen. Also: Das wäre eine tolle Herausforderung.

Gedankenlesen bleibt eine Herausforderung

Stigler: Glauben Sie, dass es mal möglich sein wird, rauszufinden, was ein Mensch denkt, ohne diesen Umweg über die Schrift oder Mundbewegungen beim Sprechen? Oder braucht man immer diesen Bewegungsreiz, um das zu entschlüsseln?

Willett: Interessante Frage. Ich denke, im Prinzip sollte es möglich sein, weil, wenn wir etwas denken, dann ergibt das ein Aktivitätsmuster im Gehirn. Wenn man in die richtigen Hirnareale schaut, müsste man es auslesen können. Wir haben uns besonders auf diese Bewegungsabsicht konzentriert, auch, weil es da schon viel Erfahrung gibt, wie sich das im Gehirn zeigt, was die Nervenzellen machen und wie man das ausliest. Es ist eine viel weniger klare Aufgabe, wie man Gedanken liest – und man kann das auch ganz schlecht in Tierversuchen erforschen. Beim Bewegungsareal im Gehirn wissen wir, wo wir hinschauen müssen. In anderen Arealen kann es sein, ich setze meine Elektroden ein und sie sind da falsch. Weil sich die Aktivität ganz woanders abspielt, vielleicht stärker gestreut ist. Aber das könnte eine spannende Aufgabe für die fernere Zukunft sein.

Äußerungen unserer Gesprächspartner geben deren eigene Auffassungen wieder. Der Deutschlandfunk macht sich Äußerungen seiner Gesprächspartner in Interviews und Diskussionen nicht zu eigen.