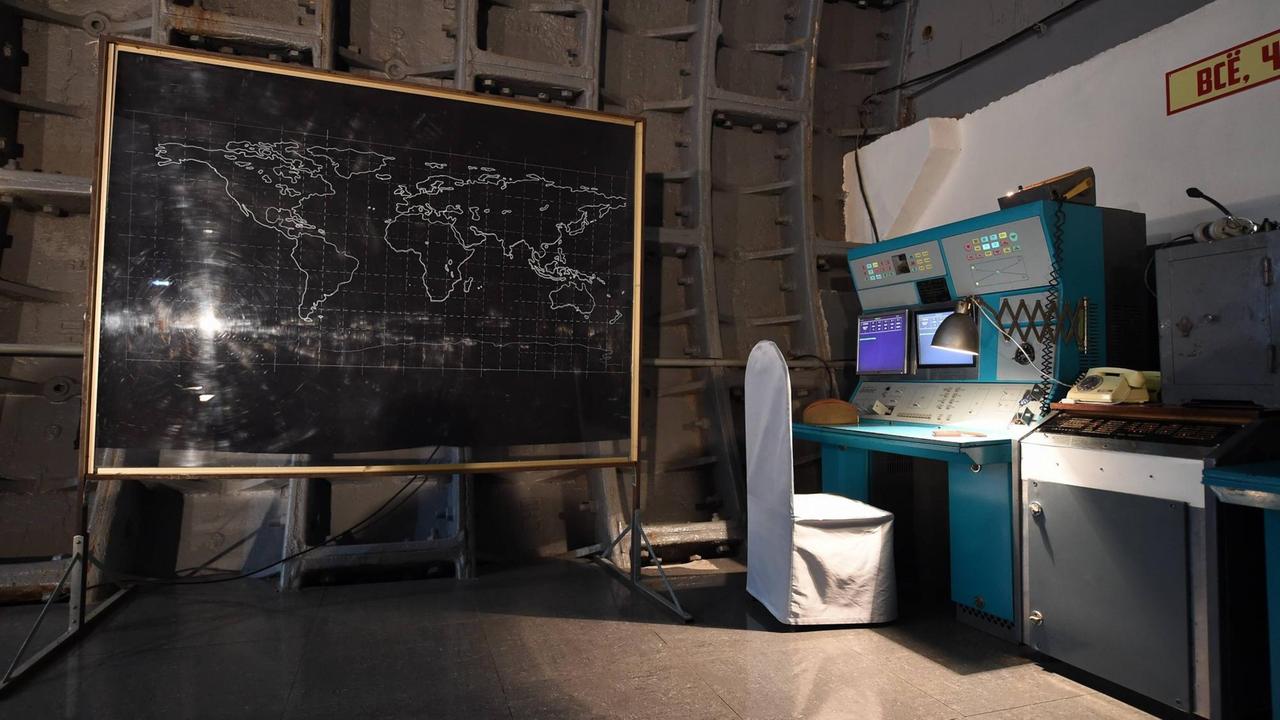

26. September 1983, kurz nach Mitternacht. Stanislaw Petrow ist diensthabender Offizier im Serpuchow-15-Bunker bei Moskau. Er hat sich gerade einen Tee geholt, als sein Computer Alarm schlägt: Die USA haben Interkontinentalraketen abgefeuert. "Start" leuchtet auf einem tiefroten Bildschirm auf. Eine Sirene heult los.

Vincent Boulanin, KI-Experte am schwedischen Friedensforschungsinstitut SIPRI:

"Seit die Entwicklung der Computer Fahrt aufgenommen hat, haben Staaten geprüft, ob sich Teile der Architektur rund um die Atomwaffen automatisieren lassen - im Bereich der Frühwarnung etwa oder bei den Raketennavigationssystemen."

1983 ist das Computersystem, mit dem Oberstleutnant Petrow arbeitet, recht neu. Doch Petrow weiß auch, dass die Nato auf die von der UdSSR in Europa stationierten SS-20-Mittelstreckenraketen mit der "Pershing-II" und mit Marschflugkörpern antworten will. Dass US-Präsident Ronald Reagan einen Raketenschutzschirm im Weltraum angekündigt und dass das sowjetische Militär eine verirrte koreanische Linienmaschine abgeschossen hat.

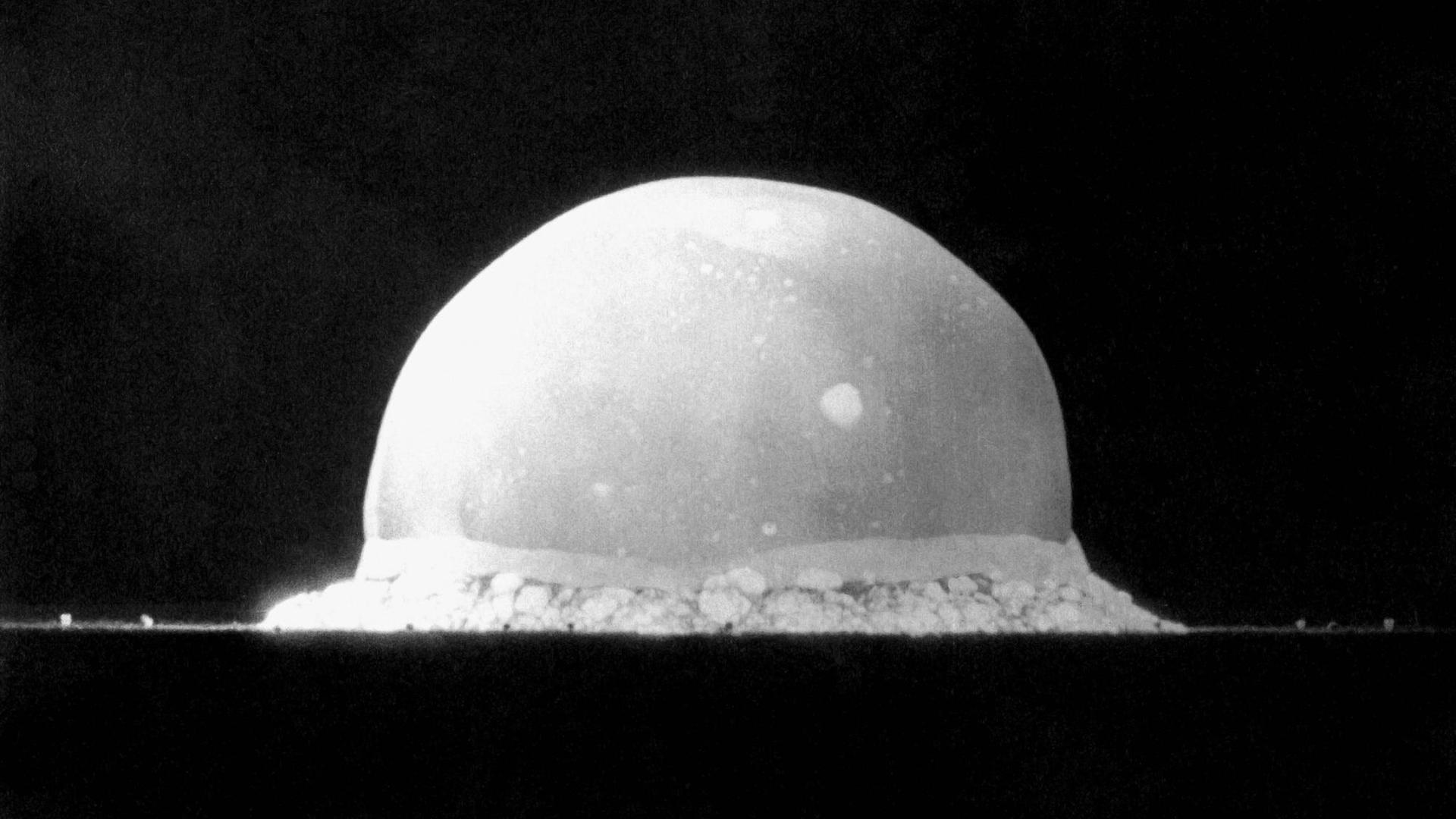

20 Minuten – dann würden die US-Raketen die Sowjetunion erreichen. Seine Kollegen, bei denen die Satellitendaten einlaufen, haben nichts auf ihren Schirmen. Doch das Protokoll besagt eindeutig: Die Entscheidung erfolgt auf Grundlage der Computeranalyse. Er muss das Oberkommando informieren. Doch warum sollten die USA den Erstschlag nur mit ein paar Raketen starten? Stanislaw Petrow meldet an seine Vorgesetzten im Hauptquartier der Sowjetarmee: System arbeitet fehlerhaft. Wenn er sich irrt, wird gleich die erste Atomexplosion erfolgen …

Die Katastrophe blieb aus. Der Computer hatte Sonnenreflexionen auf Wolken als Raketenstarts interpretiert.

"Künstliche Intelligenz" soll Datenflut bewältigen

Seit damals hat sich die Informationstechnik laufend fortentwickelt und im Golfkrieg 1990 dem US-Militär den Sieg über Saddam Hussein binnen Wochen beschert. Doch die derzeit in allen Atomwaffenstaaten laufende Modernisierung ist auch eine Digitalisierung auf ganz neuem Niveau. Eine Flut an Satelliten- und Radardaten und diverse nachrichtendienstliche Informationen laufen in den Kommandozentralen ein. Auswerten soll sie KI. Hans Kristensen, Direktor des Nuclear Information Projects bei der "Federation of American Scientists":

"Militärs werden Ihnen sagen, dass sich diese Masse an Informationen nur mit künstlicher Intelligenz bewältigen lässt. Sie werden sagen, Künstliche Intelligenz ist sehr nützlich, weil Sie damit alles viel umfangreicher, besser und schneller verarbeiten können."

Die meisten Ansätze nutzen maschinelles Lernen, um durch statistische Analysen in Datenmassen Muster zu erkennen. Vincent Boulanin:

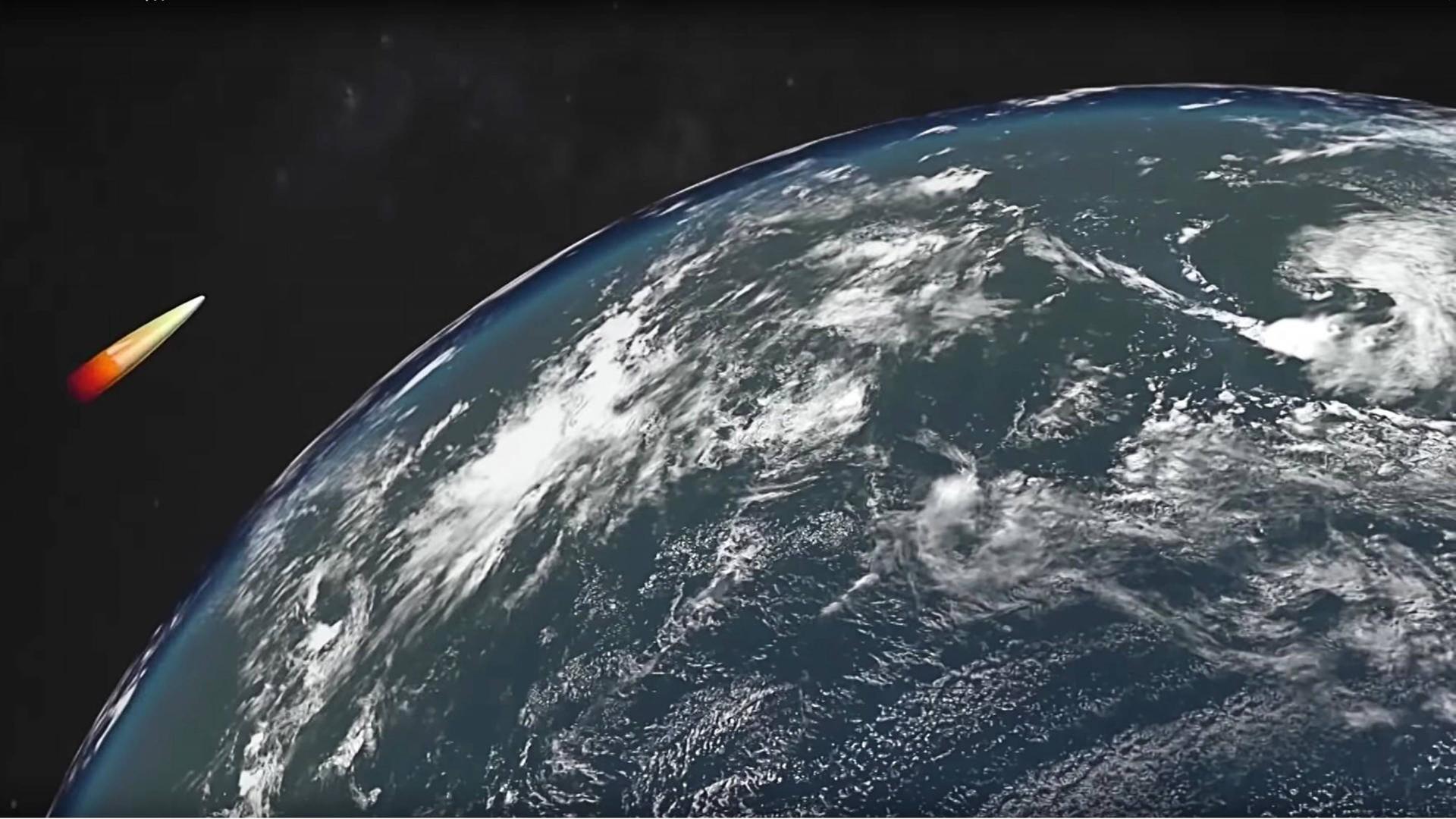

"Was wir erwarten, ist, dass Anwendungen, die wir heute schon haben, leistungsfähiger werden durch die jüngsten Fortschritte beim maschinellen Lernen. Wir können Frühwarnsysteme so entwerfen, dass sie Ziele oder Angriffe besser erkennen. KI dürfte in der Steuerung von Raketen oder Torpedos eingesetzt werden, bei der Erkennung und Abwehr von Cyberangriffen und bei der Truppenführung."

Druck auf menschliche Entscheider nimmt massiv zu

Vincent Boulanin sagt, maschinelles Lernen werfe gleich mehrere Probleme auf: Die Arbeit der Algorithmen lasse sich weder genau nachvollziehen, noch ihre Zuverlässigkeit und Sicherheit nachweisen:

"Das ist in Verbindung mit Atomwaffen eindeutig ein Risiko."

In Entwicklung sind KI-Systeme, die aufgrund zur Verfügung stehender Informationen die besten Handlungsoptionen aufzeigen sollen – bis hin zur Auswahl der Ziele oder der Wahl der Mittel. Dem Menschen bliebe dann, auf Grundlage der Computeranalyse zu entscheiden.

Ulrich Kühn leitet den Forschungsbereich "Rüstungskontrolle und Neue Technologien" am Institut für Friedensforschung und Sicherheitspolitik an der Universität Hamburg.

"Aber was heißt das konkret? Dort, wo der Algorithmus schon die Auswertung für den Menschen übernimmt, präsentiert er ja bestimmte Ergebnisse. Und das könnte natürlich gerade in akuten Krisen, wo man vielleicht binnen Minuten entscheiden muss, dazu führen, dass der Druck auf die menschlichen Entscheider massiv zunimmt."

Digitalisierung reißt neue Flanken für Fehler und Ausfälle auf

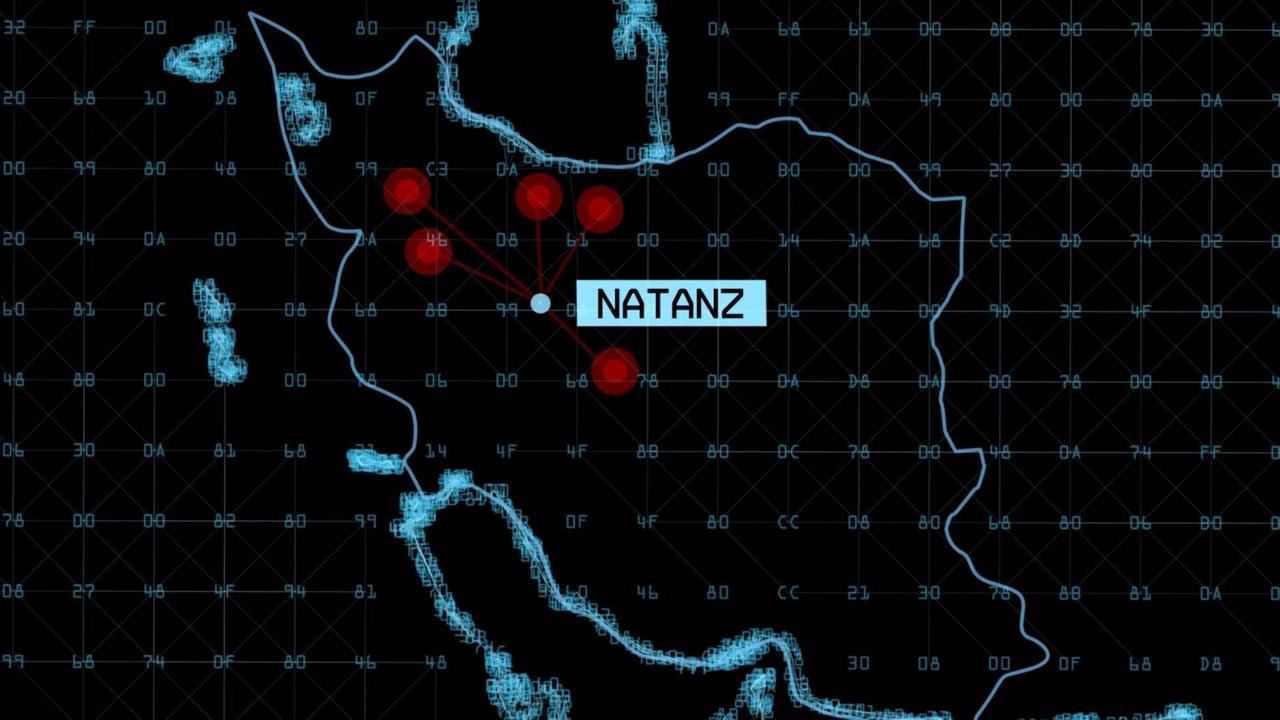

Dass KI eines Tages über den Einsatz von Nuklearwaffen alleine entscheide, hält Ulrich Kühn für unwahrscheinlich - doch ihr Einfluss werde wachsen. Schließlich folgte bei Atomwaffen bislang die Strategie immer den Möglichkeiten. Die Digitalisierung reiße zudem neue Flanken auf. Etwa wenn durch einen Hackerangriff ein Satellit ausfällt, der Aufgaben für konventionelle und nukleare Streitkräfte erfüllt. Kühn:

"In dem Moment, wo beispielsweise ein solcher Satellit gehackt wird, müssten die USA ja theoretisch davon ausgehen, dass vielleicht ein anderer Nuklearwaffenstaat jetzt den Erstschlag vorbereitet und dass das im Grunde der erste Schritt ist, dass man diesen Satelliten ausgeknipst. Diese Vermischung sehe ich als ein massives Sicherheitsproblem für die nächsten Jahre und Jahrzehnte."

Eine neue Gemengelage entsteht zudem durch Cyberangriffe. Schadsoftware wie Viren und Würmer oder auch logische Bomben können auch nukleare Abschreckungssysteme ausschalten. Vincent Boulanin:

"Das eigentliche Problem ist, wie die Staaten das Risiko einschätzen. Manchmal wirkt schon die Wahrnehmung, dass der Feind durch KI besser ausgerüstet ist als man selbst, destabilisierend. Wenn ich glaube, dass China viel in KI investiert und sich deshalb besser vor meinen Angriffen schützen kann, werde ich meine Entscheidungen entsprechend anpassen."

Abhängigkeit von Algorithmen schafft gefährliche Eigendynamik

Die USA haben bereits angekündigt, sich bei Cyberangriffen eine nukleare Antwort vorzubehalten. Die Abhängigkeit der Atommächte von Algorithmen ist heute schon enorm und sie wächst weiter. Datenberge, hyperschnelle Trägersysteme, komplexe Verzahnungen - für Hans Kristensen steckt darin eine gefährliche Eigendynamik:

"Künstliche Intelligenz dürfte im nuklearen Arsenal zunehmen, weil die Entscheidungsträger vor ihrer Entscheidung schlicht weniger Zeit haben herauszufinden, was vor sich geht. Das ist also eine sehr gefährliche Spirale, in die wir da geraten."

Ein Fehlalarm kann einen Atomkrieg auslösen. Vincent Boulanin:

"Es ist also wichtig, dass Mechanismen entwickelt werden, die irgendwie verhindern, dass ein Systemausfall zu katastrophalen Entscheidungen führt."

(*) Anmerkung der Redaktion: Bei dem Bild handelt es sich um einen Nachbau des Kommandozentrums für einen nuklearen Gegenschlag im "Bunker 42" im Museum des Kalten Krieges Moskau. Dieser Zusatz fehlte in einer ersten Version.