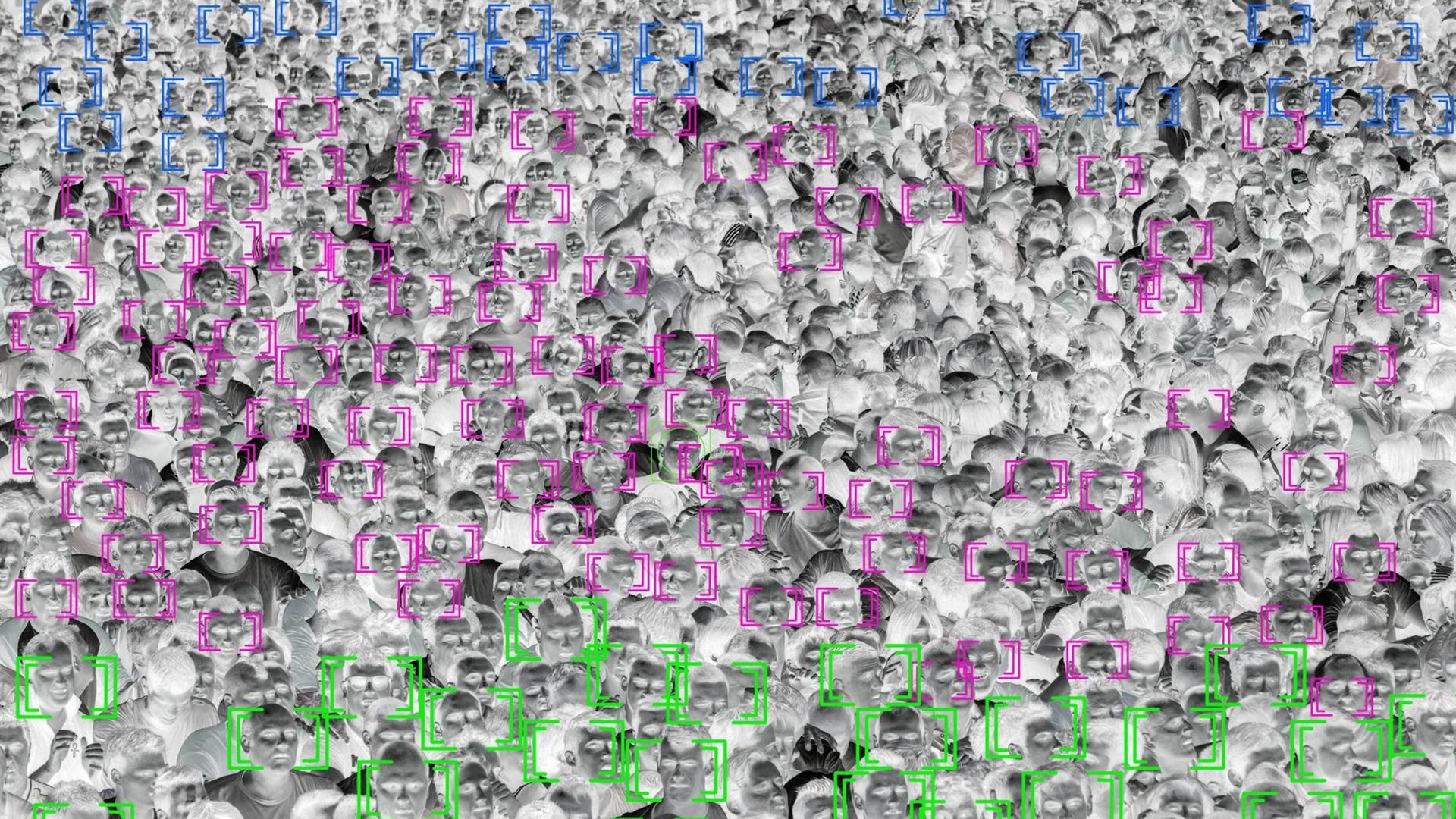

In den USA haben Mathematiker und Mathematikerinnen aus den USA alle Kollegen aufgerufen, keine Algorithmen mehr für die Polizei zu entwickeln. Diese seien unweigerlich rassistisch - genau wie das Polizei- und Justizsystem. Denn die Algorithmen werden mit Daten eines Justizsystems gefüttert, das nachweislich nicht gerecht ist und in dem Schwarze Bürgerinnen und Bürger schlechtere Chancen vor Gericht haben als weiße.

Sandra Wachter forscht an der Universität Oxford dazu, wie gerecht Algorithmen sein können. Ein Algorithmus schaue sich immer alte Entscheidungen an, erklärte sie im Dlf: "Wie hat man in der Vergangenheit, in den letzten 20, 30, 40 Jahren Kredite vergeben, wen hat man befördert, wen hat man ins Gefängnis geschickt. Anhand dieser Muster wird dann der Algorithmus zukünftige Entscheidungen treffen."

Da es aber zum Beispiel in der Strafjustiz oder bei Beförderungen in der Vergangenheit oft zur Diskriminierung gekommen ist, müsse man regelmäßig kritisch auf diese Daten schauen, "weil wir sonst einfach glauben, dass Algorithmen neutral aufgrund von Daten Entscheidungen treffen, die aber eigentlich diesen fürchterlichen historischen Hintergrund mit sich bringen."

Das Interview in voller Länge:

Sophie Stigler: Fangen wir doch mal mit einem guten Beispiel an: Können Sie mir einen Algorithmus sagen, der in einer schwierigen gesellschaftlichen Aufgabe gute Ergebnisse bringt?

Sophie Stigler: Fangen wir doch mal mit einem guten Beispiel an: Können Sie mir einen Algorithmus sagen, der in einer schwierigen gesellschaftlichen Aufgabe gute Ergebnisse bringt?

Sandra Wachter: Es gibt bestimmte Bereiche, wo Algorithmen besser sind als Menschen, wenn sie Entscheidungen treffen. Wenn man sich jetzt überlegt, die Probleme, die es bei der menschlichen Entscheidungsfindung gibt – das könnte zum Beispiel sein, dass jemand Stimmungsschwankungen hat. Das könnte sein, dass jemand hungriger ist und deswegen seine Entscheidungsfindung beeinträchtigt ist. Es könnte sein, dass man jemanden bestechen könnte.

Algorithmen entscheiden anhand menschlicher Entscheidungen

Stigler: Das wurde auch nachgewiesen, dass Richterinnen und Richter in den USA kurz vor der Mittagspause, also wenn sie gerade hungrig sind, eher härtere Urteile fällen.

Wachter: Genau! Was ja auch menschlich, verständlich ist. Oder wir haben jemanden vor uns, der uns bewusst oder unbewusst an jemanden erinnert, den wir gar nicht mögen. All diese Dinge fließen dann natürlich in die Entscheidungsfindung ein. Diese Dinge, die kann man mit Algorithmen lösen, weil die werden nicht müde, die können nicht bestochen oder bezirzt werden und die haben auch keine alten Schulfreunde, die sie wieder vor sich sehen. Also dieser Teil der algorithmischen Entscheidungsfindung ist besser als mit Menschen.

Aber natürlich ist das nicht die ganze Geschichte, weil sozusagen der Algorithmus ja nicht mit diesen Ideen aufwartet, von sich selbst aus sich überlegt, wer könnte denn ein guter Arbeitnehmer sein, wer soll denn befördert werden, wer soll den Kredit bekommen. Nein, das muss man sich so vorstellen, dass ein Algorithmus, der Entscheidungen fällen soll, ob jemand eingestellt werden soll oder jemand einen Kredit bekommt, der schaut sich alte Entscheidungen an. Wie hat man in der Vergangenheit, in den letzten 20, 30, 40 Jahren Kredite vergeben, wen hat man befördert, wen hat man ins Gefängnis geschickt. Anhand dieser Muster wird dann der Algorithmus zukünftige Entscheidungen treffen.

Das wäre an für sich gar kein Problem, wenn wir der Meinung wären, dass wir immer gute Entscheidungen treffen. Das Problem ist leider, dass wir das nicht immer so gut gemacht haben. In der Strafjustiz, wenn es um Beförderungen geht, wenn es um Kredit geht – all diese Dinge, da findet sich ein großer Bias, eine große Diskriminierung.

Aber der Algorithmus kennt die Geschichte nicht, der Algorithmus kennt die Geschichte der Diskriminierung aufgrund Sexualität oder ethnischer Zugehörigkeit oder geschlechtlicher Orientierung, kennt der nicht. Der sieht nur Daten wie, ah, in den letzten 20, 30 Jahren haben diese Menschen als CEOs gearbeitet oder als Professoren gearbeitet. Der kennt die Entscheidungsfindung dahinter nicht, der weiß nicht, warum diese Menschen ausgesucht worden sind.

Deswegen ist es ganz wichtig, ein bisschen kritisch auf diese Dingen zu schauen, weil wir sonst einfach glauben, dass Algorithmen neutral aufgrund von Daten Entscheidungen treffen, die aber eigentlich diesen fürchterlichen historischen Hintergrund mit sich bringen.

"Der Algorithmus hält uns einen Spiegel vor das Gesicht"

Stigler: Ist ja logisch. Wenn ich mein Programm mit verzerrten Daten füttere und es daraus lernen soll, dann bekomme ich auch ein verzerrtes Ergebnis. Jetzt die Frage, kann man das irgendwie retten?

Wachter: Ich glaube, man muss da leider an sehr vielen Seiten gleichzeitig arbeiten. Man kann nicht erwarten, dass der Algorithmus oder in Wirklichkeit irgendeine Technologie soziale Probleme lösen kann. Das ist nicht möglich, das ist ja nicht die Schuld des Algorithmus. Der Algorithmus hält uns einen Spiegel vor das Gesicht.

Jetzt ist die Frage, was machen wir mit diesem Spiegelbild? Wir müssen dieses Spiegelbild nutzen, um einen Dialog anzufangen und herauszufinden, wieso ist es denn so, dass weniger Frauen in den Mathematikstudiengängen zugelassen werden? Warum ist es denn so, dass Afroamerikaner länger im Gefängnis eingesperrt sind als andere? Warum entscheiden wir die Entscheidungen so? Und dann müssen wir uns überlegen, wie wir da entgegenwirken können.

Stigler: Aber selbst wenn man jetzt diese Verzerrung der Daten von früher kennt, kann man sie denn dann noch verwenden? Kann man dem Algorithmus sagen, okay, du darfst dir diese Daten angucken, aber bedenke, dass sie eben verzerrt sind?

Wachter: Das Problem ist, dass man das nur technisch alleine gar nicht lösen kann. Man muss eigentlich in einem Team zusammenarbeiten, wo sich Juristen, Ethiker, Soziologen und Techniker zusammentun, um zu verstehen, was die Daten eigentlich aussagen, um herauszufinden: Welche Daten, welche Kriterien können wir nutzen, die jedem die gleichen Möglichkeiten geben, wo es keine Diskriminierung gibt.

Interdisziplinäres Team müsste Kriterien untersuchen

Stigler: Aber was wäre jetzt ein Modell, wie man das Ganze lösen kann? Man muss jetzt bei jedem Algorithmus sozusagen ein interdisziplinäres Wissenschaftsteam zusammenstellen, die sich dann zusammen genau angucken, was haben wir da jetzt eigentlich gemessen? Ist das realistisch?

Wachter: Zum Beispiel ich habe eine Forschungsgruppe hier in Oxford, dort haben wir genau so eine interdisziplinäre Gruppe. Ich bin die Juristin und ich arbeite mit einem AI-Experten zusammen und mit einem Ethiker. Wir haben herausgefunden, wie man ein bisschen diese Black Box öffnen kann und einfach verständlich nachvollziehen kann, was der Algorithmus macht. Wir haben Methoden entwickelt, wie man sozusagen Diskriminierung testen kann und Möglichkeiten erschaffen, um zu sehen, dieser Algorithmus benachteiligt zum Beispiel Afroamerikaner oder Frauen oder welche Gruppe auch immer, an der man interessiert ist.

Stigler: Dieses Werkzeug, um zu schauen, ob ein Algorithmus diskriminierend ist oder nicht, ist das etwas, was Unternehmen auch verwenden könnten, um ihre eigenen Algorithmen zu testen? Also zum Beispiel, wenn ein Unternehmen einen Algorithmus verwendet, um Jobbewerbungen zu sortieren?

Wachter: Genau! Wir haben zum Beispiel einen algorithmischen Test entwickelt, das ist mathematisch, zu kompliziert, um es zu erklären. Aber in Wirklichkeit ist das genau die Idee dahinter. Man will ja eigentlich nicht warten, bis sozusagen die Klagen anfangen, sondern man will ja eigentlich Diskriminierung von vorneherein verhindern.

Und die Art und Weise, wie wir uns das eben auch vorstellen, ist sozusagen den öffentlichen und den privaten Sektor einzuladen, diese Tests zu benutzen und periodisch ständig zu testen, ob ihre Algorithmen bewusst oder unbewusst gegen bestimmte Gruppen diskriminieren. Weil oftmals wissen sie es ja auch nicht, weil es eben nicht so offensichtlich ist wie ein Kopftuchverbot oder solche Dinge, sondern die nutzen ganz untraditionelle Daten, wo einem vielleicht gar nicht klar ist, dass so etwas passiert.

Stigler: Vielleicht können wir ja doch mal versuchen, zumindest ansatzweise zu verstehen, was der Test leistet. Wenn ich das richtig verstehe, würde er sich zum Beispiel bei einem Bewerbungsszenario angucken, welche Menschen wurden aufgrund des Algorithmus eingeladen und welche eben nicht, und würde die nach verschiedenen Eigenschaften vergleichen und gucken, ob eine Gruppe dann besonders oft abgelehnt wurde zum Beispiel, kann man das so zusammenfassen?

Wachter: Ja! Und dann beginnt die harte Arbeit, weil dann muss ich herausfinden, warum der Algorithmus das gemacht hat.

Stigler: Wie wichtig, glauben Sie denn, sind solche ständigen Überprüfungen der Algorithmen, die wir verwenden?

Wachter: Jede Entscheidung, die traditionell von einem Menschen getroffen wurde, wird oder kann von einem Algorithmus getroffen werden. In den nächsten zehn, 15 Jahren werden wir immer mehr automatisierte Entscheidungsfindung sehen, bei denen wir immer weniger verstehen, warum und weshalb ein Algorithmus etwas macht. Und deswegen ist es extrem wichtig, gleich von Anfang an Mechanismen einzubauen, die uns verstehen lassen, was der Algorithmus macht und ob das unfair für bestimmte Personengruppen ist.

Äußerungen unserer Gesprächspartner geben deren eigene Auffassungen wieder. Der Deutschlandfunk macht sich Äußerungen seiner Gesprächspartner in Interviews und Diskussionen nicht zu eigen.