Das Ausschließen von Personen oder Gruppen aus sozialen Netzwerken wird auch "Deplatforming" genannt. Die großen Online-Plattformen sperren nicht erst seit kurzem Accounts, die gegen ihre Richtlinien verstoßen – in den vergangenen zwei Monaten passierte das aber gehäuft.

Nach Twitter hat im Juli 2020 auch Youtube die Konten der rechtsextremen "Identitären Bewegung" gesperrt, darunter das Konto des Mitbegründers der "Identitären Bewegung" in Österreich, Martin Sellner. Bei Youtube hatte Sellner zuletzt rund 100.000 Abonnierende, auf Twitter folgten ihm knapp 40.000 Nutzerinnen und Nutzer.

Schon im Juni hatte Youtube rund 25.000 Kanäle wegen Hassrede gesperrt, darunter die des amerikanischen Neo-Nazis Richard Spencer und des kanadischen Rechtsradikalen Stefan Molyneux. Die Video-Plattform sperrte den "Identitären"-Chef Sellner zudem nicht zum ersten Mal: Bereits 2019 verlor er wegen Verletzungen gegen die Community-Guidelines nach und nach Social-Media-Kanäle, wurde aber später wieder freigeschaltet. Zuvor hatte Youtube ein härteres Vorgehen gegen Hate Speech angekündigt.

Youtube und Twitter sind mit ihren Konten-Sperrungen bei weitem nicht die ersten, die Mitglieder der "Identitären Bewegung" verbannen. Facebook und Instagram hatten dies beispielsweise schon 2018 getan. Ende Juni 2020 sperrte Facebook nach Informationen der "New York Times" zudem hunderte Gruppen und Accounts der vom Konzern als "gewalttätig" und "gefährlich" eingestuften und als rechtsextrem geltenden amerikanischen "Boogaloo"-Bewegung.

Auch die Plattform Reddit, die lange als weitgehend unreguliert galt, ging Ende Juni 2020 verstärkt gegen "regelbrechende Inhalte" vor. Der Konzern entfernte zahlreiche Unterforen, sogenannte Sub-Reddits, von Fans des US-Präsidenten Donald Trump, die Reddit als diskriminierend eingestuft hatte. Die Streaming-Plattform und Amazon-Tochter Twitch hatte Ende Juni 2020 bereits den Account von Trump selbst wegen "hassschürenden Verhaltens" gelöscht, wie "heise" berichtete.

Twitter erklärte, die jüngst gesperrten Konten der "Identitären Bewegung" hätten gegen die Richtlinien des Kurznachrichtendienstes verstoßen – unter anderem im Bezug auf gewalttätigen Extremismus. Außerdem seien die Inhaber der Konten an "illegalen Aktivitäten" beteiligt gewesen. Sie hätten sich auf Twitter terroristischen Organisationen oder gewalttätigen Extremisten angeschlossen oder diese gefördert.

Youtube begründet die Sperrungen rechtsextremer Accounts ebenfalls mit ihren Richtlinien gegen Hassrede, die die Plattform im vergangenen Jahr verschärft hatte. Man schließe jeden Kanal, der "wiederholt oder ungeheuerlich" gegen die Richtlinien verstoße, so ein Youtube-Sprecher bei "The Daily Beast".

Nachdem die Richtlinien aktualisiert worden seien, um besser auf rassistische Inhalte eingehen zu können, habe es einen fünffachen Anstieg bei der Entfernung von Videos gegeben.

Auch Reddit hatte seine Richtlinien im Juni 2020 angepasst, sodass Communities und Nutzer, die "Hass auf Grundlage von Identität" verbreiten, gesperrt werden können. Zuvor hatte der "Social News Aggregator" eigentlich eine andere Strategie verfolgt – lange wurden kaum Inhalte bei Reddit gelöscht.

Dass Reddit nun über 2.000 Gruppen gesperrt habe, sei einerseits mit wirtschaftlichen Abwägungen verbunden: Man wolle mit anstößigen Inhalten Anzeigenkunden nicht verprellen, so Korrespondent Marcus Schuler im Dlf. Andererseits sei es zu einer Einsicht gekommen: "Viel Schwachsinn wollten die Plattformbetreiber einfach nicht mehr akzeptieren". Neben rassistischen und rechtsextremistischen Äußerungen hätten auch sich schnell verbreitende Falschinformationen zum Coronavirus den Ausschlag gegeben, "die Notbremse" zu ziehen.

Die Stategie des "Deplatforming" ist umstritten. Während einige die Meinungsfreiheit bedroht sehen, zweifeln andere an der Wirksamkeit, denn: Wer von einer Plattform ausgeschlossen wird, sucht sich womöglich alternative Portale.

Nach Ansicht der Journalistin und Rechtsextremismus-Expertin Karolin Schwarz funktioniert das "Deplatforming" noch nicht besonders gut. So habe "Identitären"-Chef Sellner, nachdem er schon 2019 bei Youtube gesperrt wurde und dann wieder entsperrt wurde, im Nachhinein noch mehr Reichweite bekommen.

Zudem gebe es Hinweise darauf, dass "Deplatforming" auch dazu führt, "dass man eben in geschlossene Räume abwandert und dort zwar weniger neue Leute für sich gewinnt, aber gleichzeitig auch nochmal eine Radikalisierung stattfindet", so Schwarz bei Deutschlandfunk Kultur.

Diese mit dem "Deplatforming" eingehende Gefahr sieht auch der Extremismusforscher Jakob Guhl. In geschlossenen Räumen könnten sich Radikalisierungsprozesse beschleunigen und eine gewaltsame Radikalisierung sei hier wahrscheinlicher, sagte Guhl im Deutschlandfunk.

Die Kontensperrung der "Identitären Bewegung" bei Twitter und anderen großen Online-Plattformen sei trotzdem ein "erheblicher Einschnitt" für die Gruppe. Auf alternativen Plattformen erreiche sie deutlich weniger Menschen und könne ihr Ziel der gesellschaftlichen Diskursverschiebung hin zum Rechtsextremismus schwerer erreichen.

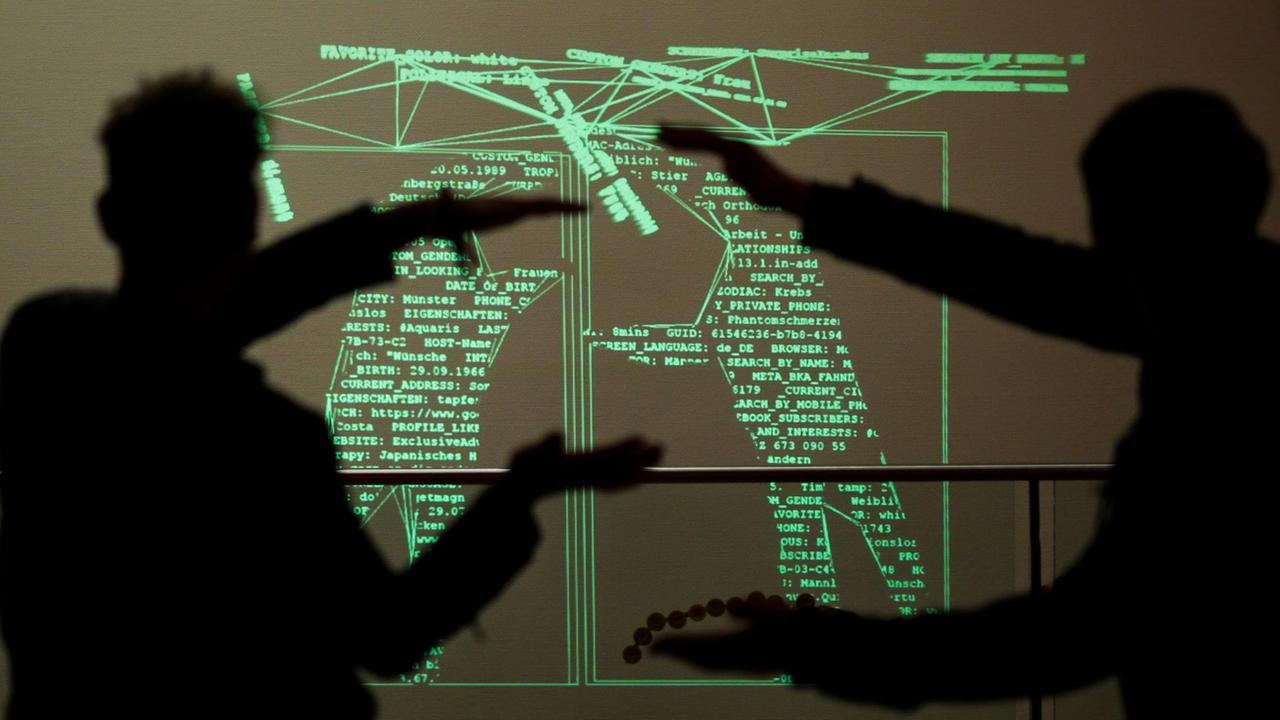

Die Extremismusforscherin Julia Ebner, die wie Guhl in London am Institute for Strategic Dialogue (ISD) Hass und Radikalisierung im Internet untersucht, sieht ebenfalls einen positiven Effekt beim "Deplatforming". Sie verweist darauf, dass der Prozess der Radikalisierung immer klar und schrittweise ablaufe. Personen könnten über den Konsum toxischer Posts und Kampagnen im Netz über einen längeren Zeitraum in extreme Gruppen hineingezogen werden.

Um diese Prozesse zu durchbrechen, brauche es einen vielschichtigen Lösungsansatz, sagte Ebner bei Deutschlandfunk Nova. Längerfristig müsse an den Algorithmen und den Geschäftsmodellen der Tech-Plattformen gearbeitet werden, die verschwörerische und gewalttätige Inhalte priorisieren würden, so Ebner.

Auch der Kulturwissenschaftler Christian Huberts sieht hier eine "große Herausforderung der Branche und ihrer Plattformen", denn die Rechtsextremen würden vor allen Dingen von un- oder schlecht moderierten Plattformen profitieren, sagte Huberts im Deutschlandfunk. So seien Community-Regeln zwar oft vorhanden – diese würden aber nicht konsequent durchgesetzt: "Das ermöglicht eben Rechtsextremen, dort ihre Rhetorik zu streuen und damit eben auch ihre Ideologie, ihre Sprache, langsam zu normalisieren."

Wenn große Online-Plattformen Rechtsextremisten rausschmeißen, suchen diese sich nach Ansicht der ExpertInnen neue, alternative Räume. Immer wieder genannt werden in diesem Zusammenhang 4chan, 8chan oder QAnon, sogenannte Imageboards, also Foren, in denen anonym Bilder und Texte ausgetauscht werden können.

Daneben seien auch Spiele-Communities für Rechte ein "wunderbares Ökosystem, um sich dort zu bewegen und nicht aufzufallen", sagte Kulturwissenschaftler Christian Huberts im Dlf. Dies beziehe sich jedoch dezidiert nicht auf die gesamte Gaming-Szene, sondern auf spezielle Gaming-Subkulturen, die sich beispielsweise auf Gaming-Plattformen wie Steam vernetzen würden.

Huberts: "Die Rhetorik, die dort herrscht in den Communities, in den Foren, in den Diskussionen innerhalb der Spiele, bereits eh schon quasi durchzogen ist vom vermeintlich satirischen, humoristischen Zitieren von NS-Rhetorik, von NS-Symbolen, von rechtsradikalen Verschwörungstheorien, aber eben immer unter dem Vorwand, das sei doch nur Spaß. Wir machen das hier nur für Lacher."

Auch Plattformen wie Discord, die ursprünglich für Computerspieler geschaffen wurdene, mittlerweile aber auch darüber hinaus genutzt werden, seien problematisch, so Journalistin Karolin Schwarz.

Daneben seien es vor allem verschlüsselte Messengerdienste wie Threema oder Telegram, die in den letzten Jahren von Rechtsextremisten "wahnsinnig viel genutzt worden" seien.