Wahlkämpfe sind Zeiten werbender Worte und großer Verheißungen. Immer schon. Kandidaten und Parteien buhlen um die Gunst der Wähler, heuern Strategen und Spin-Doktoren an, die ihre Stärken vergolden und ihre Schwächen verstecken. Wie hier, im September 1984, US-Präsident Ronald Reagan:

"Die Inflationsrate hat sich halbiert in den letzten vier Jahren, jetzt können Sie wieder mit Zuversicht in die Zukunft schauen. Der Morgen bricht wieder an in Amerika. Und unter der Führung von Präsident Reagan ist unser Land stolzer und stärker und besser."

Der Werbespot sicherte seine Wiederwahl. Auch gezielte Werbung ist nicht neu. Präsidentschaftsanwärter Barack Obama setzte soziale Medien wie Facebook schon 2008 erfolgreich ein. Inzwischen aber lernen die Maschinen schneller, die Algorithmen sind raffinierter, die Datenbestände über jeden einzelnen noch gigantischer. Niemand nutzt sie entschlossener als das Team Trump. Auch zwischen den Wahlen. Marcel Schliebs, Forscher im "Computational Propaganda Team" am Internet Institute der Oxford University:

"Während des Trump-Impeachments hat die Trump Campaign allein 14.000 verschiedene Wahlwerbeslogans und -bilder in der Facebook Ad-Library, die öffentlich einsehbar ist, geschaltet, die ganz verschiedene Schichten der Bevölkerung, Altersschichten, Geschlechter et cetera mit verschiedenen Botschaften getargetet hat. Das klassische Beispiel wäre, dass die Mutter, die gerade ein Kind bekommen hat, ein Wahlwerbebild auf Facebook angezeigt bekommt über irgendeine Statistik, dass Migranten, zum Beispiel aus Mexiko, ein Kind entführt haben oder gewalttätig geworden sind. Dass der Waffenliebhaber aus Texas gleichzeitig aber die Wahlwerbung bekommt, dass Hillary Clinton ihm die Waffen wegnehmen will."

Die Trump-Leute, meint Schliebs, verstünden es vor allem, Verhaltensdaten zu nutzen: "Das bedeutet: Wie reagieren Menschen auf verschiedene Slogans und wie führen Variationen dazu, dass sie erfolgreicher oder weniger erfolgreich sind? Die Brexit-Campaign hat das im Übrigen sehr ähnlich gemacht."

Politische Botschaften werden perfekt kalibriert

Spezialfirmen mit technischem und wissenschaftlichem Knowhow helfen den Wahlkampfstrategen dabei, ihre Botschaften immer perfekter zu kalibrieren, vorzugsweise über die sogenannten sozialen Medien. "Wir haben Chancen genutzt, die die andere Seite wohl nicht genutzt hat."

Nach dem Wahlsieg 2016 ließ sich Brad Parscale, ein Hüne mit Wikinger-Bart, im US-Fernsehen feiern. Die Daten, berichtete Parcale, bis vor kurzem Trumps Digital-Guru, hätten den Wahlkampf diktiert: Spendensammlungen, Werbeausgaben, Reiserouten, die Themen der Reden. An manchen Tagen habe man auf Facebook bis zu 100.000 Varianten eines Posts durchgespielt, fleißig Worte und Farben ausprobiert. Mit Helfern von Facebook, die extra für Trumps Wahlkampfzentrale abgestellt waren.

"Wenn ich 100 Millionen Dollar für eine Plattform ausgebe, die größte Summe jemals, macht es wohl Sinn, wenn deren Leute auch da sind, um sicherzustellen, dass wir das Geld richtig ausgeben. Und die alles richtig machen."

Parscales Bilanz: Twitter ist das Sprachrohr, Facebook die Autobahn auf der Trump zum Sieg fährt. Er operiert mit Unmengen von Daten über jeden einzelnen Bürger. Sie stammen von den Social-Media-Giganten, von Werbefirmen, aus Wählerregistern und anderen Datensammlungen.

"Sie geben das in eine Maschine ein und beginnen zu lernen, wie Menschen in verschiedenen Gegenden reagieren. Das wird dann personalisiert. Diese "Hard-IDs", diese harten Identitäten werden mit Telefonnummern, E-Mail-Adressen und allem abgeglichen. Wenn all diese Teile zusammengefügt sind, haben Sie ihr Publikum. Sie können sagen: Ich möchte in diesem Teil von Ohio jeden finden, der glaubt, dass die Mauer gebaut werden muss."

Auf Knopfdruck. Als Tabelle, die über Facebooks Schnittstellen eingefüttert wird. Parscale: "Facebooks Job ist es dann, all dies zusammenzukratzen und übereinander zu legen. Dann haben Sie auf Ihrem Computer eine kleine Schaltfläche: "Dieses Publikum". Die benutzen sie für all Ihre Werbung."

"Microtargeting" auf der Basis eines psychologischen Modells

Alexander Nix, CEO von Cambridge Analytica, tritt 2016 auf die riesige Bühne des "Concordia-Gipfels" in New York. Ein Stelldichein für Politik und Business.

"Meine Damen und Herren, verehrte Kollegen. Es ist mir eine Ehre, heute zu ihnen über die Macht der Daten und der Psychografie bei Wahlen zu sprechen."

Nix spricht von einer globalen Revolution. Seine Firma betreibe eine gewaltige Datenbank, in der 4- bis 5.000 Datenpunkte über jeden erwachsenen US-Amerikaner abrufbar seien: Alter, Geschlecht, Wohnort, Lebensstil, Einstellung.

"Welches Auto Sie fahren, welche Produkte Sie kaufen, welche Zeitschriften Sie lesen, welchem Golfclub sie angehören, in welche Kirche sie gehen. Und natürlich Persönlichkeits- und Verhaltensdaten."

Er präsentiert sich als Rockstar des Microtargeting: "Heute müssen wir nicht mehr raten, welche kreative Lösung wohl funktionieren könnte. Wir können Hunderte, Tausende individuelle Datenpunkte für unsere Zielgruppen nutzen, um genau zu verstehen, welche Nachrichten welche Zielgruppen ansprechen werden, bevor der kreative Prozess beginnt."

Anfangs hatten die sozialen Medien als neue Speerspitze der Freiheit gegolten, als Plattformen, auf denen Milliarden Menschen in die Welt hinaustreten und sich Oppositionsbewegungen gegen Diktatoren formen. Heute stehen sie unter Verdacht, zahlenden Kunden dabei zu helfen, absolute Herrschaft über Millionen Köpfe zu erlangen. Kritiker sprechen von "kognitivem Hacking": Digitale Gehirnwäsche, auf riesige, in Echtzeit aktualisierte Datenschätze gestützt und von künstlicher Intelligenz befeuert.

Grundlage dieser speziellen Volkspsychologie ist ein Fünf-Faktoren-Modell der Persönlichkeitsforschung, im Englischen oft mit dem Akronym OCEAN bezeichnet. Als "Big Five" gelten, auf Deutsch, die Persönlichkeitsdimensionen Offenheit, Gewissenhaftigkeit, Extraversion, Verträglichkeit und Neurotizismus.

Wissenschaftliche Erkenntnisse mit großer Brisanz

In den Proceedings of the National Academy of Sciences of the United States of America war im Frühjahr 2013 ein Aufsatz erschienen, Titel: "Private Merkmale und Attribute sind aus digitalen Aufzeichnungen menschlichen Verhaltens vorhersagbar."

Die Autoren: Michal Kosinski, Forscher am Psychometrics Centre der University of Cambridge sowie zwei Kollegen von Microsoft Research.

"Diese Studie zeigt, inwieweit relativ einfache digitale Aufzeichnungen menschlichen Verhaltens verwendet werden können, um eine breite Palette persönlicher Attribute, die Menschen üblicherweise als privat betrachten, automatisch und genau abzuschätzen."

Die Autoren hatten entdeckt, dass einige Facebook-Likes reichen, um viele, teils sehr intime Persönlichkeitsmerkmale vorherzusagen, von Intelligenz bis Drogenkonsum, von der politischen Einstellung bis zur sexuellen Orientierung. Ihr Werkzeug: das OCEAN-Modell. Ihr Material: Persönlichkeitsprofile und Facebook-Daten von 180.000 Usern. Die Brisanz war den Wissenschaftlern durchaus bewusst. Sie warnten vor "erheblichen negativen Auswirkungen", sollten sich – Zitat – "kommerzielle Unternehmen, Regierungsinstitutionen oder auch Facebook-Freunde" solcher Methoden bedienen:

"Man kann sich Situationen vorstellen, in denen solche Vorhersagen, selbst wenn sie falsch sind, das Wohlbefinden, die Freiheit oder sogar das Leben eines Menschen gefährden könnten."

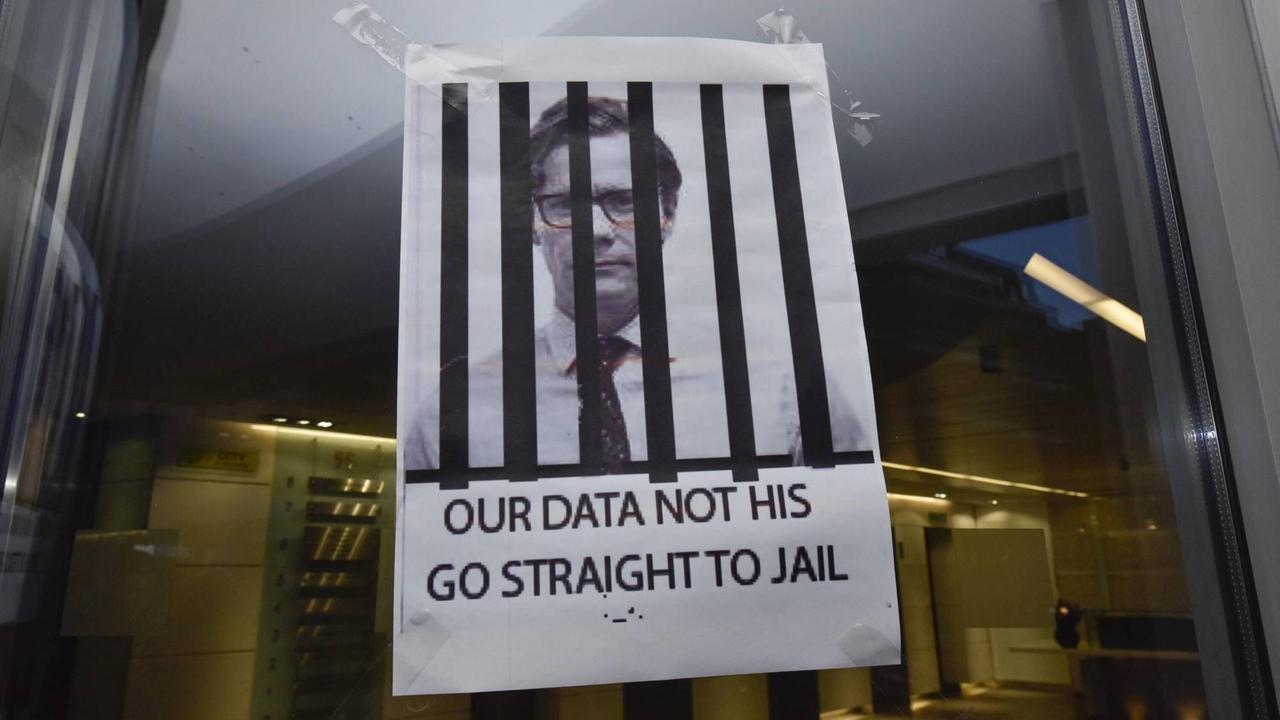

Datenskandal bei Cambridge Analytica

Kurz darauf unterschrieb Alexander Nix einen Vertrag mit Aleksandr Kogan, damals Psychologie-Dozent der Cambridge University. Kogan hatte über eine Facebook-App namens "This is your digital life" Persönlichkeitsdaten gehortet. Insgesamt sollen etwa 87 Millionen Facebook-User betroffen gewesen sein. Die Daten wurden an die Strategic Communications Laboratories, kurz SCL, verkauft, die Mutterfirma von Cambridge Analytica. SCL, 1990 gegründet, hat nach eigenen Angaben auf mehr als 100 Wahlen in über 30 Ländern Einfluss genommen, von Argentinien bis zu den Philippinen. Gründer Nigel Oakes, ein Mann aus der Werbung, beschrieb seine Methode in frühen Jahren so: "Wir verwenden die gleichen Techniken wie Aristoteles und Hitler. Wir sprechen Menschen auf der emotionalen Ebene an, um sie zu Übereinstimmung auf funktionaler Ebene zu bewegen."

Einem Fernsehsender erklärte Kogan später, alles sei "supernormal" gewesen.

Als die Verstrickungen 2018 ruchbar wurden, gingen Cambridge Analytica und SCL bald in Konkurs. Christopher Wylie, ein ehemaliger Mitarbeiter, trat als Whistleblower auf, beleuchtete viele Zusammenhänge, auch Verbindungen Kogans nach Russland: "Cambridge Analytica ist der Kanarienvogel im Kohlenbergwerk. Wir müssen uns die digitalen Echokammern vornehmen, die genutzt werden, um mit Algorithmen die amerikanische Gesellschaft zu spalten.

Sind Social-Media-Plattformen für Inhalte verantwortlich?

Hightech-Giganten wie Facebook und Google geben Millionen aus, um in Washington mehr Einfluss zu nehmen. Sie kämpfen um ihre Geschäftsbasis, die Daten von Milliarden Menschen – ihr Produkt. Sie fürchten mehr politische Aufsicht, womöglich eine Zerschlagung.

Besonders Facebook-Chef Mark Zuckerberg steht unter Feuer. Er hat gut vernetzte Republikaner als Lobbyisten angeheuert. Er dinierte sogar mit Donald Trump im Weißen Haus.

Im US-Kongress mussten sich Zuckerberg und Kollegen vorhalten lassen, dass ihre Algorithmen alles andere als transparent sind; dass sie die Verantwortung für die von ihnen transportierten Botschaften scheuen und dass ausländische Trolle und Agenten über ihre Plattformen Einfluss auf den US-Wahlkampf nehmen. Vor kurzem ist aber auch deutlich geworden, mit welch enormem Aufwand die Trump-Kampagne schwarze Wählen ins Visier nahm, um sie via Facebook von einer Stimmabgabe für die Demokraten abzuhalten.

Auch firmenintern steht der Facebook-Gründer zunehmend in der Kritik. Tausende Angestellte artikulierten Anfang August die Sorge, die Dienste des Konzerns – dazu zählen auch WhatsApp und Instagram – könnten dazu missbraucht werden, das Ergebnis der Präsidentschaftswahl im November in Zweifel zu ziehen. Inzwischen markieren Plattformen mitunter Falschnachrichten. Doch viele Untersuchungen zeigen: Die Desinformation wächst weiter, nicht nur in den USA. Eine ehemalige Datenwissenschaftlern von Facebook schrieb:

"Ich weiß, dass ich Blut an den Händen habe."

Sie listete etliche Fälle auf – von Aserbaidschan bis Bolivien, in denen Parteien und Regierungschefs via Facebook versucht hatten, Falschinformationen zu verbreiten, Oppositionelle zu bedrohen und die Öffentlichkeit in die Irre zu führen.

Nachweis von "nicht-authentischen" Accounts ist mühsam

Solche "nicht-authentischen Aktivitäten", wie die Fachleute sagen, deuten auf bezahlte Trolle und andere Formen computerisierter Propaganda aus dem In- und Ausland hin – ein wachsendes Problem für alle sozialen Netze. Zahllose Versuche, durch Falschinformationen, verdrehte Narrative und Stimmungsmache auf politische Einstellungen und das Wahlverhalten einzuwirken, sind gut dokumentiert. Etwa die der berühmt-berüchtigten "Internet Forschungsagentur" in St. Petersburg. Die Arbeit im Detail aber, verrät Oxford-Forscher Marcel Schliebs, ist äußerst mühsam.

"Zum einen sind das zum Beispiel Eigenschaften von Accounts, die Inhalte verbreiten. Also wie viele Follower hat einen Account? Wann wurde er erstellt? Aber auch die unmittelbare Umgebung und Topologie der Netzwerke, in der die sich bewegen. Da gibt es zwischen verschiedenen Akteuren große Unterschiede. Russische Akteure sind bekannt dafür, über Jahre hinweg Profile aufwendigst kultiviert zu haben, große organische Reichweite damit erzeugen zu können. Zum Beispiel über Jahre hinweg Facebook- oder Twitter-Accounts zu komplett unpolitischen Themen tweeten lassen oder posten lassen. Und dann irgendwann, wenn sie gebraucht werden oder in den Einsatz gerufen werden, anfangen, politisch zu werden. In den letzten Monaten sehen wir zum Beispiel auf der anderen Seite China, die im Kontext von Hongkong oder um den Corona-Virus herum wohl sehr schnell Kapazitäten aufbauen wollten, was dazu geführt hat, dass China in letzter Zeit vor allem auf sehr primitive Accounts zurückgreift, die auf Twitter fast alle null oder einen Follower haben und selbst sehr wenigen Leuten folgen."

Diese Pseudo-Amerikaner made in China bewegen sich oft hart am Klischee, so Schliebs:

"Die folgen fast immer Donald Trump, manchmal noch Bill Gates, Lady Gaga, Katy Perry und der NASA zum Beispiel."

Wie wirksam ist Trollerei und Propaganda tatsächlich?

Noch schwerer fällt es Wissenschaftlern zu beurteilen, welche Wirkung all diese Täuschungsmanöver beim Publikum tatsächlich entfalten. Weitere Hürde: Die Daten sind meist im Besitz von Konzernen oder Geheimdiensten, die oft wenig Begeisterung für unabhängige Forschung zeigen. Und dann gibt es noch ein ethisches Dilemma:

"Wenn wir das perfekte Forschungsdesign bauen wollen würden, das dieses Problem untersucht – in gewisser Weise so eine Art Goldstandard-Experiment – müssten wir ein perfektes randomisierten Experiment aufsetzen, wo ein zufällig ausgewählter Teil der Bevölkerung irgendeine Falschinformation, zum Beispiel auf deren Facebook-Account, angezeigt bekommt, wir dann, mal im amerikanischen Kontext, deren Facebook-Account mit ihrem ‚Voter Registration File‘ matchen und dann anschließend schauen, ob wir quasi ihre Wahlentscheidung durch die Falschinformation beeinflussen konnten. Wenn wir jetzt aber, was ich gerade gesagt habe, Revue passieren lassen, merken wir, dass wir damit quasi jede rechtliche und auch ethische rote Linie, die wir als verantwortungsvolle Wissenschaftler haben, natürlich damit überschritten haben."

Sozusagen Methoden à la Cambridge Analytica, diesmal für einen guten Zweck? Undenkbar.

Renée DiResta, Forschungsleiterin am Stanford Internet Observatory, sagt: Jede erfolgreiche ausländische Intervention setzt an vorhandenen Brüchen und Problemen der Zielgesellschaft an:

"Letztlich wird es das Ziel sein, das Vertrauen in die Legitimität der Wahlen zu untergraben. Bei Informationsoperationen muss man beachten: Diese Figuren und ihr Material finden Anklang, weil sie an vorhandenen gesellschaftlichen Spaltungen ansetzen, an legitimem Unmut, am geringen Vertrauen in Institutionen und Regierung."

"Social Bots" - lässt sich Desinformation automatisieren?

Die Frage, die viele nervös macht: In welchem Ausmaß wird sich Desinformation in Zukunft automatisieren lassen? Könnte verbesserte künstliche Intelligenz bald wirklich clevere, lernfähige Bots schaffen, die sich dann zudem rasant selbst vermehren? Bislang werden Fake-Identitäten oft zusammengepfuscht, aus Namenslisten, geklauten Fotos und minimalsten Lebensläufen. Marcel Schliebs sagt: Das Problem wird zugleich über- und unterschätzt.

"Ich glaube, dass menschlich betriebene, manuell betriebene Accounts und automatisierte, algorithmisierte Accounts, die wir auch oft als Bots bezeichnen, meist in einem Synergieverhältnis stehen."

Einerseits sind Bots bislang selten in der Lage, wirklich kreativ zu agieren. Andererseits wird ihre schiere Masse unterschätzt.

"Jüngstes Beispiel: ein Fall aus China, wo Twitter insgesamt 23.000 Accounts gelöscht hat, die regelmäßig chinesische Staatspropaganda zu Themen wie dem Coronavirus, aber auch Hongkong und anderen Themen von geopolitischer Relevanz für China verbreitet haben. Das aber hinter diesem Netzwerk von 23.000 gefälschten Accounts noch Hunderttausende automatisierte Accounts standen, deren Rolle einzig und allein war, diese von Menschen kreierten Inhalte weiter zu verbreiten und zum Beispiel zu retweeten."

Facebook schätzt, dass etwa fünf Prozent seiner knapp drei Milliarden aktiven Nutzer nicht echt sind. Obwohl der Konzern jedes Jahr Milliarden von Fake-Konten abschaltet. Inzwischen übernimmt ein Maschinenlern-System namens "Deep entity classification" die Löschung. Im März 2020 hieß es, das System habe just 6,6 Milliarden Konten abgeschaltet.

Vertrauen in verlässliche Information wird gezielt zerstört

Kate Starbird, Forscherin an der University of Washington, hielt im Oktober 2019 in Stanford einen Vortrag, Titel: "Jenseits von Bots und Trollen":

"Desinformation verringert unsere Fähigkeit zu erkennen, was oder wem wir noch vertrauen sollen. Wer nicht mehr weiß, wo verlässliche Informationen zu finden sind, läuft Gefahr, seine Handlungsfähigkeit zu verlieren. Wir wissen nicht, was wir tun sollen, weil wir nicht mehr sicher sind, was los ist. Und verlieren so unsere Fähigkeit, Entscheidungen zu treffen, die auf einer Kenntnis der Welt beruhen, wenn wir unserem Wissen über diese Welt nicht mehr vertrauen. Desinformation ist also nicht einfach falsche Information. Manchmal ist sie überhaupt nicht falsch. Um effektiv zu sein, schichten solche Informationen Wahrheit auf Lügen, oft mit einem wahren oder plausiblen Kern. Sie fügen neue Details hinzu und lassen andere weg, um eine ganz bestimmte Erzählung für ein genau bestimmtes strategisches Ziel zu formen."

Starbird und KollegInnen waren zufällig auf das Thema gestoßen. Eigentlich hatten sie das Framing in der Debatte um Polizeigewalt und "Black Lives Matter" erforscht. Doch kaum war ihre Studie im Oktober 2017 fertig geworden, veröffentlichte Twitter eine Liste mit Accounts der Trollfabrik in St. Petersburg – über 3.000 Konten, die rund drei Millionen englischsprachige Tweets verschickt hatten. Starbird klickte die Liste an. Und erkannte etliche Akteure wieder. Das Team machte sich sofort an die Arbeit, und entdeckte, dass Trolle versucht hatten, sowohl Aktivisten von Black Lives Matter als auch deren oft rassistische Gegner anzufeuern. Wie Puppenspieler. Das Team fing an, die Tweetberge inhaltlich zu analysieren:

"Ich kann diese Art Arbeit nicht unbedingt empfehlen. Ich habe Jahre gebraucht, fühle mich nun endlich erholt. Nach einem Sabbatical habe ich damit abgeschlossen. Aber es war wirklich desorientierend."

"Ökosystem" der Desinformation entfaltet Eigendynamik

Viele im Team, berichtet sie, waren verstört, wie geschickt es den Trollen gelungen war, durch eine Mixtur aus Fakten, Halbwahrheiten, Übertreibungen und gezielten Lügen beide Seiten der Debatte zu infiltrieren und zu instrumentalisieren. Wie viele Forscher spricht auch Starbird von einem "Ökosystem" der Desinformation, wo verschiedenste Akteure zusammenwirken:

"Das war also nicht orchestriert. Das geschah organisch, wurde nur manchmal, wenn es nützlich schien, von russischen und anderen Outlets strategisch kultiviert und verstärkt. Doch die schufen nicht die Verschwörungstheorien. Die Aktivitäten mögen lose mit staatlicher Desinformation verknüpft gewesen sein. Was hier passiert: Menschen in diesen Online-Communities sind jetzt derart eingebettet in diese Art von Lehren oder Denkweisen über die Welt, dass sie, wenn sie neue Informationen bekommen, neue Ereignisse sehen, sofort beginnen, diese in ihre Leitideen einzubauen. Sie erzeugen für jedes neue Ereignis eine neue Theorie, die auf diesen Thematiken basiert, und nehmen das Ereignis als weiteren Beleg für diese großartige Verschwörung mächtiger Leute, die alles manipulieren. In deren Auftrag auch die Mainstream-Medien lügen."

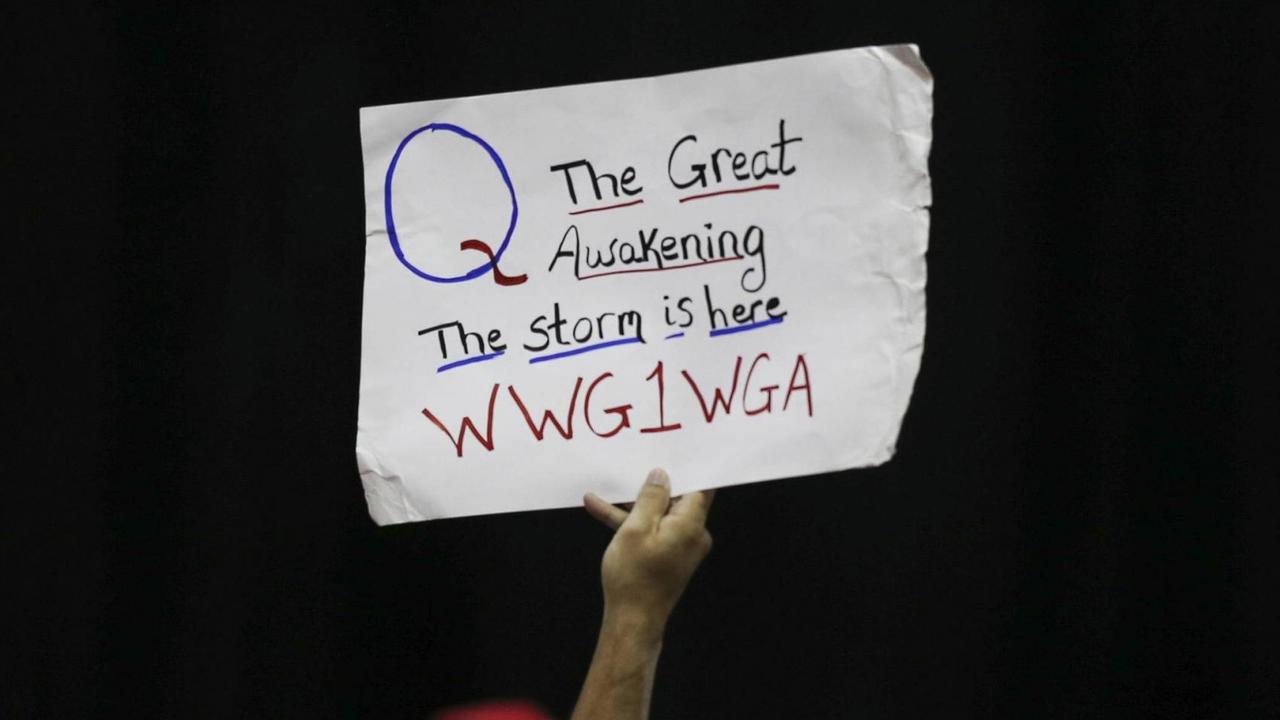

Fast wie ein Perpetuum mobile. Manche dieser ständig neu generierten Verschwörungsmuster werden aufgegriffen von "Online-Influencern", von etablierten Medien und politischen Akteuren. Selbst krudeste Erzählungen wie die von QAnon machen so über Jahre Karriere. QAnon soll ein anonymer Retter im Washingtoner Apparat sein, der Trump hilft, den endgültigen Sieg gegen den "tiefen Staat" und die Pädophilen-Ringe der Demokraten zu erringen. Wir sind alle verwundbar, sagt Kate Starbird.

Politische Werbung im Netz regulieren wie in TV und Presse?

Letztlich, heißt es jetzt in engagierten Appellen von Wissenschaftlern, gehe es um das Überleben der Demokratie im digitalen Zeitalter. Die MIT-Forscher Sinan Aral und Dean Eckles etwa forderten in einem Artikel in "Science" mehr Forschung zur Rettung der Demokratie. Die Ausrichtung, salopp gesagt: Weniger Erbsen zählen, mehr auf Auswirkungen und Gegenstrategien schauen.

"Ein wissenschaftliches Verständnis der Auswirkungen der Manipulation in sozialen Medien auf Wahlen zu erlangen, ist eine wichtige Bürgerpflicht. Ohne dieses bleiben Demokratien verwundbar. Je früher wir eine öffentliche Diskussion über die Abwägung von Privatsphäre, Redefreiheit und Demokratie beginnen, desto eher können wir einen Weg nach vorne erkennen."

So wird, auch aus der Wissenschaft, die Forderung immer lauter, die neuen sozialen Medien zu regulieren. Der Vordenker Jaron Lanier nennt sie bereits "Massenverhaltensveränderungsmaschinen."

Nina Jankowicz, Fellow am Woodrow Wilson International Center for Scholars fordert eine neue Verkehrsordnung für diese Medien: "Wir müssen wirklich ein paar Stoßstangen auf diese Kegelbahn setzen, bevor die Dinge zu sehr außer Kontrolle geraten."

Facebook und Co, sagt die Forscherin, werden sich niemals selbst kontrollieren. Das sei Aufgabe von Gesellschaft und Staat: "Wir verlieren tatsächlich den Informationskrieg, wenn wir diesen Weg der Politisierung des gesunden Menschenverstandes weitergehen."

Ein Anfang wäre es, die Verbreiter politischer Werbung im Internet den gleichen Standards zu unterwerfen wie Radio, Fernsehen und Print. Im US-Parlament liegen Gesetzentwürfe dazu vor. Aber sie sind bislang eben nur – Entwürfe.

"Falschbehauptungen von Trump wirkungsvoller als alle Trolle"

Andere Wissenschaftler betrachten vor allem die korrosiven Effekte der Radikalisierung: Den völligen Vertrauensverlust in Politik, Medien, Demokratie. Die Lügen der Elite, meint Brendan Nyhan, Professor of Public Policy an der University of Michigan, seien wirkungsvoller als alle Trolle.

"Wer sich um Falschinformationen sorgt, sollte sich vor allem Sorgen um die machen, die von unseren politischen Eliten kommen und weit mehr Menschen erreichen. Der Präsident der Vereinigten Staaten hat seit seinem Amtsantritt mehr als 9.000 falsche Behauptungen aufgestellt. Keiner ist in den Medien der Welt präsenter als er. Die Exposition durch Falschbehauptungen des Präsidenten der USA ist also um Größenordnungen höher."

Zuletzt hat die Corona-Epidemie einen Tsunami von Falschinformationen über Herkunft und Verbreitung des Virus, über Gegenmaßnahmen und Impfstoffe erzeugt. Der neue Begriff: "Infodemie". Viele Experten fürchten, dass sich Gerüchte und Falschmeldungen in Krisensituationen weit schneller verbreiten als Fakten; und demokratische Gesellschaften allmählich die gemeinsame Basis aus Empirie und Beobachtung und den sie tragenden Grundkonsens einbüßen.

Einige Forscher versuchen, die rechten Diskursnetzwerke in den USA, in denen sich vor allem Konservative, Libertäre, christliche Fundamentalisten und weiße Nationalisten bewegen, präziser in den Blick zu nehmen. Die Wechselbeziehungen sind komplex, die Übergänge fließend, die Kanäle immer zahlreicher. Permanent entsteht neue "Mikroprominenz", die mitunter auf enorme Reichweiten kommt.

Social-Media-Algorithmen "belohnen" extreme Botschaften

Guillaume Chaslot hat früher bei Youtube gearbeitet, der Videoplattform von Google, auf die in jeder Minute 400 Stunden neuer "Content" hochgeladen werden. Und täglich eine Milliarde Stunden Material konsumiert werden:

"Ich glaube, den meisten Leuten ist nicht klar, wie mächtig KI – künstliche Intelligenz – bereits heute ist. Wir glauben, das ist eine Sache der Zukunft, vielleicht in einem Roboter. Tatsächlich gibt es KI längst überall um uns herum. Auf Youtube etwa werden über 70 Prozent all der Dinge, die angeschaut werden, von KI empfohlen. Auf Facebook haben wir KI auf mehreren Ebenen. Eine zum Beispiel kuratiert unsere Timeline. Sie zeigt uns nicht alles, was unseren Freunden so gefällt. Sie wählt aus."

Entscheidend dabei: die "Engagement metrics". Die "Zuschauerzeit" auf Youtube, die Verweildauer, Shares und Likes auf Facebook. Die Kundschaft soll emotional eingenommen, an den Monitor gefesselt werden. Und möglichst viele Werbebotschaften sehen. Das Extreme wird belohnt.

"Das hat Nebenwirkungen. Eine Sekte zum Beispiel ist per Definition einnehmend. Menschen in einer Sekte beschäftigen sich viel mit ihrem Führer. Das ist das perfekte Modell für Facebook. Facebook ist so konzipiert, dass es Sekten stets bevorzugen wird – weil die wirklich gut darin sind, Menschen einzubinden. Wir sehen, wie gut Verschwörungstheorien wie QAnon, die Sekten in vielerlei Hinsicht ähnlich sind, auf Facebook funktionieren. Weil sie Leute fesseln, viele Shares, Likes und Weiterleitungen erzeugen. Auch wenn sie mit der Realität nichts zu tun haben."

2016 berichtete das Wall Street Journal über Facebook-interne Untersuchungen, denen zufolge sich fast zwei Drittel der Nutzer auf Facebook extremistischen Gruppen angeschlossen hatten, nachdem ihnen diese vom hauseigenen Algorithmus empfohlen worden waren.

"64 Prozent aller Beitritte zu extremistischen Gruppen geschahen aufgrund unserer Empfehlungs-Tools."

Guillaume Chaslot: "Ich glaube nicht, dass diese Unternehmen Demokratie als einen Wert betrachten, als etwas Wichtiges. Sie machen sehr kleine Schritte, um sie zu schützen. Facebook etwa kündigt an, in der letzten Woche vor der Wahl keine neue politische Werbung mehr zu zeigen. Das sieht nach einem sehr, sehr kleinen Schritt zum Schutz der Demokratie aus."

Sind die Algorithmen heute besser?

"Das grundlegende Problem ist nicht die Raffinesse des Algorithmus, sondern die Frage: Wofür ist er optimiert? Ein sehr grundlegender Algorithmus, der beispielsweise auf Demokratie optimiert wurde, würde viel mehr für die Demokratie tun als ein sehr komplexer Algorithmus, der auf User-Beteiligung optimiert ist."

US-Wahlkämpfer setzen auf eigene Kampagnen-Apps

Inzwischen suchen sich US-Wahlkämpfer von den großen Datenkonzernen zu emanzipieren. Etwa mit Kampagnen-Apps wie "Trump 2020". Die App verlangt vom Nutzer: Name, Telefonnummer, E-Mailadresse, Postleitzahl. Und generiert bei der Nutzung ständig neue, für die Strategen interessante Daten. Erneut scheint es vor allem darum zu gehen, möglichst viel über die User und ihre Kontakte zu erfahren. Und ihnen möglichst wirkungsvolle, auf sie zugeschnittene Botschaften zu schicken. Die App von Joe Biden dagegen, "Team Joe" gibt sich deutlich weniger datenhungrig. Die Trump-App, urteilt die Zeitschrift "Technology Review", "hat eine viel längere Liste von Zugriffsanforderungen. Sie möchte Ihre Kontakte lesen und verlangt die Berechtigung, Ihren Standort zu erfahren, den Status und die Identität Ihres Telefons zu lesen, sich mit Bluetooth-Geräten zu koppeln und mögliche SD-Karten im Gerät zu lesen, zu beschreiben oder zu löschen."

Immer häufiger, berichtet "Technology Review", würden Versuche beobachtet, Menschen über Bluetooth-Sender, versteckt etwa in Vorgarten-Plakaten oder an Kirchen zu orten. Der neue Fachbegriff: "Geo-Propaganda".

Für ihren "Kulturkrieg", ihren oft religiös aufgeladenen Endkampf um die Macht in den USA, scheint der Trump-Kampagne – auch technisch – jedes Mittel legitim. Immer wieder betonen ihre Multiplikatoren, dass es im November um wirklich Alles gehe, um Gott oder Teufel, Ruhm oder Untergang, Größe oder Sozialismus, Wahrheit oder Lüge.

Unlängst malte der republikanische Youtuber Charles Kirk seinen Anhängern die Folgen einer Trump-Niederlage aus. Eine Art Weltuntergangsvision: Trump würde eingesperrt, die Kirchen geschlossen, die Konten blockiert. Alle aufrechten Republikaner wären Freiwild.

"Wenn wir verlieren, wenn der Präsident verliert, werden sie uns alle holen kommen. Sie werden Eure Kinder holen, sie werden überall auftauchen."

Wahlcomputer sind extrem anfällig für Manipulationen

Und dann gibt es da noch ein Problem, das über all die Software gern vergessen wird: Die Hardware der US-Wahlbüros.

"Ich glaube nicht, dass ich jemals auf ein Problem gestoßen bin, das schwieriger ist als die Sicherheit und Integrität von Wahlen."

Im August, auf der Konferenz BlackHat, einem Stelldichein von Computer-Sicherheitsexperten in Las Vegas, diesmal online, zog Professor Matt Blaze, Professor an der Georgetown University, eine vernichtende Bilanz: In den knapp 178.000 Wahlbüros der USA stünden höchst unterschiedliche Gerätschaften – für die Registrierung, die Abstimmung, für das Zählen und Übermitteln der Ergebnisse. Es gebe, sagt Blaze, "enorme Angriffsflächen".

"Was sie alle gemeinsam haben: Unser Vertrauen in das Wahlergebnis hängt zunehmend von unserem Vertrauen in die Integrität der Mechanismen ab, die wir dafür verwenden."

Zumal die Wahlergebnisse mitunter extrem knapp ausfallen. 2016 lag Donald Trumps Vorsprung vor Hillary Clinton in den Bundesstaaten Michigan, Pennsylvania und Wisconsin zwischen 0,23 und 0,77 Prozent. Als besonders tückisch gelten Wahlcomputer, an denen die Bürger per Touchscreen ihre Stimme abgeben. Viele seien veraltet, anfällig für Bugs, Hacks und Viren.

Auf der US-Hackerkonferenz DefCon, gleich nebenan, werden Wahl-Computer in einem "Voting Village" alle Jahre wieder einem Stresstest unterzogen. Bislang, berichtet Blaze, wurde noch jedes Gerät geknackt.

"Die Leute, die Geld ausgeben, um darauf Einfluss zu nehmen, wie Sie wählen, haben sehr viel mehr Ressourcen als jene, die versuchen, sicherzustellen, dass alles reibungslos läuft, dass wirklich jeder die Möglichkeit hat zu wählen und dass die Stimmen richtig gezählt werden."

Schlussfolgerung von Blaze: Computer können helfen. Aber die Stimmabgabe muss auf Papier erfolgen. Die Urne ist das Beste. Bei einer Umfrage auf der BlackHat-Konferenz meinten mehr als zwei Drittel der Teilnehmer, das jede Form elektronischer Abstimmung riskant sei. Nur Desinformation, fanden 71 Prozent, sei noch gefährlicher.