"Es wäre besser, es hätte das Patent nicht gegeben."

"Da gab's nur die Eins."

"Ich kenne gar keine fremden Algorithmen."

"The tempo of the music."

"Die Welle, die über die Membran drüber läuft."

"Where is the first beat?"

"Da gab's nur die Eins."

"Ich kenne gar keine fremden Algorithmen."

"The tempo of the music."

"Die Welle, die über die Membran drüber läuft."

"Where is the first beat?"

App: TC 11

Ich habe meinen Tablet-Computer auf dem Schoß und lege zwei Finger auf den Bildschirm. Unter ihnen zwei orangefarbene Kreise, die anfangen zu wachsen. Jetzt lege ich einen weiteren Finger dazu, und jetzt wische und trommle ich mit allen Fingern über den Bildschirm. Und schüttle das Gerät. Diese App kostet rund 25 Euro und bietet das, was sich die Musikinformatik-Institute und Experimentalmusiker schon seit Jahrzehnten wünschen: interaktives Musikmachen.

App: Gitarre

Und das eine Konzertgitarre. Schön auf dem Bildschirm abgebildet, und das Witzige ist: Wenn ich mit den Fingern darüber streife, klingt sie nicht nur: Die Saiten fangen an zu schwingen, wie bei einer sehr tief gestimmten Gitarre.

App: Sounddrop

Hier tropft etwas: kleine Punkte auf dem Smartphone-Bildschirm, die von oben nach unten strömen. Der Witz an dieser kostenlosen App ist, dass ich den Tropfen mit den Fingern Hindernisse in den Weg stelle, dünne Balken, und siehe da: Sie werden davon abgestoßen, reflektiert, und erzeugen dabei andere Töne. Die seriellen Komponisten vor 100 Jahren in Paris hätten nicht aufgehört, damit ihre Muster zu entwickeln.

App: Sequencer

Smartphones haben Mikrofoneingänge und Kopfhörerausgänge. Es ist also naheliegend, dem Musiker für unterwegs eine Kompositions-App an die Hand zu geben. Und wenn er nur in einem stillen Eckchen am Flughafen einen Rhythmus rein singt und, frisch gelandet mit einem Freund gezupfte Streicher draufsetzt, und zusätzliche Gesangsspuren, wenn es sein muss. Früher hätte man dazu ein Studio gebraucht, 250 Dollar pro Stunde. Der Song lässt sich exportieren und am PC weiterverarbeiten.

App: Traktor DJ

DJs lieben Apps, mit denen man zwei Musiktitel ineinander überblenden kann, ohne dass der Takt springt. Es gibt viele solche Apps. Bei manchen sieht man zwei Plattenspieler auf dem Bildschirm, bei anderen zwei Musikspuren mit den Audio-Wellen. Ich lege auf die eine Spur eine sehr alte Aufnahme eines von Busoni auf Klavier umgeschriebenen Bachchorals. Auf der anderen bereite ich Beyoncés Hit "Drunk in Love" mit einem großen Hall vor. Hier ist sie. Jetzt gebe ich beide Spuren frei, und der Spaß beginnt. Zwei Spuren, zwei Hände, und einigermaßen synchron. Die Tonarten beißen sich, was fast natürlich ist und was ich mit dieser App nicht ändern kann. Aber ich habe auch zwei Titel ausgewählt, die mir das Programm nicht vorgeschlagen hat. Noch ein paar Scratches am Ende.

Algorithmen suchen passende Musik

In glücklichen Fällen gelingen Überlagerungen von zwei Musikquellen sehr verschiedener Art auch melodisch perfekt. Wir fangen mit Jazz an und setzen jetzt taktgenau Drum & Bass-Rhythmen dazu. Und nun grooven sogar die Bässe gut zusammen, der Kontrabass der Jazz-Band und der elektronische Subbass. Das Herausfiltern von Musiken, sodass sie zusammenpassen, ist ein neues Forschungsfeld. Es kam nur dadurch auf, dass der Disc Jockey heute nicht mehr 40 Schallplatten auf die Bühne mitbringt, sondern die Musikbibliothek in seinem Notebook-Computer, mit meist Tausenden von Musiktiteln. Da geeignete Paare herauszufinden, die sich gut überblenden lassen, erfordert neue Analysemethoden für Musik. Die Wissenschaft hat einen Namen: Music Information Retrieval, abgekürzt MIR.

"Hallo, ich bin Mickael Le Goff, Teamleader der MIR-Themen, Musik Information Retrieval, bei Native Instruments."

Mickael Le Goff kommt aus Frankreich und lebt seit langem in Berlin. Er betrachtet MIR als "Rückwärtsprogrammieren" von Musik. Der Komponist kennt ja die Akkorde, die er komponiert, die Musiker kennen die Töne, die sie auf den Instrumenten spielen, der Schlagzeuger das Tempo. All diese Informationen liegen in einem fertigen Musikstück aber verschränkt vor, sodass man als Konsument prüfen muss: Ist das jetzt ein Wechsel von g-Moll auf D-Dur auf der Gitarre, oder macht das der Bass? Aus dem fertigen Musikmaterial also zurückrechnen, woraus es eigentlich besteht, das ist Music Retrieval. Dabei kommen ähnliche Rechentechniken (Algorithmen) zum Einsatz wie bei der Spracherkennung. Wenn wir ins Smartphone sprechen: "Wie viele Menschen leben in Stuttgart?", erkennt die Software ja unsere Stimme, interpretiert den Sinn der Frage und antwortet:

"Die Bevölkerung von Stuttgart beträgt ungefähr 587.700."

Mickael Le Goff sagt, dass jeder Musikstil einen eigenen Algorithmus zur Analyse braucht. Einen zum Erkennen von Pop-Musik, einen für Hip Hop. Wofür gibt es noch keinen Algorithmus (außer für Strawinsky)? Dafür: Drum & Bass. Finden wir hier mal die Eins? Ist sie da ... oder da ... 1-2-3-4.

Le Goff: "Drum & Bass-Musik ist ein anderes Extrem, weil hier das Tempo so hoch ist, 160, 180 Beats pro Minute, sodass sich die Töne überlappen und wir sie kaum voneinander trennen können. Das Signal ist so dicht, dass wir auch hier einen anderen Algorithmus verwenden müssen, um damit einigermaßen klar zu kommen. Eins unserer schwierigsten Themen ist, die 1 zu erkennen, also den Taktbeginn. Bei einem typischen Techno-Stück im 4/4-Takt taucht die Basstrommel viermal pro Takt auf. Wo ist der Taktanfang, wo ist die Eins?"

Max Schönherr: "Ich kann es Dir sagen!"

Le Goff: "Du kannst es mir sagen, weil Du die Musik verstehst und Dein Gehirn eine vielschichtige Analyse betreibt. Wenn ich Dir aber einen sehr kurzen Musikbrocken gebe, wirst Du die Eins nicht finden. Man kann so einen Brocken alle acht Takte loopen, also wiederholen, es klingt immer okay, egal wo man die einsetzt. Unser Hirn fängt dann, wenn es mit der Basstrommel nicht weiterkommt, an, nach anderen Mustern zu suchen, nach Akkordwechseln, nach Stimmungswechseln in der Musik, wenn der Gesang einsetzt usw. Häufig passiert etwas Neues auf der Eins."

Schönherr: "Oder mit dem Auftakt."

Le Goff: "Der Auftakt macht uns auch Schwierigkeiten! Hier müssen wir uns den gesamten Verlauf des Stücks ansehen und auf Wiederholungen achten. Zum Glück besteht Musik in der Regel aus vielen Wiederholungen. Während andere Elemente häufig immer wiederkehren, tut es der Auftakt nicht so oft."

Maschinen lernen wie Menschen zu hören

Die Berliner Firma Native Instruments lässt sich bei der Musikanalyse stark von dem leiten, was wir Menschen hören. Der Computer soll so hören, wie wir Menschen hören. Man nennt das Maschinelles Lernen. Die Grenzen liegen da, wo wir bei einem Stück nicht unterscheiden können, was Strophe und was Refrain ist; wie soll es dann eine Software verstehen? Wir werden später von einem Münchner Programmierer erfahren, wie er ohne Maschinelles Lernen auskommt, um in einem fertigen Musikstück den Rhythmus, die Tonart und die 1 zu finden.

"Ich bin Egbert Jürgens, arbeite bei der Forschungsabteilung von Native Instruments, leite diese Abteilung."

Auch er sucht die 1 in fertigen Songs, ihn interessiert aber mindestens so stark das Erzeugen neuer Klänge mit Methoden der Informatik. Als Königsdisziplin gilt da seit langem das Physical Modelling, deutsch: das Simulieren von Instrumenten mit physikalischen Methoden.

So klang eine "Flöte", 1980er Jahre, auf die Synthesizerbesitzer vor 30 Jahren stolz waren. Später wurden Flöten gesampelt, also von realen Flötenspielern aufgenommen und dann auf Klaviertasten gelegt. Wegen des relativ einfachen Aufbaus der Luftsäulen in länglichen, ungekrümmten Blasinstrumenten kann man Flötenklänge aber mit heutigen PCs rein rechnerisch mit Überlagerung von Sinusschwingungen erzeugen. Und sogar so tun, als würde man die Luftsäule mit einem Geigenbogen an-streichen und so zum Schwingen zu bringen.

Wir hören das physikalische Modell einer gestrichenen Flöte.

Ich spiele diesen Klang mit einem an den PC angeschlossenen Midi-Keyboard, und so beeindruckend er klingt, die Software mogelt. Wenn man den ganzen Hall wegnimmt, bleibt wenig Überzeugendes übrig. Das physikalische Modell ist zu dürftig. Dabei wären heute Computer schnell genug, um auch komplexe Simulationen in Echtzeit zu berechnen. Warum also gibt es von Seiten einer Musiksoftware-Firma keine überzeugenden Angebote?

Frequenzen werden modelliert

Egbert Jürgens: "Das physikalische Modellieren ist leider ziemlich zum Stillstand gekommen, weil es auf dem Gebiet Patente gibt. Diese Patente laufen jetzt langsam aus. Aber sie haben die letzten 20 Jahre die Entwicklung in dem Bereich der 'Waveguides', wie es sich nennt, blockiert. Das ist eine Art Resonator, in den man Energie hineinsteckt, diese wird dann reflektiert und erzeugt dadurch eine Schwingung. Mit diesen Resonatoren können Sie die verschiedensten Instrumente nachbauen. Sie können damit sogar eine Saite modellieren, aber auch alle Blasinstrumente. Sie können sogar flächige Strukturen damit abbilden. Es ist trotzdem ein sehr einfaches Verfahren. Sie brauchen dazu nur wenige Zeilen Code. Es erscheint einem ziemlich trivial. Vor 20 Jahren war es nicht ganz so trivial. Trotzdem würde ich sagen, es wäre besser, es hätte das Patent nicht gegeben."

In den nächsten fünf bis zehn Jahren laufen diese Patente aus. So lange geht Egbert Jürgens einen anderen Weg, der, sagen wir mal, Zwischenlösungen anbietet.

Jürgens: "Was wir jetzt machen, ist modale Synthese. Damit simulieren wir die Phänomene, die man bekommt, wenn man beispielsweise auf die Membran einer Trommel mit einem Stock haut. Man nimmt nicht direkt eine Gleichung, die beschreibt: Ich habe einen Körper von den und den Ausmaßen und damit die Welle, die über diese Membran drüber läuft, sondern ich gehe eine Ebene höher und beschreibe die Phänomene, die auftauchen. Wenn ich auf eine Membran bestimmter Größe draufhaue, bekomme ich 'Moden', in denen diese Membran schwingt. Und jedes dieser Bewegungsmuster der Membran erzeugt bestimmte Frequenzen. Wir modellieren jetzt diese Eigenfrequenzen der Membran."

"Modalsynthese: Diese Idee kommt eigentlich aus der Aeronautik-Industrie und auch von Leuten, die Brücken bauen und so weiter",

sagt in dieser international besetzten Industrie ein Kollege von Egbert Jürgens in Berlin, nämlich:

"Francisco Garcia. Ich bin ein DSP-Softwareentwickler bei Native Instruments."

DSP, das ist der Überbegriff für digitale Klangverarbeitung, Digital Signal Processing.

Bisher ist die Modalsynthese bei einigen Trommeln gelungen, bei der Basstrommel und der Snaredrum zum Beispiel.

Bisher ist die Modalsynthese bei einigen Trommeln gelungen, bei der Basstrommel und der Snaredrum zum Beispiel.

Hier das Modell einer Snaredrum, also der Trommel, die der echte Schlagzeuger normalerweise direkt zwischen seinen Beinen hat. Diese Snare haben Egbert Jürgens und Francisco Garcia programmiert, sie basiert also nicht auf einem Sample, auf einem real aufgenommenen Klang. Die Snare ist komplett digital erzeugt. Und sie klingt gut.

Ich spiele die Trommel über einen so genannten Controller, das ist ein an den Computer angeschlossenes Gerät mit druckempfindlichen Tastenflächen. Schlage ich mit dem Finger kräftiger darauf, setzt die Mathematik ein und macht die Trommel nicht nur lauter, sondern verändert auch ihr Frequenzspektrum. Mit einem Drehregler kann ich die die Trommel umstimmen und so tun, als würde ich sie an verschiedenen Stellen anschlagen. Die Unterschiede sind nur minimal zu hören, aber sie sind zu hören, und wenn es in der digitalen Musikproduktion eine Währung gibt, dann ist es die Exklusivität eines Klangs.

Ob die Musiker diesen Aufwand spüren – vermutlich nicht. Sie spüren aber sehr wohl, wenn etwas gut klingt. Es gibt ein Software-Instrument, das dem Team von Jürgens und Garcia mehr Aufwand bereitet hat als diese Trommeln jetzt: der digitale Nachbau des berühmtesten Synthesizers aller Zeiten, des Mini Moog. Der Mini Moog war in den 1980er Jahren extrem beliebt, nicht zuletzt wegen seiner klanglichen Unreinheiten. Die Musiker wissen die Software-Version eines Analog-Synthis zu schätzen.

Egbert Jürgens: "Die Entwicklung war sehr schwierig und sehr aufwendig. Das ist Elektronik, und in der Elektronik passieren sehr viele Dinge, die man nicht erwarten würde."

Max Schönherr: "Denkt man nicht!"

Jürgens: "Denkt man nicht, weil man ja denkt: Das sind Transistoren, Widerstände, die sind hintereinander geschaltet. Und wenn man sich die anguckt, weiß man, was passiert. In der Wirklichkeit fließen dann Ströme in die falsche Richtung, und Dinge, die linear sein sollten, sind es nicht. Und Widerstände sind dann doch ein bisschen auch Kondensatoren, und solche Dinge."

Die Simulation eines Analogsynthesizers fordert ganz andere Algorithmen als die Modalsynthese für Trommeln und das physikalische Modellieren völlig neuer Instrumente. Wollen die Musiker überhaupt völlig neue Instrumente?

Jürgens: "Es ist generell so, dass sich Musiker häufig kleine Änderungen von dem wünschen, was sie kennen."

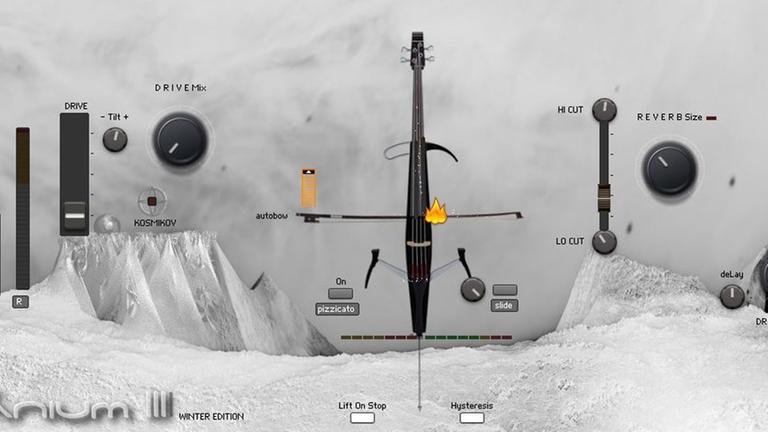

Problemfeld Hall

Zum Beispiel wünschen sie sich einen besseren Hall. Dieser Hall beruht auf Mathematik. Er hat eine lange Fahne, er klingt also sehr langsam aus, wie in einer großer Kirche oder einem großen Saal. Ihm liegt ein seit vielen Jahren bekannter Algorithmus zugrunde; er ist sehr flexibel, ich kann die Hallfahne verkürzen, den Raum vergrößern. All das geht in der Wirklichkeit nicht. Und es stimmt auch nicht ganz. Der digitale Hall klingt immer ein wenig steril, weil er so sauber ist und weil er nicht die Defekte eines realen Raums berücksichtigt, und auch nicht, wo der Zuhörer in diesem Raum sitzt und wo in dem Raum der Klang erzeugt wird, vorn oder hinten links. Toningenieure der Vienna Symphonic Library messen seit Jahren Konzerthallen in Wien akustisch aus und haben daraus eine Hall-Software entwickelt, die nun jeder Musiker benutzen kann. Eine ausgezeichnete Alternative zum Digitalhall. Er nennt sich Faltungshall.

Nehmen wir eine Violine. Auch sie wurde von den Wienern aufgenommen, ich spiele sie auf meiner Midi-Tastatur. Trocken, ohne Hall. Jetzt begebe ich mich – virtuell – ins Konzerthaus und dort in den vor gut zehn Jahren gebauten Neuen Saal. Er heißt so: Neuer Saal. Ich positioniere am Bildschirm die Violine auf der Bühne, und wohin setze ich mich? Ich setze mich mal in die siebte Reihe, direkt rechts am Mittelgang – und blicke nach vorn. Das alles stelle ich mit der Maus ein. So klingt die Violine, wenn sich sie über die Tasten spiele:

Ich kann auch ins Foyer rausgehen und die Violine auf einer der Treppen zu mir rüber spielen lassen:

Nun kenne ich das Foyer des Konzerthauses nicht und habe die Programmierer gefragt, warum es so stark hallt? Ob sie da etwas falsch berechnet haben? Aber nein, das Foyer ist reich mit Marmor getäfelt! Für den Faltungshall realer Räume gibt es einen richtigen Markt. Immer mehr Software-Instrumente werden mit solchen Raummodellen ausgeliefert, die den digitalen Hall ergänzen.

Räume fürs Kino

"Ich bin Yvan Grabit, ich arbeite seit 1997 bei Steinberg."

Ich bin in Hamburg bei einer der ältesten Musiksoftwarefirmen überhaupt. Auch hier erforscht man Räume. Zum Beispiel den im Film.

Grabit: "Es ist beim Film jetzt nicht mehr so, dass man sagt: Ich mache eine Mischung für ein Kino mit 5.1 Surround, für ein Kino Stereo oder ein Kino mit 3D..."

... also Filme, die einen räumlichen Eindruck vermitteln. Bei der Herstellung dieser Filme per Computeranimation oder mit zwei Kameras ist von jedem Objekt in der Szene bekannt, wo es sich befindet. Nicht nur rechts/links/oben/unten, sondern auch, wie weit entfernt, wie tief im Raum drin. Diese räumlichen 3D-Bewegungsdaten bekommt der Komponist der Musik und der Geräusche-Macher – für die Sound Effects geliefert. Yvan Grabit meint, dass wir langsam an den Punkt kommen, wo nicht der Film den Ton vorgibt, sondern mit ihm spielt:

"Ich würde sagen, dass der Film der Zukunft anders gedreht wird, auch die Kameraperspektiven anders gemacht werden. Anderes Beispiel: Wir sind in einem Raum und hören jemanden eine Etage höher herumgehen. Was passiert jetzt? Alle Cineasten würden jetzt die Kamera nach oben bewegen, um zu zeigen: Es gibt ein Geräusch von oben. Mit 3D-Audio brauchen wir das nicht mehr zu machen. Die Kamera kann fest bleiben, wo sie ist, und nur durch die 3D-Lautsprecher wird die Attraktion des Zuhörers gelenkt: OK, es gibt etwas eine Etage höher."

Sequenzer verlangen starren Takt

Steinberg ist neben Emagic ein Pionier in Sachen Sequencing. Emagic wurde von Apple gekauft, dort heißt die Software Logic, bei Steinberg heißt sie Cubase. Sequenzer sind die Kern-Programme, mit denen man am Computer komponiert. Sie zeigen Audiowellen, wenn wir Gesang aufnehmen, und Midi-Balken, wenn wir über einen Controller Schlagzeug oder über ein Keyboard Orgel einspielen. Sie laufen immer von links nach rechts. Das ist die Zeitachse.

"Werner Kracht, Steinberg, seit 30 Jahren. Zuständig für Midi. Ist die 1 für den Hersteller eines Sequencing-Programms wichtig? Die ist ziemlich wichtig, angefangen in den 1980er/90er Jahren, da gab es nur die 1. Das ist ein ganz großes Problem gewesen, früher Musik mit einem Auftakt zu machen. Das sind Dinge, die aufgrund der Sequencing-Programme verloren gegangen sind. Der Auftakt, der normalerweise zur Musik gehört, oder auch verschiedene Tempowechsel, die sind durch die Art, wie die Sequencer aufgebaut waren, verloren gegangen, weil es sehr, sehr schwierig war, das abzubilden."

Der lautere Schlag, den mir der Sequenzer vorgibt, ist die 1, der davor ist der Auftakt zur 1. Wenn ich anfange, zu diesem Metronom-Takt etwas am Keyboard einzuspielen, werde ich mit der 1 anfangen, und alles, was ich anschließend spiele, muss in das Taktraster fallen. Man kann das Tempo variieren, aber es ist umständlich, und es macht kaum jemand. Was sich niemand traut, ist, etwas ganz ohne Metronom aufzunehmen; denn der Sequenzer funktioniert nur richtig gut mit einem Takt. Spielt man ohne Taktvorgabe ein, lässt sich der Takt nur mit viel Aufwand Schritt für Schritt, Note für Note nachträglich einzeichnen, und dann stimmt er immer noch nicht genau. Werner Kracht von Steinberg macht für diese Kultur der starren Rasterung den Erfolg der Loops mitverantwortlich. Loops sind Musikbausteine, die man beliebig hintereinander setzen kann, ohne dass man Sprünge hört.

Das ist ein Schlagzeug-Loop. Das geht auch mit Gitarren und anderen Klängen. Loops fangen immer mit der Eins an, und sie sind deswegen Loops, also wiederholbar, weil sie ein festes Tempo haben.

Es geht auch ohne

Ich hatte nicht damit gerechnet, aber dann fahre ich nach München zu einem der exotischsten und renommiertesten deutschen Musiksoftwareentwickler überhaupt, einem Quereinsteiger, einem Eigenbrötler mit lockigen grauen Haaren, und da passiert ein Wunder. Er zeigt mir, dass das mit der Taktung, der 1 und mit dem Auftakt alles kein Problem mehr ist und dass er die Musiker jetzt vom starren Metronom befreit!

Max Schönherr: "So, ich bin bei Peter Neubäcker, was hören wir gerade für ein Stück?

Peter Neubäcker: "Das ist das Stück Ponder von Chet Baker, ein reines Bläserstück ohne jegliche Percussion oder dergleichen. Ein Bläserquartett."

Schönherr: "Wir Menschen können uns die so genannte Eins, auch Downbeat genannt...

Neubäcker: "Ja, Downbeat..."

Schönherr: ... ganz gut vorstellen. Versuchen wir doch mal, den Takt mitzusummen, während wir hören."

Neubäcker: "Ja."

Schönherr: "1-2-3-4... so könnte es gehen, oder?"

Neubäcker: "Ja."

Schönherr: "Ein ziemlich schleppendes Stück, lass es ruhig noch ein bisschen laufen. 1-2-3-4, Eins – bist du einverstanden mit meiner 1?"

Neubäcker: "Ja."

Das Programm schlägt das Metronom nun exakt auf den Rhythmus.

Schönherr: "Das Programm hat den Rhythmus, den wir gerade improvisiert mit gesummt haben, schon analysiert. Das ging innerhalb von Sekunden. Der lautere Klick ist eben die 1, um die es geht. Wir haben hier Unterschiede zwischen 55 Beats pro Minute, jetzt 54, dann wieder 55, 52, und das als stetigen Wechsel. Es sind ja keine Brüche im Takt. "

Neubäcker: "Wenn natürliche Musiker spielen, oder alle Musik, die bis in die 1980er Jahre hinein gespielt wurde, dann hat man zwar ein Tempo im Sinn und hält sich an das Tempo, aber der eigentliche Tempoverlauf ist natürlich fließend. Und es ist erst mit den Sequenzern und den Drum Machines in den 80ern aufgekommen, dass man so ganz konstantes Tempo hat."

Schönherr: "Gut. Können wir einmal etwas ganz anderes, etwas noch Komplizierteres wählen? Den zweiten Satz der Sonate in cis-Moll von Beethoven, das ist die Mondscheinsonate, vielleicht."

Die Software hat den Rhythmus gefunden und spielt das Metronom dazu.

Schönherr: "Peter, ich muss sagen, das habt Ihr gut gemacht."

Neubäcker: "Ja. Alle spielen also zum Klick ein, niemand spielt gerne zum Klick ein, und die Musik wird dadurch relativ tot. Wenn man erkennt, wo jeder einzelne Schlag tatsächlich ist, dann kann man das Metronom sozusagen nachträglich generieren, und die Musiker können, wie sie es eigentlich wollen, frei einspielen. Also man spielt etwas vor sich hin, so wie man es dem Gefühl nach eben spielt, und dann kann man nachher im Aufnahmeprogramm genauso weiterarbeiten und andere Sachen dazu synchronisieren, wie man es gerne hätte."

Schönherr: "Und was braucht der Musiker in der Zukunft noch?"

Neubäcker: "Also, ich glaube, er hat eh schon zu viel."

Schon lange war es so nicht mehr so umtriebig in der Szene der Musiksoftwarentwickler. Peter Neubäcker befreit jetzt die Musiker von den Fesseln der festen Taktung, Yvan Grabit bringt 3D-Sound ins Kino, und wenn demnächst die Resonator-Patente endlich auslaufen, wird Egbert Jürgens endlich virtuelle Instrumente modellieren, die niemand von Hand bauen kann. Spannende Zeiten!