Das Erwachen der Maschinen - Siegeszug der Roboter - Bordcomputer übernehmen.

"Du hast gesagt, ich soll dich an die Medikamente erinnern. Es ist jetzt soweit. Und vielleicht möchtest du etwas trinken. Du kannst durch Drücken am Schirm oder Spracheingabe antworten."

"Maschinen werden zu Handlungspartnern, die mit einem eigenen Beitrag in das Handlungsgefüge von Menschen eingewoben werden. Und damit sich auch die Frage stellt: Wer entscheidet am Ende?"

(Arne Manzeschke)

(Arne Manzeschke)

"Damit, dass wir die Entscheidung abgeben, ist natürlich ein Stück weit auch die Übertragung von Verantwortung verbunden. Das ist eine gewisse Verantwortungsdiffusion. Möglicherweise in Teilbereichen sogar eine Verantwortungslücke, die dadurch entstehen kann."

(Susanne Beck)

(Susanne Beck)

"Wenn man Techniken baut, hat das Konsequenzen im Moment sofort für die Gesellschaft auch. Sich darüber Gedanken zu machen, was das für Konsequenzen sind, halte ich schon für wichtig. Was ich dabei für besonders wichtig halte, ist, dass man nicht von vornherein die Sorgenfalten auf der Stirn der Leute sieht, sondern dass man das auch mit einem gewissen Mut vielleicht betreibt."

(Alexander Pretschner)

(Alexander Pretschner)

Pflegeheim und Krankenhaus: Roboter bringen das Essen

"Brauchst du irgendeine Hilfe? Bleib ruhig. Möchtest du, dass ich Hilfe rufe

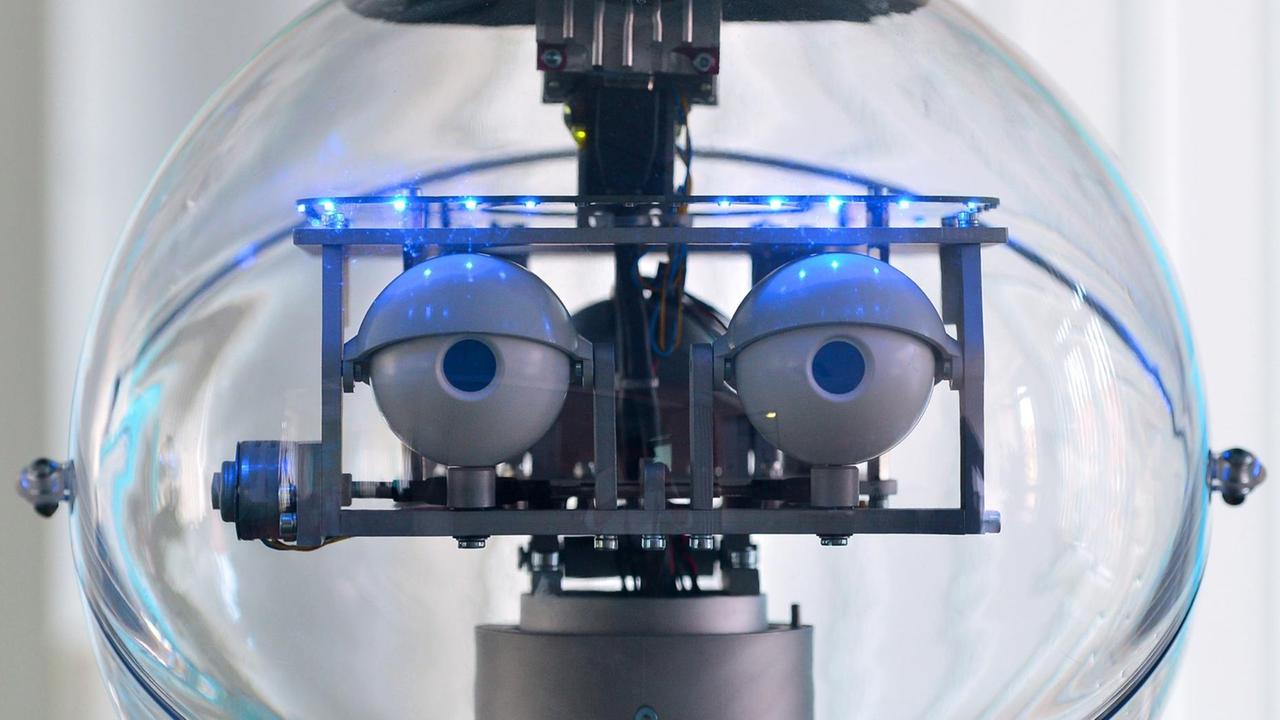

Wenn ältere Menschen im Alltag nicht mehr allein klarkommen, kann ein Roboter helfen. Die Maschine erinnert daran, dass man regelmäßig seine Tabletten nimmt, sie leitet Gymnastik-Übungen an und alarmiert - falls man stürzt - die Sanitäter.

"In den nächsten Jahrzehnten ist ein steigender Pflege- und Versorgungsbedarf in Deutschland zu erwarten. Gleichzeitig fehlen uns aber die personellen und finanziellen Ressourcen, um das wirklich zu stemmen. Von daher ist es wahrscheinlich sehr rational, mit entsprechender Technik die Probleme anzugehen und mindestens kompensierend weiter zu helfen."

Arne Manzeschke stellt sich täglich den Fragen zum richtigen Umgang mit Robotern in Heimen und Krankenhäusern. Der Theologie-Professor arbeitet im Fachbereich Ethik und Anthropologie an der Ludwig-Maximilians-Universität München sowie an der Evangelischen Hochschule Nürnberg. Pflegeroboter - das ist ein Thema für selbsternannte Heilsbringer genauso wie für Technikfeinde. Manzeschke jedoch sucht das Dazwischen.

"Welche Form von Technik liefert einen Beitrag zum guten Leben und welche trägt eher dazu bei, dass Technik die Zwischenmenschlichkeit stört, die Zuwendung unterläuft und die Kälte in der Gesellschaft vielleicht steigert."

Eigentlich klingt das vielversprechend: Ältere Menschen können länger zuhause wohnen bleiben, weil sie von Robotern unterstützt werden. Im Pflegeheim und im Krankenhaus bringen Roboter das Essen. Sie helfen bei der Therapie. Gehen mit den Menschen spazieren. Sagen ihnen, wie sie sich verhalten sollen, um möglichst lange zu leben.

Wer bestimmt wen?

"Wir kommen in diesem Bereich zu einem paradoxen Befund: Dass auf der einen Seite momentan viele technische Assistenzsysteme entworfen werden, die die Autonomie und die Teilhabe von Menschen stärken sollen. Wenn diese Maschinen aber so autonom arbeiten, tun sie Dinge, die unter Umständen dem Menschen in seiner Autonomie gar nicht helfen, sondern diese Autonomie gerade untergraben. Wenn ihnen Maschinen sagen: Du solltest dieses, du solltest jenes tun, und das solltest du gerade nicht tun. Und das ist der Punkt, wo wir fragen: Wer bestimmt hier eigentlich wen?"

Warum überhaupt diese Frage? Weil sich die Technik rasant weiter entwickelt. Weil unter manchen Ingenieuren die Euphorie in Sachen künstlicher Intelligenz kaum Grenzen kennt. Weil Konzerne wie Google, Amazon und Microsoft sich bei der Forschung zusammentun. Immerhin handelt es sich um einen riesigen Markt mit einem geschätzten Wert von weltweit knapp 20 Milliarden Euro und einem vorhergesagten jährlichen Wachstum von zehn Prozent.

Selbstfahrende Autos oder Drohnen: Unfällen vorbeugen

Weil Roboter heute Dinge können, die wir ihnen vor wenigen Jahren niemals zugetraut hätten. Es geht um automatisierte Pflege im Altenheim – und auch um andere Bereiche: Selbstfahrende Autos etwa oder Drohnen.

An der Technischen Universität München testet der Informatiker Alexander Pretschner solche Maschinen, die eigenständig agieren. Er ist Professor für Software Engineering.

"Vor zehn Jahren gab es die ersten autonomen Fahrzeuge bei der DARPA Grand Challenge, wo Fahrzeuge autonom durch die Wüste gefahren sind. Wenn Sie sich die Bilder davon angucken, sind auf dem platten Land Fahrzeuge umgefallen, weil das nicht so richtig funktioniert hat. Nur zehn, 15 Jahre später fahren die Autos durch Städte ganz allein."

Pretschner arbeitet an der TU München mit Unternehmen wie BMW, Google und Siemens zusammen. Unter anderem versucht der Informatiker herauszufinden, warum autonome Geräte Fehler machen. In seinem kleinen Labor stehen unter anderem ein Staubsauger-Roboter und eine Drohne, ausgerüstet mit sechs Propellern und einer Kamera.

"Es geht darum, dass diese Drohnen ja tatsächlich zunehmend unseren Luftraum bevölkern werden. Das Problem, das uns als Wissenschaftler interessiert, ist, dass wenn etwas in solchen Systemen schief geht, wie man im Nachhinein herausfinden kann, was eigentlich daran schief gegangen ist. Ist das ein Windproblem gewesen, ist das ein Hackerangriff gewesen, ist das ein Fehler des Operators gewesen und so weiter."

Pretschner versucht mit seinem Team, Unfällen vorzubeugen. Damit nicht so etwas passiert, wie vor einigen Monaten in Florida mit einem Tesla. Der Wagen war auf einem Highway in einen von der Seite kommenden Sattelschlepper gefahren - der Autofahrer starb. Laut Hersteller verwechselten die Sensoren des Tesla die weiße Seitenwand des LKW mit dem Himmel - sie übersahen ihn also schlicht. Ein tragischer Fall, bei dem der Fahrer zudem eine Mitschuld hatte. Denn bisher muss jeder, der ein solches Auto fährt, so gut aufpassen, dass er jederzeit das Steuer übernehmen kann.

Insgesamt betrachtet dürfte es mit dem Durchbruch autonomer Fahrzeuge künftig deutlich weniger Unfälle geben. Manche Experten sagen voraus: In einigen Jahrzehnten bis zu 90 Prozent weniger - das könnte jedes Jahr rund einer Million Menschen weltweit das Leben retten. Auch der Energieverbrauch und damit die Umweltbelastung könnten deutlich sinken. Insofern sieht der Münchner Informatiker Alexander Pretschner die Entwicklung autonomer Technik positiv.

"Ich bin da eigentlich eher optimistisch, weil das Ganze doch erstaunlich gut funktioniert. Es gibt Millionen von Kilometern, die gefahren werden ohne Schwierigkeiten. Nun gibt es aber natürlich auch Situationen, an die vorher keiner gedacht hat."

Wer macht den Schaden eines Roboters wieder gut?

Wenn eigenständig agierende Systeme unseren Alltag durchdringen, hat das Folgen. In punkto Sicherheit, Datenschutz, Abhängigkeit von der Industrie. In punkto Selbstbestimmung; mit Blick darauf, wie sich unser Leben verändert.

"Ich persönlich glaube, dass man schon überlegen muss, was man tut. Ich glaube schon auch insbesondere, dass Ingenieure die Verantwortung haben, darüber nachzudenken. In Deutschland gibt es tendenziell eine gewisse Vorsicht bei solchen Diskussionen und eine gewisse Aversion vielleicht gegen zu viel Mut, Neues auszuprobieren. "

Manche denken die Sache nicht vom Anfang, sondern vom Ende her: Inwieweit lässt sich eine einmal entwickelte Technologie aufhalten? Was heißt das für unsere Gesellschaft? Wie gehen wir damit um, dass uns die Maschinen in manchen Bereichen haushoch überlegen sind und immer komplexer werden? Wer verdient daran, wer trägt die Risiken? Ganz konkret: Wenn ein Roboter einen Schaden verursacht: Wer macht ihn wieder gut?

An der Universität Würzburg gibt es seit 2010 eine Forschungsstelle RobotRecht mit inzwischen 20 Doktoranden. Ihr Leiter Eric Hilgendorf ist Professor an der Juristischen Fakultät und hat zusätzlich einen Doktortitel in Philosophie.

"Nach meinem Eindruck sind die Anfragen an die Rechtswissenschaft und an die Ethik zurzeit intensiver als an die Technik. Technisch scheint schon sehr viel geklärt zu sein oder es ist Forschung, die einfach vorangeht. Im ethischen und im juristischen Bereich sind viele Fragen ganz neu und drängen sehr."

Exportschlager "Die deutsche Rechtsordnung"

Durch den Einsatz von Robotern sind ganz unterschiedliche Rechtsgebiete betroffen: Strafrecht, Versicherungsrecht, Patentrecht. Es geht um Datenschutz oder den Rechtsvergleich mit den USA, wo die großen Technologiekonzerne wie Google und Amazon sitzen. Weltweit beschäftigen sich bisher nur wenige Wissenschaftler mit Roboterrecht.

Insofern, sagt Eric Hilgendorf, habe Deutschland eine besondere, auch internationale Verantwortung.

"Die deutsche Rechtsordnung ist Exportschlager geworden, so dass zurzeit viele Länder genau hinschauen, was macht Deutschland in Bezug auf Haftung für autonome Systeme, wie regulieren wir die autonomen Fahrzeuge im Straßenverkehr."

Ein eigenes, ganz neues Rechtssystem für Roboter sei nicht nötig, sagt der Würzburger Jurist. Vielmehr gehe es darum, die bestehende Rechtsordnung weiter zu entwickeln und neu zu interpretieren. Etwa in punkto Verantwortung, wenn ein autonomes System einen Unfall verursacht und jemand verletzt wird. Zentral sei die so genannte Gefährdungshaftung. So haftet etwa der Halter eines PKW immer dann, wenn durch den Betrieb seines Autos Personen- oder Sachschäden entstehen - unabhängig von der Frage wer schuld ist. Verknüpft ist das mit dem System der Pflichtversicherung, die jeder Fahrzeughalter abschließen muss.

Gefährdungshaftung für Pflegeroboter

Etwas Ähnliches bräuchten wir für Pflegeroboter in Heimen, meint Eric Hilgendorf.

"Für humanoide Roboter, die alte Leute pflegen, die sie umbetten oder auch nur unterhalten, gibt’s so eine Gefährdungshaftung nicht. Und da stellt sich die Frage: Wer haftet, wenn ein solcher Roboter einen Fehler begeht und eine alte Person etwa hinfällt. Hier besteht die Gefahr, dass die Geschädigten auf ihren Schäden sitzen bleiben. Und da muss man nach versicherungsrechtlichen Lösungen fragen. Ich persönlich bin der Meinung, dass man für alle Roboter eines gewissen Komplexitätstyps über kurz oder lang eine Gefährdungshaftung einführen sollte."

Entsprechend müssten sich die Betreiber von Heimen und Krankenhäusern versichern, in denen Pflegeroboter zum Einsatz kommen.

Selbstfahrende Autos: Wie wird in Dilemma-Situationen entscheiden?

Ein anderes Beispiel aus dem Bereich selbstfahrender Autos: Was, wenn ein solcher Wagen in einen Unfall verwickelt wird und vor der Wahl steht, entweder ein Kind anzufahren oder eine Gruppe von fünf Senioren. Die klassische Dilemma-Situation. Wie ist nun der Algorithmus des selbstfahrenden Autos programmiert? Wird diejenige verschont, die jünger ist? Oder derjenige, der einen Fahrradhelm trägt? Frauen eher als Männer?

"Die Tötung ist auf jeden Fall rechtswidrig, egal wie der Wagen entscheidet. Jetzt kommt aber das Problem: Heißt das, dass beide Fälle gleich zu behandeln sind? Oder muss der Wagen im Rahmen der Rechtswidrigkeit eine Präferenz haben? Ich meine, wenn auf der einen Seite fünf Menschen ums Leben kommen können, auf der anderen Seite nur einer ums Leben kommen wird, ist es immer noch besser, dass ein Unschuldiger getötet wird als dass fünf Unschuldige getötet werden. Also ich würde hier dem Prinzip des kleineren Übels folgen. Das ist aber noch sehr offen."

"Recht-Ethik-Technik"-Kurse

Über solche und andere Fragen diskutiert seit kurzem eine Ethik-Kommission des Bundesverkehrsministeriums, der auch Jurist Hilgendorf angehört. Zusammen mit dem Präsidenten des ADAC, einem Weihbischof, Informatikern und Ingenieuren.

"Es gibt nach meinem Eindruck durchaus viele Ethiker, die sich in Technikfragen ganz gut eingearbeitet haben. Es gibt auch zunehmend Juristen, die das getan haben. Es gibt aber bislang erstaunlicherweise relativ wenig Ingenieure, die es für Wert befunden haben, sich mit normativen Fragen aus dem Recht oder aus der Ethik zu beschäftigen. Man sollte hier eigene Studiengänge konzipieren, zumindest Zusatzmodule. Es geht um eine gewisse Sensibilisierung für normative Fragestellungen und es geht um die Vermittlung von Grundwissen. Ich denke, das ist heute unverzichtbar."

Einen Verbündeten fand Hilgendorf in Alexander Pretschner, dem Informatikprofessor von der TU München. Gemeinsam verantworten sie den neuen Kurs 'Recht-Ethik-Technik' für Nachwuchs-Ingenieure.

"Natürlich ist mein Fokus die Technik. Wir haben aber, glaube ich, alle mittlerweile verstanden, dass die heutigen Herausforderungen zu groß sind, als dass sie von einer Disziplin betrachtet oder gelöst werden können. Wenn's jetzt nicht nur um Informatik für neue Maschinen oder Programme geht, sondern darum, dass sich die Gesellschaft verändert, muss man sich natürlich auch darüber Gedanken machen. Und selbstverständlich bin ich auf Juristen angewiesen, die mir erklären, wie bestimmte juristische Zusammenhänge sind. So genau wie die Juristen darauf angewiesen sind, dass wir ihnen grundlegende technische Dinge so portionieren, dass das für die Entscheidungsfindung dort hilfreich ist."

Tod durch Algorithmus – ohne Panik

Autonome Technik ist normativ betrachtet weder per se gut noch per se schlecht. Die Frage ist: Wo und wie wird sie eingesetzt? Besonders augenfällig wird das im Krieg - bei autonomen Waffen. Das ist keine Science Fiction, sondern Wirklichkeit: Langstreckenraketen, die sich selbst ihre Ziele suchen. Drohnen, die aus der Luft feindliche Stellungen identifizieren und eigenständig das Signal zum Angriff geben. Waffen, die automatisch Gesichter erkennen und dann losschlagen. Experten nennen das zugespitzt: Tod durch Algorithmus.

"Im Krieg gilt ein Verhältnismäßigkeitsgrundsatz. Kann eine Maschine tatsächlich entscheiden, was verhältnismäßiges Verhalten ist? Das traue ich Maschinen nicht wirklich zu."

Susanne Beck ist Professorin für Strafrecht und Rechtsphilosophie an der Universität Hannover. Sie fragt: Was wird aus der klassischen Idee von Verantwortung, wenn nicht mehr Menschen handeln, sondern Maschinen? Wer entscheidet im Falle autonomer Waffen über Leben und Tod?

"Möglicherweise könnte der normative Gewinn darin liegen, dass die Maschine keine Panik hat, sie hat nicht Angst um ihr eigenes Leben, sie hat auch keinen Adrenalinschub. Zugleich müssten wir so einer Maschine wirklich zutrauen, die Situation hundertprozentig richtig einzuschätzen. Das heißt zu erkennen, ob das Gegenüber vielleicht gerade dabei ist sich zu ergeben, wirklich sicher zu sein, dass das eben ein militärisches Gegenüber und kein Zivilist ist und dergleichen."

Befürworter argumentieren: Autonome Waffensysteme könnten Kriege berechenbarer und menschlicher machen. Ist es besser, wenn statt Soldaten Roboter in den Kampf geschickt werden?

Empathie lässt sich nicht programmieren

"Da gibt es Diskussionen, dass so eine maschinelle Entscheidung darüber, ob das Gegenüber getötet wird oder nicht, möglicherweise einen Verstoß gegen dessen Würde darstellt. Das finde ich überzeugend, weil keine Möglichkeit mehr einer Gnade, eines Erbarmens existiert. Und das finde ich in so einer Situation sehr problematisch."

Bewaffnete Roboter müssten ein Verständnis von Moral haben. Sie müssten empathisch agieren können, sagt Strafrechtlerin Susanne Beck.

"Zur Empathie brauchen wir ja, dass man dasselbe fühlen kann, was gerade das Gegenüber empfindet. Und das werden wir einer Maschine nie beibringen können. Auch die Moral einer Maschine wird nie dieselbe sein wie die eines Menschen. Moral entsteht über Zeit und über Erziehung. Da bin ich zumindest skeptisch, dass man das ohne weiteres einprogrammieren kann."

Bisher ist klar: Menschen handeln - und tragen Verantwortung für ihr Tun oder Unterlassen. Dieses Regelsystem unseres Zusammenlebens gerät durch autonome Systeme ins Wanken, sei es im Falle von Extremsituationen wie Krieg oder im Alltag.

"Es ist wichtig, dass wir mit dieser Verantwortungsdiffusion bewusst umgehen. Was ja droht, wenn sich niemand mehr verantwortlich fühlt und niemand verantwortlich gemacht werden kann, dass dann eben auch die Verantwortlichkeit des Handelns nachlässt. Die Entscheidungen, die wir heute treffen - welche Forschung fördern wir, welche Maschinen, welche Form von künstlicher Intelligenz entwickeln wir weiter, dass die eben auch schon verantwortlich getroffen werden müssen in einem transparenten Diskurs."

Maschinen entwickeln ihre eigene Ethik?

Eines gilt vielen als ausgemacht: Unser Leben wird sich durch selbständig agierende Maschinen sehr viel grundlegender verändern, als sich die meisten das heute vorstellen können.

Wie menschlich werden diese Maschinen? Verlieren wir, wenn Maschinen handeln, unsere Stellung als alleiniges normatives Subjekt? Der evangelische Theologe Arne Manzeschke sieht darin eine eminente ethische Herausforderung.

"Wir werden uns eine Ethik für den Umgang mit den Maschinen zu Recht legen müssen. Und wir werden vielleicht sogar gewärtigen müssen, dass diese Maschinen sich ihre eigene Ethik entwickeln. Und wann wird es spannend, wie wir im Austausch vielleicht zu einer gemeinsamen Ethik kommen. Denn das müssen wir der Maschine zugestehen: Wenn sie so etwas wie Autonomie hat, wenn sie so etwas wie Handlungs- und Verantwortungshoheit hat, dann muss man ihr auch zubilligen, dass sie das selber tut."

Technik macht nicht das gute Leben

Wo liegen die Grenzen? Wo ziehen wir sie und wer entscheidet darüber?

"Wir brauchen Technik, aber diese Technik soll so sein, dass das, was wir als essenziell ansehen - nämlich menschliche Zuwendung - dass das weiterhin gewahrt bleibt. Und dass wir nicht aufgrund einer bestimmten technologischen Pfadabhängigkeit sagen müssen: Ja sorry, das war eine schöne Idee mit der Menschlichkeit, aber das geht halt unter diesen Bedingungen nicht."

Gerade mit Blick auf Roboter, die Menschen pflegen, ist Gesundheitsethiker Manzeschke sensibel. Da geht es um Vertrauen und um die Frage, wie möchte eine Gesellschaft mit Älteren, Kranken, Schwachen umgehen.

"Finden wir es zuträglich, Menschen, die gewisse Einschränkungen haben, der Obhut von Maschinen anzuvertrauen, weil wir selbst angeblich etwas Wichtigeres zu tun haben? Und damit komme ich zu einer sehr grundsätzlichen Frage: Wozu das Ganze? Wie wollen wir zusammen leben? Und wenn wir feststellen, dass wir uns dadurch verlieren, dann ist das der falsche Weg."

Autonom handelnde Maschinen werden vieles im Leben einfacher machen. Aber auch besser?

"Die Technik macht nicht das gute Leben. Sie kann ein Mittel sein, wenn wir selbst uns darüber klar sind, was wir als das gute Leben begreifen wollen. Solange wir das nicht wissen oder dieser Frage ausweichen, wird uns Technik nicht weiterhelfen, sondern sie wird uns womöglich auf Pfade führen, von denen wir irgendwann sagen müssen: Das war’s nicht. Aber dann sitzen wir auf diesen Pfaden und werden von denen nicht mehr runter kommen."

Es geht also darum, wer die Richtung vorgibt, wer Autonomie gewinnt oder behält: Roboter oder Menschen.