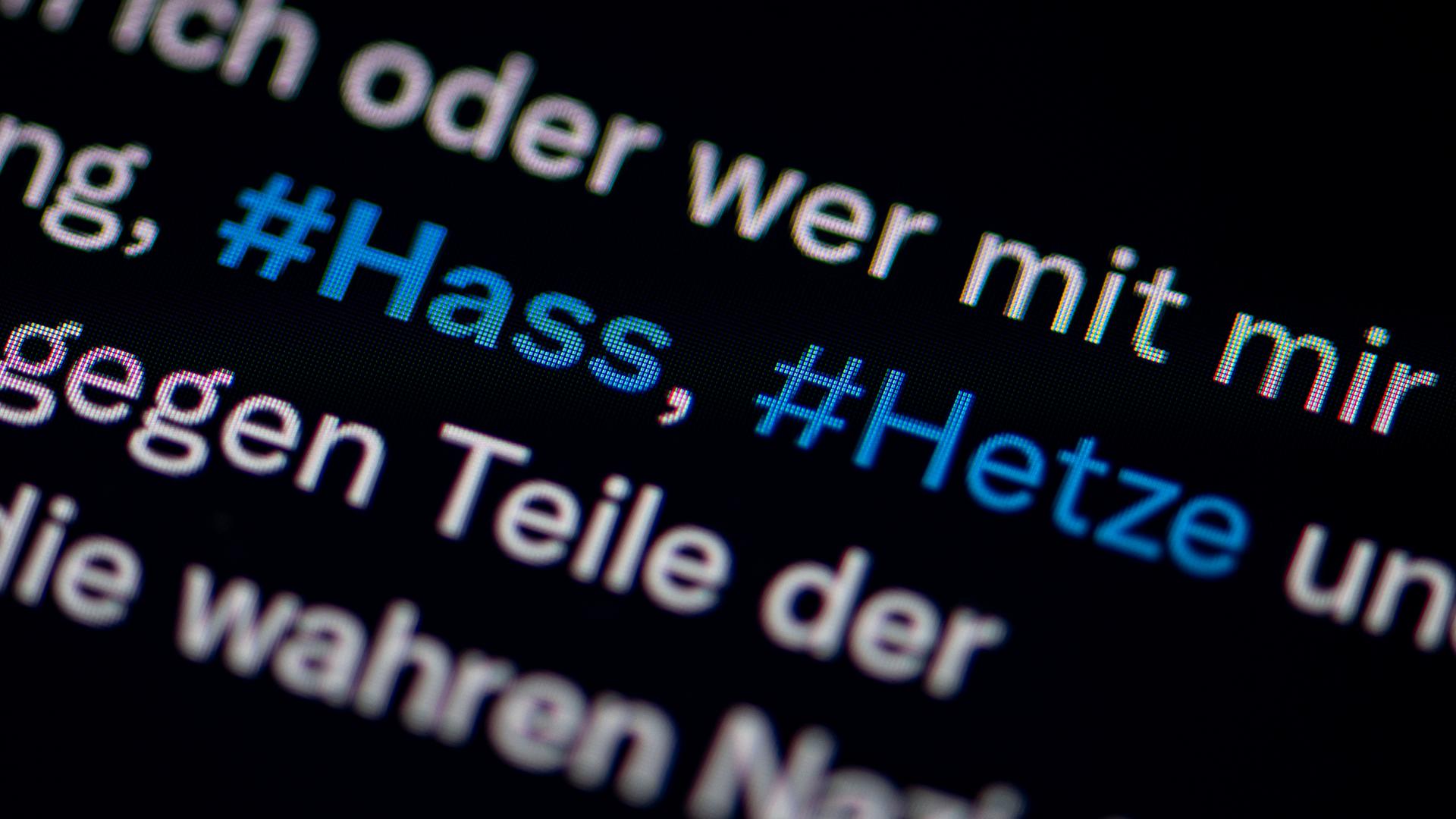

Bei Twitter rumpelt es gewaltig. Seit der Milliardär Elon Musk den Kurznachrichtendienst übernommen hat, bleibt kein Stein auf dem anderen. Er hat die Hälfte der Angestellten entlassen - darunter vor allem jene Teams, die sich um Hassrede und Desinformation gekümmert hatten. Wird Twitter deshalb bald voll sein mit Hatespeech und Propaganda? Oder kann Künstliche Intelligenz den wenigen verbliebenen Moderatoren der Plattform helfen, problematische Inhalte zu erkennen? Die Technikjournalistin Eva Wolfangel liefert Antworten auf die wichtigsten Fragen.

Sophie Stigler: Werden Hassbotschaften auf Twitter jetzt länger online stehen - oder gar nicht mehr gelöscht?

Eva Wolfangel: Vermutlich wird es jetzt einfach länger dauern, bis Drohungen und Aufrufe zur Gewalt von der Plattform entfernt werden. Elon Musk hat drei Teams entlassen, die sich mehr mit den Grundlagen und der Forschung zu Fake News und Hassrede befasst haben. Ein viertes Team, das ganz konkret mit dem Löschen von Inhalten beschäftigt ist, wurde deutlich verkleinert. Dabei kommt dieses Team jetzt schon kaum hinterher. Das Problem wird sich also weiter verschärfen, denn nach diesen Einschnitten dürfte es kaum noch möglich sein, es an der Wurzel anzupacken.

Schon jetzt hört man von Twitter immer wieder, dass Inhalte automatisch gesperrt wurden, an denen eigentlich nichts auszusetzen ist. Und dass es dann sehr lange dauert, bis ein Mensch das Problem löst und diese Inhalte wieder online stellt. Andererseits kommt es immer wieder vor, dass Inhalte, die eindeutig rassistisch oder antisemitisch sind, von Twitter nicht gesperrt werden. Womöglich weil die KI-Systeme, die heute schon im Einsatz sind, das nicht verstanden haben oder sich schwer damit tun zu entscheiden. Deshalb ist meine Prognose ganz klar: Das wird sich jetzt noch verschärfen, weil es einfach viel weniger Menschen gibt, die sich dem Thema annehmen.

Chan-jo Jun klagt gegen Twitter

Stigler: Der Anwalt Chan-jo Jun fürchtet, dass sich das Problem verschärft, wenn Twitter noch stärker auf Automatisierung setzt. Facebook hatte er wegen nicht gelöschter Gewaltdarstellungen verklagt. Jetzt verklagt er Twitter. Was genau wirft er der Firma vor?

Wolfangel: In diesem Fall geht es um falsche Tatsachenbehauptung. Ein User hat den Antisemitismusbeauftragten von Baden-Württemberg, Michael Blume, immer wieder vorgeworfen, eine Sexualaffäre zu haben oder jemanden sexuell zu belästigen. Michael Blume hat das selber mehrfach gemeldet, aber es wurde von Twitter nicht entfernt - er hat erstmal nur automatisierte Antworten bekommen, dass das nicht gegen die Standards verstoßen würde. Und diese Antworten kamen so schnell, dass er und sein Anwalt überzeugt sind, dass das eine automatisierte Entscheidung ist und dass das gar kein Mensch gesehen hat. Herr Jun hat mir gesagt, dass die vermutlich nur nach Stichworten suchen. In dem Fall wäre das gar keine richtige KI. Und das richtige Stichwort war wohl nicht dabei. Chan-jo Jun forscht auch zu dem Thema und sagt: Falsche Tatsachenbehauptungen sind für die automatischen Systeme von Twitter wohl besonders schwer zu erkennen.

"KI hat eine Verzerrung gegenüber Minderheiten"

Stigler: Auf welche Stichworte hätte die KI denn reagiert?

Wolfangel: Diese Stichwortlisten sind nicht öffentlich bekannt. Aber man kann davon ausgehen, dass da eindeutig mit Hassrede assoziierte Stichworte drin stehen. Und da ist das Stichwort 'Sexualaffäre' dann wohl nicht dabei. Das ist ja auch ganz gut so, denn wenn diese Listen zu ausführlich wären oder zuviele uneindeutige Begriffe enthielten, würden auch mehr Dinge automatisch gesperrt. In der Regel ist es so, dass die KI eben nach auffälligen Stichwörtern und Mustern sucht. In scheinbar eindeutigen Fällen entscheidet sie automatisiert. Wenn es nicht eindeutig ist für die KI oder wenn sich Menschen beschweren, dann werden Menschen einbezogen bei Twitter, die entscheiden, was jetzt wirklich wahr ist.

Stigler: Was ist dabei fehleranfällig?

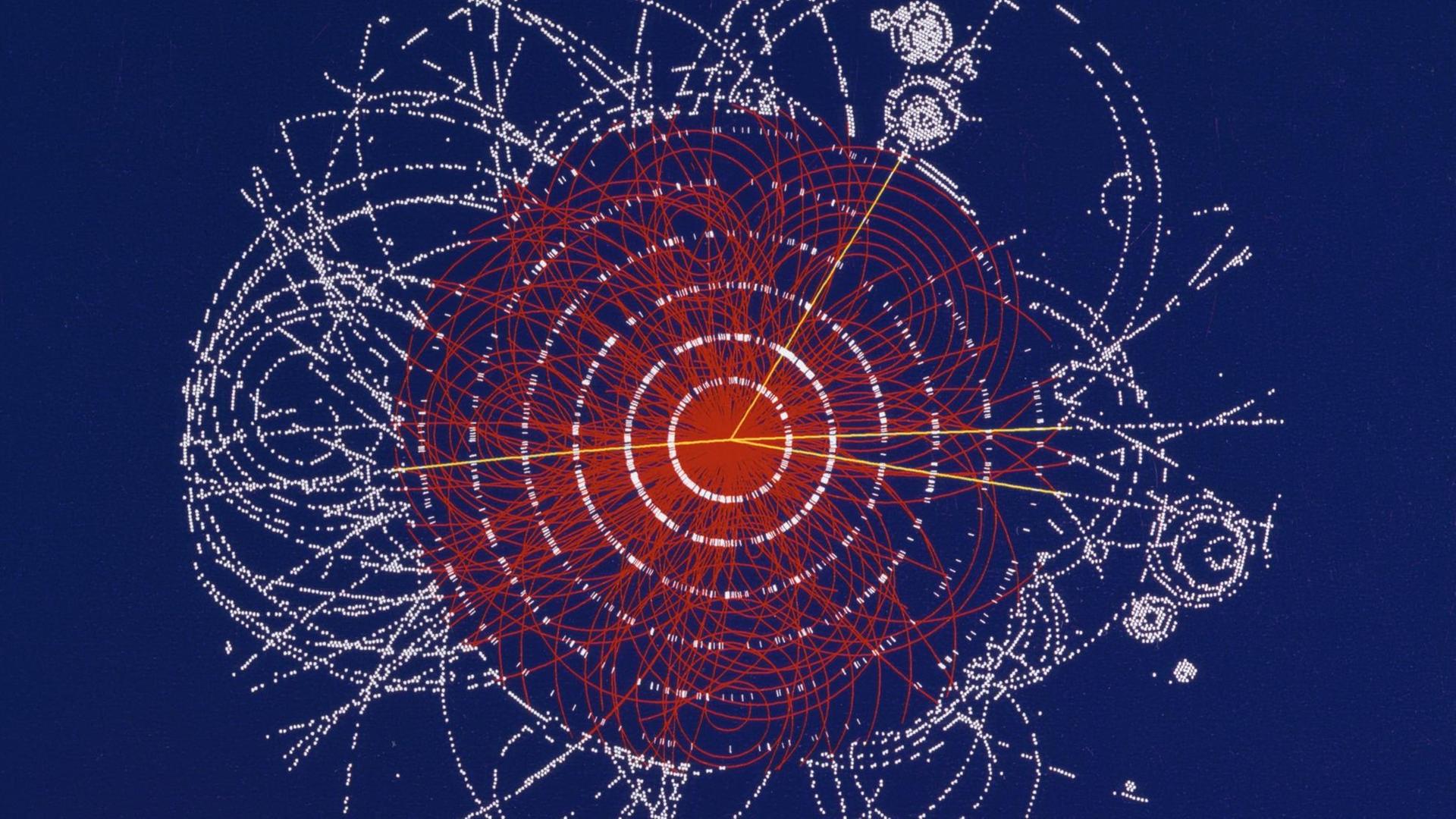

Wolfangel: Dazu muss man verstehen, wie KI Systeme lernen: Nämlich anhand von Trainingsdaten. Das sind große Datensätze, zum Beispiel mit Text, der Hassrede enthält, und Text ohne Hassrede. Und die Systeme vergleichen das statistisch und erkennen Muster darin, sodass sie dann perspektivisch auch in unbekannten Texten erkennen können: Das ist tendenzielle Hassrede oder keine Hassrede.

Dabei zeigt sich aber immer wieder: Weil die Datensätze nicht ausgeglichen sind, hat die KI einen Bias - also eine Verzerrung gegenüber Minderheiten, weil von diesen weniger Daten vorhanden sind. Das führt dann zum Beispiel dazu, dass bei deren Posts verhältnißmäßig viele Nachrichten automatisch gesperrt werden, die eigentlich harmlos sind. Und andersherum: Wenn die rassistisch beleidigt werden, funktioniert die automatische Sperrung nicht so gut.

Aufrufe zum Genozid in Äthiopien nicht erkannt

Stigler: Solche Verzerrungen sind ein lange bekanntes Problem bei KI Systemes. Gibt es da keine Fortschritte?

Wolfangel: Es kommt sehr darauf an, wen man fragt. Der Facebook-Forscher Yann LeCun sagt zum Beispiel, dass die Systeme sehr gut funktionieren und zu 95 Prozent akkurat sind. Das stimmt aber nach meiner Beobachtung nicht - zumal das ja auch eine sehr ungenaue Angabe ist. Was heißt zu 95 Prozent akkurat? Timnit Gebru, der ja bei Google gekündigt wurde und die sich intensiv mit großen Sprachmodellen und deren Verzerrungen beschäftigt, die sagt auch: Noch immer werden Inhalte von Minderheiten häufig fälschlich geblockt. Sie bezeichnet das sogar als "digital apartheid", also digitale Apartheid.

Hinzu kommt, dass die Sprache wirklich ein Thema ist. Diese Systeme funktionieren am besten auf Englisch. Auch auf Deutsch merkt man immer wieder, dass die Dinge falsch verstehen. Weil es natürlich am meisten Trainingsdaten auf Englisch gibt. Besonders problematisch wird es, wenn sich Dinge neu entwickeln. Timnit Gebru hat mir das Beispiel #TigrayGenocide genannt, der Bürgerkrieg in Äthopien. Da gab es auf Twitter Aufrufe zum Genozid, die die KI nicht erkannt hat - wegen dem fehlenden Kontext und weil es eben eine neue Entwicklung ist.

"Damit es besser funktioniert, braucht es mehr Forschung"

Stigler: Welchen Beitrag kann KI künftig leisten beim Umgang mit problematischen Online-Inhalten?

Wolfangel: Leider funktioniert die automatische Erkennung durch KI Systeme bisher nur mit bekanntem Material - also mit Bildern von Gewaltdarstellungen oder sexuellem Missbrauch zum Beispiel, die man schon kennt. Die kann KI ganz gut identifizieren. Aber das ist eben der kleinste Teil von problematischen Inhalten in sozialen Medien. Und damit es besser funktioniert, braucht es eindeutig mehr Forschung dazu. Forschung, die herausbekommt, wie man diesen Bias angehen kann, damit man nicht nur an den Symptomen herumkuriert und Moderator*innen immer mehr schreckliche Inhalte sehen müssen. Und das ist aber genau das, was Twitter jetzt nicht macht. Wie gesagt: Die drei Teams, die sich mit den Wurzeln des Problems befasst haben, sind entlassen worden. Und das ist natürlich eine ganz fatale Entwicklung.

Äußerungen unserer Gesprächspartner geben deren eigene Auffassungen wieder. Der Deutschlandfunk macht sich Äußerungen seiner Gesprächspartner in Interviews und Diskussionen nicht zu eigen.