Christian Rohde: "Die Physik ist komplett mathematisiert. Die Chemie und die Biologie, in diesen Wissenschaften ist dieser Prozess erst später gestartet worden."

Fast wie ein Virus breitet sich die Mathematik aus. Computer assistieren dabei.

Eberhard Voit: "Insofern sind die Computer jetzt dabei, in die Biologie groß einzusteigen."

Sie hauchen Daten Leben ein, machen aus einem Fossil einen Organismus.

Warren Porter: "Gewissermaßen bauen wir Jurassic Park."

Jerry McManus: "Die Simulationen waren gut darin, etwas zu beschreiben - vorherzusagen, wenn Sie so wollen -, das vor zehntausenden von Jahren passiert ist, das wir nicht direkt beobachten können, sondern rekonstruieren müssen."

Sie extrapolieren von der Vergangenheit in die Zukunft. Von Meeresschildkröten auf Schmetterlinge, Koalas und Kühe. Von Kühen auf der Erde zu Kühen im Weltraum.

Warren Porter: "Wir können das für alle möglichen Tiere machen. Und wir können es sogar auf erd-ähnliche Planeten extrapolieren, nach denen wir gerade im Universum suchen."

Lange ein exotisches Randgebiet: Die Mathematisierung der Biologie ist noch in den Kinderschuhen

Wie stellen Sie sich ein biologisches Forschungsinstitut vor? Räume mit gekachelten Tischen, voll mit Instrumenten und Geräten, Mikroskopen und Sequenzierern? Schränke mit Zellkulturen in Petrischalen? All das gibt es bei Eberhard nicht:

"Wir haben kein nasses Labor, wie man so schön sagt. Es sind alles Berechnungen."

In den 70er und 80er Jahren hat Voit an der Universität Köln an seinem Doktortitel gearbeitet. Dort galt er als Exot:

"Ich hab damals dann schon Mathematik und Biologie studiert, was als etwas lächerlich angesehen wurde, weil es hieß: Die Biologie ist einfach zu kompliziert dafür. Und ich sollte mich doch lieber entweder auf die Biologie oder auf die Mathematik konzentrieren, aber nicht mit Computern spielen. So hieß es damals."

Kühlschrankgroße Computer hatten wesentlich weniger Rechenleistung als heutige Smartphones. Trotzdem war Voit überzeugt, dass die Mathematik die Biologie bereichern kann. Er ging in die USA, fand dort Gleichgesinnte - die ebenfalls ein Schattendasein pflegten. Bis sich die Technik irgendwann nicht mehr ignorieren ließ:

"Die große Wende kam wahrscheinlich so um 2000, als man auf einmal in der Biologie Experimente machen konnte, wo man Gen-Expressionen messen konnte und gleichzeitig zehn- oder zwanzig- oder dreißigtausend Datenpunkte hatte, auf einmal. Und da wurden die Biologen nervös und sagten: Wir brauchen Leute, die irgendwie mit Computern uns helfen können."

Das Forscherleben danach war ein völlig anderes, sagt Eberhard Voit. Heute ist er anerkannt. Er leitet eine Gruppe am Georgia Institute of Technology in Atlanta, die nicht im Nasslabor forscht, sondern im virtuellen Raum. Erkenntnisgewinn liefern hier nicht Experiment und Beobachtung, sondern Programmcode und Prozessoren:

"Wenn man einen Input und einen Output hat, kann so ein Modell einem zeigen, wie dieser Input innerhalb des Systems verarbeitet wird und welche Schritte da sind und warum dieser Output da rauskommt und nicht ein anderer Output."

Input und Output sind Daten aus der echten Welt. Vorgaben oder Werte, die von anderen Forschern in realen Experimenten beobachtet wurden. Doch wie aus dem Input der Output wird, das lässt sich eben in der Realität oft nicht nachvollziehen. Der Computer dagegen kann die Vorgänge mathematisch modellieren, erklärt Voit:

"Man kann also diese Kette von Stimulation und Effekt ganz gut dadurch nachvollziehen und man lernt, wie so ein Input verarbeitet wird vom System, was nicht unbedingt einfach zu machen ist mit traditionellen Methoden."

Systembiologie heißt dieses Forschungsfeld. Sie will funktionierende Modelle bauen. Das klappt nicht immer:

"Wenn die Simulation das wiedergibt, was ich beobachte, dann bin ich natürlich froh. Aber wenn's das nicht tut, dann lerne ich was Neues dazu. Ein Beispiel: Wir haben uns viel mit Bakterien beschäftigt, die Zucker in Laktat umwandeln. Das sind Bakterien, die in Jogurts und Käse und so etwas sind. Und wir haben das beste Wissen eingebaut in Modelle - und die Modelle klappten nicht."

Die Modelle konnten die im Experiment gemessenen Mengen der Stoffwechselprodukte nicht nachbilden.

"Und warum klappten sie nicht? Ja, weil irgendwelche Regulationsmechanismen einfach nicht beachtet worden waren, nicht erforscht worden waren. Keiner hat dran gedacht, dass da vielleicht eine Regulation sein könnte. Und die Modelle sagten: Hier ist was falsch. Und deswegen musst du an dieser Stelle gucken, ob was da ist."

Es ist was da, bestätigten Experimental-Biologen. Bei anderen Bakterien konnten sie den vom Computermodell postulierten Mechanismus schon nachweisen. Bei den Bakterien, die Eberhard Voit modelliert hatte, steht die Prüfung noch aus. Experimente sind also nach wie vor nötig, auch weil Simulationen unter Umständen mehrere verschiedene mögliche Erklärungen für ein Phänomen liefern. Aber Simulationen ermöglichen ein zielgerichteteres Experimentieren.

Computersimulationen können reale Experimente nicht ersetzen

Ein gut gemachtes Modell kann helfen, Wissenslücken zu stopfen, bruchstückhafte Informationen zu einem stimmigen Ganzen zusammenzusetzen oder schnell und günstig verschiedene Wege durchzutesten. Dabei darf man Computerexperimente aber nicht mit realen Experimenten verwechseln, warnt Till Grüne-Yanoff, Wissenschaftsphilosoph an der Königlich-Technischen Hochschule in Stockholm:

"Ich habe jetzt quasi im Computer etwas, das repräsentiert sagen wir mal ein soziales System oder ein Auto oder ein Gebäude. Dann fange ich an, Veränderungen daran vorzunehmen und diese Veränderungen führen dann zu bestimmten Resultaten. Und die sind erstmal Veränderungen des Modells. Und dann muss ich zusätzlich argumentieren, dass diese Veränderungen des Modells auch relevant sind für die Wirklichkeit, die durch dieses Modell abgebildet wird oder eher: abgebildet werden soll."

Er erkennt jedoch an: Computersimulationen machen Bereiche der Wissenschaft zu Experimentierfeldern, in denen bisher Experimente schlicht nicht möglich waren:

"Denken Sie mal an Makro-Ökonomie, wo man sich fragt: Was wäre denn der Fall, wenn wir allen Leuten 50 Euro extra in die Tasche stecken würden, in Deutschland. So ein Experiment würde erstmal eine ganze Menge Geld kosten. Oder vielleicht gibt's auch einfach ethische und rechtliche Fragen. Wir dürfen nicht in die Eigentumsrechte der Bürger eingreifen. Wir können also nicht Experimente machen, indem wir die Steuern verändern."

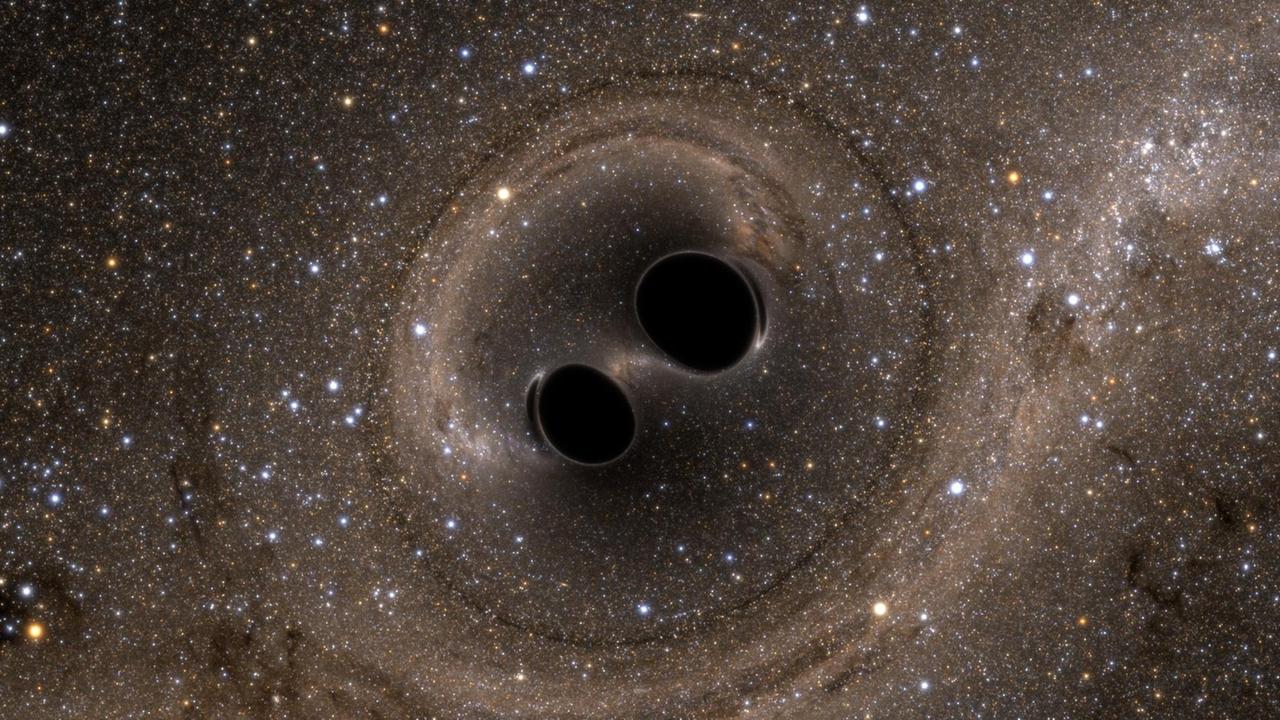

Astrophysik ist eine andere Forschungsrichtung, die durch Simulationen erst zur Experimentalwissenschaft geworden ist. Mit welchen Parametern ein schwarzes Loch funktioniert oder nicht, das lässt sich nur am Computer ausprobieren. Computersimulationen haben auch vorhergesagt, wie die Gravitationswellen aussehen, die bei der Kollision schwarzer Löcher entstehen. Diese Ergebnisse zeigten Experimentalphysikern, wonach sie suchen mussten, um Gravitationswellen zu messen - was im September 2015 erstmals gelang.

Wichtige Erkenntnisse über die Vorgänge im Universum sind nur durch Computersimulationen zustande gekommen. Sie scheinen konsistent zu sein mit Beobachtungen. Aber kein Modell bildet die Wirklichkeit zu 100 Prozent ab.

Simulationen über die Folgen von schmelzendem Eis durch reale Experimente bestätigt

Einer, der nah an der Wirklichkeit ist, ist Jerry McManus. Er führt durch ein Archiv der New Yorker Columbia University, in dem fast 20.000 Bohrkerne lagern. Forschungsschiffe haben sie über Jahrzehnte auf der ganzen Welt am Grund der Ozeane aus der Tiefe gezogen. Die älteren Kerne liegen ausgetrocknet im Keller, die jüngeren werden in einem gigantischen Kühlraum frisch gehalten. In Plastikröhren verpackt, stapeln sie sich in Metallregalen:

"Das Sediment ist feucht, das ist immer noch das Original-Wasser vom Meeresgrund. Wir können das organische Material darin untersuchen, ohne dass es verunreinigt wurde. Und was man hier sieht, sind typische Probeentnahmen, wo jemand zehn Gramm oder so entnommen hat."

Die Entnahmen haben schmale Kerben in der braun-schwarzen Bodenprobe hinterlassen. Bis zur letzten Eiszeit reichen die längsten Bohrkerne zurück. Jerry McManus sucht darin nach Hinweisen auf frühere Schwankungen in den Meeresströmungen. Was er herausfand, brachte ihm im Juli 2016 eine Veröffentlichung in Science ein:

"Die große Umwälzung im Atlantik, wenn die Wassermassen im hohen Norden an Dichte gewinnen und absinken und sich dann nach Süden bewegen, was ausgeglichen wird durch Strömungen Richtung Norden wie den Golfstrom, den Nordatlantikstrom, den Norwegischen Strom, die sind alle Teil dieses großen Kreislaufs. Dieser Kreislauf wurde in der Vergangenheit zeitweise dramatisch schwächer, meist durch Süßwassereintrag in der nördlichen Hemisphäre."

Viel Süßwasser kommt vor allem dann ins Meer, wenn Eisberge und Gletscher schmelzen.

"Es gab während der letzten Eiszeit eine Handvoll Fälle, wo riesige Eisberge abgebrochen und in den Atlantik getrieben sind. In jedem einzelnen Fall kam der Kreislauf beinahe zum Erliegen."

Was sein Doktorand an den Sedimentablagerungen ablas, passte gut zu den Modellen, erschreckend gut, so McManus:

"Ozeanmodellierer, die ihre Simulationen mit Süßwasser geflutet haben, hatten genau das vorhergesagt. Die Überraschung war, dass die Modelle richtig waren, nicht dass sie falsch waren."

Gelangt durch den Klimawandel wieder viel Süßwasser ins Meer, könnten die Strömungen also wieder zum Erliegen kommen - und damit für die nächste Klimakatastrophe sorgen.

Jerry McManus beschreibt die Zusammenarbeit zwischen Datensammlern wie ihm auf der einen und Modellieren auf der anderen Seite als einen iterativen Austausch. Seine Daten verbessern die Modelle und die Modellierer sagen ihm, wo es sich lohnen könnte, nach neuen Anhaltspunkten in der Natur zu suchen. Und hat er Daten gewonnen, helfen Modelle und Simulationen bei der Interpretation:

"Manchmal sind gesammelte Daten oder Beobachtungen zeitlich oder räumlich eingeschränkt. Die Modelle ermöglichen uns, diese Beobachtungen zu erweitern und die Bandbreite möglicher Interpretationen einzuschränken. Das ist wichtig, wenn man an abgelegenen Orten oder zu ungünstigen Jahreszeiten arbeitet. Sie sorgen also für eine robustere Interpretation und geben den Beobachtungen so viel größeren Wert."

In der Vergangenheit hatten Geowissenschaftler große Freiheiten, ihre oft sehr punktuellen Daten in einen Kontext einzuordnen. Sie konnten immer nur einen winzigen Ausschnitt der Erde untersuchen und versuchten daraus Aussagen über einen weit größeren Bereich zu treffen. Heute reichern Computermodelle die Datenpunkte mit Kontext an. Eine wissenschaftliche Publikation in der Natur gesammelter Daten ist ohne dazugehörige Modelle kaum noch denkbar.

In einigen Disziplinen fristen Computersimulationen nach wie vor ein Schattendasein

Modelle geben Daten also Validität. Doch mitunter sehen die Ergebnisse besser aus als sie sind. Denn wie experimentell gewonnene Werte, haben auch von Computerexperimenten generierte Szenarien Fehler. Der Mathematiker Christian Rohde vom Stuttgarter Exzellenzcluster Simulation Technology:

"Ich muss Daten eingeben, Parameter eingeben, die sind alle natürlicherweise mit Unsicherheiten behaftet. Und diese Unsicherheit zieht sich bei einer noch so guten numerischen Simulation bis auf das Endergebnis durch. Und ich muss wissen, inwiefern ich auch für das Endergebnis noch eine Unsicherheit habe."

Neben den Eingabeparametern sind auch die Modelle selbst mit Unschärfen behaftet. Die Ausgabe mit einem Fehlerbalken zu versehen, ist aber schwierig. Einerseits visuell: Wenn Wissenschaftler schicke 3D-Animationen produzieren, lassen sich Messunsicherheiten darin schlecht darstellen. Andererseits ist die Verarbeitung von Daten in Modellen oft ein einziges Dickicht, so dass gar nicht klar ist, wie groß die Unsicherheiten am Ende eigentlich sind, sagt Rohde:

"Das ist ein komplexes Zusammenspiel, das auch weitestgehend noch nicht verstanden ist, und das ist eine zentrale Herausforderung für die Zukunft meiner Wissenschaft an der Stelle."

Der Philosoph Till Grüne-Yanoff sieht Fortschritte bei der Transparenz, etwa in der Kommunikation von Ergebnissen aus der Klimaforschung. Doch in manch anderer Disziplin ist das Ansehen von Computersimulationen getrübt. In der Volkswirtschaftslehre beispielsweise würden sie kaum eingesetzt:

"Es gibt dazu verschiedene Spekulationen, manchmal auch meiner wissenschaftstheoretischen Kollegen. Die argumentieren, dass es in der VWL eine sehr starke Modellierungspraxis gibt und schon seit den 50er Jahren gab, die sehr stark auf mathematische Modelle aufgebaut ist. Und was da wichtig ist, ist immer der analytische Lösungsweg."

Computermodelle, die mit Differentialgleichungen und vielen Parametern und Variablen arbeiten, die sie zig-, hundert- oder tausendfach mit verschiedenen Anfangsbedingungen durchlaufen lassen, sind aber nicht mehr analytisch lösbar. Es gibt keinen Beweis, der sich als solcher in einem Paper abdrucken ließe, so Grüne-Yanoff:

"Und das ist vielleicht einer der Gründe, weswegen VWLer und vielleicht auch andere skeptisch gegenüber Simulationen sind. Weil denen die Transparenz, die epistemische Transparenz wie die Ergebnisse zustande kommen, fehlt."

Die Komplexität eines Modells ist abhängig vom Einsatzzweck

Was Computersimulationen tun, wirkt manchmal wie Magie. Es scheint, als könnten sie aus einem schwarz-weißen, zweidimensionalen Schatten einen bunten, dreidimensionalen Organismus kreieren. Sie liefern Hypothesen, für die die menschliche Vorstellungskraft nicht ausreicht, für die unsere Datenverarbeitungskapazität viel zu beschränkt ist. Je zutreffender diese Hypothesen sein sollen, desto mehr Daten braucht man, desto komplexer muss das Modell sein, so scheint es. Doch sie müssen nicht jedes Teilchen, jeden Prozess abbilden. Im Gegenteil. Die Arbeiten von Jerry McManus zu Meeresströmungen beispielsweise stehen im Kontext des Klimawandels. Schon vor Jahrzehnten, als von der Komplexität heutiger Klimamodelle noch niemand zu träumen gewagt hatte, wurden die Veränderungen an Meeresströmungen von verhältnismäßig einfachen Modellen postuliert. Doch in modernen globalen Klimamodellen sind die untersuchten Effekte bis heute kaum zu erkennen:

"Globale, aber dafür grob aufgelöste Modelle verhalten sich inkonsistent zu unseren Beobachtungen. Hochdetaillierte Modelle hingegen schauen sich zwar nur einen kleinen Teil des Ozeans an, lösen aber Raum und Zeit sehr gut auf. Sie können das Verhalten von Süßwasser, das ins Meer fließt, viel besser abbilden."

Entweder, man betrachtet das große Ganze, oder man fokussiert auf ein Detail. Beides geht auch in den mächtigsten Computersimulationen nicht gleichzeitig. Das bestätigt auch Syn Schmitt, der in einem ganz anderen Feld forscht. Er ist Biomechaniker und arbeitet im Stuttgarter SimTech-Exzellenzcluster an einem digitalen Menschmodell. Ein Mensch besteht aus mehr als 200 Knochen, rund 700 Muskeln, in den Muskeln spannen sich unzählige Fasern. Wie detailliert man all das simuliert, hängt vom Einsatzzweck ab:

"Wenn's so 'n detailliertes Modell ist mit 260 Muskeln, ist der Muskel selbst als sehr grobes Element repräsentiert. Es interessiert trotzdem aber manches Mal, dass man auch die Einzelstruktur hat, beispielsweise wenn es darum geht, Muskelkrankheiten zu untersuchen. Dann muss dieser Muskel ein geometrisches Objekt werden. Und wir entwickeln Methoden und arbeiten daran, dann einzelne Muskeln detaillierter abzubilden, die bis hin zu den Zellen oder sogar Molekülen abbilden können, ob der Muskel ein Kraftdefizit hat."

Wohl alle Wissenschaftler, die mit Simulationen arbeiten, würden sich mehr Rechenleistung für immer komplexere Modelle wünschen. Aber alle sagen auch, dass einfachere Modelle oft ausreichend sind. Das Modell muss geeignet für die Ziele sein, die man mit ihm erreichen will. Im Wissenschaftssprech: Man braucht ein valides Modell. Schmitt:

"Ich denke, das sind 80 Prozent der Ablehnungsgründe für Publikationen, weil man sich darüber streitet, ob die Modellierung valide ist. Das hängt zum einen davon ab: Habe ich die Struktur, die Geometrie richtig abgebildet, also Ausdehnungen. Das ist vielleicht noch einfach zu bewerkstelligen. Habe ich dann die zugehörige Physiologie, also Funktionsweise richtig abgebildet, die Zusammenhänge? Da ist schon der Abstraktionsgrad abhängig vom Auge des Betrachters."

Für manche Simulationen mag es reichen, einen Menschen etwa so simpel zu stricken wie einen zweibeinigen Roboter. Jedes zusätzliche Detail generiert dann nur überflüssigen Ballast. Für andere Zwecke hingegen sollte möglichst jeder Nervenimpuls realitätsnah simuliert - und verständlich dokumentiert werden. Auch hier hapert es noch.

Die Ergebnisse virtueller Experimente sind häufig schwer nachvollziehbar

Oft genug ist Veröffentlichungen nicht mehr anzusehen, wie genau die Ergebnisse zustande gekommen sind, was genau die Wissenschaftler simuliert haben. Christian Rohde:

"Tatsächlich gibt es viele Ergebnisse, die auf Programmen basieren, die nirgends veröffentlicht sind, die letztlich nur der Forscher selber mal geschrieben hat, und nach seinem möglichen Ausscheiden aus dem Projekt, aus dem Wissenschaftsleben verschwindet auch dieses Programm und das numerische Experiment selber ist gar nicht wiederherstellbar, was die wichtigste Forderung an einen echten Experimentalwissenschaftler wäre."

Mit der immer stärker computerisierten Wissenschaft muss sich also auch der wissenschaftliche Publikationsprozess verändern. Statt seitenlanger analytischer Beweise müssen irgendwie numerische Verfahren veröffentlicht werden - also der Programmcode. Eine Entwicklung in diese Richtung hat begonnen, führt Rohde aus:

"Es wird inzwischen von vielen Zeitschriften, in denen wir publizieren, verlangt, dass numerische Programme wiederherstellbar mit abgeliefert werden, und das ist auch die richtige Richtung. Was noch dazukommt, ist, dass Programmcode öffentlich zugänglich sein sollte. Hier muss sich aber erst eine gewisse Kultur entwickeln und es ist nicht sicher, wie man das angesichts der Datenmengen vernünftig macht und auch nachvollziehbar realisiert."

Christian Rohde sieht das als eine der großen Baustellen beim Aufbau von Computersimulationen zur dritten Säule der Wissenschaft, die gleichberechtigt neben Theorie und Experiment steht. Weit entfernt scheint dieses Ziel nicht. Die Computer weisen Wissenschaftlern immer häufiger den Weg. Sie identifizieren die erfolgversprechendsten Pfade, die Forscher einschlagen können. Schon bevor überhaupt geforscht werden kann, spielen sie eine entscheidende Rolle: Zu Forschungsanträgen gehören heute oft auch Argumente aus Computersimulationen, die nahelegen, dass sich die Investition lohnt.

Die Simulationswissenschaft ist per se interdisziplinär

Computersimulationen inspirieren Forscher in der Sportwissenschaft, in der Geographie, in der Biologie, hier fast überall von der Gentechnik bis hin zur Forst- und Landwirtschaft, wo sie Erträge vorhersagen. Forscher fast aller Disziplinen beschäftigen sich damit, weil Simulationswissenschaft per se interdisziplinär ist. Verkörpert wird das von Warren Porter, einem Biologen, der sich für Meeresschildkröten interessiert:

"Ich musste lernen, wie man virtuelle 3D-Tiere baut und animiert. Also habe ich ein paar Kurse in der Kunst-Fakultät belegt. Und dann musste ich wissen, wie man Reibung und Schub und den ganzen Wärmetransfer-Kram berechnet. Also habe ich ein paar Ingenieurs-Vorlesungen gehört. Ich habe inzwischen fast 50 Kurse in 19 verschiedenen Fakultäten gemacht."

Ohne das vielfältige Angebot an der Universität von Wisconsin in Madison hätte Warren Porter sich das nötige Wissen gar nicht aneignen können, sagt er. Und vor allem hätte er dabei auch nicht die Kollaborationspartner gefunden, mit denen er jetzt zusammen forscht. Gemeinsam haben sie ein Modell von Meeresschildkröten erschaffen, mit dem sie nun nach Belieben spielen können. Um die Vorfahren heutiger Meeresschildkröten zu untersuchen oder den Evolutionsdruck nachzuvollziehen:

"In der Animation kann man die Bewegung der Flossen beliebig verändern. So können wir ergründen, wodurch etwa die maximale Effizienz begrenzt wird. Wie sind sie geschwommen? Wie viel Nahrung mussten sie aufnehmen? Wie hat sich die Schwimmtechnik verändert oder die Größe der Flossen oder die Art der Bewegung?"

Porter betreibt also quasi experimentelle Paläontologie. Das hilft ihm dabei zu verstehen, wie die Umwelt einen Organismus beeinflusst. Das Gelernte kann er nun auf die Zukunft übertragen, oder auf andere Arten anwenden:

"Wir können beliebige Tiere konstruieren und mit großer Sicherheit beantworten, wie gut es funktionieren würde. Nach dem gleichen Prinzip wie man eine Rakete konstruiert oder ein Auto oder ein Boot. Wenn man die Grundprinzipien gut verstanden hat, kann man eine beliebige Geometrie nehmen und gucken, wie sich dieses Objekt in Luft oder im Wasser verhält."

Aus der Forschung ist ein Spin-off-Unternehmen entstanden, sie vertreibt eine App für Viehhalter. Mit Blick auf den Klimawandel ermittelt sie, wie sich an einem bestimmten Standort der Ertrag von Milchkühen verändern wird. Durch Manipulation der Variablen wie Größe, Fellfarbe und Haltungsbedingungen lassen sich dann unter Umständen besser funktionierende Kombinationen finden.

Simulationen können zeitaufwändige Experimente ersetzen

Dass Simulationen keine Computer-Hirngespinste sind, sondern eng mit der Wirklichkeit verknüpft, zeigt sich, wenn sie die reale Welt verändern helfen. Auf der Suche nach Arten, die sich als Energiepflanzen eignen und Mais oder Raps als Bio-Ethanol-Lieferanten ablösen könnten, untersuchte Eberhard Voits Team eine nordamerikanische Gras-Art, die Rutenhirse. Es ging vor allem darum, einen Weg zu finden, die Pflanze einfacher in Ethanol oder Butanol umzuwandeln. Dabei entdeckten die Wissenschaftler bisher unbekannte Mechanismen, die innerhalb der Grashalme bei der Produktion von Lignin ablaufen - Lignin ist praktisch Holz, und das stört bei der Ethanol-Produktion, so Voit:

"Und wir können jetzt Vorhersagen machen, wir haben Vorhersagen gemacht, wie man die Lignin-Produktion ändern kann, mit bestimmten genetischen Modifikationen, wo das Lignin dann entweder weniger da ist oder in einer anderen Komposition vorliegt."

Die experimentelle Bestätigung dieser Vorhersagen läuft derzeit in Texas:

"Mit reinen Experimenten würde das Jahre dauern. Und - wo wir das Modell jetzt haben - können wir diese Sachen in Minuten machen."

Auch Syn Schmitt überträgt Ergebnisse aus dem Computer zurück in die Wirklichkeit.

"Wir können einen Vorschlag und ein Konzept geben, das wurde auch schon patentiert, wie ein künstlicher Muskel in seiner Grundstruktur aussehen muss. Und das haben wir nur gelernt, weil wir eben Modelle des Menschen, des biologischen Systems haben und sagen können, welche einfachste Form von mechanischen Elementen benötigt werden, damit man in der Realität einen künstlichen Muskel bauen kann, der möglichst viele positive Eigenschaften des biologischen Muskels integriert."

Die Modelle sind noch zu primitiv, um die großen Herausvorderungen der Menschheit sinnvoll anzugehen

Simulationen helfen Wissenschaftlern Zusammenhänge zu erkennen, Wissenslücken aufzudecken und Abläufe zu verstehen. Oft geht es um kleinste Details, aber immer auch irgendwie um das große Ganze. Warren Porter hat aus Schildkrötensimulationen ein universelles Tiermodell entwickelt. Eberhard Voit will noch höher hinaus. Er sucht nach den Grundprinzipien der Biologie. Nach den Formeln des Lebens, die die Biologie nicht nur simulierbar, sondern berechenbar machen:

"Also zunächst mal werden wir wahrscheinlich sehr viel mit Simulationen machen müssen, weil alles so kompliziert ist. Im Endeffekt möchten wir Gesetze haben in der Biologie, so wie wir Gesetze in der Physik haben."

Die Gesetze der Physik, sagt Voit ein wenig neidisch, ermöglichen es uns, einen Roboter zum Mars zu schicken, der Fotos zurücksendet, ohne dass das vorher jemand ausprobiert hat. So etwas wünscht er sich auch für die Biologie: Mehr Gewissheit, weniger Versuch und Irrtum:

"Wir haben vielleicht so zwei, drei Gesetze in der Biologie, aber nicht mehr. Insofern sind wir noch am Suchen. Und wenn wir diese Gesetze irgendwann haben, dann werden Simulationen weniger wichtig werden, weil wir dann aufgrund dieser Gesetze Dinge berechnen können und vorhersagen können, ohne das auszuprobieren. Was Simulationen eigentlich sind: Ausprobieren von Möglichkeiten - bestmöglich, die schlechtesten Möglichkeiten, die wahrscheinlichsten Möglichkeiten, so etwas kriegt man mit Simulationen ganz gut raus."

Vielleicht sind die Differentialgleichungen, auf denen fast alle heutigen Simulationen beruhen, gar nicht die richtige mathematische Ausdrucksform, um biologische Vorgänge zu beschreiben. Voit hofft auch auf Weiterentwicklungen in der Mathematik. Die Werkzeuge, die Forscher heute zur Verfügung haben, sind für Voit jedenfalls unbefriedigend. Rechenleistung sei nicht das Problem, die wenigsten Simulationen benötigen Supercomputer. Vielmehr stimmten die Methoden noch nicht:

"Wir wollen Probleme lösen, die sehr kompliziert sind. Zum Beispiel möchten wir gerne Diabetes oder Krebs oder so etwas heilen. Und unsere Methoden sind bisher noch viel zu primitiv, um diese großen Probleme, die sogenannten Grand Challenges, irgendwie anzugehen."

Er fühle sich, als würde er versuchen mit einer Steinschleuder den Mars zu erreichen, sagt Voit:

"Wir können also zielen und unseren Stein da hin schleudern, aber wir können ihn bisher nicht treffen."

Computersimulationen haben ihre Möglichkeiten also noch längst nicht ausgereizt.