Straßenbahn. „Nächste Haltestelle: Südvorstadt.“ Die Ansage in der Dresdner Straßenbahn: ein Service für Fahrgäste, hilfreich für die, die über Büchern oder Smartphones sitzen. Wie wichtig solche Sprachausgaben für blinde Menschen sind, macht sich wohl kaum einer klar.

„Südvorstadt. Endstation."An der Endhaltestelle der Linie 8 wartet Jan Blüher. Zu erkennen ist er an seinem weißen Blindenstock.

„Hallo Herr Blüher!“

„Herr Reintjes?“

„Thomas Reintjes, hallo!“

„Schönen guten Tag!“

„Herr Reintjes?“

„Thomas Reintjes, hallo!“

„Schönen guten Tag!“

Wer fremd ist in der Stadt, kann sich blind auf sein Smartphone verlassen, um ans Ziel zu kommen – weil es bequem ist. Für Blinde wie Jan Blüher geht es nicht um Bequemlichkeit, sondern darum, sich die Welt zu erschließen. In Dresden kennt er sich zwar aus, aber die Dinge sind in Bewegung.

„Ich stehe jetzt hier auf einem kleinen Platz und würde gerne wissen: Was ist so um mich herum? Manche Sachen kann man schon riechen hier, aber andere nicht ...“

„Es riecht nach Brathähnchen.“

„Genau.“

„Ich hab die App jetzt geöffnet, lege jetzt einen Suchradius fest.“

„Hier ist nicht so viel, was wir da brauchen, 100 Meter sollte da reichen. Jetzt drehe ich mich mit dem iPhone.“

„Da ist die Post .... So ist es gedacht, dass man sich sozusagen umschauen kann.“

„Also das nutzt eine Kompass-Funktion.“

„Ja genau. Das Smartphone weiß: In welche Richtung werde ich gehalten? Hat Daten von interessanten Punkten, Straßen, Kreuzungen und kann mir deswegen sagen, wo bist du und wenn du dort hin willst, musst du in die Richtung gehen.“

„Okay, dann machen wir das.“

„Es riecht nach Brathähnchen.“

„Genau.“

„Ich hab die App jetzt geöffnet, lege jetzt einen Suchradius fest.“

„Hier ist nicht so viel, was wir da brauchen, 100 Meter sollte da reichen. Jetzt drehe ich mich mit dem iPhone.“

„Da ist die Post .... So ist es gedacht, dass man sich sozusagen umschauen kann.“

„Also das nutzt eine Kompass-Funktion.“

„Ja genau. Das Smartphone weiß: In welche Richtung werde ich gehalten? Hat Daten von interessanten Punkten, Straßen, Kreuzungen und kann mir deswegen sagen, wo bist du und wenn du dort hin willst, musst du in die Richtung gehen.“

„Okay, dann machen wir das.“

Von der Straßenbahn zu Jan Blühers Wohnung sind es ein paar Minuten Fußweg. Das Smartphone braucht er dafür nicht, ein klassisches Hilfsmittel schon: den Langstock, umgangssprachlich Blindenstock.

Mit dem Blindenstock unterwegs

„Der Blindenstock, den es jetzt so etwa seit dem Zweiten Weltkrieg gibt, ist eine der Erfindungen, die blinde Menschen autonom gemacht hat.“

Gerhard Weber, Professor für Mensch-Maschine-Interaktion an der Technischen Universität Dresden. In seinem Institut wird daran geforscht, wie digitale Technik Blinde noch autonomer machen kann, doch bisher ist der analoge weiße Stock ungeschlagen.

„...weil der durch die haptische Wahrnehmung im Griff des Blindenstocks Information über den Untergrund vermittelt: Ist der weich, senkt sich der Boden ab, ist hier Split, ist hier ein Teppichboden? Also, das wird alles über ein Mal aufsetzen des Stocks vermittelt. Und zum anderen ist dieses Aufsetzen verbunden mit einem kleinen akustischen Impuls. Der wiederum geechot wird, das heißt von dem, was sich um einen herum befindet, noch mal hörbar gemacht wird, was eigentlich dort ist. Also draußen kann ein blinder Mensch entscheiden: Ist hier eine Hauswand oder ist hier ein Busch, ist hier eine Einfahrt oder ist hier gar nichts?“

Der Stock vermittelt eine Vielzahl von Informationen unglaublich schnell. Keine Technik kann da bisher mithalten. Kurz bevor der Mensch den Fuß einen Schritt weiter nach vorne setzt, weiß er durch den Stock in der Hand, was ihn erwarten wird. In Echtzeit. Thomas Kahlisch, Mitglied im Präsidium des Deutschen Blinden- und Sehbehindertenverbands, bestätigt das. Obwohl er promovierter Informatiker und technikaffin ist, sagt er:

„Der Stock und der Hund, das sind so die wichtigsten Hilfsmittel. Der Stock, der ist täglicher Begleiter, ohne den geht's gar nicht: bis zur Straßenbahn und dann eben den Weg zur Arbeit, oder in den Einkaufsladen oder zum Bahnhof oder so. Der Hund ist schön, weil mit dem Hund kann man diese Wege noch etwas sicherer gehen und auch schneller gehen und noch einfacher den Weg finden als mit dem Stock. Wo man ja mit dem Stock immer in der Situation ist: Ich muss tasten wo sind Übergänge, wo befindet sich eine Bordsteinkante oder parkt hier gerade ein Auto mitten auf dem Weg oder es gibt Baustellen. Um so was führt einen der Hund wunderbar herum. Das ist ein sehr einfaches und ein schönes Gehen.“

Einen Führhund hat Kahlisch nicht mehr, denn so hilfreich die Tiere auch sind, beispielsweise für Vielreisende sind sie unpraktisch. Aber auch mit dem Stock stößt er manchmal an Grenzen.

„Im letzten Jahr, ganz früh bin ich auf Arbeit gegangen und es hatte intensiv geschneit. Mit dem Stock zu laufen: gar kein Problem. Aber wenn man dann nicht mehr die Übergänge fühlt, dann weiß man nachher nicht mehr, ob man schon in der Straße abgebogen ist oder ob man schon die Querstraße erreicht hat oder nicht. Das ist selbst bei einfachen Wegen, wenn es geschneit hat, extrem schwierig. Was habe ich gemacht: Ich hab mein Smartphone rausgeholt, hab meine Navigationsapp angeschmissen und hab gewusst, wo ich bin in der Straße, und war sofort wieder auf dem richtigen Weg und konnte mich dann gut zurechtfinden.“

Das Ziel vieler Entwicklungsteams ist daher eine Technik, die so schnell wie der Stock, so zuverlässig wie ein Führhund und dabei flexibel einsetzbar ist. Prinzipiell ist vergleichbare Technik schon verfügbar, sagen Rainer Stiefelhagen und Daniel Köster vom Karlsruher Institut für Technologie: „Sie können sich heute in einem Oberklasse-Fahrzeug Spurhaltesysteme, Abstandshaltesysteme kaufen, Systeme, die Straßenschilder erkennen. Und solche Verfahren könnten wir auch nutzen, um blinde Menschen zu unterstützen, beispielsweise um eine sichere Navigation oder sicheres Bewegen in der Stadt zu ermöglichen oder auf dem Campus hier. Und daran arbeiten wir.“

Köster: „Das Ziel bei uns wäre, naja wir sagen manchmal selbst gerne: der digitale Blindenstock. Es gibt ja für uns inzwischen ziemlich viele Navigationssysteme – die meisten Handys können das – und das Problem für den Blinden ist aber: Das Navigationssystem sagt mir nur ‚in hundert Metern rechts‘. Und mit dem Blindenstock kann ich mir quasi die nächsten ein, zwei Meter erfühlen, so lang wie mein Blindenstock halt ist. Und der Bereich dazwischen, der wird halt gar nicht betrachtet.“

Und auch nicht der Bereich in Brust- oder Kopfhöhe. Mit dem Stock lässt sich nur der Boden abtasten.

„Wir hatten das Problem, dass ein Student mal in diesen geparkten Lkw gelaufen ist, wo halt so ein Lkw entladen wurde und der hatte die Ladefläche halt runtergelassen und das war halt dann so Brust-/Kopfhöhe. Und der ist da halt reingelaufen, weil er es mit seinem Stock natürlich nicht erkennen konnte.“

Mit Stereokameras wollen die Karlsruher Forscher für Abhilfe sorgen. Daniel Köster stellt dabei die Objekterkennung auf den Kopf. Sein Algorithmus muss nicht herumstehende Fahrräder von Mülleimern unterscheiden können. Er muss nur erkennen, wo der Fußgänger freie Bahn hat und was kein Hindernis ist, etwa entgegenkommende Fußgänger.

„Wenn wir die Freiflächen vor dem Blinden herausfinden können, könnten wir ihm quasi den bestmöglichen Weg zur nächsten Kreuzung zeigen. Und dann hätte er wieder die Information: Okay, ich möchte an der nächsten Kreuzung rechts gehen. Und dann geht's zur nächsten Kreuzung und dass wir immer dieses Stück betrachten.“

Im Laufe dieses Jahres will Daniel Köster die ersten Benutzer einen Prototypen seines Systems ausprobieren lassen. Noch ist die Stereokamera an einen Laptop gekoppelt, in Zukunft könnte das System auf einem Smartphone laufen und die Kamera in eine Brille integriert werden.

Virtuelles Auge Smartphone

Unterwegs in Dresden hält Programmierer Jan Blüher an einem Blumenladen. Draußen, vor dem Schaufenster sieht er sich das Angebot an. Mit Händen und Smartphone.

„Ja, und für die Blumen will man ja wissen: Was hat man da? Wenn man sich auskennt, findet man die Sorte auch noch durch Tasten raus. Aber für die Farbe bietet sich dann der ColorVisor an.“

ColorVisor. Mitternachtsblau. Graublau. Feuerrot.

„Also das sind wirklich knallrote Tulpen.“

„Ah ja, schön.“

„Ah ja, schön.“

Jan Blüher hat die App selbst entwickelt und vertreibt sie über den AppStore für ein paar Euro. Leben könnte er davon nicht. Blumen kauft er zwar selten, aber die App hilft auch bei der Auswahl von Kleidung oder um festzustellen, ob Bananen grün, gelb oder schon braun sind, erzählt er auf dem Weg zur nächsten Station, einem Supermarkt.

„Ich stehe am Regal und hab ein Glas vor mir und hab keine Idee, was es sein könnte. Aber auch dafür gibt's ne App. Die nennt sich Digit Eyes. Das ist ein Barcode-Scanner. Dann nehme ich mir das Glas, drücke auf Scannen und versuche, auf der Packung den Barcode zu finden. Ich drehe das Glas, damit möglichst alles abgedeckt ist.“

„Jetzt hat er ihn gefunden. Und jetzt muss er im Internet nachschauen, was es denn ist.“

Salz-Dill-Gurken, 370 Gramm.

„Und da haben wir's. Und auch hier ist das wieder besonders spannend zuhause. Wenn man irgendwann mal irgendwelche Konservengläser, Verpackungen gekauft hat, wo man nicht mehr weiß, was es ist. Oder man weiß: In dem einen sind die Würstchen, in dem anderen sind die Gurken, dann hilft diese App einfach mal auseinanderzuhalten: Was ist was. Sodass man dann nicht die Würstchen essen muss, wenn man eigentlich die Gurken haben wollte.“

„Jetzt hat er ihn gefunden. Und jetzt muss er im Internet nachschauen, was es denn ist.“

Salz-Dill-Gurken, 370 Gramm.

„Und da haben wir's. Und auch hier ist das wieder besonders spannend zuhause. Wenn man irgendwann mal irgendwelche Konservengläser, Verpackungen gekauft hat, wo man nicht mehr weiß, was es ist. Oder man weiß: In dem einen sind die Würstchen, in dem anderen sind die Gurken, dann hilft diese App einfach mal auseinanderzuhalten: Was ist was. Sodass man dann nicht die Würstchen essen muss, wenn man eigentlich die Gurken haben wollte.“

Kahlisch: „Ich hätte vor sechs Jahren als Usability-Experte darauf gewettet, dass das niemals funktionieren kann, dass ein blinder Mensch mit einem Touchscreen zurechtkommt. Da sind echt ein paar smarte Ideen drin, die die Entwickler von der Firma mit dem angebissenen Apfel hatten, die natürlich auch bei der Android-Welt inzwischen auch Eingang findet.“

Apple hatte beim iPhone von Anfang an darauf geachtet, dass es für Menschen mit verschiedenen Einschränkungen bedienbar ist. Für Menschen mit Sehbehinderungen gibt es die VoiceOver-Funktion. Fährt man mit dem Finger über den Bildschirm, liest das Gerät vor, welche App oder welche Funktion sich an der jeweiligen Stelle aufrufen lässt. Durch strikte Vorgaben sind Programmierer von Apps gezwungen, ihre Anwendungen so zu gestalten, dass sie mit der Sprachausgabe funktionieren. Allerdings erzählt Informatiker und Blindenvertreter Thomas Kahlisch auch, dass Apple in letzter Zeit manches verschlechtert habe und auf Kritik nicht reagiere. Dennoch: Smartphones bedeuten für Blinde einen enormen Gewinn an Lebensqualität: „Für mich ist es als blinder Mensch einfach in einer großen Vielfalt Zuwachs an Informationen, Zuwachs an Mobilität, an Entscheidungsfreuden, also Möglichkeiten mich selber zu entscheiden, mir selber Informationen zu verschaffen.“

Allerdings: Optimal sind die Touchscreens nicht.

Taktile Displays

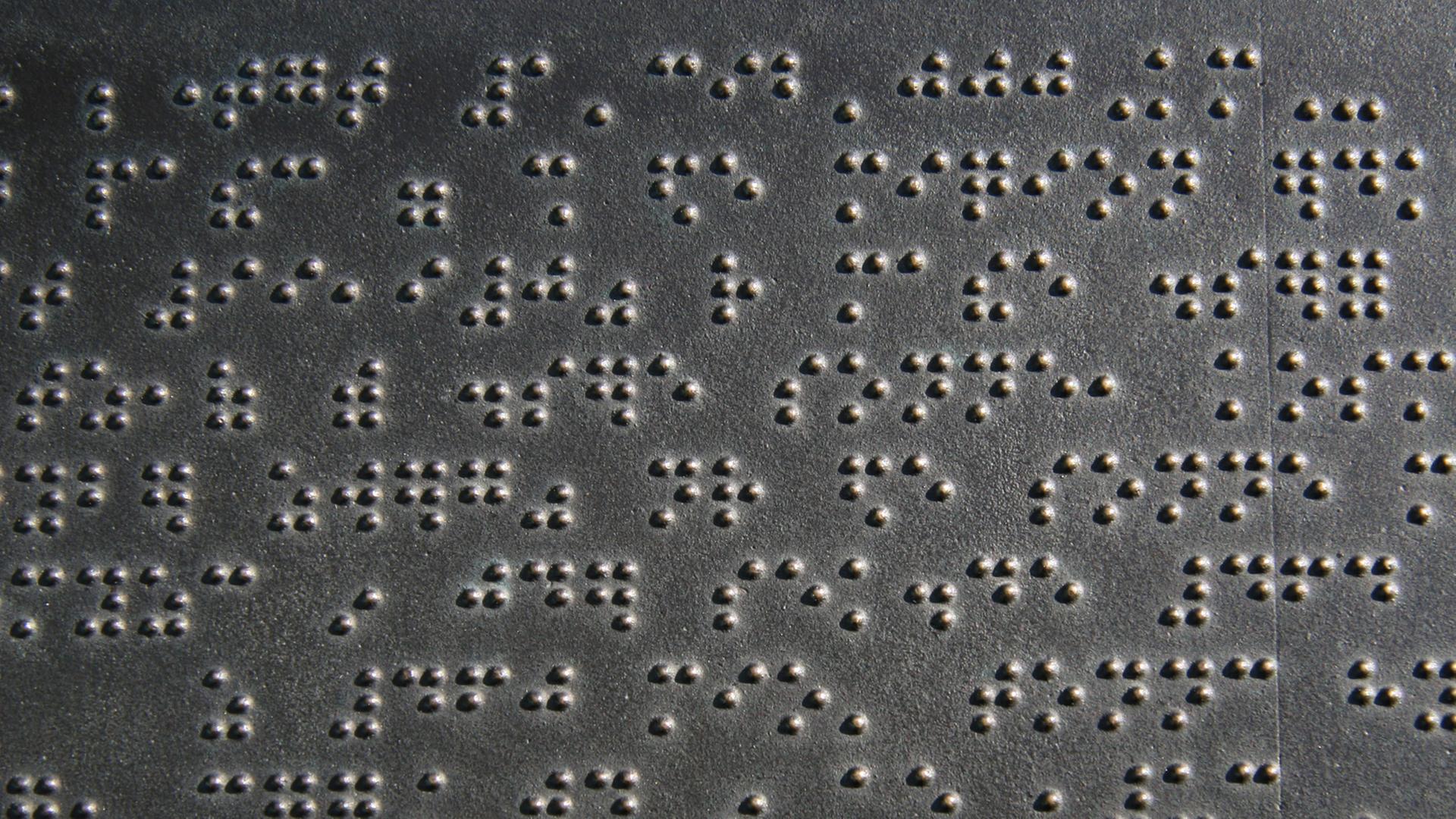

Noch besser als eine spiegelglatte Oberfläche mit Sprachausgabe fänden viele Blinde einen Bildschirm, der auch für sie etwas abbildet. Der ihnen Informationen erschließt, die eine Sprachausgabe nicht vermitteln kann: Grafiken etwa. Oder der sie Inhalte diskret statt über Lautsprecher konsumieren lässt, indem Blindenschrift auf dem Display ertastbar ist. Geräte, die die Brailleschrift zeilenweise ausgeben, gibt es schon lange, erklärt Bastian Rapp vom Karlsruher Institut für Technologie:

„Gerade für die Leute, die viel am Computer arbeiten, die arbeiten sehr viel mit diesen dynamischen Braille-Zeilen. Das ist im Endeffekt eine Zeile, die unter der Tastatur angeordnet wird, mit einer Stiftmatrix und die Stifte heben und senken sich quasi, um über den Braille-Code auf diese Art und Weise Buchstaben zu codieren. Und man kann mit dem Finger diese Stifte quasi tasten und dann taktil die Zeile lesen.“

Die Geräte lassen sich mit allen gängigen Computern und auch mit Smartphones koppeln. Allerdings kosten Braille-Zeilen mehrere Tausend Euro und haben auch sonst einige Nachteile.

„Eine Zeile zu lesen – kann man sich ja auch vorstellen, wenn man das als sehender Mensch macht: Eine Maske über den Bildschirm zu legen, die immer nur eine Zeile anzeigt, ist relativ schwierig. Plus, was noch dazukommt: Grafiken kann man mit diesen Matrizen jetzt nicht direkt darstellen. Dafür sind die auch nicht ausgelegt.“

Erste größere Tastfelder, taktile Displays, gibt es inzwischen. Noch sind sie schwer und teuer. Deshalb beschäftigen sich Forschergruppen weltweit mit der Frage, wie sich Oberflächen noch manipulieren lassen. Bastian Rapp setzt auf Mikrofluidik. Technik, bei der kleinste Mengen Flüssigkeit durch winzige Kanäle bewegt werden.

„Das ist ein dünnes Röhrchen, das ist gefüllt mit einem Wachs. Und dieses Röhrchen ist umwickelt mit einem Draht. Dieser Draht kann unter Spannung gesetzt werden, heizt sich auf und schmilzt dann das Wachs, das in dem Röhrchen ist.“

Das Wachs wird beweglich: Wenn von unten Wasserdruck angelegt wird, bewegt es sich nach oben, stößt gegen eine Membran und erzeugt eine Beule, die sich ertasten lässt. Einen Prototypen mit sechs Punkten, wie sie für einen Braille-Buchstaben gebraucht werden, führt Rapps Mitarbeiterin Elisabeth Wilhelm vor:

„Jetzt kann ich einfach mal einen oder zwei von diesen Schaltern umlegen, dann fließt Strom. Dann müssen wir ein bisschen warten, weil: Das Heizen dauert ein bisschen. Und wenn ich jetzt mit der Spritze da Druck draufgebe, dann sieht man schon, wie der erste Punkt sich da langsam nach oben schiebt. Also sehen kann man es nicht ganz so gut, aber wenn man drauf fasst, dann merkt man, wie der Punkt sich hebt.“

Schaltet sie die Heizdrähte wieder ab, wird das Wachs fest und das Punktmuster bleibt stabil. Ein paar Probleme müs-sen sie noch lösen in Karlsruhe, aber dann soll sich mit der Technik und 3D-Druck sehr günstig ein Display mit hunderten Punkten herstellen lassen. Allerdings sorgt das Aufschmelzen und Aushärten des Wachses für ein Tempolimit. Zehn Sekunden dauert es derzeit, ein Punktmuster aufzubauen.

„Der Knackpunkt ist: Wie transportiert man Informationen, räumliche Informationen, also die sich über die Fläche verteilen, an einen Blinden?“

Mit dieser Frage beschäftigt sich auch Jens Bornschein an der Technischen Universität Dresden. Auf seinem Schreib-tisch steht schon ein taktiles Display, allerdings mit älterer Technik. Es ist im Prinzip aus mehreren Braille-Zeilen zu-sammengesetzt und besteht aus einer Fläche von Metallstiften, die der angeschlossene Computer blitzschnell heben und senken kann. Das über zehntausend Euro teure Gerät namens Hyperbraille wurde in Dresden mitentwickelt. Jens Bornschein arbeitet nun daran, Bildschirminhalte wie Grafiken angepasst auszugeben. Wie werden farbige Balkendiagramme in schraffierte Flächen übersetzt? Wie lassen sich Landkarten so darstellen, dass sie intuitiv verstanden werden?

„Wir kennen das von Karten. Also ein Mischwald sieht immer aus mit Dreiecken und ein komisch verunstaltetes Omega-Zeichen. Wasser ist im Normalfall blau. Und genau solche Mechanismen wollen wir auch für diese taktilen Grafiken schaffen.“

Muster sollen auf verschiedenen Ausgabemedien wiedererkannt und richtig interpretiert werden. Was die Fingerspitzen ertasten, mit bestimmten Assoziationen zu verbinden, hat allerdings Grenzen:

„Wir haben versucht, Blinde dazu zu kriegen, dass sie uns eventuell eine Farbe oder eine Emotion dazu sagen, das war aber zu unterschiedlich. Für viele sind kurze Striche dann eventuell Regen oder Schnee, andere sagen, das sieht aus wie ihre Gardine zuhause. Oder es sieht aus wie rot. Das können natürlich nur Leute sagen, die eine Assoziation mit rot haben und das ist leider etwas so Subjektives, dass man es nicht verallgemeinern kann. Das heißt, derjenige, der das Muster verwendet, der hat dann dafür zu sorgen, dass dem eine Assoziation zukommt.“

Jens Bornschein arbeitet an Richtlinien, an einem Baukasten-System, das helfen soll, Informationen ertastbar zu ma-chen.

Hilfe durch Apps

„Jan Blüher ist inzwischen zu Hause angekommen. Auch auf seinem Schreibtisch, an dem er seine Apps programmiert, steht eine Braille-Zeile. Jetzt aber setzt er sich an den Küchentisch und trinkt Latte Macchiato. Das Glas fotografiert er mit seinem Smartphone.“

„Okay, es hat geblitzt, automatisch.“

„Ja, er hat das Bild gemacht und schickt's jetzt los.“

Picture eins ist Trinkglas mit weiß-brauner Flüssigkeit.

„Also Tap Tap See ist eine App, damit macht man ein Foto von irgendeinem Objekt, was man gerne identifizieren möchte, dann wird das Foto ins Netz geschickt, also zu den Servern der Firma, die die App entwickelt hat, und zurückkommt eine Beschreibung dessen, was auf dem Bild ist. Und das kann man halt mit allen möglichen Sachen machen, das geht sogar so weit, dass wenn man Sachen mit Anzeigen hat, kann man ein Foto von der Anzeige machen und sich dann ausgeben lassen, was es ist. Und das Spannende dabei ist, das wird einerseits mit Bilderkennungsalgorithmen gemacht, aber das funktioniert nicht immer. Und deswegen kann es sein, dass dann am Ende reale Menschen, die irgendwo sitzen auf der Welt, das Bild vorgesetzt kriegen, das beschreiben und dann wird's erst an mich zurückgesendet.“

„Ja, er hat das Bild gemacht und schickt's jetzt los.“

Picture eins ist Trinkglas mit weiß-brauner Flüssigkeit.

„Also Tap Tap See ist eine App, damit macht man ein Foto von irgendeinem Objekt, was man gerne identifizieren möchte, dann wird das Foto ins Netz geschickt, also zu den Servern der Firma, die die App entwickelt hat, und zurückkommt eine Beschreibung dessen, was auf dem Bild ist. Und das kann man halt mit allen möglichen Sachen machen, das geht sogar so weit, dass wenn man Sachen mit Anzeigen hat, kann man ein Foto von der Anzeige machen und sich dann ausgeben lassen, was es ist. Und das Spannende dabei ist, das wird einerseits mit Bilderkennungsalgorithmen gemacht, aber das funktioniert nicht immer. Und deswegen kann es sein, dass dann am Ende reale Menschen, die irgendwo sitzen auf der Welt, das Bild vorgesetzt kriegen, das beschreiben und dann wird's erst an mich zurückgesendet.“

Jeder Gegenstand lässt sich so einfach identifizieren – wenn man eine Internetverbindung hat. Ohne Internet funktioniert eine SpezialApp auf Jan Blühers Smartphone:

Geldleser. Geldleser-Warnung: Diese App nicht zur Erkennung von Falschgeld geeignet und der Anwender kann sich zur Unterscheidung von Geld nicht ausschließlich auf diese App verlassen. Geldleser läuft.

„Schauen wir mal, was wir hier haben.“

Fünf Euros, fünf Euros.

„Guter Tipp.“

Zwanzig Euros, zwanzig Euros.

„Sehr schön, man sieht, es geht auch sehr schnell.“

„Klappt sogar mit dem neuen Fünfeuroschein.“

„So muss eine App sein: Man macht die auf und funktioniert.“

„Schauen wir mal, was wir hier haben.“

Fünf Euros, fünf Euros.

„Guter Tipp.“

Zwanzig Euros, zwanzig Euros.

„Sehr schön, man sieht, es geht auch sehr schnell.“

„Klappt sogar mit dem neuen Fünfeuroschein.“

„So muss eine App sein: Man macht die auf und funktioniert.“

Neun Euro hat Blüher in den Geldleser investiert – relativ viel für eine App mit begrenztem Funktionsumfang, aber erstaunlich wenig für ein Spezialhilfsmittel für Blinde.

Smartphones bieten schon Vieles, was Blinden ermöglicht, sich besser in der Welt zurechtzufinden. Vieles lässt sich aber auch noch verbessern. Nachdem die Makronavigation – also etwa: Wie komme ich von einer Stadt in die andere – gut funktioniert, kümmert sich ein Team am Institut von Gerhard Weber in Dresden um die Mikronavigation:

„Gerade in Umsteigegebäuden – Bahnhöfen, Flughäfen, auch großen Behörden, Krankenhäusern – ist es nicht einfach einen Weg zu finden. Für blinde Menschen wird dann teilweise ein Begleitservice angeboten. Die Deutsche Bahn macht das möglich, dass man beim Umsteigen Hilfe bekommt. Aber mitten in der Nacht so etwas zu erwarten, ist dann doch viel verlangt, würde ich sagen. Die Betriebszeiten sind also nicht 24 Stunden, üblicherweise.“

Die Wissenschaftler wollen Blinden auch hier zu mehr Eigenständigkeit verhelfen. Martin Spindler hat sich für sein Forschungsprojekt viel vorgenommen: „Hier sehen wir das Beispiel Frankfurter Flughafen, das war für uns das Haupt-Test-Szenario. Ein unheimlich komplexer Gebäudekomplex mit mehreren Teilen, mit einem angebundenen Fernbahnhof, riesen Shopping-Bereich und natürlich den Gates, wo man hinfinden will.“

Spindler hat Lagepläne in eine App integriert und mit Spezialinformationen für Blinde versehen – zum einen Hindernisse, zum anderen sogenannte Landmarken, die der Orientierung dienen. Das können beispielsweise Rampen sein, die man beim Darübergehen direkt erkennt.

Drei. Route. In Durchgang C4 bis C6 drehen Sie sich nach links und gehen Sie 75 Meter bis Gang mit leichten Rampen, danach schräg rechts.

„Ja, und hier sind Entfernungen und Richtungen angegeben, die aber immer auch Bezug nehmen, auf eine Richtung, die ich entweder schon vorher habe, oder auf ein Objekt, an dem ich mich gut orientieren kann.“

Eine der größten Schwierigkeiten für Spindlers Team war es herauszufinden, wann welche Information ausgegeben werden muss, damit die Menschen weder überfordert sind, noch zu wenig Hinweise erhalten. Am Ende hat mit einem ersten Prototyp alles geklappt: „Am Schluss war's so, dass wir ein Umsteigeszenario den Nutzern als Aufgabe gegeben haben und in einem Abschlusstest die Probanden selbstständig ihren Weg von einem Gate zu einem anderen Gate in einem völlig anderen Gebäudeteil in Frankfurt finden mussten. Und das hat akzeptabel gut geklappt, also die Nutzer würden es gerne einsetzen und hoffen nun darauf, dass nun Karten erarbeitet werden für Gebäude, wo man das zum Einsatz bringen kann.“

An der Universität Stuttgart hat Andreas Hub solche Karten bereits erstellt. Der gesamte Campus wurde erfasst, Gefahrenstellen markiert, Landmarken verzeichnet – sogar Geruchsquellen wie eine Bäckerei oder Geräuschquellen wie ein U-Bahn-Schacht lassen sich mit seinem System kartieren. Inzwischen ist Andreas Hub aber nicht mehr dort angestellt, sondern will mit seiner gemeinnützigen Firma Blind Navigation International für die weitere Verbreitung der Technik sorgen. Er sieht dabei die öffentliche Hand in der Pflicht: „Wir sollten uns einfach klar werden, dass es jetzt einfach wirklich Aufgabe der Gesellschaft und des Staates ist, alle öffentlichen Gebäude barrierefrei zu machen – mit welchen Mitteln auch immer. Aber es muss mehr passieren als bisher.“

Orientierung durch Vibrationen

Wo lang geht es zum Gate, welche Hindernisse stehen im Weg und wie geht es daran vorbei? Welche Landmarken sollte man sich merken, um eine Orientierung zu bekommen? Blinden könnten in Zukunft noch viel mehr Informationen zur Verfügung stehen. Offen ist: Wie sollten diese Informationen gefiltert und wie vermittelt werden? Sprachausgabe, wie sie heute oft verwendet wird, ist nicht optimal.

„Es ist klar, dass wir nicht den Audio-Kanal die ganze Zeit überlagern dürfen, also für blinde Nutzer, weil die einfach ganz stark ihr Gehör nutzen zur Orientierung und um die Welt wahrzunehmen. Da können wir natürlich nicht dauernd irgendwie reinsprechen und unter Umständen unnütze Informationen ausspucken. Da muss man also wirklich sich viele Gedanken machen.“

Sagt Rainer Stiefelhagen. Viele Forscherteams – auch seines – experimentieren mit Vibrationssignalen. Die Karlsruher haben in einer Studie schon festgestellt, dass es für Blinde angenehmer war, Informationen per Vibration zu bekommen als per Sprache. Eines der am weitesten gediehenen Geräte hat die Firma Sensodrive entwickelt, eine Ausgründung aus dem Deutschen Zentrum für Luft- und Raumfahrt. Geschäftsführer Norbert Sporer:

„Sie sehen hier Vibrotac, es sieht aus wie ein großes Armband. Sie sehen hier sechs Vibrationsmotoren, die vibrieren ähnlich wie beim Smartphone. Die sind so groß wie eine kleine Batterie. Über eine flexible Verbindung sind die Motoren miteinander gekoppelt, das heißt, Sie können es sehr leicht // zum Beispiel an der Wade tragen.“

„Oder am Handgelenk.“

„Und wenn ich jetzt die Demo starte ...“

„Es vibriert an meinem linken Handgelenk.“

„Genau.“

„Oder am Handgelenk.“

„Und wenn ich jetzt die Demo starte ...“

„Es vibriert an meinem linken Handgelenk.“

„Genau.“

Entwickler Michael Grandl hat ein Smartphone in der Hand. Je nachdem wie stark er es neigt, verändert sich die Vibration.

„Wenn ich jetzt das Smartphone neige ...“

„Jetzt wandert die Vibration nach rechts ...“

„Genau, die Vibration wandert nach rechts. Jetzt haben wir ein langsames Ticken. Und je stärker die Neigung ist – man hört's vielleicht auch – desto stärker wird die Vibration, desto kürzer die Pulse. Bis zum 90-Grad-Winkel, dann würde es durchgängig vibrieren, wie man es auch hört.“

„Würde ich jetzt interpretieren als ‚jetzt scharf rechts abbiegen‘.“

„Ja, also wenn jetzt das durchgängig vibriert, dann sollte man sich auf der Stelle drehen, genau. Das heißt: Achtung Hindernis, bitte wenden. Genau.“

„Jetzt wandert die Vibration nach rechts ...“

„Genau, die Vibration wandert nach rechts. Jetzt haben wir ein langsames Ticken. Und je stärker die Neigung ist – man hört's vielleicht auch – desto stärker wird die Vibration, desto kürzer die Pulse. Bis zum 90-Grad-Winkel, dann würde es durchgängig vibrieren, wie man es auch hört.“

„Würde ich jetzt interpretieren als ‚jetzt scharf rechts abbiegen‘.“

„Ja, also wenn jetzt das durchgängig vibriert, dann sollte man sich auf der Stelle drehen, genau. Das heißt: Achtung Hindernis, bitte wenden. Genau.“

Natürlich soll bei dem fertigen System nicht ein Mensch den Blinden fernsteuern, sondern Apps sollen die Vibrations-muster direkt an das Armband übertragen. Blinde sind die wichtigste Zielgruppe für Vibrotac, aber seit die Forscher eine Studie mit einer anderen Personengruppe gemacht haben, sind sie erst recht davon überzeugt, auf dem richtigen Weg zu sein.

„Zum Beispiel haben wir Versuche mit Fluglotsen gemacht, über Vibrationen die Aufmerksamkeit auf bestimmte Ereignisse zu lenken. Und man hat festgestellt, dass dieser Vibrationskanal im Gehirn parallel verarbeitet wird. Das heißt, Sie haben volle visuelle Aufmerksamkeit, auditive Aufmerksamkeit und zusätzlich haben Sie den Vibrationskanal.“

Smartphones sind für Blinde zu einer Schlüsseltechnologie geworden. Sie sind der Schlüssel zur Welt. Die Abhängigkeit von teuren Spezialhilfsmitteln nimmt ab, erschwingliche Consumerprodukte sind die Plattform für spezielle Apps und Zusatzgeräte, die einen Bruchteil dessen kosten, was vor der Smartphone-Ära für Hilfsmittel ausgegeben werden musste. Das nächste Kapitel wird in einigen Jahren aufgeschlagen werden, wenn eine weitere, eigentlich für Sehende gedachte Technik verfügbar wird: Selbstfahrende Autos könnten Blinde dann noch eigenständiger machen.