Es gibt derzeit einen eindeutigen Marktführer bei Chips für Künstliche Intelligenz-Anwendungen (KI-Anwendungen).

Und so sieht man dort die Sache - Mark Hamilton vom Grafik-Prozessor-Entwickler Nvidia: "Das ist einer der Gründe für unseren Erfolg: Viele Programmierer mögen auch Computer-Spiele. Und jeder Grafik-Prozessor kann auch als neuronales Netz programmiert werden."

Es hat sich halt irgendwie so ergeben. Von Hause aus ist Nvidia eigentlich ein Ausrüster für Computer-Spieler. Aber Grafikprozessoren, wie die sie benötigen, bestehen aus vielen unabhängigen, mit einander vernetzten Recheneinheiten. Und die lassen sich eben auch zu künstlichen neuronalen Netzen verschalten.

Konkurrenz am Markt für KI-Anwendungen

Als vor ein paar Jahren KI-Anwendungen aufgekommen sind, war denn auch Nvidia schon mit passender Hardware im Markt. Jetzt aber entsteht Konkurrenz.

"Wir haben zur Zeit eine wunderbare Situation, in der mehrere Hersteller in diesen Markt der spezialisierten KI-Chips hineingehen", so Dr. Damian Borth vom Deutschen Forschungszentrum für künstliche Intelligenz.

Die Anforderungen an KI-Chips sind sehr unterschiedlich, sagt er, je nachdem ob ein neuronales Netz gerade lernt oder das Gelernte nutzbringend einsetzt.

"Wir haben bei der Anwendung von tiefen neuronalen Netzen und beim Trainieren zwei verschiedene Modi."

Lernen und Nachtrainieren

Und dabei gilt: Gelernt ist gelernt. Die produktive Anwendung eines trainierten neuronalen Netzes ist keine große Sache mehr. Aber bis es erst einmal soweit ist. Dem Netz etwas beizubringen, das Training oder das Lernen, es verlangt einen immensen Rechenaufwand.

"Was man hier nimmt, sind oft Chips wie Graphical Processing Units, GPUs die im Rechenzentrum stehen, de auf großen Datenmengen trainiert werden über Stunden, wenn nicht Tage."

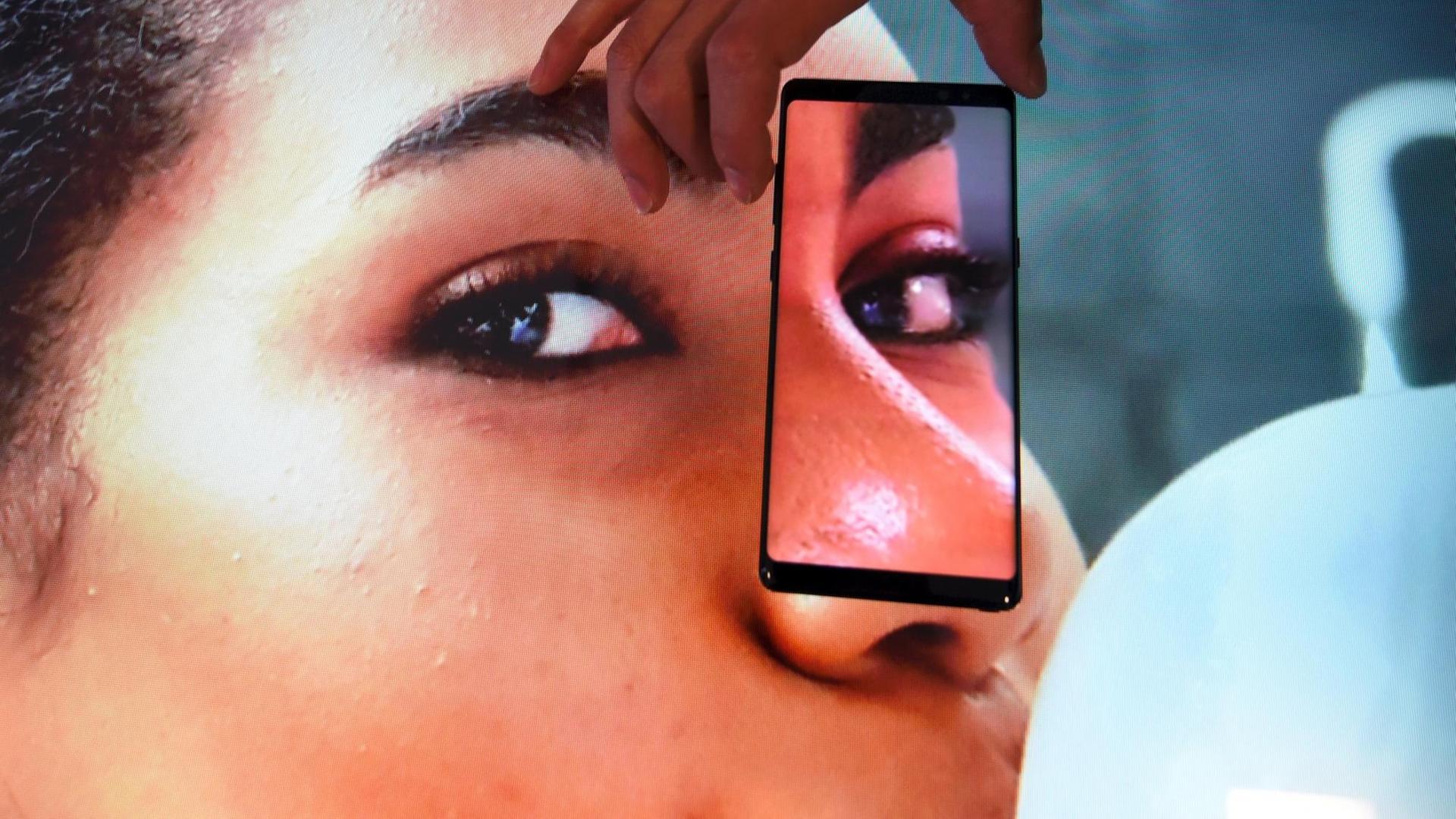

Und das kostet Strom. Wenn neuronale Netze in Form von massiv parallelen Prozessoren etwas Neues lernen, so geschieht dies fast immer in der Cloud - oder weniger wolkig formuliert - in Rechenzentren mit optimierter Energieversorgung. Anwenden hingegen lässt sich künstliche Intelligenz auch mit dem Smartphone. Beispielsweise dann, wenn selbiges das Gesicht seines Besitzers erkennt und sich entsperrt. Und ein bisschen was dazulernen können die relativ schwachen KI-Chips in Handys auch noch. Nachtrainieren nennt das Dr. Damian Borth.

"Nachtrainieren bedeutet: Man nimmt das neuronale Netz und gibt diese Bilder, die man selbst mit dem Handy von sich gemacht hat, in das Netzwerk. Und das muss nicht Millionen von Bildern überhaupt trainieren, weil es ja schon ein Verständnis von Gesichtern hat. Sondern mit diesen wenigen Bildern wird es quasi nachtrainiert. Ein paar von den Gewichten im neuronalen Netz werden dann so modifiziert, dass das individuelle Gesicht erkannt wird mit den wenigen Bildern, die man von der Person gemacht hat."

Gewaltige Rechenleistung

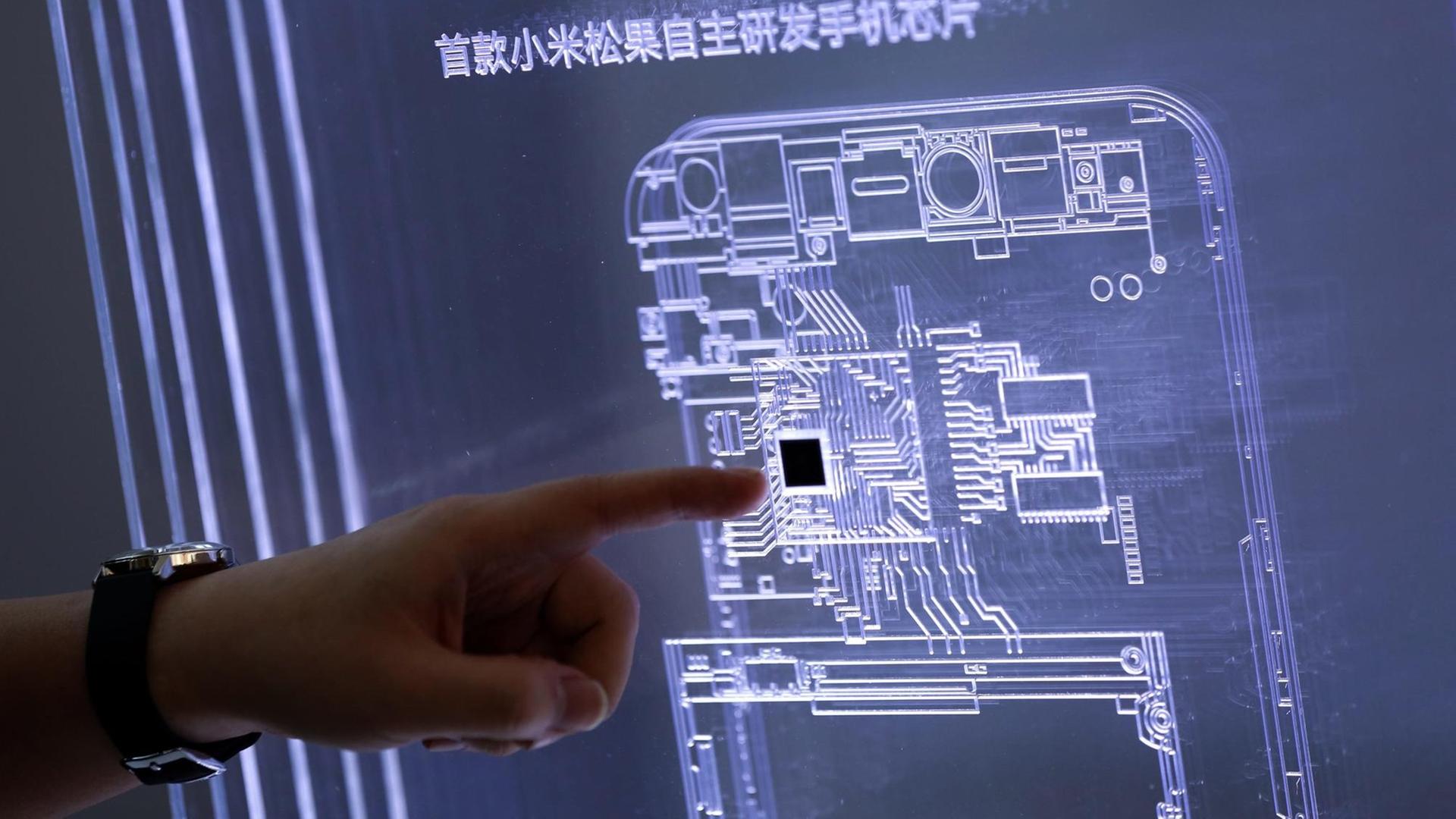

Apple und die chinesische Huawei haben neuronale Netze in ihre Smartphone-Prozessoren integriert. Intel, Samsung und etliche Start-ups arbeiten an entsprechenden Chips. Und Sundar Pichai hat bei der diesjährigen Entwicklerkonferenz Googles neue KI-Prozessoren mit einer gewaltigen Rechenleistung für die Cloud freigeschaltet

"Jede Platine bringt es auf 180 Billionen Gleitkommma-Berechnungen pro Sekunde. Wir haben sie Cloud-TPUs genannt, weil wir sie über das Internet nutzbar machen. Sie gehören seit heute zur Google Compute Engine im Netz."