Für die Vorhersage von Verbrechen nutzt die Polizei in den USA Software. Berechnet werden soll damit, wo in Zukunft Verbrechen begangen werden. Viele Mathematiker und Mathematikerinnen kritisieren das jetzt in einem offenen Brief. Die Algorithmen, die momentan existieren, basierten darauf, dass sie ihre Vorhersagen damit trainieren, auf alte, rassistische Daten zu schauen, kritisierte Mathematiker Katrin Wehrheim von der Universität Berkeley im Dlf.

Sophie Stigler: Ein kaputtes Rücklicht, ein angeblich falscher Geldschein – sowas ist ein Fall für die Polizei, aber eigentlich kein Grund für große Aufregung. Und doch sind bei solchen Einsätzen in den USA Menschen gestorben, schwarze Menschen. Durch Polizisten. Die Wut über solche Vorfälle lässt in den USA auch Menschen politisch aktiv werden, von denen man es nicht unbedingt erwarten würde: Mathematiker und Mathematikerinnen.

Sie rufen dazu auf: Arbeitet nicht mehr mit der Polizei zusammen. Unterschrieben hat auch Katrin Wehrheim, Professor für Mathematik an der Uni Berkeley und Teil der Gruppe, die den Brief veröffentlicht hat. Professor Wehrheim, Mathematiker und die Polizei bringt man vielleicht erstmal nicht so zusammen. Was ist das für eine Zusammenarbeit, die jetzt einige stoppen wollen?

Katrin Wehrheim: Die Zusammenarbeit von Mathematik und Staatsgewalt ist eigentlich seit dem Zweiten Weltkrieg sehr intim. Es kommt auch sehr viel von unserem Geld in der Mathematikforschung aus Rüstung und Polizei. Die speziellen Algorithmen, die wir hier ansprechen in dem Brief, sind die sogenannten Polizeivorhersagen. Und für uns ist das sicher nicht das größte Problem der Polizeibrutalität in den USA, aber es ist einfach ein Teil.

Stigler: Sie sagen, Polizeivorhersagen, also gemeint ist Predictive Policing, das heißt, man greift auf Statistiken zurück, …

Wehrheim: Genau.

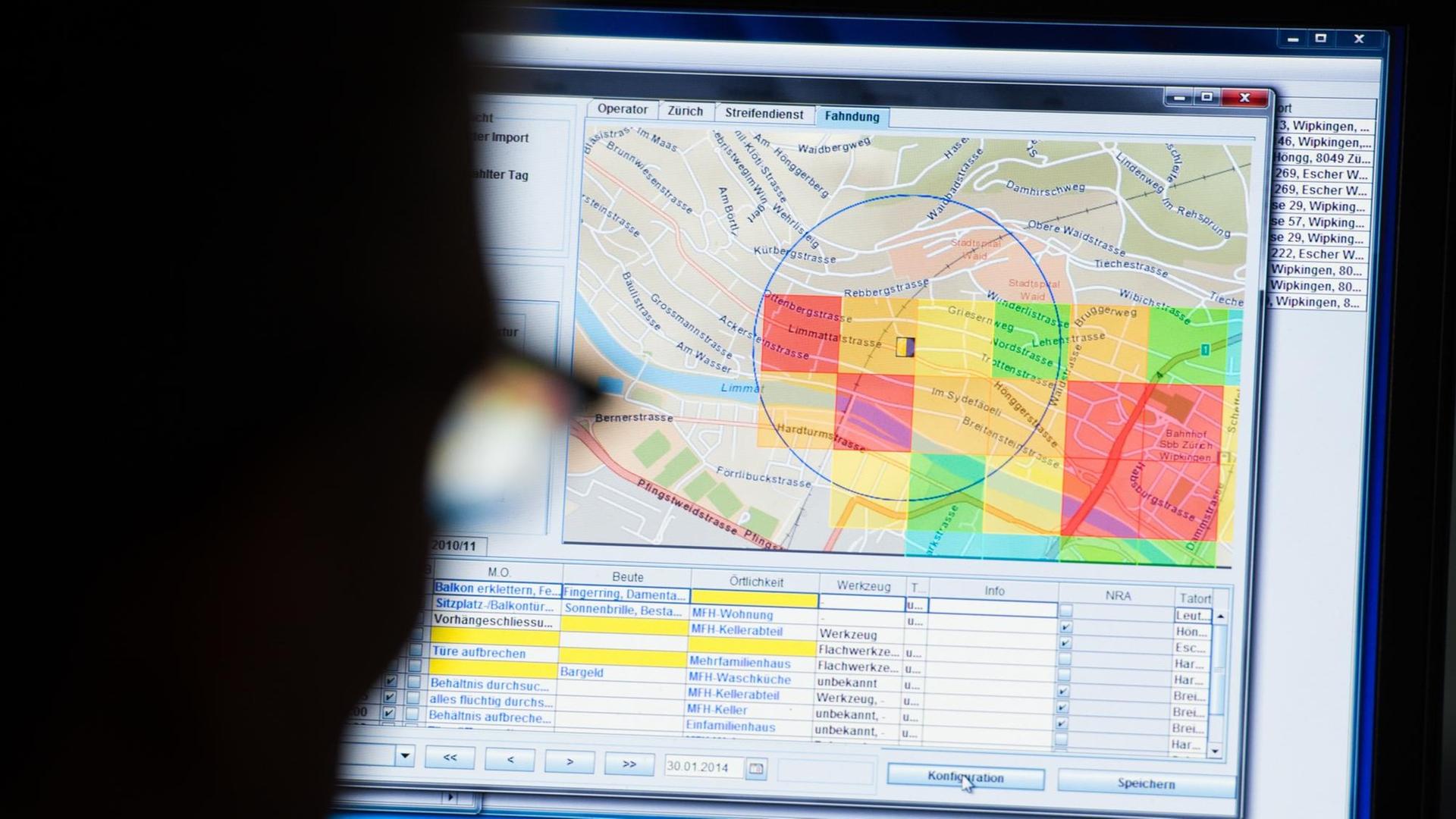

Stigler: … um Verbrechen vorherzusagen, bevor sie passiert sind, also: Wo findet der nächste Einbruch statt, wer wird vielleicht am ehesten rückfällig? Das wird in den USA ganz viel eingesetzt, aber eben auch in Deutschland in kleineren Projekten. Wo genau sehen Sie da die Probleme?

Wehrheim: Ja, Algorithmen, Mathematik ist erst mal sehr gut darin, den überliegenden Prozessen einen Anschein der Objektivität zu geben. Aber letztlich sind diese Algorithmen immer nur so gut wie die Theorie, die dahintersteckt. Und im Fall von der Vorhersage von, wo denn jetzt Kriminalität passieren mag, ist die Theorie dahinter extrem problematisch.

Kriminalität vorhersagen wie Erdbeben

Stigler: Inwiefern?

Wehrheim: Wenn wir uns jetzt mal keine Angst machen lassen von den Formeln und den schwierigen Worten, die Mathematikmenschen benutzen, um diese Algorithmen zu erklären, ist die Theorie im Grunde, dass Kriminalität sich wie Erdbeben verhält. So. Erdbeben passieren im Wesentlichen wieder da, wo vorher Erdbeben passiert sind, geographisch versetzt, ein bisschen zeitversetzt. Und was man dann im Grunde macht, ist, dass man diese sehr banale Theorie in künstliche Intelligenz und große Datenverarbeitung reinsteckt und alte Daten benutzt, um diesen Algorithmus und die Vorhersage besser zu machen. Dann nehmen wir die alten Polizeidaten, schauen, wo sind denn Festnahmen passiert, warum, und dann trainieren wir unseren Algorithmus damit.

Und dann wird dieser Algorithmus diesen Rückkoppelungseffekt produzieren, indem die Polizei wieder in genau die gleichen Gegenden geschickt wird, wo mehr schwarze Menschen leben. Also die Polizei steht dann irgendwo an der Ecke, weil die Vorhersage war, dass da jetzt wieder irgendwie vielleicht ein Gewaltakt passiert. Und wenn da nichts passiert, dann werden Provokationen passieren, aufgrund von denen dann Kriminalität künstlich erzeugt wird.

Stigler: Also im Prinzip sagen Sie, ein Erdbeben ist ein Erdbeben, das passiert, ob man hinguckt oder nicht. Bei Verbrechen ist es ein bisschen anders: Wenn ich mehr hingucke, finde ich auch mehr. Das ist sozusagen der Fehler im System, oder?

Wehrheim: Genau. Also es gibt da viele Statistiken, dass schwarze Menschen zwei Mal so häufig verkehrsgestoppt werden als weiße, aber das ist letztlich die Realität hier.

Was rauskommt, sei rassistisch

Stigler: Jetzt ist ja ein richtiger Polizeiboykott eine Sache. Man könnte auch sagen, warum helfen Sie nicht, die Systeme, die Algorithmen so zu verbessern, dass man den Rassismus sozusagen rausrechnen kann? Wäre so was möglich?

Wehrheim: Ich kann nicht grundsätzlich sagen, dass das unmöglich ist. Aber ich kann Ihnen sagen, dass es komplett unmöglich ist, mit den Algorithmen, die momentan existieren. Die Algorithmen, die momentan existieren, basieren darauf, dass sie ihre Vorhersagen damit trainieren, auf alte Daten zu schauen. Und in den USA sind die alten Daten extrem rassistisch. Das heißt, egal, wie ich jetzt da noch irgendwie schlauere Trainingsalgorithmen, künstliche Intelligenz, irgendwelche Berechnungen reinstecke: Was rauskommt, wird immer zutiefst rassistisch sein.

Äußerungen unserer Gesprächspartner geben deren eigene Auffassungen wieder. Der Deutschlandfunk macht sich Äußerungen seiner Gesprächspartner in Interviews und Diskussionen nicht zu eigen.