Lennart Pyritz: Nächste Woche beginnt in Köln die größte Computerspielemesse der Welt, die gamescom. Schon am kommenden Sonntag senden wir in Wissenschaft im Brennpunkt ein Feature zur Musik in Computerspielen: "Der Ton macht das Spiel – ein Blick in die Labors von Musik für Computergames". Maximilian Schönherr ist der Autor dieses Features, und er ist jetzt bei mir im Studio. Maximilian Schönherr, seit wann gibt es überhaupt Musik in Computerspielen?

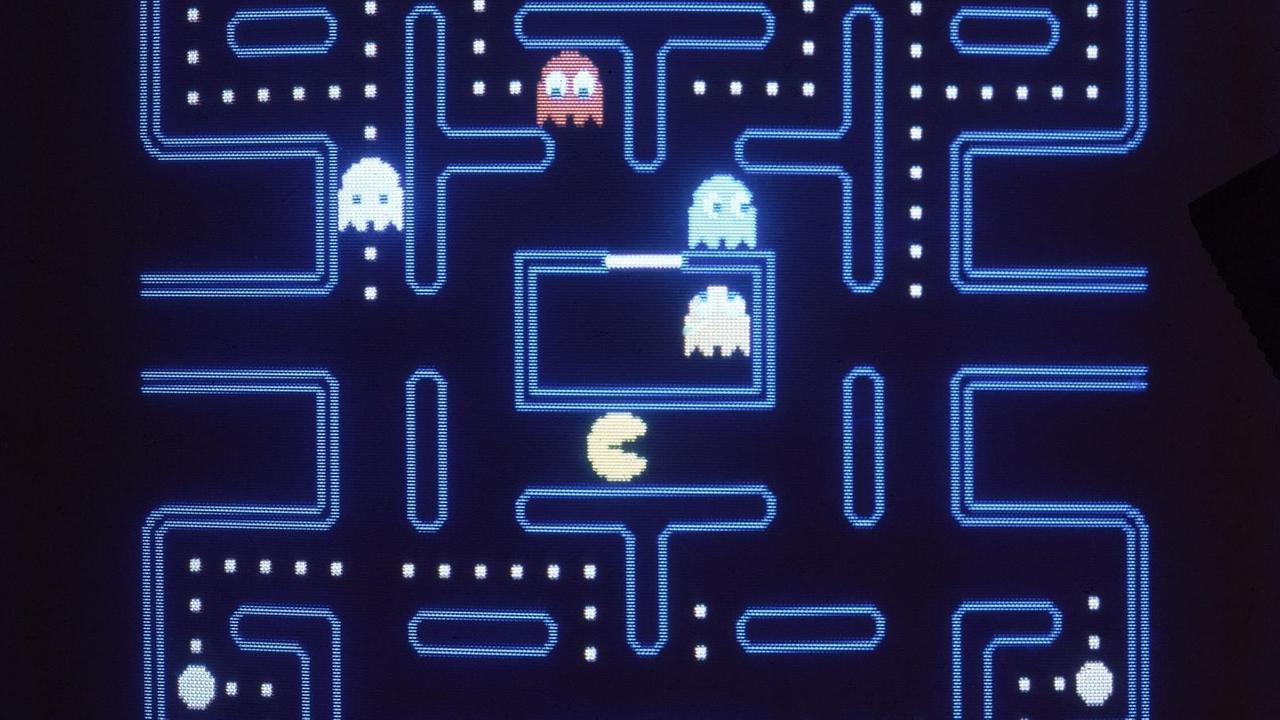

Maximilian Schönherr: Seit "Pac-Man", 1980, komponiert von Toshio Kai. Toshio Kai ist ein japanischer Grafikdesigner, also kein Musiker. Er arbeitete damals für Namco, und die Spielhallen-Konsole, auf der "Pac-Man" lief, war in der Lage, kurze Loops aus im Prinzip Sinus-Wellen wiederzugeben.

Maximilian Schönherr: Seit "Pac-Man", 1980, komponiert von Toshio Kai. Toshio Kai ist ein japanischer Grafikdesigner, also kein Musiker. Er arbeitete damals für Namco, und die Spielhallen-Konsole, auf der "Pac-Man" lief, war in der Lage, kurze Loops aus im Prinzip Sinus-Wellen wiederzugeben.

Auch die späteren Komponisten von Computerspielemusik kamen nicht aus den Musikhochschulen, sondern eher von der Programmierung. 1983 hat ein damals 25-jähriger Hacker live in einer Radio-Sendung solche Musik auf einem C64 Heimcomputer komponiert. Er musste dafür ein Gespür für Polyfonie haben und gab die Akkorde in Form von Programmcodes ein. Der junge Mann aus Kassel ist heute 50, heißt Chris Hülsbeck und gilt als Pionier der Game-Music.

Computerspiele sind nicht linear - ihre Vertonung schwierig

Pyritz: Mit heutigen Musiken in Spielen ist das natürlich nicht vergleichbar. Sie klingen opulent wie Filmmusik. Offenbar komponieren heute Musiker?

Schönherr: Ja, aber es sind schon andere Musiker als die, die die Filmmusik komponieren. Beim Film wird linear komponiert, das Computerspiel läuft eben nicht linear ab. Der Spieler entscheidet. Das hat zur Folge, dass die Musik völlig andere Voraussetzungen erfüllen muss als Filmmusik. Wenn der Spieler eine Szene durchspielt, lauert im Hintergrund quasi eine ganze Palette an Musiken. Dreht er, statt weiter zu gehen, nach rechts um, wo der Wald aufhört und das Schloss zu sehen ist, startet eine andere Musik, vielleicht eine dramatischere Musik. Der Komponist muss also in Ebenen denken, denn die Schloss-Sequenz darf sich ja mit der Wald-Musik nicht beißen, sie muss zum Beispiel von der Tonart her stimmen.

Die Audio-Engine passt den Sound automatisch der Situation an

Pyritz: Was läuft bei einem solchen Wechsel im Rechner ab?

Schönherr: Bei einem Computerspiel gibt es zwei Programmmodule, die sich dauernd die Hand geben: Die Game Engine, die das Spiel treibt, also zum Beispiel der Grafikkarte sagt, wenn der Spieler den Controller nach rechts drückt, muss der Wald aufhören und das Schloss auftauchen. Und die Audio-Engine, die die Musiken und Sound Effekte dazu liefert. Diese Verzahnung wurde in den letzten Jahren immer feiner. Heute ist es kein Problem mehr, der Musik eine andere Note zu geben, wenn die Elfe durch den Wald streift, und nicht der Schlächter. Weil die meisten Spiele gemeinsam gespielt werden können, mischen die Spieler quasi die Musik automatisch zusammen. Wenn fünf Helden zusammen losziehen, werden zum Beispiel tiefe Trommeln und spitze Trompeten erklingen, weil jeder seine Musik mitbringt.

Pyritz: Ändern die Virtual-Reality-Spiele, die jetzt erscheinen, an dieser Methode grundsätzlich etwas?

Schönherr: An der vielschichtigen Kompositionstechnik nicht, aber massiv, was die Stereofonie angeht. Hier läuft im Moment viel Forschung. Es geht ja darum, dass sich der Spieler, mit der VR-Brille vor den Augen, umdreht, weil ein Geräusch von hinten kommt. Wenn er sich umgedreht hat, muss das Geräusch von vorn kommen. Mit klassischer Stereofonie ist das nicht zu machen, weil sie nur rechts und links bietet. Aber durch das Ausmessen von Ohrmuscheln und der Simulation von Frequenzänderungen zwischen hinten und vorn, oben und unten, geht das inzwischen ziemlich gut. Es ist nur ein ganz erheblicher Programmieraufwand, dieses sogenannte "Tracking" der Kopfbewegungen binaural in Echtzeit umzusetzen.