Apple möchte sich in Zusammenarbeit mit der US-amerikanischen nichtstaatlichen Kinderschutz-Organisation National Center for Missing and Exploited Children (NCMEC) gegen die Verbreitung von Bildern und Filmen einsetzen, auf denen sexuelle Gewalt gegen Kinder zu sehen ist, sogenanntes "Child Sexual Abuse Material" (CSAM).

Dafür will Apple Bilder mit einem technisch anspruchsvollen Verfahren auf ihre Inhalte prüfen. Wenn es hier eine gewisse Anzahl an Treffern gibt, sollen Menschen das Material sichten. Handelt es sich dann tatsächlich um Missbrauchsbilder, sollen über die Kinderschutzorganisation die Behörden alarmiert werden.

Bei in der Cloud gespeicherten Inhalten passiert so eine Art Scan bereits - beispielsweise bei Google und Microsoft. Das wirklich Neue bei ist nun also der Scan direkt auf den Geräten der Nutzenden.

Wie genau funktioniert das und was ist technisch das Problem, an dem sich jetzt die Kritik entzündet?

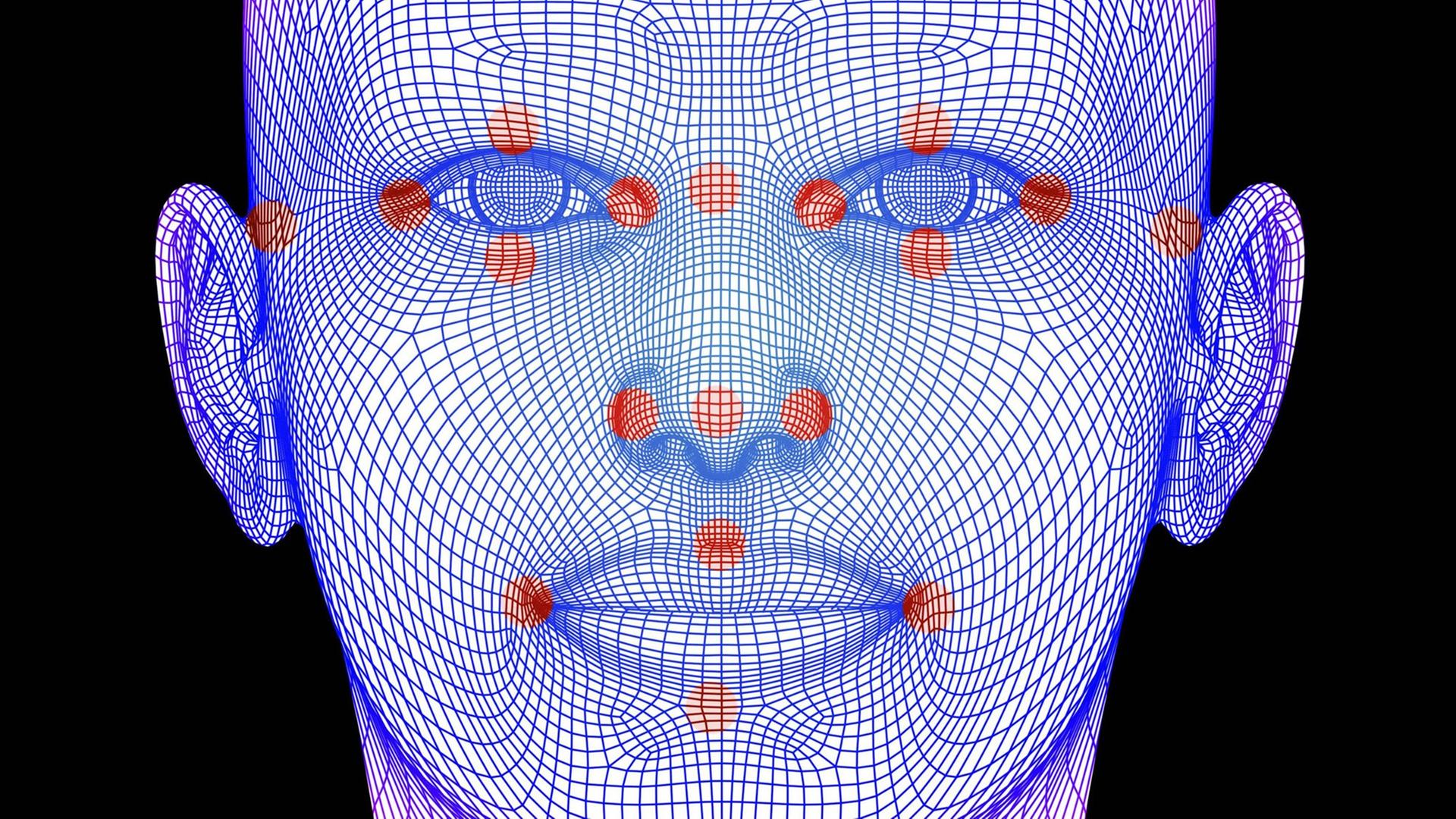

Das NCMEC liefert sogenannte Hashwerte von Missbrauchsfotos. Ein Hashwert ist quasi ein digitaler Fingerabdruck eines solchen Bildes: eine Zeichenkette, die anhand der Bildeigenschaften errechnet wird und die nicht zu einem Bild zurückgerechnet werden kann. Die Sammlung der Hashwerte wird direkt auf iPhone und iPad mit den "Fingerabdrücken" der dort gespeicherten Bilder abgeglichen. Bei mehr als 30 Treffern wird dann eine Kontroll-Kette in Gang gesetzt.

Das Problem ist, dass es bei den Hashwerten je nach Verfahren sogenannte Kollisionen geben kann. Das heißt: Zwei völlig verschiedene Bilder können den gleichen Fingerabdruck haben. Ein weiteres, noch viel schwerwiegenders Problem ist aber: Apple kann nicht sicher ausschließen, dass künftig nicht eventuell Hashes ganz anderer Bildinhalte abgeglichen werden - auch wenn der Konzern jetzt betont, es gehe ausschließlich um Missbrauchsfotos.

Es wird befürchtet, dass Apple nach beliebigen Bildinhalten oder Bildinformationen wie Aufnahmeort und -zeit sucht. Zudem lässt sich die Suche technisch auch nicht sicher nur auf Bilder beschränken. Viele Kritiker sprechen darum von einem "Dammbruch".

Wenn die Geräte an sich nicht mehr sicher sind und ohne Eingriffsmöglichkeit der Nutzenden nach Material suchen und das melden, dann würden Smartphone und Tablet endgültig zu mobilen Wanzen zur Totalüberwachung der Nutzenden, beispielsweise durch totalitäre Regime, so die Kritik.

Ja, absolut. Der Wettstreit zwischen Privatsphäre und Überwachung tobt seit Jahrzehnten. Mailverschlüsselung, Verschlüsselung des Datentransports und noch viel mehr Ansätze zum Schutz der Privatsphäre wurden etabliert. Mit Staatstrojanern und jetzt mit dem CSAM-Scanner werden aber immer neue Wege etabliert, dagegen vorzugehen.

Wenn nun die Geräte ihre Nutzenden kontrollieren und diese nichts dagegen tun können, ist davon abzuraten, diese Geräte noch zu benutzen. Denn niemand kann Journalisten, Anwälten, Priestern, Menschenrechtlerinnen oder auch einfach rechtsschaffenden Bürgerinnen garantieren, dass nicht noch nach ganz anderen Inhalten als CSAM gesucht wird.

Darüber hinaus werden Kriminelle, die Bilder von Kindesmissbrauch haben und teilen wollen, auch wieder Wege am Scan-Tool vorbei finden. Und die eigentlich Betrogenen sind die Nicht-Kriminellen.

Aktuell heißt es, dass Apple mit der nächsten System-Version auch den Scanner für iPhone und Tablet einführt - vorerst aber nur für Nutzende in den USA. Der Konzern hat betont, dass er die Technik komplett transparent machen will, und erste Organisationen haben bereits angekündigt, sehr genau hinschauen zu wollen.

Allerdings ist der Gegenwind, der Apple trifft, derzeit sehr stark. Und es ist nicht ausgeschlossen, dass Apple die Funktion ersatzlos zurückzieht. Das Unternehmen hat schließlich auch einen mühsam aufgebauten Ruf zu verlieren, besonders Privatsphäre-schützend und sicher zu sein. Mit dem CSAM-Scanner wäre das schlagartig vorbei – trotz aller Beteuerungen.