Manfred Kloiber: Die Quantentechnologie ist zur Zeit eines der Lieblingsthemen der IT-Visionäre. Darunter versteht man Technologien, die sich die bizarren Effekte der Quantenwelt zunutze machen mit dem Ziel, hochparallel arbeitende Supercomputer zu entwickeln. Oder auch neuartige Kommunikationskanäle via Internet zu schaffen, die absolut abhörsicher sind. Lange Zeit traf man bei Veranstaltungen zum Thema Quantentechnologie vor allem auf Grundlagenforscher von Universitäten oder Max-Planck-Instituten. Doch das hat sich geändert. Bei einem Symposium, zu dem der Münchner Kreis am Donnerstag geladen hatte, da wurden auch viele Industrievertreter unter den Referenten und rund 200 Gästen gesichtet. Mein Kollege Ralf Krauter war auch dabei. Ralf, wittern da die Industrievertreter inzwischen Morgenluft mit neuen Geschäftsfeldern?

Ralf Krauter: Definitiv. Also dass sich da Umbrüche anbahnen, die die IT-Branche umkrempeln werden, war unter den versammelten Experten unstrittig. Konzerne wie Google, IBM, Intel, Toshiba und Microsoft investieren ja massiv in die Entwicklung von Quantencomputern. Die Frage ist nur: Auf welchen Zeitskalen ist da jetzt mit bahnbrechenden Innovationen zu rechnen, die dann wirklich auch lukrative neue Geschäftsmodelle ermöglichen. Bei der abhörsicheren Kommunikation mittels Quantenkryptographie rechnen Fachleute in den nächsten 5 Jahren mit neuen kommerziellen Anwendungen, um etwa vertrauliche Firmendaten langfristig vor fremdem Zugriff zu schützen. Beim Quantencomputer, dem ‚heiligen Gral’ der neuen Quantentechnologien, war der Tenor eher, dass der wohl noch 10 Jahre entfernt ist. Das sagte zum Beispiel Astrid Elbe, Entwicklungschefin Europa beim Chiphersteller Intel. Und auch Ingolf Wittmann, der bei IBM für Quantencomputer zuständig ist, äußerte sich in München ähnlich.

Quantencomputer sind Superrechnern überlegen

Kloiber: Aber einen Hype, den gibt es definitiv. Der wird nämlich befeuert nicht zuletzt durch Google, wo ein Forscherteam noch in diesem Jahr den Beweis antreten will, dass Quantencomputer konventionellen Superrechnern nicht nur theoretisch, sondern auch praktisch überlegen sind.

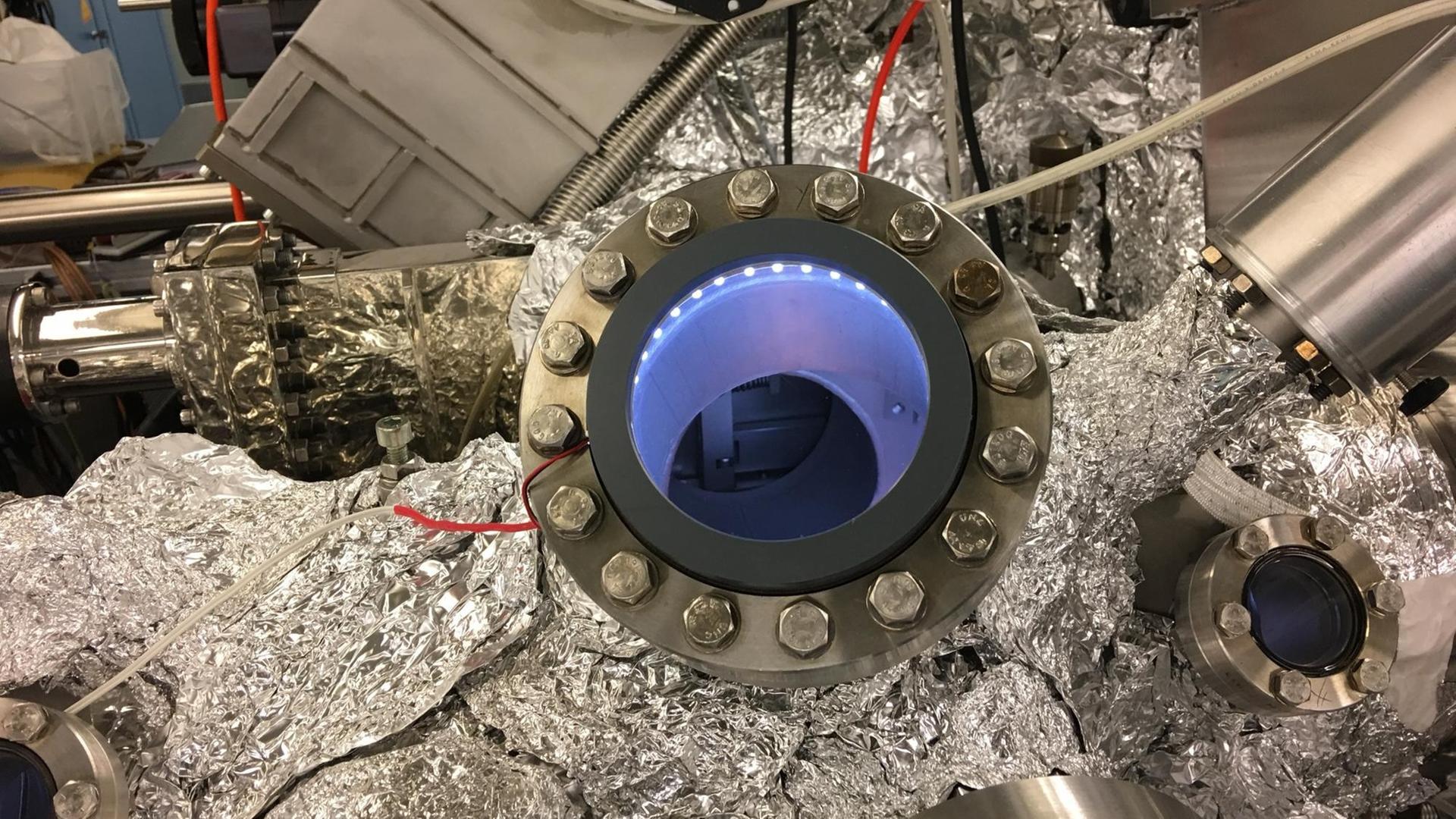

Sprecherin: Im Frühjahr präsentierten die Entwickler von Google Research ihren neuesten Quantenprozessor. Sein Name: Bristlecone. Sein Herzstück: 72 supraleitende Leiterschleifen, die als so genannte Quantenbits fungieren. Auf wenige Tausendstel Grad über dem absoluten Nullpunkt gekühlt, sollen diese 72 Qubits Bemerkenswertes zuwege bringen. Sie sollen eine Rechenaufgabe lösen, an der sich konventionelle Supercomputer bislang die Zähne ausbeißen. Wenn die Demonstration gelingt, wäre das der lang erhoffte Beweis, dass Quantencomputer klassischen Rechnern bei der Lösung bestimmter Probleme tatsächlich haushoch überlegen sind.

Professor Tommaso Calarco, Direktor des Instituts für komplexe Quantensysteme an der Universität Ulm, war vor zwei Monaten in Santa Barbara und hat sich den Stand der Entwicklung angesehen. Sein Eindruck: Die Chancen, dass das Team von Google-Research sein Ziel noch in diesem oder spätestens im nächsten Jahr erreicht, stehen gut:

„Das heißt aber immer noch nicht, dass diese Anwendungen jetzt sofort das Computing revolutionieren. Selbst der Chef des Google Labs, John Martinis, hat deutlich gesagt: Das ist wissenschaftlich sehr aufregend, ist aber für die Lösung von einem nutzlosen Problem. Das ist ein Problem, das sehr speziell ist, aber dafür gemacht, dass man zeigt: Das ist etwas, was ein Quantencomputer machen kann und kein klassischer Computer.“

Quantenregister könnte mehr Zahlen speichern als die Summe aller Atome

Dass der Nachweis dieser Quanten-Überlegenheit einem Prozessor mit wenigen Dutzend Informationseinheiten gelingen könnte, hängt mit deren erstaunlichen Eigenschaften von Quantenbits zusammen. Während ein klassisches, digitales Bit entweder den Wert Null oder Eins hat, kann ein Qubit beide Werte gleichzeitig annehmen – wie eine Münze im Flug, die sowohl Kopf als auch Zahl repräsentiert und erst beim Aufprall auf eins von beiden festlegt wird. Der Vorteil: Während ein PC mit 16 klassischen Bits nur einen von 65536 Werten kodieren kann, kann ein Rechner mit 16 Qubits alle 65536 Werte gleichzeitig verarbeiten. Ein Quantenregister mit nur 250 Qubits könnte theoretisch mehr Zahlen gleichzeitig speichern als es Atome im Universum gibt.

Doch es gibt ein Problem: Schon die kleinste Störung beendet den fragilen Überlagerungszustand der Qubits, deshalb müssen sie akribisch vor Umwelteinflüssen geschützt werden. Bei mehr als einigen Dutzend ist das noch keinem gelungen. So testen IBM und Intel aktuell Quantenprozessoren mit gerade mal 50 Qubits. Für Probleme mit praktischer Relevanz viel zu wenig:

„Für eine praktische Umsetzung, die dann für Verbraucher von Nutzen sein könnte, müssen wir schon noch warten, dass Tausende, vielleicht Millionen von Quantenbits da sind. Was prinzipiell möglich ist, es gibt aber große ingenieurwissenschaftliche Herausforderungen, die beherrscht werden müssen, bevor das der Fall sein kann.“

Noch ist unklar, welche Technologieplattform das Rennen macht

Mit welchen Technologieplattformen sich künftig einmal Ensembles von zigtausend oder Millionen Qubits realisieren lassen, das ist derzeit noch völlig offen. Aktuell haben die supraleitenden Leiterschleifen die Nase vorn. Auf sie setzen neben Google auch IBM und Intel. Doch die Kühlung supraleitender Quantenbits ist aufwändig und ihre Ansteuerung über Mikrowellenantennen so komplex, dass die Technik wohl nur begrenzt skalierbar, also ausbaubar ist. Intel und andere arbeiten deshalb parallel an so genannten Spin-Qubits, bei denen isolierte Elektronen in speziellen Halbleiterstrukturen als Informationsspeicher dienen. Dieser Ansatz steckt noch in den Kinderschuhen, wäre aber leichter skalierbar und kompatibel mit klassischer Silizium-Halbleitertechnologie.

Kloiber: Also, die Rechenaufgabe, die das Team von Google Research noch dieses Jahr mit seinem Quantenprozessor zu lösen hofft, ist eher akademischer Natur. Ralf, wann könnten sich Quantencomputer denn erstmals ernst zu nehmenden Aufgaben von gesellschaftlicher Relevanz vornehmen?

Krauter: Die 10 Jahre, die Astrid Elbe von Intel in München genannt hat, spiegeln auch die Erwartungen anderer Experten wieder und finden sich so zum Beispiel auch in der europäischen Technologie-Roadmap, die Grundlage des milliardenschweren EU-Flagschiff-Projektes zur Quantentechnologie, das übrigens vom eben gehörten Tommaso Calarco initiiert wurde.

Ein universeller Quantencomputer wäre ein ‚Game Changer‘

In 10 Jahren könnte ein universeller Quantencomputer einsatzreif sein. Also eine programmierbarer Quantenprozessor, mit einigen hundert logischen Qubits, der alle erdenklichen Aufgaben lösen könnte. Zum Beispiel heutige Verschlüsselungscodes knacken, mit Hilfe des Shore-Algorithmus zur Primfaktorzerlegung großer Zahlen. Oder unsortierte Daten durchforsten, mit Hilfe des Grover-Algorithmus. Ob in der Material- oder Pharmaforschung, bei der Risikoanalyse im Bankensektor oder der Optimierung von Verkehrsströmen: So ein universeller Quantencomputer wäre ein ‚Game Changer‘, also ein Erdbeben, das die IT-Branche ordentlich durchrütteln würde.

Kloiber: Sie sagen, einige 100 Qubits würden wohl schon reichen, um eine neue Ära des Computing einzuläuten, Tommaso Calarco sprach von Quantenprozessoren mit Tausenden oder sogar Millionen Qubit. Was stimmt denn nun?

Krauter: Einige hundert logische Qubits wären wohl genug für einen revolutionären Quantenrechner. Die Qubits, die es heute gibt, sind aber alles andere als perfekt und die Rechenprozesse damit deshalb fehleranfällig. Diese Fehler muss man korrigieren – und das ist bei Quantencomputer viel aufwändiger als bei klassischen Computern.

Quantenfehlerkorrektur ist eine große Herausforderung

Experten gehen aktuell davon aus, dass man hundert bis tausend zusätzliche Qubits braucht, um aus einem realen Qubit ein präzise arbeitendes logisches Qubit zu machen. Und dieser riesige Overhead steigert den Aufwand, den man treiben muss enorm. Weshalb die Reduktion der Fehlerraten und die Suche nach effizienteren Mechanismen zur Quantenfehlerkorrektur gerade beispielsweise bei IBM Top-Priorität hat.

Kloiber: Wenn die großen Konzerne, wie IBM, Google und Intel einräumen, dass ein universeller Quantencomputer noch bis zu 10 Jahre entfernt ist, wie ist dann der aktuelle Hype um Quantencomputer zu erklären?

Krauter: Es gibt niedrig hängende Früchte, die man auf dem Weg schon ernten kann. Quantenprozessoren mit einigen Dutzend Qubits, die als Prototypen schon getestet werden, könnten durchaus schon hilfreich sein, um Quantensysteme zu modellieren. Stichwort: Quantensimulation. Ingolf Wittman vom IBM Q Network nannte als Beispiel ein Koffeinmolekül. Das ist ein komplexes Molekül, mit 95 Elektronen, das man mit klassischen Computern wohl nie wird simulieren können, weil der Rechenaufwand enorm ist. Ein Quantenprozessor mit 160 Qubits könnte sowas aber modellieren.

Quantensimulationen als erstes Anwendungsfeld – etwa um komplexe Moleküle zu modellieren

Das heißt: Bei der Entwicklung neuer Wirkstoffe in der Pharmaindustrie oder beim Design neuer Materialen, könnte man schon deutlich früher von Quanten-Power profitieren. Auch bei der Portfolio-Optimierung und Risikoanalyse im Finanzsektor sieht IBM erste Einsatzfelder.

Um das Potenzial auszuloten können Mitglieder des IBM Q Networks via Internet heute schon auf tiefgekühlte Quantenprozessoren mit aktuell 20 Qubits zugreifen. Und zu den Nutzern zählt neben Samsung übrigens auch der dt. Daimler-Konzern.

Kloiber: Kommen wir zum Schluss noch auf das kanadische Unternehmen D-Wave zu sprechen, das ja schon seit Jahren kommerzielle Quantencomputer verkauft und aktuell einen Quantenprozessor mit sage und schreibe 2000 Qubits nutzt. Was ist denn davon zu halten?

Krauter: Die wurden anfangs von vielen belächelt. Der Vorwurf lautete: Das ist ja gar kein richtiger Quantencomputer, was ihr da baut. Das hat D-Wave auch längst eingeräumt. Es ist kein universeller, Gate-basierter Quantencomputer, sondern quasi der kleine Bruder davon. Q-Waves Quantenrechner basieren auf dem so genannten Quanten-Annealing. Vereinfacht gesagt präparieren die ein Ensemble von aktuell 2000-Qubits in einem Anfangsszustand und überlassen es dann sich selbst, bis es sich in einem Zustand minimaler Energie eingefunden hat, der dann das Ergebnis der Berechnung verrät. Dieser Ansatz verspricht keine revolutionäre Explosion der Rechenpower, aber offenbar taugt er dennoch, um klassische Optimierungsprobleme effizienter zu lösen, als das heutige Supercomputer können. D-Wave hat sich in der Szene inzwischen durchaus Respekt erworben.