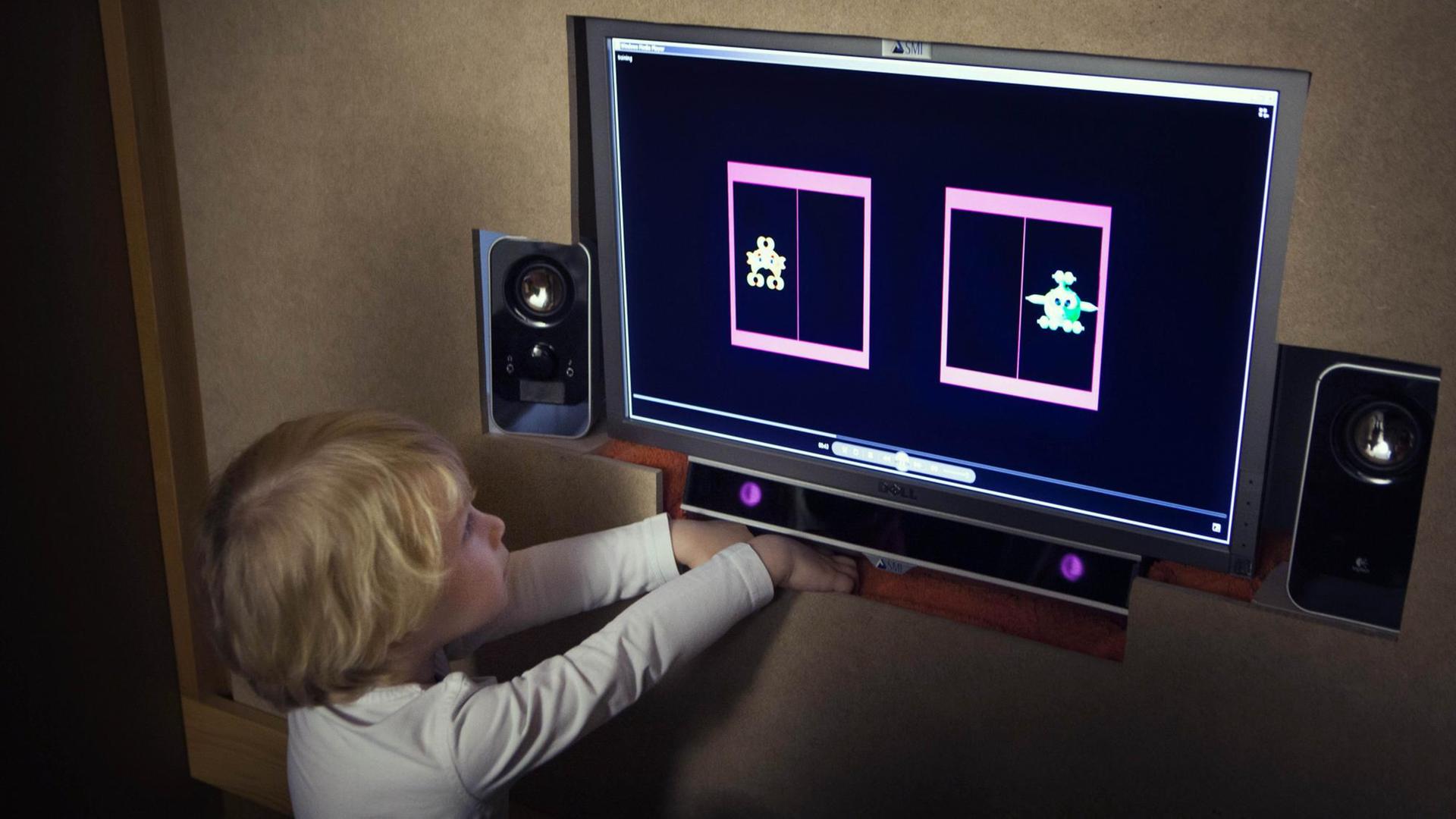

Ein Vorschulkind sitzt alleine in einem Raum, vor sich auf dem Tisch ein Marshmallow. Das Kind überlegt: Es könnte das süße Stück Schaumzucker essen. Oder es könnte warten, bis der Versuchsleiter zurückkehrt mit einem zweiten Marshmallow in der Hand. Das erhält das Kind aber nur, wenn es bis dahin das erste Stück nicht bereits verspeist hat.

Der Marshmallow-Test stammt aus den 1960er- und 70er-Jahren. Er soll nicht nur die Willensstärke und Fähigkeit zur Selbstkontrolle eines Kindes messen. Eine Langzeitstudie aus den 90er-Jahren erklärte, dass diese Eigenschaften auch der Schlüssel zum Erfolg im späteren Leben seien: Kinder, die der Versuchung auf eine schnelle Belohnung widerstehen, würden beispielsweise bessere Bildungsabschlüsse erreichen.

Als US-Forscher im vergangenen Jahr die Studie in leicht abgewandelter Form wiederholten, machten sie eine überraschende Entdeckung: Die Vorhersagekraft des Marshmallow-Tests fiel deutlich geringer aus als in der Originalstudie. Und wenn man den Bildungshintergrund der Kinder berücksichtigte, verschwand der Zusammenhang nahezu vollständig. Die ursprünglichen Ergebnisse waren nicht reproduzierbar. Und das, obwohl Reproduktion, also das Wiederholen von Experimenten zur Bestätigung der Resultate, ein unumgänglicher Bestandteil wissenschaftlichen Arbeitens ist.

"Etwa die Hälfte dessen, was in der Psychologie als Wissen publiziert wird, stimmt scheinbar nicht"

Arndt Reuning: Der Marshmallow-Test gehört zu den bekanntesten Versuchen in der Psychologie. Und deshalb ist dieses Beispiel besonders eindrücklich. Groß angelegte Replikationsstudien legen jedoch nahe, dass es sich dabei bloß um die Spitze des Eisbergs handeln könnte. Wie ist es bestellt um die Wiederholbarkeit von wissenschaftlichen Untersuchungen? Um diese Frage soll es heute gehen.

Mein Name ist Arndt Reuning. Ich heiße Sie herzlich willkommen. Und zugeschaltet aus München ist der Psychologe Dr. Felix Schönbrodt, Privatdozent an der Fakultät für Psychologie und Pädagogik der Ludwig-Maximilians-Universität. Guten Tag!

Felix Schönbrodt: Guten Tag!

Reuning: Herr Schönbrodt, Sie haben mitgewirkt an der jüngsten groß angelegten Replikationsstudie in der Psychologie, Schwerpunkt Sozialpsychologie, an der "Many Labs 2"-Studie. 28 Originalarbeiten hat das Projekt unter die Lupe genommen, hat versucht, sie zu wiederholen. Wie sah denn das Ergebnis aus: Hat sich das bestätigt, dass viele der Arbeiten andere Ergebnisse zeigen, wenn sie dann eben wiederholt werden?

Schönbrodt: Ja, das ist richtig. Es wird oft eine Zahl genannt als Ergebnis. Das sind diese ominösen fünfzig Prozent. Genau die Hälfte dieser 28 Studien konnte repliziert werden, die andere Hälfte nicht. Jetzt muss man dazusagen, dass man die Zahlen nicht überinterpretieren sollte, weil diese 28 Studien nicht zufällig gezogen wurden. Es könnte sozusagen sein, dass diese 28 von vorneherein so ein bisschen fischig aussahen. Das heißt, man kann die fünfzig Prozent nicht unbedingt generalisieren auf die gesamte Psychologie. Wobei man aus anderen Replikationsstudien weiß, die durchaus zufällig die Studien gesampelt haben: Die landen auch so zwischen vierzig und fünfzig Prozent. Das heißt, da bestätigt sich das Bild eigentlich, dass etwa die Hälfte dessen, was in der Psychologie als Wissen publiziert wird und verkauft wird, scheinbar nicht stimmt.

Reuning: Also, um nur nochmal die Dimensionen klar zu machen: Viele Fachleute glauben sogar, eine Replikationskrise der Wissenschaft ausgemacht zu haben. Können Sie das aus Ihrer Sicht bestätigen? Ist das gerechtfertigt, von einer Krise zu sprechen?

Schönbrodt: Ich denke, das hängt von der persönlichen Einschätzung ab, wann man das Wort "Krise" benutzt. Ich muss sagen: Für mich persönlich war das absolut eine Krise.

"Ich dachte mir: Wofür machen wir das denn alles?"

Reuning: Ja, warum?

Schönbrodt: Die Krise hat in der Psychologie so etwa 2011 angefangen einzuschlagen. Da war ich gerade mit meiner Promotion fertig. Und jetzt mit dem Wissen, dass etwa die Hälfte dessen, was wir publizieren, scheinbar nicht stimmt, das hat sich total mit meinem Bild als Wissenschaftler - lag quer dazu. Also, ich hatte wirklich eine persönliche Krise, wo ich dachte: Das ist nicht das, was ich als Wissenschaftler tun will. Ich dachte mir: Wofür machen wir das denn alles?

Reuning: War das dann auch Ihre Motivation, an der "Many Labs 2"-Studie teilzunehmen?

Schönbrodt: Richtig. Ich dachte mir irgendwann: Entweder versuchst du, das System mit zu ändern und es besser zu machen. Oder du gehst raus aus diesem Wissenschaftssystem. Und ich habe mich entschieden, sozusagen für eine bessere Wissenschaft zu kämpfen. Und an dieser "Many Labs 2"-Studie teilzunehmen, war eben einer davon.

Viele Autoren helfen bei der Wiederholung ihrer eigenen Studie

Reuning: Schauen wir uns noch einmal deren Ansatz an. Wie genau wurden denn die Originalarbeiten in diesem Projekt repliziert oder reproduziert?

Schönbrodt: Das war ein sehr standardisiertes Vorgehen. Man hat versucht, mit allen Original-Autoren von den Studien, sofern sie noch greifbar waren, noch leben zum Beispiel, Kontakt aufzunehmen, um die Replikation wirklich so originalgetreu wie nur möglich hinzubekommen. Man hat bei sehr vielen Studien wirklich das Okay der Original-Autoren bekommen, dass sie gesagt haben: Ja, und wenn ihr die Studie so macht, dann sollte dasselbe Ergebnis wieder herauskommen. Dann hat man alle Studien präregistriert. Das heißt, man hat vor der Datenerhebung festgelegt, wie man die Studie genau durchführen möchte, wie man sie auswerten möchte, jede der 28 Studien. Das heißt, da waren keine Freiheitsgrade mehr, sondern es war vorher festgelegt. Und was noch ein Unterschied zu den Originalstudien war, dass die Stichprobengrößen enorm viel größer waren. Also im Durchschnitt waren es vierundsechzigmal so viele Probanden in jeder Studie als in der Originalstudie. Das heißt: Wenn es den Effekt tatsächlich gibt, dann müsste er in der Replikationsstudie auch rauskommen.

Reuning: Wir werden uns gleich den Ursachen für diese Replikationskrise widmen. Aber zuvor werfen wir noch einen Blick in die Niederlande. Dort hat im Jahr 2016 der Drittmittelgeber nwo, etwa vergleichbar mit der DFG hier bei uns, drei Millionen Euro bereitgestellt für Replikationsstudien. Und meine Kollegin Anneke Meyer, die hat sich solch eine Untersuchung zeigen lassen.

Replikationsstudie in den Niederlanden

Effekt oder nicht effekt, das ist hier die Frage

Was wissenschaftlich erwiesen ist, stimmt - leider nicht immer. Studien, die ältere Studien exakt wiederholen, sollen die Zuverlässigkeit von Forschungsergebnissen klären. Das klingt einfacher, als es tatsächlich ist.

Effekt oder nicht effekt, das ist hier die Frage

Was wissenschaftlich erwiesen ist, stimmt - leider nicht immer. Studien, die ältere Studien exakt wiederholen, sollen die Zuverlässigkeit von Forschungsergebnissen klären. Das klingt einfacher, als es tatsächlich ist.

Reuning: Anneke Meyer war das über eine Studie aus den Niederlanden. Herr Dr. Schönbrodt: Wenn eine Studie in der Wiederholung andere Ergebnisse zeigt als in der Originalarbeit, heißt das dann, dass die Daten oder auch die Auswertung in der Originalarbeit falsch gewesen sind? Es könnte ja auch die Replikation selbst falsch sein.

Schönbrodt: Richtig, genau. Zunächst hat man einfach mal nur zwei sich widersprechende Studienergebnisse. Da kann man noch nicht draus schließen, welches sozusagen näher an der Wahrheit liegt. Es gibt verschiedene Qualitätskriterien, die man anlegen könnte, um zu entscheiden: Glaube ich jetzt eher der Originalstudie oder glaube ich eher der Replikationsstudie. Das kann je nach Einzelfall mal in die eine oder andere Richtung schwingen, das Pendel. In vielen Fällen würde ich mittlerweile der Replikation tendenziell mehr Gewicht geben. Zum einen daraus, dass viele Replikationsstudien oft größere Stichproben benutzen als die Originalstudien. Und ein zweiter Grund wäre, dass die Originalstudie eine Präregistrierung für die Replikation darstellt. Das heißt, dass man in der Replikationsstudie wesentlich weniger Freiheitsgrade in der Auswertung hat.

Was bedeutet signifikant?

Reuning: Ja, um die Aussagekraft einer Studie, sagen wir mal in der Sozialpsychologie zu bewerten, gibt es eine Größe, die Signifikanz. Umgangssprachlich meint man damit ja, dass etwas deutlich zu erkennen ist. Also wenn ich sage: Ich bin dreißig Zentimeter größer als meine Frau, dann würde das als ein signifikanter Unterschied gelten. Wie sieht es denn aus mit diesem Signifikanzbegriff in der Statistik - ist damit auch eine deutliche Differenz gemeint?

Schönbrodt: Ja, das ist eine sehr schwierige Frage. Denn die Signifikanz, die ist mathematisch klar definiert. Das ist aber sehr schwer, das in umgangssprachliche Begriffe zu übersetzen. Und tatsächlich weiß man aus Untersuchungen, dass oft sehr viele Forscher tatsächlich nicht genau wissen, was dieser Signifikanzbegriff bedeutet. Signifikanz sagt mir, ob ein Unterschied, den ich zum Beispiel zwischen zwei Gruppen finde, zum Beispiel eine Experimentalgruppe, die ein Medikament bekommt, versus eine Kontrollgruppe, ob dieser Unterschied rein durch Zufall zustande gekommen sein könnte oder ob da sozusagen mehr ist. Also, wir versuchen, ein Signal vom Rauschen zu trennen. Und dieser Signifikanzwert gibt uns einen Hinweis darauf, ob das eher tendenziell Rauschen ist oder ob wir es mit einem Signal zu tun haben.

Reuning: Oder um bei der Körpergröße zu bleiben: Man würde eine große Anzahl von Menschen messen, in eine Auswertung einbeziehen, um dann zum Beispiel den Größenunterschied zwischen Männern und Frauen zu bestimmen. Und die Signifikanz würde verraten, wie verlässlich dann dieser Mittelwert ist.

Schönbrodt: Genau, richtig. Wenn ich Daten sammle, werde ich immer zufällige Schwankungen drin haben. Es wird immer mal eine Gruppe ein bisschen größer sein als die andere. Die Frage ist immer, ob in einer Population, also wenn ich jetzt alle Männer und alle Frauen messen würde, ob es da einen Unterschied gibt und ob der sich in dieser Stichprobe auch abbildet.

Den Zufall mit Statistik zähmen

Reuning: Zahlenmäßig ausgedrückt wird die Signifikanz ja im sogenannten p-Wert. Und wenn der p-Wert kleiner ist als 0,05, dann ist eine Studie offenbar reif zur Veröffentlichung. Dieser Wert sagt aus: Die Wahrscheinlichkeit ist geringer als fünf Prozent, dass das Ergebnis auf Zufall beruht. Stimmt das so?

Schönbrodt: Nein, das stimmt leider nicht. Wobei: Das ist die typische Interpretation, die ganz oft gebracht wird. Technisch gesehen bedeutet das: Wenn es keinen Unterschied gäbe, zwischen beiden Gruppen, dann hätten wir eine Fünf-Prozent-Chance, diese Daten oder noch extremere Daten zu bekommen. Ich weiß: Das klingt nicht sehr intuitiv. Und das liegt daran, dass es einfach nicht intuitiv ist.

Reuning: Das heißt, es bedeutet aber auch, dass ein gewisser Prozentsatz von Veröffentlichungen tatsächlich auf Zufall beruhen?

Schönbrodt: Genau. Würden wir das Signifikanz-Testen so anwenden, wie es im Lehrbuch steht, dann würden wir unser Fehlerniveau auf typischerweise fünf Prozent kontrollieren. Das hieße, dass wir bei fünf Prozent aller wissenschaftlicher Aussagen nur einen Fehler machen.

Reuning: Ein Zwanzigstel aller Studien sollte man daher kritisch vielleicht beäugen?

Negative Ergebnisse unerwünscht

Schönbrodt: Richtig. Das Problem ist jetzt, dass die wissenschaftlichen Journale fast nur signifikante Studien drucken überhaupt. Denn nur das, was neu ist, was funktioniert hat, ist interessant. Das heißt, wir haben einen gewissen Filter, dass nur die einem signifikanten Ergebnis überhaupt publik werden. Und unter denen ist die Wahrscheinlichkeit, dass eine Studie eben nicht stimmt, wesentlich höher als fünf Prozent.

Reuning: Ja, woran liegt das?

Schönbrodt: Stellen wir uns mal vor, wir machen tausend Studien. Und in allen tausend Studien gibt es eigentlich keinen Effekt. Das ist alles nur Rauschen. Aufgrund unseres Fünf-Prozent-Fehlerniveaus werden fünfzig von den tausend Studien signifikant allein durch Zufall. Die sehen dann aus, als gäbe es einen Effekt, das ist aber tatsächlich nur Rauschen. Und es werden nur genau diese fünfzig von den Tausend werden gedruckt in den Zeitschriften. Wenn jetzt ein unbedarfter Leser rangeht und sich diese Zeitschrift anschaut, sieht er fünfzig spannende Studien, wo überall was rauskommt. Denkt sich natürlich: Naja, da muss doch was dahinterstecken. Es sind aber tatsächlich einfach nur Zufallsbefunde, die es durch den Publikationsfilter in die Zeitschrift rein geschafft haben.

Es gibt unglaublich viele Freiheitsgrade

Reuning: Wie wir aus den Replikationsstudien gesehen haben: Die Rate der Veröffentlichungen, die nicht repliziert werden können, die ist ja deutlich höher als fünf Prozent. Also ist das ein Faktor, der da noch eine Rolle spielt. Oder gibt es auch gewisse Freiheitsgrade der Forschenden bei der Auswertung ihrer Daten?

Schönbrodt: Es gibt unglaublich viele Freiheitsgrade, fast schon zu viele. Und was wir in den letzten Jahren gelernt haben, ist das Bewusstsein, wie einfach es ist, durch bestimmte Datenmassagen, nenne ich es mal, das gewünschte Ergebnis hinzubekommen. Und die Schwierigkeit dabei ist, dass es kein direkter Betrug ist, der sofort auffallen würde, sondern es sind zum Teil akzeptierte Techniken in einem bestimmten Feld. Also, ich habe als Student selber noch gelernt damals: Felix, wenn du eine Studie machst, dann erheb nicht nur ein Outcome-Maß. Also wenn es zum Beispiel um Wohlbefinden geht, dann tu nicht nur Wohlbefinden messen, sondern miss auch noch positiven Affekt, negativen Affekt und vielleicht auch noch psychosomatische Symptome. Weil: Wenn deine erste Variable nicht funktioniert, wenn da nichts rauskommt, dann guckst du mal bei der zweiten. Und wenn’s da nicht geht, hast du bei der dritten noch eine Chance. Und so weiter. Und es wurde mir tatsächlich als gute wissenschaftliche Praxis verkauft. Und der Dozent war sich sicher: Das ist gute Praxis, so Wissenschaft zu machen. Heute wissen wir, oder man weiß es eigentlich schon lange, aber heute ist das Bewusstsein da, dass genau das eine der besten Techniken ist, falsch positive Ergebnisse sich hinzutricksen.

Reuning: Man spricht da vom sogenannten p-Hacking, also den p-Wert so lange zu berechnen, bis er etwas Signifikantes ergibt?

Schönbrodt: Richtig, genau.

Reuning: Vielen Dank soweit erst einmal Felix Schönbrodt von der LMU München. Er ist Psychologe und bisher haben wir vor allem über Studien aus der Psychologie gesprochen. Aber die Überprüfung von Versuchsergebnissen durch Reproduktion ist auch wichtig für andere Disziplinen. Denn die Replikationskrise hat zum Beispiel auch schon die Lebenswissenschaften erfasst. Anneke Meyer hat Forschenden in Hessen über die Schulter geschaut.

Qualitätssicherung in der Forschung

Wiederholung in der Wissenschaft als SicherheitscheckZwei von drei Studienergebnissen in der Psychologie sind nicht zuverlässig. In anderen Disziplinen sieht es nicht besser aus: Forschungsergebnisse lassen sich häufig bei wiederholten Messungen nicht bestätigen. Doch ohne Reproduktion funktioniert wissenschaftliches Arbeiten nicht.

Wiederholung in der Wissenschaft als SicherheitscheckZwei von drei Studienergebnissen in der Psychologie sind nicht zuverlässig. In anderen Disziplinen sieht es nicht besser aus: Forschungsergebnisse lassen sich häufig bei wiederholten Messungen nicht bestätigen. Doch ohne Reproduktion funktioniert wissenschaftliches Arbeiten nicht.

Reuning: Ein Beitrag von Anneke Meyer war das. Frage an Dr. Felix Schönbrodt: Welche akademischen Disziplinen sind denn besonders stark betroffen von der Replikationskrise?

Schönbrodt: Ich glaube, es sind am meisten die betroffen, die am genauesten hinschauen. Viele Disziplinen haben keine Replikationskrise einfach aus dem Grund, weil sie nicht replizieren. Also sie wissen nicht, ob sie eine haben. Die Psychologie ist offenbar sehr stark betroffen. Man muss aber auch dazusagen, dass wir, glaube ich, die Disziplin sind, die am genauesten hingeschaut hat und Selbstreflexion durchgemacht hat.

Menschlichkeit - ein Problem für die Forschung

Reuning: Wie sieht es denn aus: Bedeutet Replikation in der Psychologie etwas anderes als in eben zum Beispiel in den Lebenswissenschaften?

Schönbrodt: Ich glaube, ein Unterschied ist, dass unser Forschungsgegenstand, nämlich Menschen, einfach sehr komplexe Wesen sind, wo sehr viele Faktoren reinspielen. Das heißt, wenn ich mir Moleküle anschaue oder in der Physik unbelebte Materie, da gibt es, glaube ich, weniger Variabilität. Insofern sollte es da einfacher sein, Dinge zu replizieren als in der Psychologie.

Reuning: Bei einer Studie in der Psychologie dürfte es ja doch wohl auch eine Rolle spielen, wie die Probandengruppe zusammengesetzt ist, also zum Beispiel deren kultureller oder regionaler Hintergrund. Wie stark sind denn die Ergebnisse abhängig von diesem Kontext, in dem die Daten erhoben werden?

Schönbrodt: Das war eigentlich das spannende Ergebnis von "Many Labs 2", diese Kontextabhängigkeit zu untersuchen. Vielleicht kurz: Warum ist das so wichtig für uns Psychologen? Wenn es eine fehlgeschlagene Replikation gab in der Vergangenheit, war eine der ersten Entgegnungen von vielen Originalautoren: "Naja, das hat deshalb nicht geklappt, weil…" Und da gab es ganz, ganz viele Gründe: weil die die Studie in einem anderen Land durchgeführt wurde, weil die Studie zehn Jahre später durchgeführt wurde, weil sie das Material übersetzt haben etc. Es wurde also eine Kontextabhängigkeit postuliert – in manchen Fällen hat man den Eindruck gehabt, um den Originalbefund zu retten. Das heißt, das war eine sehr lebhafte Diskussion in der Psychologie, ob es diese Kontextabhängigkeit gibt. Und das spannende Ergebnis war bei "Many Labs 2", dass in diesen sechzig Laboren, die alle dieselbe Studie gemacht haben, es im Grunde genommen kaum Variabilität in den Effekten gab. Also die Effekte, die es tatsächlich gab, die gab es in jedem Labor, in jedem Land, in jeder Kultur mit kaum Varianz. Die Effekte, die es nicht gab, die gab es auch nirgends. Also es ist scheinbar nicht so, dass psychologische Effekte so labil sind, dass sie mal da sind und mal nicht da sind. Und das ist für uns als Disziplin durchaus beruhigend. Weil wenn psychologische Effekte so wacklig wären, dass sie bei kleinsten Kontextänderungen schon zusammenbrechen, dann hätten wir als Disziplin noch ganz andere Sorgen.

Transparenz als Lösung

Reuning: Gibt es denn Ansätze, die sich für alle Disziplinen eignen, um die Nicht-Replizierbarkeit von Ergebnissen zu vermeiden?

Schönbrodt: Ja, eine sehr starke Bewegung, die es in verschiedenen Disziplinen gibt, ist der Ruf nach Open Science, also transparente Wissenschaft. Und wir glauben, dass Transparenz und Offenheit, sowohl was den Forschungsprozess als auch was zum Beispiel die Rohdaten und die Ergebnisse betrifft, ein ganz wichtiger Baustein ist, um die Reproduzierbarkeit und die Glaubwürdigkeit von Forschung zu verbessern.

Reuning: Wie würde das denn ganz konkret aussehen? Wir haben ja in dem ersten Beitrag gehört von dem Registered Report, also dass man vorher bestimmt, was man auswerten möchte, welche Daten man erhebt. Ist das ein Werkzeug in diesem Werkzeugkasten der Open Science?

Schönbrodt: Richtig, genau. Das ist eines der wichtigsten Werkzeuge tatsächlich. Weil das nimmt diese ganzen Freiheitsgrade, mit denen man die Daten kreativ solange auswertet kann, bis dann doch etwas rauskommt. Ein anderes Werkzeug im Werkzeugkasten wären offene Daten. Das heißt, dass die Rohdaten mitgeliefert werden. Das ist bisher in der Psychologie, aber auch in vielen anderen Fächern, sehr unüblich, das zu machen. Wenn ich die Daten offenlege, können erstens andere nachschauen, können das überprüfen, was ich gemacht habe, können vielleicht alternative Ansätze drüber laufen lassen. Und es erhöht auch die Effizienz, weil ich auf dem aufbauen kann, was andere schon gemacht haben. Also ich kann deren Forschungsergebnisse einfach nehmen und an der Stelle weitermachen und muss nicht wieder das Rad von vorne erfinden.

"Wer Karrier machen will braucht positive Ergebnisse"

Reuning: Wie sieht es denn aus mit der Publikationskultur? Wir hatten ja vorhin schon kurz darüber gesprochen: Der Anreiz für die Forschenden besteht darin, möglichst viel zu veröffentlichen, nur Neues zu veröffentlichen und möglichst nur positive Ergebnisse zu publizieren.

Schönbrodt: Richtig, die andere Struktur ist aus meiner Sicht vielleicht eines der grundlegenden Probleme für die Replikationskrise, weil, wie Sie schon gesagt haben, wer eine Karriere machen möchte in der Wissenschaft, der braucht eben viele positive, fast perfekte Ergebnisse. Verschärfend kommt hinzu, dass fast alle Positionen unterhalb der Professur in Deutschland befristet sind an der Uni. Das sind dann oft Ein-, Zwei- oder Dreijahresverträge. Und es geht jetzt nicht nur drum: Mache ich ein bisschen mehr oder ein bisschen weniger Karriere in der Wissenschaft. Sondern es geht existenziell eher darum: Kann ich überhaupt meinen Traumberuf ausüben? Oder fliege ich nach drei Jahren raus, weil ich nicht die Publikationsleistung gebracht habe, die ich gebraucht hätte, um weiterzumachen. Und das erzeugt natürlich enorme Anreize, möglichst schöne Ergebnisse zu produzieren.

Reuning: Glauben Sie denn vor diesem Hintergrund, dass es der Wissenschaft überhaupt gelingen kann, diese Replikationskrise zu überwinden?

Verhalten Optimistisch

Schönbrodt: Ich bin mittlerweile optimistisch. Wenn Sie mich vor vier oder fünf Jahren gefragt hätten, wäre ich vielleicht eher ambivalent gewesen. Aber diese Bewegung hin zu einer offenen, glaubwürdigen Wissenschaft ist mittlerweile sehr stark geworden. Sehr fachabhängig, in einigen Fächern mehr, in anderen weniger. Aber es gibt auch schon Anstrengungen, auch die Anreize zu verändern. Wir haben zum Beispiel in unserem Department in München die Professur-Ausschreibungen mit einem Absatz drin ergänzt, wo drin steht, dass unser Department Wert legt auf replizierbare, glaubwürdige Forschung und dass wir das unterstützen. Und somit explizit ein Signal senden, dass es uns nicht nur um die reine Quantität geht, sondern um die Qualität und um die Glaubwürdigkeit der Forschung. Und von den Kandidaten, die sich bei uns bewerben, und alle Kandidatinnen und Kandidaten sollen bei der Bewerbung einen kurzen Absatz mitliefern, inwiefern sie diese Ziele schon umsetzen oder in Zukunft gedenken umzusetzen. Und das hat bei einigen Professur-Besetzungen auch tatsächlich schon den Unterschied gemacht.

Reuning: Das heißt, Sie sind optimistisch, dass sich dieses Prinzip der Open Science durchsetzen wird?

Schönbrodt: Verhalten optimistisch, ja.

Reuning: Vielen Dank, Felix Schönbrodt war das von der Ludwig-Maximilians-Universität München. Dort ist er der akademische Geschäftsführer am LMU Open Science Center. Und damit sind wir auch schon wieder am Ende der Sendung angelangt. "Signifikant oder nicht? Wenn Studien einem zweiten Blick nicht standhalten." Das war das Thema heute. Und damit verabschiedet sich im Studio Arndt Reuning.