"Hiermit bestätige ich, dass alle meine Angaben der Wahrheit entsprechen." Wer mit Unterschrift so eine Stellungnahme gleich am Anfang eines Dokumentes bestätigt, statt wie üblich am Schluss, macht weniger Falschangaben. So das Ergebnis einer viel beachteten psychologischen Studie. So einfach ist es also Leute zur Ehrlichkeit zu bewegen. Oder auch nicht.

"Es ist ein offensichtlich dreist gefälschter Datensatz. Wahrscheinlich der dreisteste, den ich je gesehen habe." Joe Simmons ist Professor an der Wharton School an der Universität Pennsylvania und Teil eines Wissenschaftler-Trios, dass sich einen Namen damit gemacht hat, Ungereimtheiten in Daten aufzudecken.

Studie war "fester Bestandteil der Vorlesungen"

Auf ihrem Blog "Data Colada" veröffentlichten die Forscher vor Kurzem eine Analyse, die zeigt: Wesentliche Teile der bekannten Ehrlichkeitsuntersuchung sind frei erfunden. Einige der Autoren haben daraufhin um den Rückzug der Studie gebeten.

Dabei hatte das 2012 im Fachmagazin PNAS veröffentlichte Untersuchungsergebnis bis vor Kurzem noch zum Standard-Lehrbuchwissen der Psychologie gehört. Über 400-mal wurde der Artikel zitiert. Eine US-amerikanische Versicherungsgesellschaft übernahm die Unterschrift am Anfang für ihre Policen. Steuerbehörden verschiedener Staaten ließen eine Anpassung ihrer Formulare prüfen. Auch Joe Simmons war zunächst überzeugt: "Diese Studie war ein fester Bestandteil meiner Vorlesungen. Es macht einfach Sinn: Wenn ich zuallererst unterschreibe, nicht zu lügen, dann bleibt mir das im Kopf und gelingt mir möglicherweise besser, als wenn ich erst am Schluss unterschreibe, wenn die Tat vollbracht ist."

Daten aus dem Zufallsgenerator

Erste Zweifel an der Aussagekraft der Studie waren schon letztes Jahr aufgekommen: Die Autorinnen und Autoren wollten auf ihren früheren Ergebnissen aufbauen und hatten dafür den ersten Teil der Studie wiederholt. Ohne Erfolg. Die Ergebnisse waren nicht reproduzierbar.

Die jetzt hinzugekommenen Betrugsvorwürfe betreffen den zweiten Teil der Studie: einen Feldversuch, in dem Daten von einer Autoversicherung gesammelt wurden. "Wir haben in diesem Fall mit Kooperationspartnern zusammengearbeitet, die gerne anonym bleiben wollen. Sie waren es, die mit ihrem Verdacht auf uns zukamen. Das erste, wo wir dachten, 'Das sieht nach Betrug aus' war die Verteilung der Daten. Es gab gleich viele Menschen, die besonders weite Strecken fuhren wie solche, die ganz kurze oder mittlere Distanzen zurücklegten. Das ist extrem unwahrscheinlich. Dazu kamen Merkmale, die eigentlich nur entstehen, wenn Zahlen von einem Zufallsgenerator erstellt werden. Und ein paar typische Copy-Paste-Fehler."

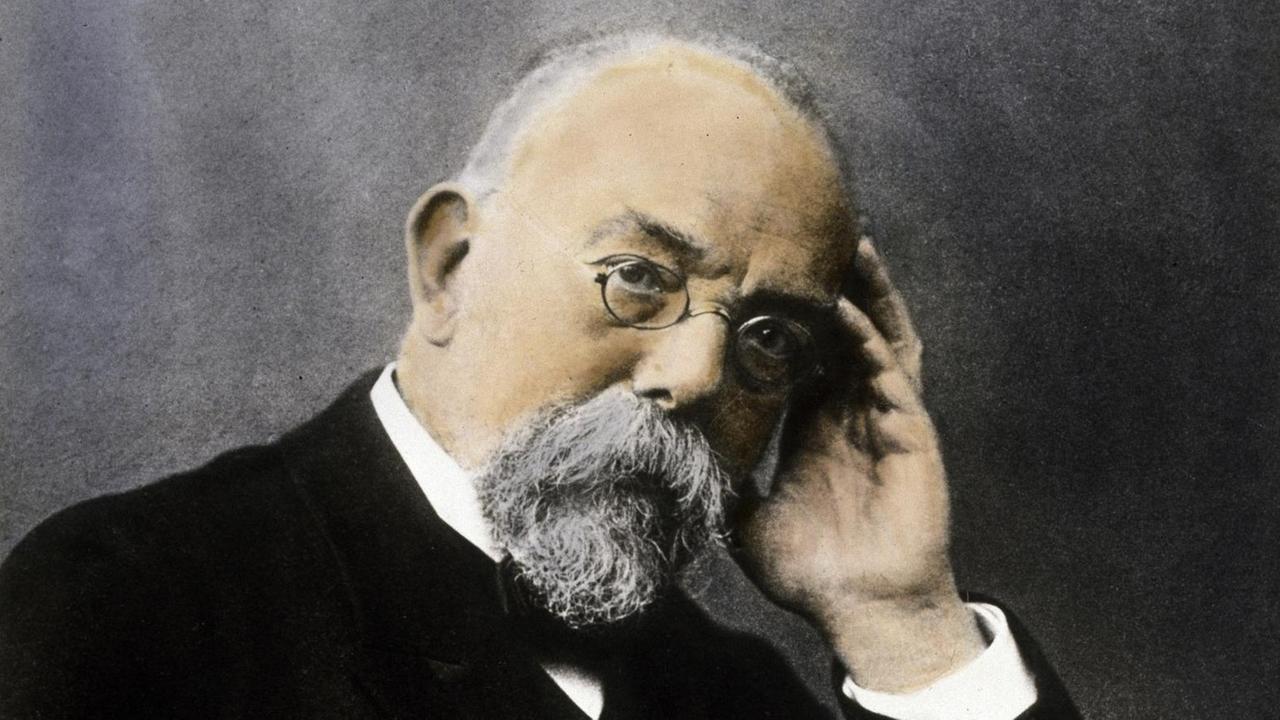

Unter Verdacht: Ein Superstar der Wissenschaft

"Ja", geben auch die Autorinnen und Autoren der Studie zu, diese Daten müssen gefälscht sein. Gewesen sein will es niemand. Die meiste Aufmerksamkeit richtet sich auf einen der Autoren der Studie. Einen Superstar der Sozialpsychologie: Dan Ariely. Verfasser von drei New-York-Times-Bestsellern, unter anderem "Die halbe Wahrheit ist die beste Lüge".

Ariely räumt ein, dass nur er die Originaldatei von der Versicherung erhalten habe. Er bestreitet jedoch nachdrücklich, die Daten manipuliert zu haben. Auf Anfrage des Deutschlandfunks verwies er auf eine Stellungnahme, die begleitend zum belastenden Blog-Eintrag veröffentlicht wurde, in der es heißt, das Duke Office for Integrity sei informiert und er unterstütze die Untersuchungen. Auch die Versicherung selber könnte die Daten gefälscht haben. Eindeutige Beweise gibt es für keine der beiden Möglichkeiten.

Systemversagen eher als individuelle Schuld

Für Susann Fiedler, Mitbegründerin des Deutschen Netzwerks für Reproduzierbarkeit, ein Grund sich nicht zu sehr auf die Schuldfrage zu versteifen. "Ob die einzelnen Forscher jetzt an der Stelle genauer hätten hingucken müssen? Ja, denke ich." Wichtiger ist für die Professorin der Wirtschaftsuniversität Wien etwas Anderes: "Was wir als Feld einfach machen müssten und was einfach unsere Pflicht als Wissenschaftler sein sollte, ist, dass wir eine transparente Dokumentation zur Verfügung stellen. Sodass, wie jetzt zehn Jahre später passiert ist, jemand nachschauen kann und den Fehler entdeckt. Dass wir eine ganz andere Fehlerkultur haben, damit diese Sachen nicht in der Literatur landen und tatsächliche Veränderungen gesellschaftlich herbeiführen, die aber gar nicht belastbar sind. Und da glaube ich, dass es ein Systemversagen wurde, wofür dieser Akt jetzt tatsächlich leider wieder ein schönes Beispiel ist."

Verbindliche Qualitätsstandards könnten schützen

Dass ein Studienergebnis sich im Nachhinein als falsch herausstellt, ist kein Einzelfall. Eine Untersuchung aus dem Jahr 2015, in der 100 einflussreiche Befunde aus der Psychologie auf den Prüfstein gestellt wurden, ergab, dass kaum ein Drittel der Versuche erfolgreich wiederholt werden konnten. Egal, ob ein ehrlicher Fehler oder Betrug hinter unzuverlässigen Ergebnissen stecken, verbindliche Qualitätsstandards könnten vor beidem gleichermaßen schützen. Was fehlt, ist bisher noch die Verankerung im System, meint Joe Simmons.

"Wenn ich sehe, was sich auf Graswurzelebene alles tut, bin ich schon optimistisch. Aber wenn ich daran denke, was sich auf übergeordneter, struktureller Ebene tut – dann denke ich, ich muss dringend einen trinken."