‚VIVA‘ soll so groß sein wie ein Kleinkind, sie soll eine eigene Mimik haben und Smalltalk beherrschen. VIVA – das ist der Name eines so genannten „sozialen“ Roboters, der gerade entwickelt wird und in drei bis vier Jahren auf den Markt kommen könnte.

„Wenn ich abends nach Hause komme, hört VIVA das, fährt mir entgegen, sagt: ‚Schön, Claude, dass du wieder da bist.‘ Schaut mich an und sagt: ‚War heute ein anstrengender Tag? Du wirkst gestresst.‘ Dann sag ich: ‚Hmm, ja, stimmt, du hast Recht.‘“

Claude Toussaint hat das Münchner Start-Up ‚Navel Robotics‘ gegründet, um den Roboter gemeinsam mit Universitäten und Unternehmen zu entwickeln – gefördert durch das Bundesforschungsministerium mit knapp 2,3 Millionen Euro. VIVA ist ausgestattet mit Kameras, Sensoren und Hochleistungs-Prozessoren für die Künstliche Intelligenz.

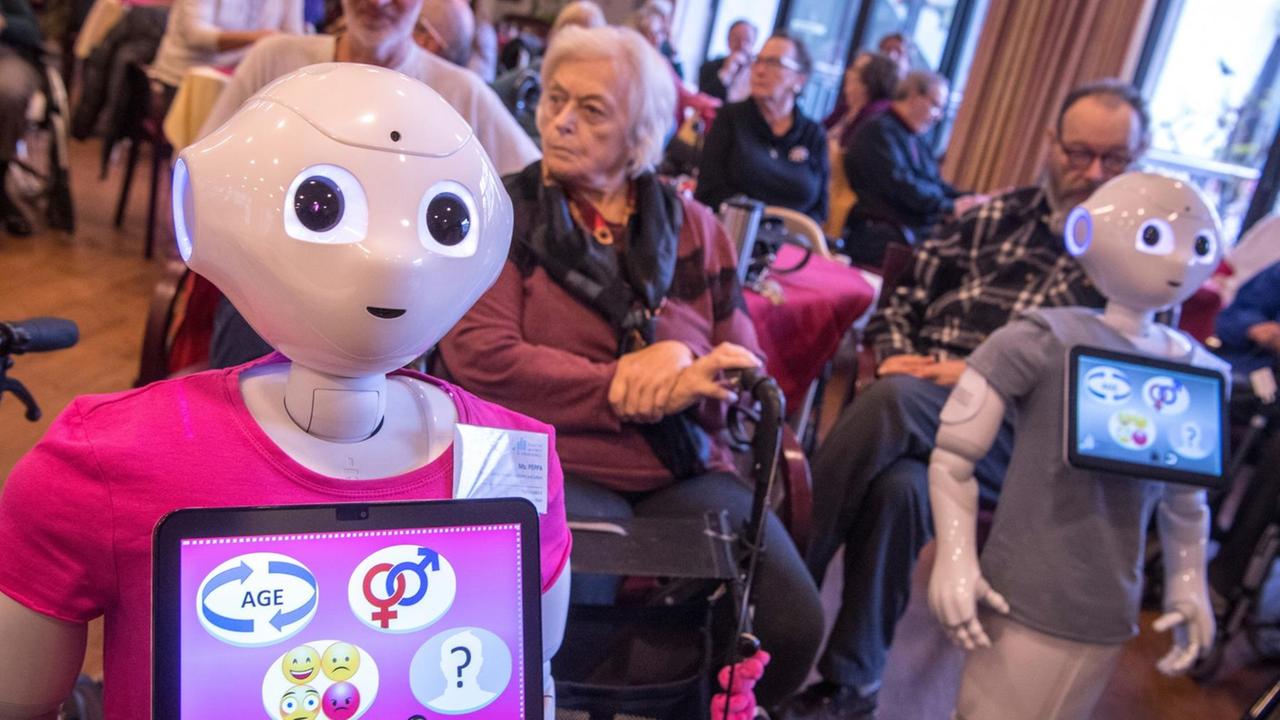

Anders als die meisten bisherigen Roboter soll dieser nicht direkt eine Funktion erfüllen. Sondern er soll ein soziales Gegenüber für uns Menschen sein: Situationen und Emotionen erkennen, sich lebendig verhalten, mit uns reden und damit unser Wohlbefinden steigern. Vielleicht wie eine Art Haustier, sagt Entwickler Toussaint.

„Das Design soll sehr sympathisch, vertrauenswürdig wirken. Wir müssen ein Design machen, was irgendwie an den Menschen angelehnt ist, aber andererseits darf das Design nicht zu menschlich wirken. Wenn man einen Roboter zu menschlich macht, dann bekommen die Leute Angst, weil sie es nicht einschätzen können, was das Gegenüber ist. Das heißt, es muss jederzeit deutlich sein, dass das ein Roboter ist, kein Mensch. Aber andererseits darf es nicht so technisch wie ein Roboter wirken.“

Technik , die tatsächlich dem Menschen dient

VIVA könnte aussehen und sprechen wie eine computeranimierte Comicfigur. Allerdings mit einem ernsthaften Ziel: In einem alternden Land könnte der Roboter einsamen Menschen in Alten- und Pflegeheimen Gesellschaft leisten.

„Der Schlüssel zwischen Pfleger und Heimbewohner ist so schlecht, dass viele Heimbewohner zu wenig Ansprache haben. Und das kann VIVA machen: Leute ansprechen und damit sie auch kognitiv aktivieren. Drei, vier Roboter mehr sind sehr gut leistbar – drei, vier Pfleger mehr ist sehr schwierig.“

Eine Idee, die manche großartig finden und andere verstörend, gibt der Ingenieur zu:

„Mir war natürlich schon sehr früh klar, dass da ethische Fragen aufkommen, weil ich mich im Bekannten- und Freundeskreis unterhalten hab über dieses Thema. Und ein Teil der Leute schreckt sehr schnell zurück und sagen: ‚Das kann doch gar nicht sein, das darf nicht sein.‘ Also habe ich auch für mich selbst versucht, Antworten zu finden, weil ich natürlich auch meinen eigenen, persönlichen ethischen Anspruch hab.“

An VIVA arbeiten Ingenieure, Designer, Psychologen – aber auch Ethik-Fachleute. Arne Manzeschke, Professor für Anthropologie und Ethik für Gesundheitsberufe an der Evangelischen Hochschule Nürnberg, begleitet das Projekt. Seine Leitfrage:

„Wie gestaltet man die Technik so, dass sie tatsächlich dem Menschen dient? Wir bieten den Technikern keine ethische Checkliste an, sondern gehen mit ihnen gemeinsam in eine Reflexion: Welche Vorstellung vom Menschen, von Einsamkeit, von sozialem Miteinander haben wir? Und was bedeutet das für die konkrete soziale Interaktion, die dann zwischen Mensch und Technik entsteht? Und überlegen, das, was wir ethisch für gut befinden, wie kann das in diese Konstruktion mit eingehen.“

Moralische Verantwortung, wenn Roboter Fehler machen

Technische Erfindungen haben auch heute schon Folgen für unsere Gesellschaft: etwa das Problem, wo der Atommüll endgelagert werden soll. Neu an der gegenwärtigen Forschung ist: Die technischen Systeme laufen nicht irgendwo, fernab vom Menschen, sondern wir kommen mit ihnen unmittelbar in Berührung – Beispiel soziale Roboter. Damit gehen tiefgreifende Fragen einher: Wie frei und unabhängig sind wir in Zukunft? Wenn Geräte mittels künstlicher Intelligenz selbstständig agieren, wer entscheidet dann: der Mensch oder die Maschine? Wer übernimmt Verantwortung, wenn ein Roboter einen Fehler macht und jemanden verletzt? Was ist, wenn die Technik plötzlich aussetzt oder einem Sabotage-Akt zum Opfer fällt?

„Wo bleiben wir als Menschen, als moralisches und verantwortliches Subjekt, wenn wir eigentlich gar nicht mehr wissen, wie Entscheidungen zustande gekommen sind, die wir aber dann verantworten sollen. Wir werden uns fragen müssen: Wie wollen wir mit dieser Abhängigkeit umgehen? Und wie schaffen wir es, bei der ganzen Delegation von Entscheidungen und Nachdenkens-Prozessen nicht blöd zu werden, und intellektuell auch nachzulassen und dann sowieso abhängig zu werden von Maschinen.“

Ethik-Professor Manzeschke sagt: Technik sei nicht einfach neutral. Bereits während der Forschung fielen Entscheidungen: wie wir uns künftig fortbewegen, wie wir kommunizieren und leben werden. Deshalb entwickelt sein Team, gefördert durchs Forschungsministerium, zurzeit einen ethischen Orientierungsrahmen für Ingenieure.

Dabei sieht sich der evangelische Theologe nicht als Bremser des technischen Fortschritts, sondern als Mitgestalter. In Einzelfällen gebe es trotzdem Grenzen, die nicht überschritten werden dürften. Etwa bei sensiblen Gesundheitsdaten.

„Wir hatten mal ein Projekt, wo wir gesagt haben, also überlegt euch mal gut, was ihr da macht, wenn ihr ein Quasi-Diagnostiksystem für Demenz ins Internet stellt mit Künstlicher Intelligenz. Die Leute probieren das, weil das so schön niedrigschwellig ist, weil man mit niemandem reden muss, nicht zum Arzt gehen muss und auch die Scham nicht hat, entdeckt zu werden. Aber was bedeutet es, wenn man in dem Fall dann eine Quasi-Diagnose – es ist ja keine echte Diagnose – bekommt, und damit alleine ist. Was könnten die sozialen Folgen davon sein?“

Roboter gegen den Pflegekräftemangel

Tatsächlich überdachten die Entwickler ihre Idee noch einmal. Claude Toussaint, der am Roboter VIVA forscht, sagt, vor allem eines sei ihm durch die Zusammenarbeit mit den Ethik-Fachleuten bewusst geworden: dass er als Ingenieur, der Künstliche Intelligenz programmiert, Normen setzt, was er für richtig hält und was für falsch. Denn der Roboter soll ein Verständnis für Werte und Bedürfnisse haben, auf Freude, Wut, Angst oder Zufriedenheit seines Gegenübers reagieren. Damit Menschen die Technik überhaupt akzeptierten, müssten sie ihr vertrauen.

„Es ist ganz wichtig, dass ich jederzeit den Eindruck habe, ich weiß, was das System jetzt als Nächstes tut. Das ist bei einem Fahrkartenautomaten auch wichtig: Was kann ich als Nächstes tun, was passiert. Und es wird bei einem Roboter, der autonom agiert, noch wichtiger sein. Dass ich nicht überrascht bin von dem, was als Nächstes passiert.“

Bereits in wenigen Jahren könnte der Roboter – Kostenpunkt wohl rund 3.000 Euro – in Altenheimen zum Einsatz kommen. Gesundheitsethiker Arne Manzeschke sieht darin ein Für und Wider: Einerseits werden in Deutschland Prognosen zufolge bald hunderttausende Pflegekräfte fehlen. Tätigkeiten wie Essen austeilen, Menschen waschen oder umbetten könnten dann durchaus Roboter übernehmen. Andererseits gehe so die Idee der ganzheitlichen Pflege verloren.

„Was passiert da eigentlich als Gesellschaft, dass wir sagen: Uns fällt momentan nichts Besseres ein, als den alten Menschen Roboter vorzusetzen, weil wir haben ja alle keine Zeit dafür. Da scheint für mich eine ethisch interessante Frage auf: Was passiert hier eigentlich, dass wir unsere Prioritäten offenbar ganz anders setzen und sagen: Diese alten Menschen, das ist nicht so wichtig, da haben wir Wichtigeres zu tun.“

Auch Ingenieur Claude Toussaint zögert erst auf die Frage, ob er selbst einmal so einen sozialen Roboter um sich haben möchte:

„Ich bin gar nicht der Typ, der solche Gadgets normalerweise hat. Wenn wir das aber richtig gut hinbekommen, könnte ich mir das schon vorstellen, ja.“