Die Menschheit hat schon den allergrößten Blödsinn geglaubt: Die Sonne dreht sich um die Erde. Lämmer wachsen auf Bäumen. Waschen ist schlecht für die Gesundheit. Da ist man doch froh, in einer aufgeklärten Gesellschaft zu leben. In einer Welt, in der Logik und Tatsachen zählen…

"Sie kennen Leute die meinen, die Erde sei flach. Ganz sicher. Aber Sie wissen nicht, wer diese Leute sind, denn wer an die Scheibenerde glaubt, verheimlicht es." (Mark Sargent, Buchautor und Betreiber des YouTube-Channels "Flat Earth Clues")

"Ich halte den von Menschen gemachten Klimawandel für nicht existent." (Michael Limburg, AfD-Politiker und Vizepräsident des "Europäischen Instituts für Klima und Energie")

"Our press officer Sean Spicer gave alternative facts for that - Sean Spicer, unser Pressesprecher, hat dazu alternative Fakten dargestellt." (Kellyanne Conway, Beraterin des US-Präsidenten Donald Trump)

Wissen statt Glauben. Warum glauben wir dann immer noch Dinge, die wir besser wissen könnten?

Die Geschichte von den skythischen Lämmern

"Ich, John Mandeville, Ritter, geboren in England in einer Stadt, die St. Alban heißt, fuhr aus über das Meer, als man nach Christi Geburt tausenddreihundertundzwanzig Jahre zählte, am Vorabend des St. Michaels Tages." (Das Reisebuch des Sir John Mandeville)

Cailin O'Connor: "Es fing an mit den angeblichen Reiseschilderungen dieses Ritters. Es ist historisch nicht gesichert, dass er tatsächlich ein Ritter war oder es die Beschreibung einer echten Reise ist. Aber in dem Buch behauptet er, er wäre nach Indien gefahren."

"Und wer von diesseits des Meeres nach Indien und Cathay will, der fährt durch ein Land, das Caßdilbe heißt. Und das ist ein sehr schönes Land." (John Mandeville)

Cailin O'Connor: "Dort sah er mit eigenen Augen diese Pflanze, und auf der Pflanze waren diese Hülsenfrüchte."

"Wenn die Früchte reif werden, so dass man sie aufbrechen kann, dann findet man darin ein Tier, das Fleisch und Blut hat und in der Wolle einem Lämmchen gleicht." (John Mandeville)

Cailin O'Connor: "Er behauptete, er hätte diese Lämmer gesehen, sie berührt und auch gegessen. Und er sagte, sie schmeckten wunderbar."

Ein Lamm, das wie Gemüse wächst: In Werken der Naturforscher des Mittelalters tauchen Bilder auf, direkt neben Abbildungen von Elefanten. Immer wieder gab es Berichte von jemandem, der jemanden getroffen hatte, der das skythische Lamm gesehen hatte oder Kleidung aus seiner Wolle. Kritische Stimmen merkten an, eine Kombination aus Tier und Pflanze könnte Probleme mit dem Blutkreislauf haben. Endgültige Aufklärung brachte eine gezielte Expedition, die das Tier suchte und es nicht fand. 300 Jahre waren da vergangen.

Alles was wir wissen, beginnt mit einer Vermutung. Der Unterschied zwischen glauben und wissen liegt darin, ob die Vermutung einer objektiven Prüfung standhält. Ohne Evidenz kein Wissen. So die Theorie. In Zeiten von Foto, Film und Fernreisen würde niemand mehr an skythische Lämmer glauben – was nicht heißt, dass sie ausgestorben sind.

Alles was wir wissen, beginnt mit einer Vermutung. Der Unterschied zwischen glauben und wissen liegt darin, ob die Vermutung einer objektiven Prüfung standhält. Ohne Evidenz kein Wissen. So die Theorie. In Zeiten von Foto, Film und Fernreisen würde niemand mehr an skythische Lämmer glauben – was nicht heißt, dass sie ausgestorben sind.

Jeder vierte Amerikaner und jeder dritte Russe meint auch heute noch, die Erde sei der Mittelpunkt des Universums. Die Deutschen haben nicht so große Probleme mit der Astronomie. Allerdings auch nicht mit Astrologie. Jeder vierte glaubt, wenn Venus im Haus des Schützen steht, ist die Zeit günstig, Neues zu lernen. Rund 70 Prozent meinen, dass Homöopathie wirkt, obwohl es dafür keine wissenschaftlichen Belege gibt. Jeder 13. hat dagegen Zweifel, dass Impfen sinnvoll ist.

Das Zeitalter der Falschinformation

Cailin O'Connor ist Assistenzprofessorin für Logik und Wissenschaftsphilosophie an der University of California in Irvine und eine der Autorinnen des Buches "The Age of Misinformation". Sie erforscht, wie Wissen entsteht:

"Vor einiger Zeit wurde klar, dass Falschinformationen und Irrglauben zu einem gesellschaftlichen Problem geworden sind und das brachte mich dazu, mir die grundsätzliche Frage zu stellen: Warum halten so viele Menschen an falschen Überzeugungen fest, die ihnen letztlich schaden?"

Normalerweise untersucht Cailin O'Connor, wie Wissenschaftler arbeiten, um zu einer neuen Erkenntnis zu gelangen. Dieser Ansatz lässt sich leicht auf uns alle verallgemeinern. Der Prozess, in dem Forscher Wissen schaffen, unterscheidet sich im Prinzip nicht davon, wie wir alle lernen. Sie gehen dabei nur systematischer vor, was das Ganze leichter nachvollziehbar macht.

"Die Gelehrten, die im Mittelalter an das skythische Lamm glaubten, waren nicht dumm. Sie gehörten zur Bildungselite ihrer Zeit, aber sie saßen diesem Irrglauben auf, weil sie einander vertrauten. Ich denke, diese Geschichte zeigt uns eine grundlegende Tatsache: Wissen entsteht in einem sozialen Kontext. Und das gilt ganz besonders für Wissenschaft. Es gibt einige wenige wissenschaftliche Annahmen über die Welt, die wir aus eigener Erfahrung machen. Aber das meiste wissen wir, weil es uns jemand anderes erzählt hat. Und es ist einfach unmöglich, alles selbst zu überprüfen."

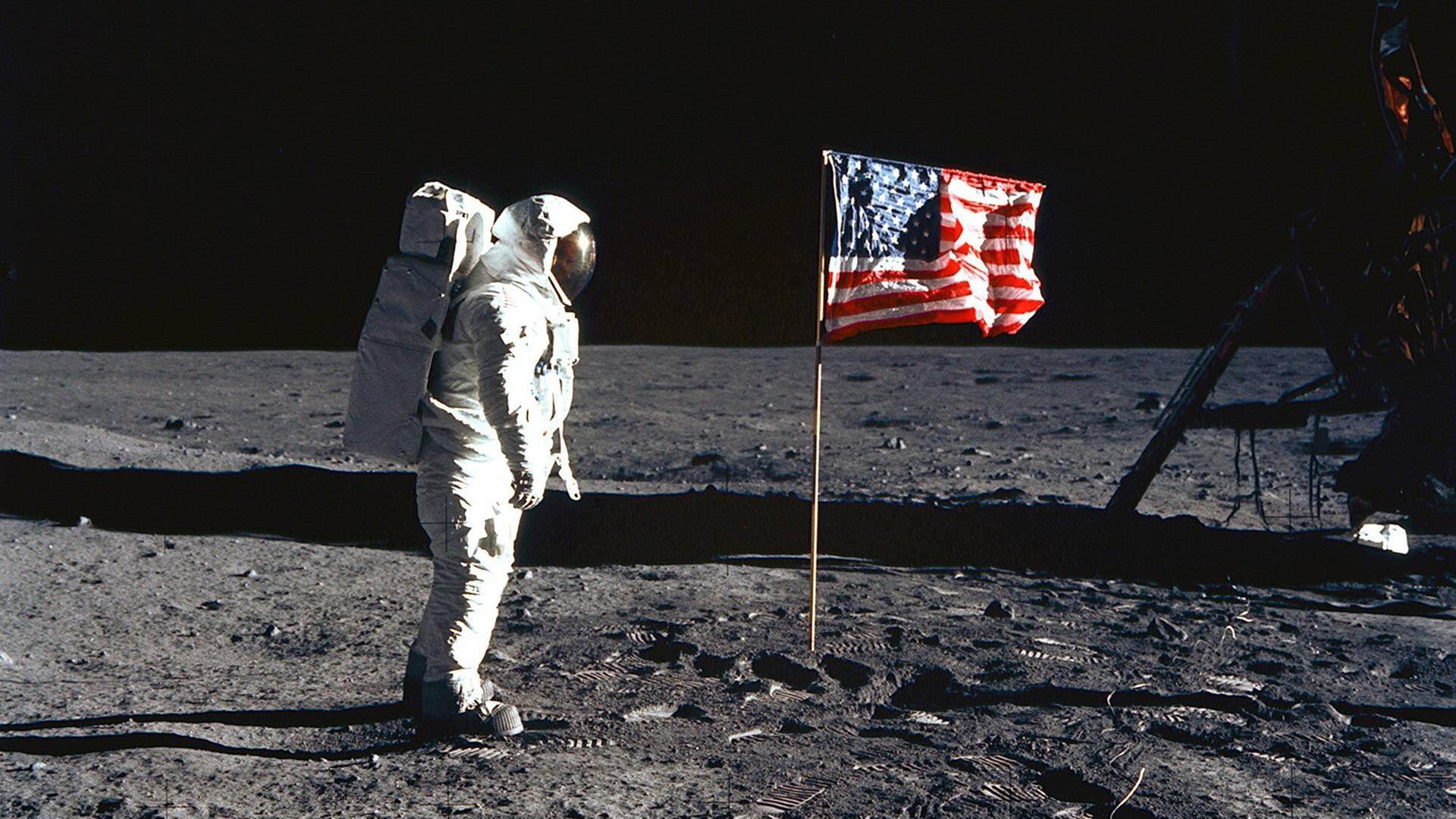

Jeder kann sehen, dass die Sonne auf und wieder unter geht. Den Beweis dafür erbringen, dass die Bewegung auf die Rotation der Erdachse zurückzuführen ist, kann kaum jemand. Ohne Informationsaustausch müsste jeder das Rad neu erfinden. Mondflug, Krebsmedizin, Internet gäbe es nicht. Nur, unter die Information mischt sich manchmal ein Irrtum.

Computermodell simuliert Meinungsbildung

"Wir arbeiten mit einem Computermodell, das eine Gruppe von Leuten simuliert. Wir nennen die ‚Agenten‘, denn natürlich sind sie viel einfacher konstruiert als echte Menschen. Diese Agenten bilden ein Netzwerk. Manche reden miteinander, andere nicht. Genau wie wir es in der echten Welt tun."

In Cailin O’Connors Modell haben die Agenten die Wahl zwischen zwei Theorien. Eine der Theorien ist richtig. Die Agenten sollen herausfinden, welche. Jeder von ihnen beginnt mit einer zufällig zugeteilten Überzeugung.

"Die Agenten überprüfen ihre Annahme durch Tests. Sie beobachten, was passiert, und passen ihre Annahme dann entsprechend an. Gleichzeitig teilen sie die von ihnen gesammelten Hinweise mit den anderen."

Jeder Agent kombiniert die eigenen Erkenntnisse mit den Ergebnissen der Kollegen in seinem Netzwerk. So lange, bis alle sich auf eine Theorie geeinigt haben. Jeder Einzelne handelt absolut logisch. O’Connor:

"Sie sind also wirklich gut darin, rational abzuwägen. Nichtsdestotrotz – sie können alle gemeinsam zum falschen Ergebnis kommen. Und zwar immer dann, wenn einige von ihnen Beobachtungen machen, die die falsche Theorie stützen. Das ist einfach eine Frage der Wahrscheinlichkeitsverteilung. So wird einer auf die falsche Fährte gelockt. Das führt dann auch andere in die Irre."

1954 veröffentlicht der Gastroenterologe E.D. Palmer eine wegweisende Studie. Seit langem rätseln Mediziner, was die Ursache für Magengeschwüre ist. Untersuchungsergebnisse stützen zwei mögliche Theorien: Entweder liegt der Auslöser in zu viel Magensäure oder die Erkrankung wird durch Bakterien hervorgerufen. In Biopsien von über 1.000 Patienten sucht Palmer nach Hinweisen auf Bakterien. Und findet keine. Er schlussfolgert, dass Bakterien im sauren Milieu des Magens nicht überleben können. Frühere Befunde, in denen Bakterien nachgewiesen wurden, müssten auf Verunreinigungen zurückzuführen sein. Die enorme Größe der Untersuchung überzeugt die Kollegen beider Lager. Nach 1954 gilt Übersäuerung allgemein als Auslöser für Magengeschwüre.

Alles ist, wie es sein sollte: Eine Vermutung wurde angestellt. Sie hält einer objektiven Prüfung stand. Und sie bewährt sich in der Praxis: Die Behandlung mit säureneutralisierenden Medikamenten hilft. Allerdings nicht so gut, wie Antibiotika, die einige Ärzte der vorherrschenden Meinung zum Trotz einsetzen. Was weitestgehend unbeachtet bleibt.

Alles ist, wie es sein sollte: Eine Vermutung wurde angestellt. Sie hält einer objektiven Prüfung stand. Und sie bewährt sich in der Praxis: Die Behandlung mit säureneutralisierenden Medikamenten hilft. Allerdings nicht so gut, wie Antibiotika, die einige Ärzte der vorherrschenden Meinung zum Trotz einsetzen. Was weitestgehend unbeachtet bleibt.

Sozialer Druck sabotiert die Urteilsfähigkeit

Wissenschaft zeigt nicht, was wahr ist und was falsch. Wissenschaft schließt, anhand von Evidenz, was am wahrscheinlichsten wahr sein könnte. Damit ist Unsicherheit ein inhärenter Teil von Wissenschaft. Es kann sein, dass wichtige Hinweise nicht bekannt sind. Es kann immer einen Zufallsbefund geben oder einen methodischen Fehler. Auch der rationalste Denker kann dadurch einer falschen Annahme, einem Irrglauben aufsitzen. Und wann sind Menschen schon einmal wirklich rational?

Cailin O'Connor: "Menschen haben soziale Neigungen. Und eine davon ist die Tendenz, sich der Mehrheit anzupassen. Jeder tut das mehr oder weniger. Es ist einfach unangenehm, sozial aufzufallen. Und besonders unangenehm kann es sein, eine andere Meinung zu haben."

Cailin O'Connor: "Menschen haben soziale Neigungen. Und eine davon ist die Tendenz, sich der Mehrheit anzupassen. Jeder tut das mehr oder weniger. Es ist einfach unangenehm, sozial aufzufallen. Und besonders unangenehm kann es sein, eine andere Meinung zu haben."

Sich der Gruppe anzuschließen ergibt oft Sinn. Wer regelmäßig "Wer wird Millionär" sieht, wird es wissen: Der Publikumsjoker, bei dem das ganze Studio befragt wird, hat um die 90 Prozent Erfolgswahrscheinlichkeit. Eine Gruppe kommt oft zum richtigen Ergebnis – allerdings nur, wenn jeder einzelne unabhängig von den anderen sein Urteil fällt. Sobald die Entscheidungen einzelner von denen anderer abhängen, kippt die Weisheit der Menge ins Gegenteil Das zeigt auch das simulierte Netzwerk von Cailin O'Connor:

"Wir können unser Modell mit den absolut rationalen Denkern so verändern, dass sich die Agenten ein bisschen mehr so verhalten, wie wir es tun würden. Wir untersuchen, was passiert, wenn sie sich einander etwas anpassen. Und was wir finden ist: Je stärker die Neigung des Einzelnen sich anzupassen, desto wahrscheinlicher wird es, dass die ganze Gruppe zum falschen Schluss kommt. Wir sehen dabei auch: Einige der Agenten glauben zwar an die richtige Lösung, handeln aber nach der falschen. Allein wegen ihres sozialen Umfeldes."

Robert Millikan und Harvey Fletcher etablierten 1910 eine Methode, mit der es gelang, die Ladung eines Elektrons zu bestimmen. Eine der wichtigsten physikalischen Konstanten. Millikan erhielt dafür den Nobelpreis. Über die Jahre ist die Konstante allerdings ein bisschen größer geworden. Millikan hatte eine falsche Viskosität der Luft angenommen. Statt den Fehler zu korrigieren, passten nachfolgende Generationen ihre Messwerte immer ein bisschen den früher veröffentlichten Messungen an. Erst seit 2014 ist die Elementarladung wirklich konstant.

Falschinformation als Kriegsgrund

"Mein Name ist Stephan Lewandowsky. Ich bin Professor für kognitive Wissenschaft an der Universität von Bristol in Großbritannien."

Seit über 15 Jahren beschäftigt sich der in Berlin geborene Australier damit, wie Menschen mit falschen Informationen umgehen. Den Anstoß dafür gab der Irak-Krieg im Jahr 2003.

"Ich habe damals in Australien gewohnt und jeden Morgen, als wir aufgestanden sind, gab es Nachrichten aus dem Kriegsgebiet und die erste Nachricht hieß immer, dass irgendwelche chemischen Waffen gefunden worden sind, und die nächste Nachricht hieß: Das war ein falscher Alarm."

Massenvernichtungswaffen, die der Irak angeblich besitzt, sind der Vorwand, mit dem die US-amerikanische Regierung unter George Bush den Krieg vorantreibt.

"Ich habe damals in Australien gewohnt und jeden Morgen, als wir aufgestanden sind, gab es Nachrichten aus dem Kriegsgebiet und die erste Nachricht hieß immer, dass irgendwelche chemischen Waffen gefunden worden sind, und die nächste Nachricht hieß: Das war ein falscher Alarm."

Massenvernichtungswaffen, die der Irak angeblich besitzt, sind der Vorwand, mit dem die US-amerikanische Regierung unter George Bush den Krieg vorantreibt.

"I take the fact that he has weapons of Mass destruction very seriously." (George W. Bush, ehemaliger US-Präsident)

Die Vereinten Nationen versagen ihre Unterstützung. Die Bush-Regierung entscheidet sich für einen Alleingang. Innerhalb von Wochen ist der Irak erobert. Amerikanische Soldaten suchen nach Massenvernichtungswaffen, finden aber dann doch nie welche. Stephan Lewandowsky:

"Das hat mich fasziniert, denn die Frage taucht dann auf, was machen dann Leute, wenn sie dauernd so etwas hören, und dann wird es wieder negiert und dann kommt es am nächsten Tag wieder und dann wieder nicht und so weiter und so weiter."

Gemeinsam mit Kollegen führt Stephan Lewandowsky eine internationale Studie durch, in der er Amerikaner, Australier und Deutsche zu Informationen aus der Kriegsberichterstattung befragt.

Gemeinsam mit Kollegen führt Stephan Lewandowsky eine internationale Studie durch, in der er Amerikaner, Australier und Deutsche zu Informationen aus der Kriegsberichterstattung befragt.

"Das heißt, wir haben Leute gefragt: Habt ihr von diesem Ereignis gehört? Und dann haben die Leute meistens gesagt: Ja, ja das war in den Nachrichten. Dann haben wir gefragt. Wisst ihr, ob das korrigiert worden ist? Und dann in manchen Fällen haben die Leute gesagt: Ja richtig, da war eine Korrektur im Fernsehen, das stimmt also nicht. Und ein paar Sekunden später haben wir gefragt: Ja glaubt ihr, dass das stattgefunden hat? Ja klar!

Das war ein Aha-Erlebnis, dass in Amerika Leute gesagt haben, sie glauben, was sie wissen, was falsch ist. Vor allen Dingen, weil das in unseren anderen Ländern, wo wir auch die gleiche Untersuchung gemacht haben, nämlich in Deutschland und Australien, nicht der Fall war."

Das war ein Aha-Erlebnis, dass in Amerika Leute gesagt haben, sie glauben, was sie wissen, was falsch ist. Vor allen Dingen, weil das in unseren anderen Ländern, wo wir auch die gleiche Untersuchung gemacht haben, nämlich in Deutschland und Australien, nicht der Fall war."

Das Weltbild bestimmt, was wir für wahr halten

Bei Deutschen und Australiern funktioniert die Korrektur. Die zweite Information hilft ihnen, die erste als Falschmeldung zu erkennen und vor allem, sie auch entsprechend zu behandeln. Warum funktioniert das bei den befragten Amerikanern nicht?

"Wir waren dann in der Lage diesen Unterschied zwischen den Ländern dadurch zu erklären, dass die Deutschen und Australier skeptischer waren über die Motivation hinter dem Krieg."

Über Jahre hinweg haben die Amerikaner in Dauerschleife gehört, der Irak habe Massenvernichtungswaffen, der Irak sei eine Gefahr, der Irak bedrohe die USA. In Deutschland glauben dagegen die meisten, es ginge den USA um die Kontrolle der Ölvorkommen des Irak. In Australien gilt der Krieg als Mittel, die Diktatur zu beenden. Für Deutsche und Australier passt es ins Konzept, dass keine Massenvernichtungswaffen gefunden werden. In den USA geht es Vielen genau umgekehrt. Die falschen Informationen über Waffenfunde passen zu dem, was sie erwarten. Deshalb bleiben sie bei dem, was sie zu wissen meinen. Lewandowsky:

"Das Problem ist, dass Leute tatsächlich das, was sie als erstes hören, zunächst einmal am meisten glauben, und das dann zu korrigieren, ist systematisch schwer. Wir als Menschen haben ein ganz starkes Bedürfnis, ein Modell im Kopf zu haben von der Welt, was erklärt, was sich abspielt. Und wenn mir jetzt einer sagt, die eine Komponente von dem Modell ist falsch, dann ist das sehr schwer für mich das aufzugeben. Dann ist ja ein großes Loch in meiner Erklärung der Welt."

"Wir waren dann in der Lage diesen Unterschied zwischen den Ländern dadurch zu erklären, dass die Deutschen und Australier skeptischer waren über die Motivation hinter dem Krieg."

Über Jahre hinweg haben die Amerikaner in Dauerschleife gehört, der Irak habe Massenvernichtungswaffen, der Irak sei eine Gefahr, der Irak bedrohe die USA. In Deutschland glauben dagegen die meisten, es ginge den USA um die Kontrolle der Ölvorkommen des Irak. In Australien gilt der Krieg als Mittel, die Diktatur zu beenden. Für Deutsche und Australier passt es ins Konzept, dass keine Massenvernichtungswaffen gefunden werden. In den USA geht es Vielen genau umgekehrt. Die falschen Informationen über Waffenfunde passen zu dem, was sie erwarten. Deshalb bleiben sie bei dem, was sie zu wissen meinen. Lewandowsky:

"Das Problem ist, dass Leute tatsächlich das, was sie als erstes hören, zunächst einmal am meisten glauben, und das dann zu korrigieren, ist systematisch schwer. Wir als Menschen haben ein ganz starkes Bedürfnis, ein Modell im Kopf zu haben von der Welt, was erklärt, was sich abspielt. Und wenn mir jetzt einer sagt, die eine Komponente von dem Modell ist falsch, dann ist das sehr schwer für mich das aufzugeben. Dann ist ja ein großes Loch in meiner Erklärung der Welt."

Umfragen aus den letzten Jahren belegen, dass vier von zehn US-Amerikanern immer noch der Meinung sind, der Irak hätte im Jahr 2003 Massenvernichtungswaffen besessen. Und das trotz Richtigstellung durch Politiker und Medien. Lewandowsky:

"Wenn jetzt aber einer kommt und sagt: Moment mal, es stimmt nicht, aber hier ist eine Alternative, die auch alles erklärt, da geben die Leute dann die ursprüngliche Information auf."

"Wenn jetzt aber einer kommt und sagt: Moment mal, es stimmt nicht, aber hier ist eine Alternative, die auch alles erklärt, da geben die Leute dann die ursprüngliche Information auf."

Wahrheitsfindung im mutigen Selbstversuch

Nachdem 30 Jahre lang die Säure-Hypothese unangreifbar gewesen war, lieferte Barry J. Marshall eine solche alternative Erklärung für die Entstehung von Magengeschwüren.

Bei der Verleihung des Nobelpreises, den er im Jahr 2005 erhielt, erinnert er sich an das Schlüsselexperiment, das Ärzte zum Umdenken brachte: "Die einzige Person auf der Welt, die im Bewusstsein des Risikos eine Einverständniserklärung dafür geben konnte, Helicobacter-Bakterien zu trinken, war ich. Ich musste also an meinem eigenen Experiment teilnehmen."

Innerhalb weniger Tage bekommt er ein Geschwür, das er mit Antibiotika wieder heilt. Nachfolgende Untersuchungen zeigen: Auch die Neutralisierung der Magensäure hilft, weil der veränderte PH-Wert es für die Bakterien ungemütlich macht. Marshall:

"Meine Vorgesetzen haben mich unterstützt. Irgendjemand musste ja die Endoskopie an mir durchführen. Der Chef der Mikrobiologie hat geholfen, die Bakterien anzuzüchten. Ich hatte also moralische Unterstützung."

Innerhalb weniger Tage bekommt er ein Geschwür, das er mit Antibiotika wieder heilt. Nachfolgende Untersuchungen zeigen: Auch die Neutralisierung der Magensäure hilft, weil der veränderte PH-Wert es für die Bakterien ungemütlich macht. Marshall:

"Meine Vorgesetzen haben mich unterstützt. Irgendjemand musste ja die Endoskopie an mir durchführen. Der Chef der Mikrobiologie hat geholfen, die Bakterien anzuzüchten. Ich hatte also moralische Unterstützung."

Ohne die Unterstützung etablierter Kollegen hätte die Geschichte aber auch anders ausgehen können.

"Während meiner gesamten Reise hatte ich den Vorzug herrlichen Wetters. Und da der Sommer jetzt in voller Schönheit ist, genoss ich die Freude der guten Aussicht." (Letters of Lady Mary Montague)

Cailin O'Connor: "Lady Mary Wortley Montagu war eine britische Aristokratin. Sie lebte im 18. Jahrhundert und reiste mit ihrem Mann, der Botschafter war, als junge Frau in die Türkei. Dort lernte sie die Variolation kennen. Eine medizinische Anwendung, die in England damals noch unbekannt war."

"Ich werde dir jetzt etwas erzählen, das dich wünschen lassen wird, du wärest selbst hier. Die Pocken, so verheerend und allgegenwärtig bei uns, sind hier gänzlich harmlos durch eine Erfindung, die hier Variolation genannt wird." (Lady Mary Montague)

Cailin O'Connor: "Dafür wurde der Haut des Patienten ein Kratzer zugefügt. In den Kratzer wurde Material aus den Pusteln eines Pockenerkrankten geschmiert. Das ist im Prinzip eine Impfung mit abgeschwächten Viren. Die Patienten, an denen Variolation durchgeführt wurde, machten eine leichte Form der Krankheit durch und waren danach immun."

"Du wirst dir vorstellen, wie erfreut ich über die Sicherheit dieses Experimentes bin, denn ich plane es an meinem lieben, kleinen Sohn durchzuführen. Ich bin Patriotin genug, um keine Mühen zu scheuen, diese nützliche Erfindung auch in England in Mode zu bringen." (Lady Mary Montague)

Die kluge Strategie der Lady Montague

Und mühsam wurde es. Bei ihrer Rückkehr nach England stieß Lady Mary bei den britischen Ärzten mit ihrer Idee auf wenig Gegenliebe. Die empirische Evidenz war auf ihrer Seite. Mehr aber auch nicht. Sie war eine Frau, die sich in eine Männerdomäne einmischen wollte. Sie war kein Arzt und sie setzte sich für eine Methode ein, die aus einem fremden Land kam und von "Heiden" praktiziert wurde – quasi ein okkultes Ritual. Alles zusammen keine guten Voraussetzungen, um als glaubwürdig zu gelten. Cailin O'Connor:

"Wir haben verschiedene unterbewusste Regeln, die uns helfen zu entscheiden, wem und was wir glauben. Eine einleuchtende Regel ist, dass wir aufhören auf Menschen zu hören, die oft falsche Informationen verbreiten. Wir glauben denen, die unseren Respekt genießen oder Experten sind. Etwas anderes, das wir tun, ist, denen zu glauben, die so sind wie wir. Die sich über ähnliche Dinge definieren, die gleiche Meinung haben."

Wer etwas sagt, kann mehr Einfluss haben, als der Inhalt dessen, was gesagt wird. Nachdem Lady Mary mit Argumenten bei ihren Landsleuten gescheitert war, versuchte sie es anders. Sie trank Tee in guter Gesellschaft und redete mit ihresgleichen: Müttern, die sich wünschten, dass ihre Kinder gesund blieben. Cailin O'Connor:

"Sie überzeugte Prinzessin Karoline von Ansbach, die Gemahlin des Königs, ihre beiden kleinen Töchter einer Variolation zu unterziehen. Und zwar öffentlich. Was das bewirkte, war zum einen: Die Leute sahen, dass die Methode sicher war. Zum anderen – und das war wahrscheinlich viel wichtiger – machte es die Immunisierung interessant als etwas, das eine extrem einflussreiche Person, der man nahestehen wollte, auch tat. Es wurde salonfähig."

"Sie überzeugte Prinzessin Karoline von Ansbach, die Gemahlin des Königs, ihre beiden kleinen Töchter einer Variolation zu unterziehen. Und zwar öffentlich. Was das bewirkte, war zum einen: Die Leute sahen, dass die Methode sicher war. Zum anderen – und das war wahrscheinlich viel wichtiger – machte es die Immunisierung interessant als etwas, das eine extrem einflussreiche Person, der man nahestehen wollte, auch tat. Es wurde salonfähig."

Erst 80 Jahre später entwickelte der englische Landarzt Edward Jenner ausgehend von der Variolation eine modernere Schutzimpfung. 1980 erklärte die WHO die Welt für pockenfrei. Eine wissenschaftliche Erfolgsgeschichte, zu der Lady Mary nicht unerheblich beigetragen haben dürfte – mit einer vollkommen unwissenschaftlichen Methode. Cailin O'Connor:

"Sie war wirklich klug und hat die ungeschriebenen Regeln sozialen Vertrauens genutzt."

"Sie war wirklich klug und hat die ungeschriebenen Regeln sozialen Vertrauens genutzt."

Im Zweifel geht Vertrauen vor Objektivität

Wem wir glauben, bedingt, was wir wissen. Natürlich wollen wir alle von uns denken, dass wir eher auf die fundierte Meinung eines Experten setzen als auf die irgendeines Promis. Dass wir gute Argumente vor Emotionen setzen. Dass wir seriöse Nachrichten lesen statt Trump-Tweets. Tun wir vielleicht auch, aber im Zweifel geht Vertrauen vor Objektivität. Welche Folgen diese soziale Selektion von Informationsquellen im Extremfall haben kann, zeigt Cailin O'Connor mit ihrer simulierten Gesellschaft am Computer.

"Unsere Annahme war, dass Informationen, die man von jemandem bekommt, der anders ist als man selbst, als weniger zuverlässig eingestuft werden. Der Effekt auf die eigene Überzeugung ist nicht so stark, wie wenn jemand etwas sagt, dem wir wirklich vertrauen. Und was wir beobachtet haben, ist: Ein Bisschen dieser ungleich verteilten Skepsis reicht aus, das Netzwerk zu polarisieren. Es entstehen zwei Lager, die unterschiedliche Ansichten vertreten und einander so wenig glauben, dass sie niemals einen Konsens erreichen werden."

Das Ergebnis sind gesellschaftliche Glaubenskriege. Evolutionstheorie versus Kreationismus, Klimaschützer versus Klimawandelleugner, Homöopathen versus Schulmediziner, Impfskeptiker versus Impfbefürworter. Anfang der 80er-Jahre entdeckt Harald zur Hausen, dass Infektionen mit Humanen Papillomviren, kurz HPV, Gebärmutterhalskrebs verursachen können. 2006 wird der erste Impfstoff gegen HPV zugelassen. Schätzungen zufolge sollten bis zu 5 Prozent der weltweiten Krebsfälle durch HPV-Impfungen zu vermeiden sein. In vielen Ländern wird eine Impfempfehlung ausgesprochen. So auch 2013 in Japan.

"Eine Woche nachdem die HPV-Impfung ins Nationale Impfprogramm aufgenommen wurde, gab es seine Pressekonferenz, auf der Videos von angeblichen Impfschäden gezeigt wurden."

Riko Muranaka ist Ärztin und Journalistin. Die Bilder der Mädchen, die teilweise unter schlimmen Krampfanfällen leiden, schockieren sie. Sie bezweifelt nicht, dass Impfschäden vorkommen können. Einen direkten Zusammenhang der beschriebenen Fälle zu HPV-Impfungen kann sie aber nicht entdecken:

"Die als Impfschäden dargestellten Symptome haben im Durchschnitt erst 380 Tage nach der ersten Impfung eingesetzt, im Extremfall erst fünf Jahre später. Die Impfschäden können sich angeblich in hundert verschiedenen Symptomen äußern, irgendwann im Laufe des Lebens auftreten und unheilbar sein. Es ist eine Hypothese, für die es keinerlei wissenschaftliche Evidenz gibt, die aber Angst macht, leicht zu glauben ist und leicht zu verbreiten."

Impf-Skepsis ohne wissenschaftliche Evidenz

HPV-Impfstoffe sind in über 100 Ländern zugelassen. Mehrere Millionen Frauen weltweit sind geimpft. Aufgrund von Placebo kontrollierten Studien und Überwachungsprogrammen wird die Impfung als gut verträglich eingeschätzt. Die japanische Regierung beauftragt trotzdem eine Untersuchungskommission und zieht die nationale Impfempfehlung bis auf Weiteres zurück.

Seitdem ist die HPV-Impfrate in Japan von 70 Prozent auf unter ein Prozent gefallen – obwohl die Impfung weiter erhältlich und kostenlos ist. Stephan Lewandowsky:

"Was sehr wichtig ist in solchen kontroversen Situationen, wo die Öffentlichkeit sich an anderen orientieren muss, ist, dass man die Geschlossenheit der Wissenschaft darstellt. Denn wenn die Experten sich streiten, dann weiß man nicht, was ist hier die Realität. Und darum ist es auch systematisch der Fall, dass die Gegner aus politischen Gründen versuchen, eine wissenschaftliche Debatte zu erfinden, damit die Öffentlichkeit glaubt, dass sich die Wissenschaftler nicht einig sind."

Seitdem ist die HPV-Impfrate in Japan von 70 Prozent auf unter ein Prozent gefallen – obwohl die Impfung weiter erhältlich und kostenlos ist. Stephan Lewandowsky:

"Was sehr wichtig ist in solchen kontroversen Situationen, wo die Öffentlichkeit sich an anderen orientieren muss, ist, dass man die Geschlossenheit der Wissenschaft darstellt. Denn wenn die Experten sich streiten, dann weiß man nicht, was ist hier die Realität. Und darum ist es auch systematisch der Fall, dass die Gegner aus politischen Gründen versuchen, eine wissenschaftliche Debatte zu erfinden, damit die Öffentlichkeit glaubt, dass sich die Wissenschaftler nicht einig sind."

Das ist nicht besonders schwierig, denn Unsicherheit gehört ja zur Wissenschaft dazu. Um mit wissenschaftlichen Belegen eine falsche Idee zu untermauern, muss man nur die richtigen Studien aussuchen, sie in Szene setzen und die übrigen ignorieren: Die Tabak-Industrie veröffentlichte jahrzehntelang Forschungsergebnisse, die keinen Zusammenhang zwischen Rauchen und Krebs fanden. Alle anderen kehrten sie unter den Teppich. Eine Studie zeigte einen Zusammenhang zwischen Masern-Impfungen und Autismus. 17 weitere konnten ihn nicht finden. Die Masern-Autismus-Studie wurde zurückgezogen, aber die Impfquote in Großbritannien brauchte 12 Jahre, um sich zu erholen.

Kann man lernen, Falschinformationen zu erkennen?

Aktuell untersucht Stephan Lewandowsky ob wir lernen können, Falschinformation zu erkennen, ohne tiefgreifendes Expertenwissen zu haben. Dafür absolvieren die Versuchsteilnehmer 10-minütige Trainings, in denen sie üben, Informationen kritisch zu hinterfragen. Die ersten Ergebnisse sind vielversprechend.

Können wir doch noch lernen zu glauben, was wir wissen? Lewandowsky: "Wenn es wirklich so wäre, dass man Leute nie korrigieren könnte, dann müsste man ja Universitäten und Schulen zumachen. Natürlich lernen Leute etwas."

Können wir doch noch lernen zu glauben, was wir wissen? Lewandowsky: "Wenn es wirklich so wäre, dass man Leute nie korrigieren könnte, dann müsste man ja Universitäten und Schulen zumachen. Natürlich lernen Leute etwas."

Wissen entsteht, weil wir anderen glauben. Irrtum nicht ausgeschlossen. Cailin O'Connor: "Im Laufe der Geschichte ist eine anerkannte Theorie immer wieder von einer neuen abgelöst worden. Und das wird sicherlich auch für viele der Dinge gelten, an die wir heutzutage glauben. Wir wissen nicht, welche der Dinge, die wir glauben, nicht stimmen. Es steht also fest, jeder von uns sitzt irgendwo einem Irrtum auf. Ich habe mein Bestes gegeben, gut belegte Annahmen darüber zu treffen, wie Unwahrheit entsteht. Aber es ist gut möglich, dass etwas, was ich Ihnen heute gesagt habe, falsch ist. Sie sollten mir also nicht hundert Prozent vertrauen. Sie sollten ein bisschen skeptisch sein."