Das Urheberrecht an das digitale Zeitalter anzupassen, faire Bezahlung für Kreative und Rechteinhaber: Das waren unter anderem die Ziele, die das Europaparlament mit der Vorlage der neuen Urheberrechtsrichtlinie erreichen will. Ende März wird das EU-Parlament darüber beschließen. Doch ein Artikel der Richtlinie bringt reichlich Kritiker auf die Palme.

Es ist Artikel 13. Er bestimmt, dass Diensteanbieter, die Werke in großem Umfang speichern oder öffentlich zugänglich machen, in Absprache mit den Rechteinhabern geeignete Maßnahmen ergreifen müssen, um sicherzustellen, dass – vereinfacht gesagt – die Rechte der Urheber nicht verletzt werden. Das soll für Dienste gelten, die eine gewisse Größe überschreiten oder länger als drei Jahre am Markt aktiv sind.

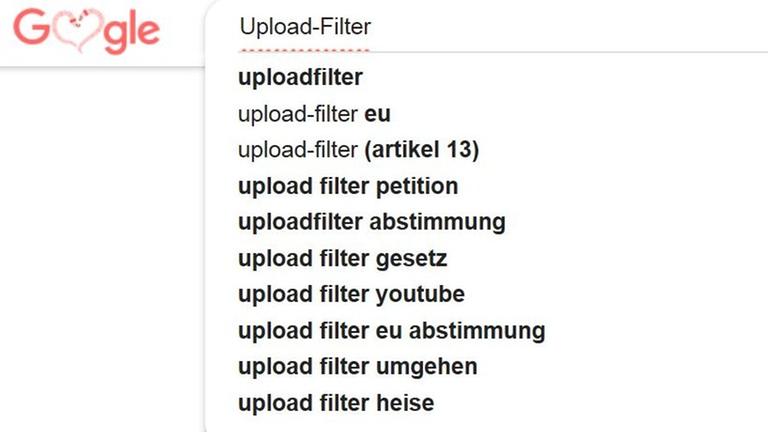

Dabei stellt sich zunächst die Frage, wie wahrscheinlich ist es denn, dass der Artikel 13 wirklich zur Etablierung von Inhalts- beziehungsweise Uploadfiltern führt?

An dieser Fragen scheiden sich die Geister. Im Gesetzesentwurf heißt es, dass unter Umständen notwendige "Inhaltserkennungstechniken geeignet und angemessen sein" müssen. Explizit nach Filtern verlangt der Text in seiner derzeitigen Form nicht. Der Artikel verlangt aber nach Absprachen zwischen Rechteinhabern und den Plattformen.

Die Kritiker befürchten die Einführung sogenannter Uploadfilter, die Befürworter hingegen argumentieren, eine Einigung sprich Lizenzierung der Inhalte und wirksame Durchsetzung der Einigung mache solche Filter überflüssig.

Ob es wirklich zu solch Uploadfiler zum Einsatz kommen werden, hängt auch davon ab, wie wirksam sie aus technischer Sicht sind.

"Das Abgleichen von verschiedenen Inhalten funktioniert sehr gut"

Wenn es nur darum geht, Texte, Bilder, Musik oder Videos abzugleichen, dann ginge das schon ganz gut, erklärt der promovierte Informatiker Frank Pallas. Er forscht an der Technischen Universität Berlin zu interdisziplinären Fragen moderner Informationssysteme und -technologien.

"Was technische Systeme heute schon sehr gut können, ist Inhalte abzugleichen auf Basis von verschiedenen Verfahren, die dann meistens speziell auf den jeweiligen Inhalt hin entwickelt werden", sagt der Informatiker Frank Pallas von der Technischen Universität Berlin. Erkennen sei dann noch eine andere Geschichte, weil dann immer die Frage sei, was man erkennen soll. "Aber gerade das Abgleichen von verschiedenen Inhalten funktioniert sehr gut auch in gewissen Unschärfen."

Daher: Festzustellen, ob Video A eine Kopie oder Variante von Video B ist, das fällt mit heutigen Technologien nicht schwer. Bei Musik, Fotos und Text ist es sogar noch deutlich einfacher. Dennoch sind die Systeme und die zugehörigen Datenbanken so komplex, dass solche Werkzeuge heute vor allem bei den großen Internetplattformen zum Einsatz kommen – zum Beispiel bei Googles Videoplattform YouTube. Dort heißt die Technik ContentID, die in drei Stufen entwickelt wurde.

2007 begann es mit der Erkennung von Musik, später kamen dann Videos hinzu. Seit 2010 kann Google auch Melodien identifizieren. Das System erkennt sie selbst dann, wenn sie in einer etwas anderen Form mit anderen Instrumenten gespielt werden.

"Grundsätzlich ist aber bei all diesen genannten Optionen jetzt die Technologie sehr ähnlich. Es wird von den Ursprungsdateien eine Referenzdatei erstellt, ein sogenannter Hash, der dann hinterlegt wird bei uns in der Datenbank und neu hochgeladene Videos bei YouTube werden dann mit dieser Datenbank abgeglichen", sagt Google-Sprecher Ralf Bremer. Das sei eine riesige Datenbank mit inzwischen Millionen von Referenzdateien natürlich. Eine riesige Infrastruktur die da im Hintergrund ablaufe.

Doch auch diese riesige Infrastruktur hat ihre Grenzen, wie Bremer ausführt:

"Die Grenzen sind für uns natürlich insbesondere dadurch definiert, was die Rechteinhaber uns an Material zur Verfügung stellen. Wenn die Referenzdateien entsprechend qualitativ hochwertig sind, ist natürlich die Zuverlässigkeit der Erkennung dann entsprechend hoch."

"Da bin ich doch sehr, sehr skeptisch"

Hier geht es jetzt jedoch nur um unveränderte Medien. Beispielsweise, wenn ein Musikvideo von einem Fan hochgeladen wird oder jemand einen Song als Begleitung für sein Video verwendet. Kompliziert wird es, wenn Teile aus Medien verwendet werden: Einzelne Sequenzen, manipulierte Ausschnitte. Denn dann ändere sich die Datei fundamental, erklärt Linus Neumann, Sprecher des Chaos Computer Clubs, in Bezug auf Videos: "Wir brauchen also Algorithmen, die die Essenz des Videos verstehen, die also die Kontraste hochziehen, versuchen die Bildsequenzen zu erkennen und daraus ein Maß zu entwickeln, was resistent ist gegen Größenänderungen des Videos, Ränder drumherum machen, Farbe ändern, Ausschnitte machen."

Das Vergleichen von zwei Dateien sei jedoch relativ komplexer Vorgang. Dieser Prüfvorgang sei, wie alle Prüfvorgänge, natürlich fehleranfällig, so Neumann.

Noch komplizierter und aufwändiger und in gewisser Hinsicht aussichtsloser wird es für die Filter- und Erkennungssyteme, wenn man Fremdmaterial erlaubt nutzt. Frank Pallas von der TU-Berlin sagt: "Ist das jetzt eine Parodie gewesen? Ist es jetzt vielleicht auch einfach ein Zitat gewesen? Und all solche Dinge. Das ist jedenfalls nach meiner Kenntnis noch nicht mal in den Kinderschuhen geschweige denn irgendwie in einer anwendbaren Form."

Große Hoffnungen, vor allem seitens der Befürworter von Artikel 13, liegen auf Künstlicher Intelligenz. So schrieb beispielsweise die Verwertungsgesellschaft Gema auf Twitter, KI könne heute sogar selbstständig einparken. Da sollte es ein leichtes sein, zwischen Original und Parodie zu unterscheiden.

"Ja, es ist möglich, mit Künstlicher Intelligenz das eine oder andere zu erkennen", sagt Pallas, "aber was tatsächlich eine auch nur ansatzweise verlässliche Erkennung von Parodien, von Dingen die vom Zitatrecht gedeckt sind und so weiter, da bin ich doch sehr skeptisch".

Und auch Neumann mein, dass "das Argument, dass diese Aufgabe von künstlicher Intelligenz bewältigt werden könnte, zeigt wirklich, dass die Menschen nicht verstanden haben, wie künstliche Intelligenz funktioniert und wie nicht."

Alternative zu den Filtersystemen

Auch das Science Media Center noch weitere Statements eingeholt. Und gleichlautend meinen alle befragten Forscher: nach derzeitigem Stand der Technik wird zum Einen erlaubte Nutzung nicht korrekt erkannt werden und zum Anderen wird KI daran nichts ändern.

Doch die Kritik an Artikel 13 reicht noch weiter. Vor allem die Angst vor einer Etablierung einer Zensurinfrastruktur sticht hervor. Auch hier sind sich die Experten überwiegend einig, dass durch die Einrichtung solcher Filter gleichzeitig die Infrastruktur geschaffen wird, auch Inhalte gezielt zu filtern. Das mag derzeit im Großteil Europas eine lächerliche Angst sein, doch extreme politische Positionen werden immer erfolgreicher.

Linus Neumann vom CCC weist zudem darauf hin, dass es bereits aktuell Bestrebungen gebe, Terror-verherrlichende und ähnliche Inhalte zu filtern. Zur Filterung von Meinungen oder missliebigen Inhalten sei es dann nicht mehr weit. Daher: ist einmal eine entsprechende Infrastruktur aufgebaut, ist dem Dual Use, also der weiteren auch negativen Nutzung Tür und Tor geöffnet.

Dabei sind solche Filtersystemen nicht alternativlos. Einige Befürworter des Artikels 13 betonen, wenn die Verwerter und Rechteinhaber weitreichende Lizenzen erteilten und die Nutzer, also in dem Fall die Plattformen, gewillt sind, sich zu einigen und Gebühren zu zahlen, dann brauche es die Filter nicht. Weitere Vorschläge umfassen einfach zu erwerbende und zu prüfende Lizenzen zum Beispiel mit digitalen Wasserzeichen zur Erkennung.

Der Lizenzerwerb müsse trivial, also sehr einfach werden. Auch ein Vorschlag: ohne Filter vorzuschreiben sollten einfach umsetzbare Sanktionsmöglichkeiten gegen Urheberrechtsverstöße eingeführt werden, so dass sich von selbst ein Anreiz ergibt, derlei Verstöße entweder nicht zu begehen oder sie besser zu erkennen.