"In fast jedem Kriminalroman, seit den bewundernswerten Geschichten von Arthur Conan Doyle, kommt einmal der Moment, wo der große Detektiv das ganze Tatsachenmaterial gesammelt hat, das er – zumindest für eine bestimmte Phase seiner Untersuchung – braucht. Der Detektiv erkennt jedoch sofort, dass er auch durch bloßes Nachdenken eine sinnvolle Ordnung in das gesammelte Tatsachenmaterial bringen kann." (Albert Einstein und Leopold Infeld, "Die Evolution der Physik", 1938)

"Wir schalten Teleskope auf der ganzen Welt zusammen. Wir speichern das Radiolicht dann auf Festplatten und verarbeiten es dann in den Computern. Wir speichern drei, vier Petabyte an Daten. Das schicken wir dann in große Computer-Cluster. Dieses Material sieht oft recht verworren, unzusammenhängend und beziehungslos aus. Zum Beispiel die Teilchenphysik!

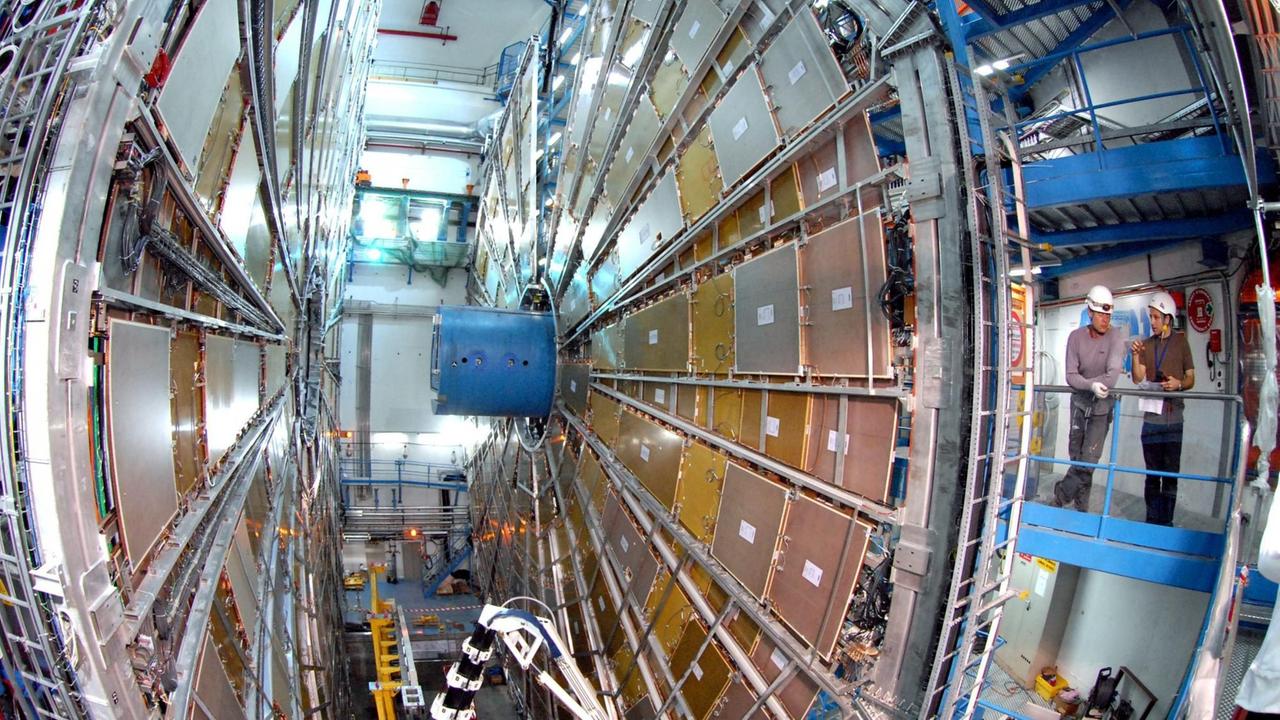

Am CERN gibt's Teilchenbeschleuniger, die nach bestimmten Kollisions-Ereignissen suchen. Das sind unglaublich viele Daten. Das kann man nicht mehr mit bloßem Auge machen. Man automatisiert das! Dadurch weiß man aber, dass man bestimmte Informationen komplett wegschmeißt. Und wenn da etwas ganz Exotisches wäre, was nur hin und wieder mal auftaucht, dann fällt das irgendwo ins Nirwana des Computers. Es wird gar nicht wahrgenommen. Das ist etwas, wo der Mensch natürlich mit seiner kreativen Art und seiner Neugier eben Dinge entdecken kann, die nicht geplant waren." (Heino Falcke, Astronom)

"Daten verdoppeln sich in der Wissenschaft alle 18 Monate, das ist die weltweite Datenlage in der Wissenschaft in jedem Feld. Das ist auch ein Trend, der sich seit über zehn Jahren ständig fortsetzt. Ohne Big Data können wir eigentlich gar keine komplexe Biologie mehr betreiben. Selbst kleine Labore erzeugen Daten im großen Stil und brauchen heutzutage Computer." (Jan Korbel, Molekularbiologe und Bioinformatiker)

"Die Nützlichkeit unnützen Wissens"

"Mein Lieblingsbeispiel ist Elektrizität. In den 1830er-Jahren spielte Michael Faraday mit Elektrizität. Er machte lustige Sachen, ließ Haare zu Berge stehen und sowas."

Audimax der Universität Bielefeld: Robbert Dijkgraaf – theoretischer Physiker und Direktor des Institute for Advanced Study in Princeton – erzählt über "die Nützlichkeit unnützen Wissens".

"Und einmal besuchte der Finanzminister Faradays Labor und fragte: Was ist der praktische Nutzen von Elektrizität? Und Faraday sagte: Ich weiß es nicht. Aber eines Tages werden Sie es besteuern!"

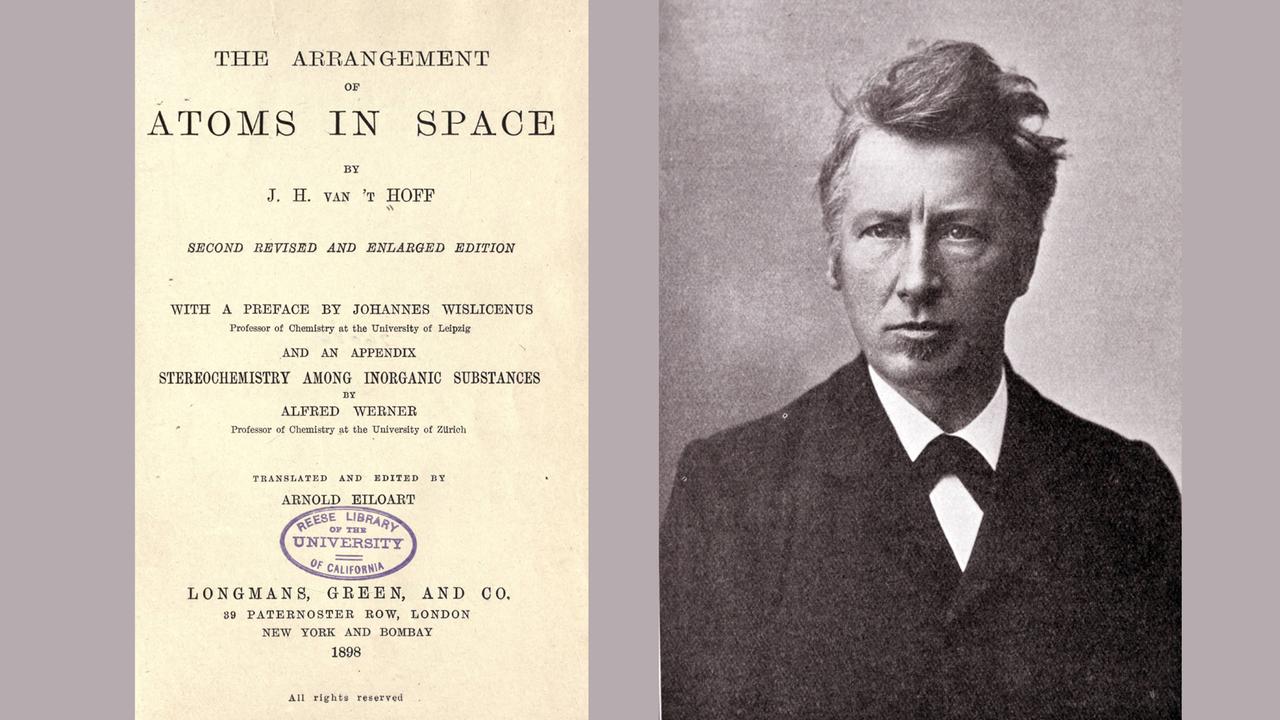

Es geht um die Fähigkeit, über das Sichtbare, Bestehende und Bekannte hinauszudenken. Auch der niederländische Chemiker Jacobus van‘t Hoff – der erste Nobelpreisträger für Chemie – war so ein Vordenker. Ende des 19. Jahrhunderts postulierte er unter anderem die räumliche Anordnung von Kohlenstoff-Atomen in Molekülen.

Die Fachwelt ignorierte van’t Hoffs Arbeiten zunächst, Kollegen witzelten. Van’t Hoff – so steht es zum Beispiel im "Journal für praktische Chemie" von 1877 – bekomme seine Ideen offenbar "auf dem durch kühnen Flug erklommenen chemischen Parnass. Ein Doktor van’t Hoff findet, wie es scheint, an exakter chemischer Forschung keinen Geschmack."

"Van‘t Hoff war so verletzt darüber, dass er wegen seines Einfallsreichtums kritisiert wurde! Für seine Antrittsrede an der Universität Amsterdam später hatte er sich deshalb die Biografien der 200 berühmtesten Wissenschaftler der letzten Jahrhunderte angesehen – Galileo, Newton und so weiter. Er unterteilte sie in drei Kategorien: erstens diejenigen ohne jeden Sinn für Fantasie. Dann die mit Fantasie und Interesse an Kunst, Musik und Literatur. Und drittens diejenigen mit überbordender Fantasie, die sich auch für abwegige Dinge interessierten, wie Astrologie oder Mystik. Van’t Hoffs Ansicht nach gehörten immerhin 15 der 200 wichtigsten Forscher in diese dritte Kategorie. Darunter Descartes, Leibniz, Newton. Also – ich würde sagen, die Top-15."

Rein abstraktes Denken bei Albert Einstein

Auch Albert Einstein entwickelte das Gerüst seiner Relativitätstheorie zunächst abseits der akademischen Welt. Als Angestellter im Berner Patentamt, nach Feierabend und an Sonntagen, im Austausch mit wenigen Freunden und seiner damaligen Frau Milena. Auch seine Gedanken schienen vielen Fachkollegen abwegig: dass es weder absoluten Raum noch absolute Zeit gibt, sondern Längen und Zeiten vom Bewegungszustand des Betrachters abhängen; dass Masse und Energie äquivalent sind; dass sich Gravitation als Eigenschaft einer gekrümmten Raumzeit beschreiben lässt. Robbert Dijkgraaf:

"Das ist so eine erstaunliche menschliche Leistung! Vor allem, weil Einstein in der Lage war, sie nahezu ohne Datengrundlage zu entwickeln. Es war rein abstraktes Denken! Maschinen analysieren sehr gut, wie Dinge funktionieren, aber nur Menschen fragen: ‚Warum‘? Die Gravitationstheorie zum Beispiel – nach Newton gab es ein paar hundert Jahre lang viele sorgfältige Experimente mit schweren Körpern und so weiter. Aber es blieb die Frage: Warum wirkt Gravitation? Darauf eine Antwort zu geben – das erfordert einen ganz neuen Blickwinkel. Einstein hatte den. Und das ist, was Menschen können: eine andere Perspektive einnehmen und Fragen stellen, die man nur fragen kann, wenn man sich außerhalb eines Systems begeben kann."

Nur – wie gelingt es, sich außerhalb eines Systems zu stellen? Und warum sollen das nur Menschen können? Neue Theorien brauchen oft Jahrzehnte, um sich durchzusetzen. Und haben sich Denk-Gebäude einmal etabliert, sind sie nicht so schnell zum Einsturz zu bringen. Ist es da nicht völlig plausibel, einen unbefangenen Blick auf vorliegende Phänomene gerade von Maschinen zu erwarten? Die sich nie irgendwo bewerben müssen, keine Empfehlungsschreiben brauchen, keine Interessen haben?

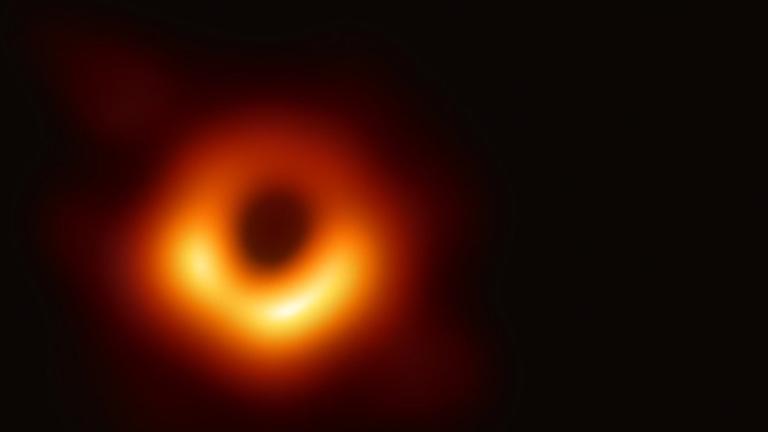

Das erste Bild eines Schwarzen Loches

Im April 2019 präsentiert das "Event Horizon Telescope"-Projekt das Bild eines Schwarzen Lochs. Sofort geht es um die Welt – auch wenn die Details der Interpretation durchaus umstritten sind. Heino Falcke, Astrophysiker an der Radboud-Universität Nijmegen:

"Das ist der Kern der Galaxie M87 – und dies ist das erste Bild eines Schwarzen Loches. Ein orangeroter Ring mit einem dunklen Fleck im Zentrum. Wir sehen, wie Licht in der Dunkelheit verschwindet, im Schatten des Schwarzen Lochs. Wir sehen, wie Licht abgebogen wird, sozusagen im Kreis fliegt, diesen fast perfekten Ring bildet. Und dadurch sind Schwarze Löcher nach Jahrzehnten der Abstraktion auf einmal Realität geworden."

Schwarze Löcher sind eine der Vorhersagen von Einsteins Relativitätstheorie. Dass sie tatsächlich existieren, zeigten als erste Andrea Ghez und Reinhard Genzel, die für ihre Beobachtungen im Zentrum unserer Milchstraße gerade den Nobelpreis erhalten haben. 2015 gelang der Nachweis von Gravitationswellen, verursacht durch die Kollision zweier Schwarzer Löcher. Jetzt noch das Bild eines dieser Schwerkraft-Ungetüme. Alles innerhalb weniger Jahre – und: 100 Jahre nachdem Einstein seine Gleichungen publiziert hatte. Jahre, die es brauchte, um die Theorie zu diskutieren; um die Experimente zu ihrer Prüfung zu entwickeln und die nötigen Geräte zu bauen – und um diese Geräte bedienen zu lernen und die Ergebnisse der Experimente auszuwerten.

Daten-Materialschlacht mit Computerclustern

"Wir brauchten ein Teleskop, so groß wie die Welt."

An der Abbildung des Schwarzen Lochs arbeitete ein 350köpfiges, internationales Forscherteam etwa 20 Jahre lang. Heino Falcke beschreibt die Zusammenarbeit in seinem Buch "Licht im Dunkeln":

"Wir schalten Teleskope auf der ganzen Welt zusammen, wir speichern das Radiolicht dann auf Festplatten; drei, vier Petabyte an Daten, an rohem Radiolicht. Das schicken wir dann durch große Computercluster, die synthetisieren das. Da müssen Bildverarbeitungsverfahren, da müssen Kalibrations-Algorithmen laufen. Also es ist rechenintensiv, in jeder Hinsicht sehr viel Material, Aufwand, so eine richtige Materialschlacht, wo auch alle Techniken zum Einsatz kommen."

Es ist ein langer Reifungsprozess – von der Theorie bis zu beobachtbaren Fakten, die die Theorie bestätigen oder widerlegen können. Die Methoden und die Technik, die zu dieser Prüfung nötig sind, werden auf diesem Weg oft überhaupt erst entwickelt.

Neue Instrumente, neue Erkenntnisse in der Astrophysik

"Okay, gehen wir zu einem anderen Gebäude." Heidelberg-Königstuhl, Sternwarte der Universität Heidelberg, Instrumentierungsabteilung. Unter Leitung von Walter Seifert werden hier astronomische Analyseinstrumente gebaut.

"Hier rein?" "Ja, hier rein. Nah-Infrarot-Spektrographen, optische Spektrographen, abbildende Systeme – alles das, was hinterm Teleskop, das als Lichtsammler fungiert, dranhängt. In dem Sinne ein Instrument, das aus dem Licht die astrophysikalische Information rauszieht – wie zum Beispiel hier, 4MOST; das wird ein Spektrograph fürs ESO-VISTA-Teleskop."

Eins der jüngsten Projekte an der Landessternwarte: die Bestätigung der Rotverschiebung des Lichts im Schwerefeld der Sonne. Ebenso wie Schwarze Löcher eine Konsequenz aus der Relativitätstheorie.

Der Astronom Hans-Günter Ludwig entwickelt an der Sternwarte Simulationen von Strömungs-Vorgängen auf der Sonne, die Rotverschiebungs-Effekte stören können: "Natürlich brauche ich Messdaten! Und ohne Leute wie Walter, der die Dinger baut, würde ich ziemlich bald auch am Ende sein. Heute ist vieles, was in der Astronomie geschieht, tatsächlich instrumentierungsgetrieben. Also wenn jetzt Gravity nicht gewesen wäre, hätte Reinhard Genzel wahrscheinlich nicht den Nobelpreis bekommen, ohne diese technischen Neuerungen. Oder Heino Falcke und Co. mit ihrem Bild vom Schwarzen Loch."

Und Walter Seifert ergänzt: "Oder auch mit CERN und so weiter, mit allen diesen Großforschungsprojekten ist es so: klar – neue Instrumentierung, neue Analyse-Instrumente. Damit kann man neue Wissenschaft machen."

Zirkelschluss-Gefahr beim Instrumentendesign

Gravity – die Technologie, die es ermöglicht, mehrere Teleskope zu einem virtuellen Großteleskop zusammenzuschalten – oder der Teilchenbeschleuniger am CERN sind nur zwei Beispiele: für fortgeschrittenes Engineering, das Daten generiert, die Antworten liefern sollen auf Fragen, die innerhalb eines theoretischen Rahmens auftauchen.

"Dann kommt natürlich genau diese Phase, wo genau definiert werden muss: Wie soll das Instrument aussehen, damit es alle wissenschaftlichen Anforderungen erfüllt?

"Wenn Sie hier einen Fehler machen, kann das ein Forschungsergebnis wesentlich verfälschen?" "Das könnte es. Deswegen ist es so – jetzt im Labor ist genau die Phase, wo wir Tests machen. Simulationen. Um zu sehen, ob das Instrument genau das macht, was es machen sollte. Ohne das geht auch kein Instrument – wird nicht freigegeben für wissenschaftliche Beobachtungen."

Hans-Günter Ludwig: "Wir haben zwar gesagt, dass wir die allgemeine Relativitätstheorie bestätigen, aber es ist eher so, dass wir an unseren Messungen gezweifelt hätten, wäre das nicht herausgekommen. Dass wir nicht so sehr die Relativitätstheorie in Zweifel ziehen, sondern eher die Frage des Messverfahrens."

Ein klarer theoretischer Rahmen bringt präzise Analyse-Instrumente hervor. Nur: besteht so nicht die Gefahr von Zirkelschlüssen? Man möchte etwas finden, von dem man annimmt, dass es existiert, man entwickelt Werkzeuge und Methoden, um es zu suchen und wenn man nichts findet, vermutet man, dass man falsch gemessen hat? Dass mehr Daten und noch feinere Werkzeuge nötig sind?

"Naja – wir erwarten natürlich Überraschungen. Natürlich haben wir eine ziemlich konkrete Vorstellung in dem bekannten Kontext, was wir erwarten. Aber wir hoffen ja, dass diese Messungen etwas jenseits des bekannten Kontexts uns liefern, sodass wir dort etwas Neues erleben."

Bestehende Theoriegebäude können blind machen

Der Wissenschaftshistoriker Thomas Kuhn schrieb 1962 in "Die Struktur wissenschaftlicher Revolutionen": Ein herrschendes Theoriegebäude werde so lange ausgearbeitet, bis es immer mehr Fragen gibt, die innerhalb dieses Paradigmas nicht mehr befriedigend beantwortet werden können. Dann werde es durch ein neues Paradigma ersetzt – allerdings erst nach einer Phase des Suchens. Denn: so wie eine Theorie ermöglicht, Dinge zu sehen, die vorher niemand gesehen hat – so kann sie auch blind machen für Dinge, die zwar existieren – aber nicht ins Theoriegebäude passen. Heino Falcke:

"Dann stellt man fest, zehn Jahre später: Wenn ich damals die richtige Frage gestellt hätte, hätte ich es damals schon entdecken können. Und dafür ist es wichtig, Daten zu speichern und immer wieder neu durchzuarbeiten."

59 Zetabytes umfasste Statistiken zufolge die Menge der Daten, die bis Dezember 2020 weltweit generiert, erfasst, kopiert und verarbeitet wurden. Das ist etwa das 60-millionenfache der Daten, die ein menschliches Gehirn speichern kann, und sie verdoppelt sich alle zwei bis drei Jahre. Die Chance ist groß, dass darin auch Hinweise auf Zusammenhänge stecken, die weit über bestehende Erkenntnisse hinausreichen.

Big Data und Supercomputer essentiell bei der Genom-Analyse

"Jetzt kommen wir in den Bereich unserer Sequenziermaschinen…" Europäisches Laboratorium für Molekularbiologie in Heidelberg. Jan Korbel, Genetiker und Bioinformatiker, führt durch die Laborräume seiner Arbeitsgruppe.

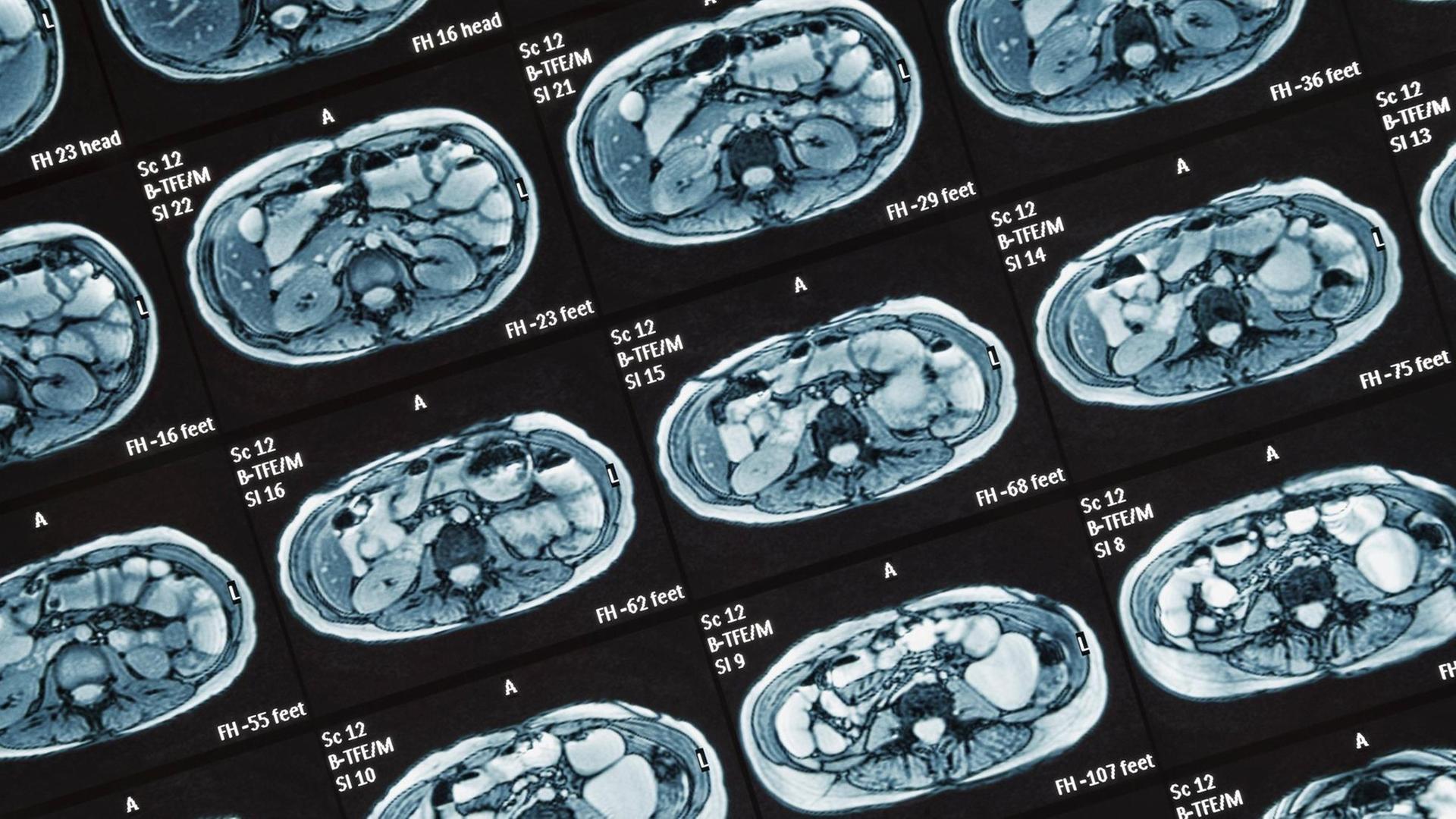

"Wir arbeiten jetzt schon mit Tausenden von menschlichen Genomen, vom Erbgut von Krebs-Patienten, und vergleichen die. Um dann mehr darüber zu erfahren: Wie kommt es zur Krebs-Entstehung? Wie kann ein Umwelteinfluss und ein erblicher Faktor, wie können die wechselwirken, damit es später zu Tumor-Entstehung kommt? Und das müssen sogar Programme machen, weil das Erbgut – es gibt so viele DNA-Bausteine, wie es Menschen gibt! Sechs Milliarden Bausteine! In jeder Zelle! Und darum brauchen wir Computerprogramme, um diesen Vergleich durchzuführen."

Biologie und Lebenswissenschaften wurden in den vergangenen Jahren durch "BigData" besonders verändert. "Next Generation Sequencing" vor etwa 15 und "Genom-Editing" vor etwa acht Jahren waren Meilensteine – inzwischen ist auch maschinelles Lernen unverzichtbar. Jan Korbel und sein Team entwickeln Algorithmen, die das Erbgut von Tumorzellen mit gesunden Zellen vergleichen. Diese Arbeit ist dabei fest verzahnt mit der "klassischen" Laborarbeit, zum Beispiel an Gewebeproben.

"Wir haben eine neue Methode entwickelt – die erste Methode weltweit – die es uns ermöglicht, in einzelnen Zellen, genomweit, nach Mutationen zu gucken. Um dann die Krebs-Mutagenese noch besser zu verstehen. Und da können wir das jetzt mit Mikroskopie verbinden und dann den Schluss schaffen, zwischen dem, was man seit über 100 Jahren schon im Mikroskop sieht – hier ist eine Zellteilung, die sieht irgendwie komisch aus – und einem in der DNA identifizierbaren Mutations-Prozess. Und diese Brücke können wir jetzt schlagen, was vor einigen Jahren undenkbar war."

DNA-Sequenzen entschlüsseln von unter dem Mikroskop gefundenen Zellveränderungen. Nahezu in Echtzeit. Bei tausenden Genomen mit je sechs Milliarden Basenpaaren. Kennt man die Mutationen, kann man Therapien anpassen. Das kann Leben retten. Ein enormer Fortschritt. Mehr müssen Maschinen nicht leisten. Und wenn doch: könnten sie es?

Wie kann eine "Künstliche Intelligenz" generalisieren?

Berlin Science Week, Anfang November 2020. Ein virtuelles Panel des Exzellenz-Clusters "Science of Intelligence" der Technischen und Humboldt-Universität Berlin. Marc Toussaint, Professor für Intelligente Systeme, spricht über verschiedene Arten maschinellen Lernens. Er stellt zwei Wege gegenüber, um aus Informationen Schlüsse zu ziehen. Dem einen folgen viele Deep Learning-Methoden: neuronale Netze durchsuchen und gewichten Daten nach bestimmten Zielvorgaben. Sie lernen sozusagen Merkmale auswendig und können dann als Antwort auf eine Frage auf Abruf ein passendes Beispiel liefern, etwa: Auch das ist ein Auto. Der andere Weg versucht, das Prinzip zu verstehen, das Fahrzeugen allgemein zugrunde liegen könnte. Letzteres nennt man üblicherweise "Denken". Dabei ist die interessante Frage: Wozu nützt "denken"? Und: wie unterscheiden sich Maschinen und Menschen in Bezug auf diese Fähigkeit?

"Der Begriff Generalisierung ist ganz wichtig in der KI und auch im maschinellen Lernen generell. Man stelle sich vor, ein System oder ein Mensch sieht einen Apfel von einem Baum fallen. Und was ziehen wir daraus? Das ist die große Frage. Wenn ich jetzt einige Daten, vielleicht Videos, hätte von Äpfeln, die vom Baum fallen und diese Videos in ein neuronales Netz eingebe und das neuronale Netz quasi darauf trainiere, in Zukunft vorherzusagen, ob ein Apfel fällt oder nicht, dann kann das neuronale Netz das sicher lernen und es wird in Zukunft sagen: Ja, hier ist ein roter Apfel am Baum, könnte fallen. Wenn ich als Gegenbeispiel nehme, dass da jetzt ein Mensch steht – und er sieht den Apfel fallen und was er daraus zieht, ist eine Theorie, ein Modell. Und diese Theorie und das Modell ist so abstrakt und so wunderbar, dass es auf so viel anwendbar ist und so viel mehr vorhersagen kann als einfach nur, dass Äpfel fallen. Weil es eben sehr, sehr viel stärker generalisiert."

In der Wissenschaft gilt eine Theorie als umso stärker, je umfassender die Voraussagen sind, die sich auf ihrer Grundlage treffen lassen. Sie entsteht aus der Fähigkeit, aus Beobachtungen Regeln abzuleiten. Die dann wiederum auch in anderen Bereichen anwendbar sind. Toussaint:

"Also, wenn ich denn jetzt Gravitation verstanden habe, wie komme ich denn jetzt darauf zu wissen, wie ich ein Haus bauen muss, damit das nicht zusammenfällt? Diese Lücke zu schließen, die ist hochkomplex. Und die leisten wir aber oft und das leisten wir mit dem, was wir als Denken bezeichnen. Und in diesem Sinne ist der wissenschaftliche Prozess eigentlich die tollste Form von Lernen, die neuronale Netze eigentlich so gar nicht haben."

"Wo sie aber hinkommen sollten?" "Ähm – ja. Genau. Wo sie hinkommen sollten."

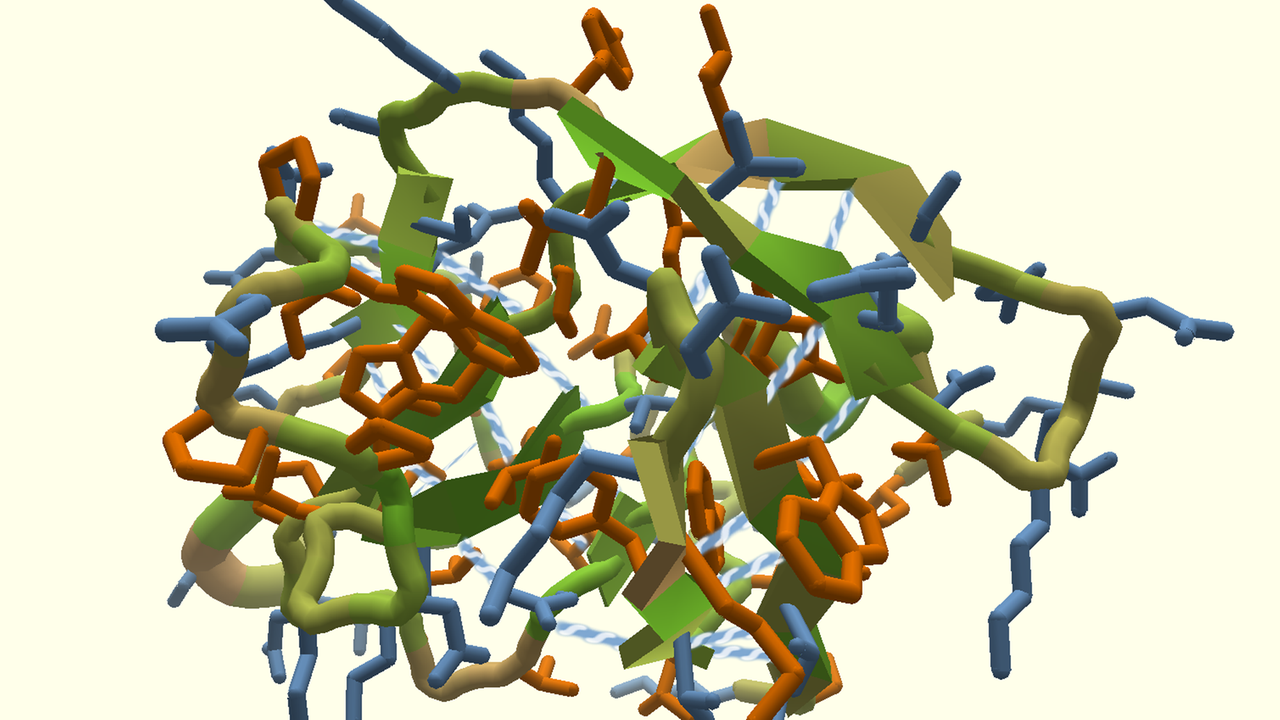

Durchbruch einer KI bei der Proteinfaltungs-Analyse?

Ende November 2020. Die KI-Firma DeepMind – wie Google ein Teil der Alphabet-Holding – feiert ihr neu entwickeltes Programm "AlphaFold" bei einer Pressekonferenz:

"Wie Sie vermutlich wissen – unsere Gruppe hat außerordentlich gut abgeschnitten beim CASP14-Wettbewerb; und zwar im Vergleich zu den anderen Gruppen als auch bei der Genauigkeit unseres Modells als solche. Es ist wirklich herausragend, ein großer Schritt vorwärts; geradezu unfassbar."

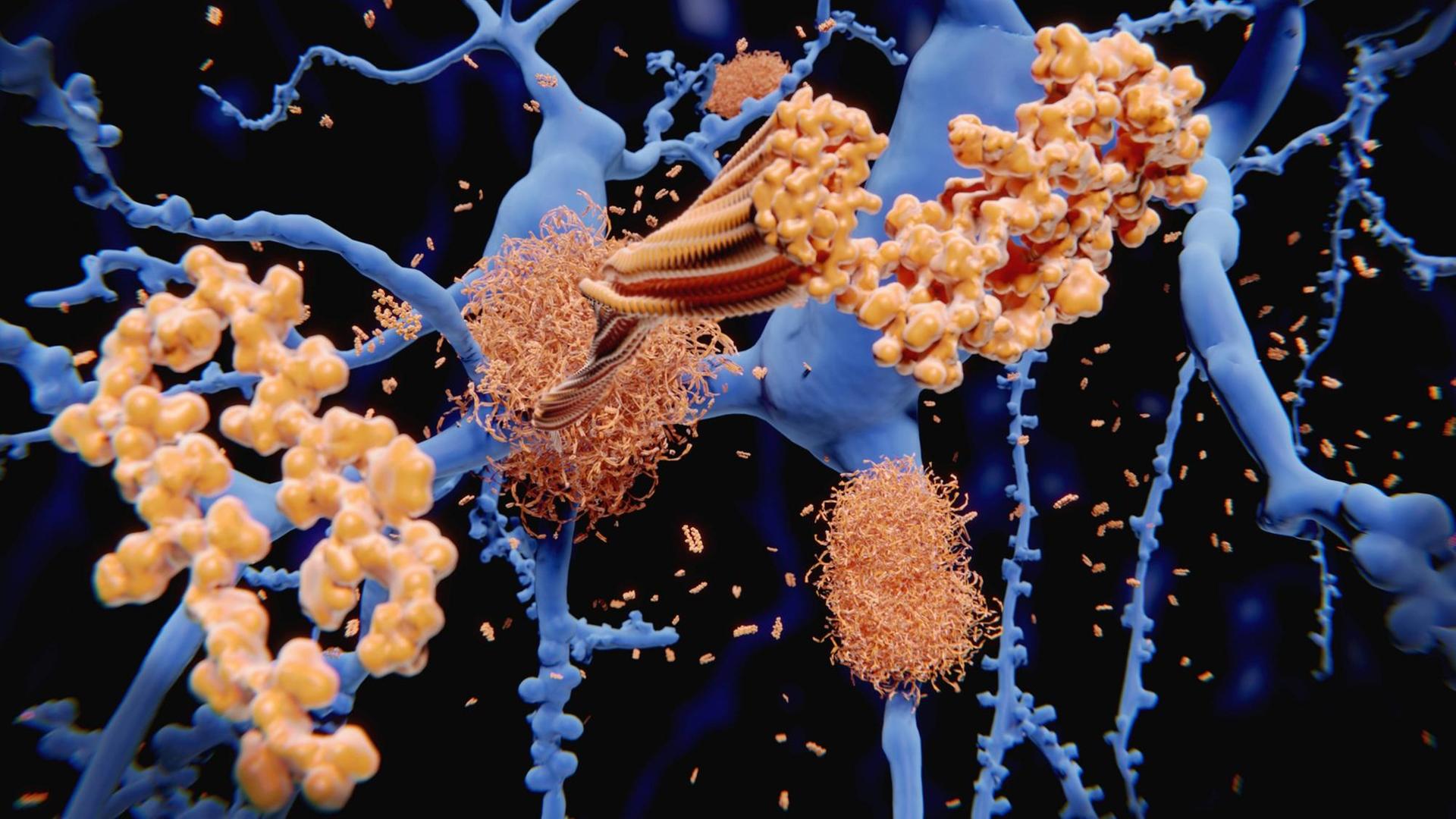

Es geht um das Problem der Proteinfaltung – seit mindestens 50 Jahren eine der größten Herausforderungen in der Biologie. Bioinformatiker Jan Korbel:

"Ich habe in meiner Uni-Laufbahn gelernt, das ist nicht lösbar. Und jetzt hat DeepMind es anscheinend gelöst. Wir müssen natürlich auf die Publikation warten, um zu sehen, ob das wirklich so mind-blowing ist, was sie da gemacht haben. Also – ein Protein ist eine Kette von Amino-Säuren, die ein Knäuel bildet. Und das Knäuel macht letztendlich die Funktion, die bewirkt, ob das Protein in der Nase einen Riech-Rezeptor ausbilden kann oder auch der Effekt, dass wir sehen können: das sind alles Proteine. Wie diese Faltung zustande kommt – das ist ein irrsinnig schweres Problem, weil einfach, man hat eine lange Kette von den Aminosäuren mit sehr vielen Möglichkeiten, wie jede Aminosäure mit der anderen wechselwirken kann. Wie das dann im dreidimensionalen Raum aussehen soll, konnte man bisher nicht zuverlässig vorhersagen."

Die Form eines Proteins entscheidet über die Funktion. Wer anhand der Aminosäuren-Abfolge vorhersagen kann, wie ein fertiges Protein aussehen und funktionieren wird, hat einen Schlüssel zum Verständnis grundlegender Mechanismen des Lebens. Er kann damit unerwünschte Funktionen unterbinden. Oder: im Labor erwünschte Funktionen herstellen. Er kann Krankheiten verstehen und Medikamente entwickeln.

"Das können Menschen nicht. Kein Mensch kann ein Protein gedanklich falten, aber eine Software scheint es jetzt zu können."

KI-Ziel "Verständnis entwickeln" ist aus dem Fokus geraten

AlphaFold arbeitet mit aufmerksamkeitsbasierten neuronalen Netzen. Eine Deep Learning-Variante, die nur Informationen nutzt, die gerade relevant sind. Wie bei einem Puzzle werden zunächst Teile zusammengesetzt, zwischen denen die Zusammenhänge klar sind, erst nach und nach fügen sie sich zu einem Ganzen zusammen. Dabei weiß AlphaFold nicht, was ein Protein ist. Wie es mit anderen Proteinen wechselwirkt oder welche Rolle es in einem Organismus spielt. AlphaFold kennt Aminosäure-Sequenzen und Strukturen von 170 Tausend bekannten Proteinen. Und schätzt auf dieser Basis enorm treffsicher, welche Strukturen zu unbekannten Sequenzen gehören müssten. "Denken" ist das noch immer nicht. Weil, so Marc Toussaint…

"..das wirklich tolle, stark generalisierende Lernen nicht nur darin besteht, Daten auswendig zu lernen, sondern aus Daten wirklich Theorien zu entwickeln, die anwendbar sind auf viele Dinge."

"Das ist möglich?" "Ich denke schon, dass das möglich ist. Im Grunde war das genau immer schon eigentlich das Ziel: dass maschinelles Lernen sich damit beschäftigen sollte, aus möglichst wenigen Daten möglichst stark abstrahierende Modelle zu lernen. Weil, das war die Zeit, wo man wenig Daten hatte. Nur durch den Wandel der Zeit, dass man plötzlich jetzt so viele Daten hatte, ist eigentlich genau dieser Anspruch etwas verloren gegangen."

"Eigentlich könnte man doch sagen, diese ungeheure Datenflut, die in den letzten Jahrzehnten entstanden ist, hat sozusagen den Maschinen das Denken abgewöhnt?" "Ja – das könnte man so sagen. Also – es ist ja auch so, dass diese sehr datengetriebenen Methoden unglaublich erfolgreich sind. Wirklich wahnsinnig erfolgreich. Aber, aus wissenschaftlicher Sicht, wenn man jetzt KI-Forscher ist, ist es tatsächlich so, dass es fast ein bisschen enttäuschend ist. Weil man ja so unglaublich viele Daten hat, ist es gar nicht mehr so wichtig, dass die Systeme wirklich Theorien entwickeln oder kompakte Repräsentationen. Es reicht ja geradezu, wenn sie einfach nur diese Milliarden von Daten auswendig lernen und etwas generalisieren zwischen diesen. Und das funktionierte auch sehr gut, aber kommt nicht mit diesem wissenschaftlichen Anspruch gleich, ja – Verständnis zu entwickeln."

Gedankenexperimente bleiben vorerst dem Menschen vorbehalten

Maschinen liefern Antworten – in einer Geschwindigkeit und einer Präzision, zu der Menschen nicht in der Lage sind. Sie sind unverzichtbar, wenn es darum geht, Lösungen für konkrete Probleme zu entwickeln – in den gigantisch großen Dimensionen des Alls ebenso wie in den mikroskopisch kleinen der Zellen und Teilchen. Sie treiben den Fortschritt in einem nie dagewesenen Ausmaß. Allerdings: Vorläufig tun sie das nur dort, wo ein Mensch schon war. Robbert Dijkgraaf:

"Meine Datensätze sind mathematische Gleichungen. Für mich sind sie wie Spielzeuge – in gewisser Weise besteht meine tägliche Arbeit aus Spielen. Mit diesen Gleichungen. Einige von ihnen, glauben wir, wissen mehr als wir. Wir machen Gedankenexperimente. Und das ist das Wunderbare: In Gedanken können wir in Gegenden vordringen, in die wir mit Experimenten noch nicht kommen."